Tiefgehender Vergleich und Auswahlleitfaden für Mainstream-KI-Agent-Frameworks (LangChain vs. LangGraph vs. CrewAI vs. AutoGen vs. Semantic Kernel, 2026)

Mit kontinuierlichen Durchbrüchen in den Fähigkeiten von Large Language Models (LLM) entwickeln sich KI-Agenten von Proof-of-Concepts zu industriereifen Implementierungen. Allein zwischen 2023 und 2024 ist die Anzahl der Open-Source-KI-Agent-Frameworks um ein Vielfaches gewachsen, wobei mittlerweile über 20.000 „AI Agent“-bezogene Repositories auf GitHub zu finden sind. Für Entwickler, technische Leiter und Unternehmer ist die Wahl zwischen Lösungen wie LangChain, AutoGen und CrewAI zur primären Entscheidung beim Aufbau von KI-Anwendungen geworden. Sollten Sie dem ausgereiftesten Ökosystem oder einer klareren, besser kontrollierbaren Architektur Priorität einräumen? Suchen Sie einen schnellen Prototyp oder langfristige technische Stabilität und Unternehmensskalierbarkeit?

Dieser Artikel zielt darauf ab, einen „klaren und umsetzbaren Auswahlfahrplan“ für diese Entscheidung bereitzustellen. Basierend auf öffentlichen Daten und Community-Trends Stand Dezember 2025 werden wir einen systematischen horizontalen Vergleich von fünf Mainstream-KI-Agent-Frameworks über mehrere Dimensionen hinweg durchführen: Kern-Designparadigmen, technische Komplexität, Ökosystemreife, Feedback aus realen Projekten und der Kompromiss zwischen Leistung und Kosten. Dieser Leitfaden geht über eine bloße Funktionsliste hinaus und kombiniert spezifische Geschäftsszenarien, Teamgrößen und technischen Hintergrund, um eine wiederholbare Methodik für die Framework-Auswahl zu destillieren.

Der Inhalt dieses Artikels basiert auf den praktischen Erfahrungen unseres Teams in Projekten wie Content-Automatisierungssystemen, der NavGood KI-Tool-Navigationsseite und internen Unternehmensprozessagenten. Wir möchten die Lücke zwischen Konzepten, Engineering und Geschäftsanforderungen schließen, um Ihnen bei der Suche nach dem richtigen KI-Agent-Produkt oder -Framework während dieser kritischen Beschleunigungsphase der Einführung von KI-Agenten im Jahr 2026 zu helfen.

Empfohlenes Publikum:

- Technikbegeisterte und Einsteiger

- Unternehmensentscheider und Geschäftsleiter

- Allgemeine Benutzer, die an zukünftigen KI-Trends interessiert sind

Inhaltsverzeichnis:

- Teil 1: Überblick über die KI-Agent-Framework-Landschaft

- Teil 2: Tiefgehender Vergleich der fünf Mainstream-Frameworks

- Teil 3: Detaillierte Framework-Analyse

- Teil 4: Praktischer Auswahlleitfaden

- Teil 5: Performance- und Kostenüberlegungen

- Teil 6: Zukunftstrends (2025–2026)

- Fazit: Kein „bestes“ Framework, nur die „richtige“ Wahl

- Häufig gestellte Fragen (FAQ)

- Ressourcen

Teil 1: Überblick über die KI-Agent-Framework-Landschaft

Was ist ein KI-Agent-Framework?

Ein KI-Agent-Framework ist eine Sammlung von Tools und Bibliotheken, die entwickelt wurden, um den Prozess des Aufbaus intelligenter Agenten auf Basis von LLMs zu vereinfachen, die Autonomie, Planung, Werkzeugnutzung und Speicherfähigkeiten besitzen. Sein Kernwert liegt in der Abstraktion der universellen Fähigkeiten, die ein Agent benötigt – wie Chain-of-Thought-Planung, Kurz-/Langzeit-Speicherverwaltung, Orchestrierung von Tool-Aufrufen und Multi-Agenten-Zusammenarbeit – in wiederverwendbare Module. Dies ermöglicht es Entwicklern, sich auf die Geschäftslogik zu konzentrieren, anstatt komplexe Zustands- und Kontrollflüsse von Grund auf neu zu erstellen.

Die drei Phasen der Evolution von KI-Agent-Frameworks

- Frühe experimentelle Phase (2022 – Anfang 2023): Vertreten durch LangChain und BabyAGI. Gekennzeichnet durch Proof-of-Concept, Einführung der „Chain“-Logik in LLM-Anwendungen. Es löste grundlegende Probleme bei Tool-Aufrufen und Speicher, hatte aber eine relativ einfache Architektur.

- Funktionsverfeinerungsphase (2023 – 2024): Mit der Vertiefung der Anwendungen stieg die Nachfrage nach komplexen Workflows sprunghaft an. Vertreten durch LangGraph, CrewAI und AutoGen, begannen Frameworks, den Schwerpunkt auf Zustandsverwaltung, visuelle Orchestrierung, rollenbasierte Zusammenarbeit und Konversationsplanung zu legen und entwickelten sich von einfachen linearen Ketten zu komplexeren Paradigmen wie Graphen und Teams.

- Ökosystemreife & Spezialisierung (2025 – Gegenwart): Frameworks begannen sich zu differenzieren und tief in Cloud-Dienste und Unternehmens-IT-Stacks zu integrieren. Der Fokus verlagerte sich auf Produktionsreife, Leistungsoptimierung, Sicherheit, Compliance und Low-Code-Erfahrungen. Die Expansion von Semantic Kernel und Haystack im Unternehmensmarkt ist ein Kennzeichen dieser Phase.

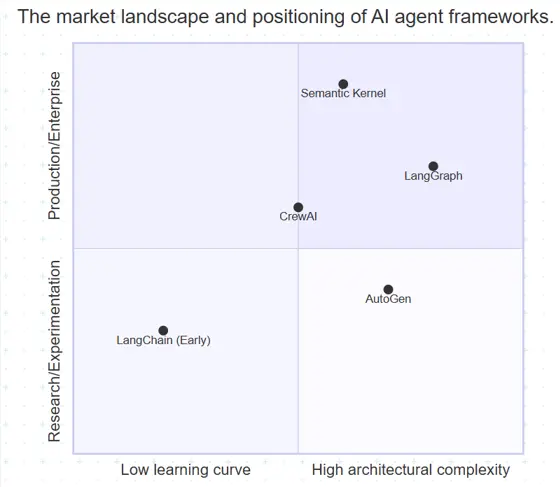

Aktuelle KI-Agent-Marktlandschaft

Der aktuelle Markt präsentiert eine Struktur „ein Marktführer, viele Herausforderer“. Das folgende Diagramm veranschaulicht die Nischen und Beziehungen der Mainstream-Frameworks:

- Marktführer: LangChain hat den First-Mover-Vorteil und die größte Community, bietet das vollständigste Ökosystem an Tools, Integrationen und Wissensbasen. Es bleibt die erste Wahl für viele Entwickler.

- Starke Herausforderer: CrewAI zeichnet sich in Teamkollaborationsszenarien mit seinem intuitiven „Rolle-Aufgabe-Prozess“-Modell aus; AutoGen hat eine tiefe Nische in der Multi-Agenten-Konversationsorchestrierung und -Forschung aufgebaut.

- Ökosystem-Entwickler: LangGraph, als „Upgrade“ innerhalb des LangChain-Ökosystems, konzentriert sich auf die Lösung komplexer, zustandsbehafteter Geschäftsprozesse mithilfe eines Zustandsgraphen. Es wird zum neuen Standard für Anwendungen mit hoher Komplexität.

- Unternehmensakteure: Semantic Kernel, unterstützt von Microsoft, integriert sich tief in Azure OpenAI und das .NET-Ökosystem und bietet natürliche Vorteile in Bezug auf Sicherheit, Beobachtbarkeit und Integration mit bestehenden Unternehmenssystemen.

Teil 2: Tiefgehender Vergleich der fünf Mainstream-Frameworks

Vergleichsdimensionen

Wir bewerten diese Frameworks anhand von sechs Kerndimensionen: Designphilosophie (bestimmt die Denkweise), Architekturmerkmale (beeinflusst Skalierbarkeit und Wartung), Lernkurve (Kosten für Teameinarbeitung), Community-Vitalität (Möglichkeit, Hilfe zu erhalten und langfristige Entwicklung sicherzustellen), Enterprise Support (entscheidend für die Produktion) und Performance (die Grundlage für große Anwendungen).

Detaillierte Vergleichstabelle

| Funktionsdimension | LangChain | LangGraph | CrewAI | AutoGen | Semantic Kernel |

|---|---|---|---|---|---|

| Kernpositionierung | Allgemeines KI-Anwendungs-Framework | Zustandsgesteuertes Framework für komplexe Workflows | Rollengesteuertes Teamkollaborations-Framework | Multi-Agenten-Konversations-Orchestrierung | Enterprise-KI-Integrations-Framework |

| Designphilosophie | „LEGO-Stil“-Modularität | „Visueller Flussdiagramm“-Zustandsmaschine | „Unternehmensstruktur“-Rollensynergie | „Gruppenchat“-Stil Konversations-Orchestrierung | „Plugin-basierte Skill“-Planung und Ausführung |

| Kernarchitektur | Chains, Agents, Tools | State Graph, Nodes, Edges | Agent, Task, Process, Crew | ConversableAgent, GroupChat | Plugins, Planners, Memories |

| Lernkurve | Mittel: Viele Konzepte, aber reiches Ökosystem | Mittel-Hoch: Erfordert Verständnis von Zustand/Schleifen | Niedrig: Intuitive und unkomplizierte Konzepte | Hoch: Flexibel, aber komplexe Konfiguration | Mittel: Klare Konzepte, erfordert Ökosystemkenntnis |

| GitHub Stars | ~ 122k+ (2025.12) | ~ 22.3k+ (2025.12) | ~ 41.5k+ (2025.12) | ~ 52.7k+ (2025.12) | ~ 26.9k+ (2025.12) |

| Dokumentation/Community | Exzellent, zahlreiche Tutorials | Gut, schnell verbessernd | Exzellent, reich an Anwendungsfällen | Mittel, API-lastig | Exzellent, Dokumentation auf Unternehmensniveau |

| Multi-Agenten-Unterstützung | Basic, erfordert manuelle Orchestrierung | Nativ & Exzellent, natürliche Graphstruktur | Kernfunktion, für Zusammenarbeit gebaut | Kernfunktion, spezialisiert auf Konversationen | Durch Planner-Kombinationen erreicht |

| Tools/Integration | Extrem reichhaltig, deckt alle wichtigen Dienste ab | Verlässt sich auf LangChain, konzentriert sich auf den Fluss | Gut, konzentriert sich auf gängige Tools | Gut, unterstützt Anpassung | Tiefes Microsoft-Ökosystem (Azure, Copilot) |

| Visuelles Debugging | Begrenzt (LangSmith) | Starker Vorteil, visuelle Ausführung | Grundlegende Prozessvisualisierung | Erfordert Tools von Drittanbietern | Über Azure-Dienste bereitgestellt |

| Enterprise-Funktionen | Via LangSmith/LangServe | Hoch, unterstützt komplexes Log-Tracking | Moderat | Geringer, forschungsorientiert | Sehr Hoch, Sicherheit, Überwachung, Compliance |

| Bestes Szenario | Schnelle Prototypen, Bildung, benutzerdefinierte Komponenten | Kundensupport, Genehmigungsworkflows, ETL komplexe Workflows | Content-Erstellung, Marktanalyse, teambasierte Aufgaben | Akademische Forschung, komplexe Debatten, Simulationen | Branchen mit hoher Compliance (Finanzen/Gesundheitswesen) |

Datenquellen:

https://github.com/langchain-ai/langchain

https://langchain-ai.github.io/langgraph/

https://www.crewai.com/

https://microsoft.github.io/autogen/

https://github.com/microsoft/semantic-kernel

Kern-Designparadigmen hinter den Frameworks

Die Unterschiede zwischen Frameworks ergeben sich aus ihren zugrunde liegenden Designparadigmen:

| Architekturparadigma | Kernidee | Repräsentatives Framework | Vorteile | Nachteile |

|---|---|---|---|---|

| Chain / Pipeline | Teilt Aufgaben in lineare Ausführungs„ketten“ auf | LangChain (Früh) | Einfach und intuitiv | Schwer zu handhabende Schleifen/Verzweigungen |

| Graph / State Machine | Verwendet Knoten und Kanten, um zustandsbehaftete Workflows zu bilden | LangGraph | Leistungsstark/flexibel, perfekt für komplexe Logik | Hohe Lernkurve und Designkomplexität |

| Rollenbasierte Kollaboration | Weist Agenten klare Rollen/Aufgaben zu, um ein Team zu simulieren | CrewAI | Natürliche Modellierung, einfache Arbeitsteilung | Weniger flexibel für strikt lineare Abläufe als Graphen |

| Konversationsorientiert | Verwendet „Dialog“ als Kernmechanismus für die Agenteninteraktion | AutoGen | Ideal für Verhandlungen oder iterative Kommunikation | Unvorhersehbarer Ausführungsfluss, schwer zu debuggen |

| Plugin / Skill-basiert | Kapselt Fähigkeiten als Plugins, die dynamisch von einem Planner aufgerufen werden | Semantic Kernel | Entkoppelt, einfach zu erweitern und zu integrieren | Erfordert leistungsstarken Planner; Performance-Herausforderungen |

Teil 3: Detaillierte Framework-Analyse

LangChain: Das vollständigste allgemeine Framework

Kernvorteil: Das Ökosystem ist sein größter Vorteil. Es bietet die umfassendste Dokumentation, die meisten Community-Tutorials und die reichhaltigsten Drittanbieter-Integrationen (Hunderte von offiziellen und Community-Integrationen, die wichtige Datenbanken, Vektorspeicher und SaaS-Dienste abdecken). Sein modularer Aufbau ermöglicht es Entwicklern, Prototypen wie LEGO-Bausteine zusammenzusetzen.

Typische Anwendungen:

- Schneller Proof-of-Concept: Zum Beispiel der Aufbau eines Q&A-Bots basierend auf privaten Dokumenten an einem einzigen Nachmittag.

- Erlernen der Prinzipien von KI-Agenten: Aufgrund seiner klaren Modularität ist es das beste Lehrbuch zum Verständnis von Konzepten wie Tools, Memory und Chains.

- Stark angepasste Bedürfnisse: Wenn Sie einen spezifischen Link tiefgreifend anpassen müssen (z. B. eine einzigartige Speicherindizierungsmethode), ermöglichen LangChains Low-Level-Schnittstellen dies.

Hinweis: „Umfassend“ bringt Komplexität mit sich. Für einfache, feste Workflows kann es sich überladen anfühlen. Sein Agent-Executor kann mit extrem komplexen, mehrstufigen Schleifen Schwierigkeiten haben; in solchen Fällen sollten Sie LangGraph in Betracht ziehen.

Bei unseren Tests für Automatisierungsskripte in NavGood haben wir zunächst versucht, eine 10-Schritte-Scraping-Logik mit einem Standard-LangChain-Agenten zu handhaben. Wir stellten fest, dass aufgrund der „Black-Box“-Natur von Chains die Wiederherstellung des Zustands schwierig war, sobald ein Zwischenschritt fehlschlug. Dies veranlasste uns, unsere Kernlogik zu LangGraph zu migrieren.

LangGraph: Die Top-Wahl für komplexe Geschäftsprozesse

Kernvorteil: Zustandsverwaltung und Visualisierung. Es abstrahiert das gesamte Agenten-System in einen gerichteten Graphen, wobei jeder Knoten eine Funktion oder ein Sub-Agent ist und Kanten die Bedingungen für den Zustandsübergang definieren. Dies ermöglicht es Entwicklern, Geschäftsprozesse, die Schleifen, bedingte Verzweigungen, Parallelität und Wartezustände umfassen, klar zu modellieren.

Beziehung zu LangChain: Es ist eine „High-Level-Komponente“ des LangChain-Ökosystems, die speziell entwickelt wurde, um die Mängel von LangChain bei komplexen, zustandsbehafteten Workflows zu beheben. Ihre Toolchains und Modell-Schnittstellen sind vollständig kompatibel.

Anwendungsfälle:

- Bearbeitung von Kundenservice-Tickets: Routing basierend auf Benutzerabsicht (Rücksendungen, Anfragen, Beschwerden), mit potenziellen Hin- und Her-Bewegungen zwischen Knoten.

- Mehrstufige Genehmigungsprozesse: Simulation von „Einreichen → Manager-Genehmigung → Finanzgenehmigung → Archivieren“, wobei eine Ablehnung in jeder Phase eine Rücksendung zur Änderung erfordert.

- Datenverarbeitungs-Pipelines: Ausführung einer „Scraping → Bereinigung → Validierung → Analyse → Berichterstattung“-Pipeline mit Wiederholungsversuchen oder Ausnahmeverzweigungen.

Hinweis: Erfordert einen Wechsel vom „Ketten“-Denken zum „Graphen“-Denken. Das Entwerfen eines guten State Schemas ist entscheidend; schlechtes Design führt zu Chaos.

Anfänger packen oft alle Zwischenergebnisse, Kontexte und Logs in ein einziges State-Objekt, wodurch es überladen wird. Unser Vorschlag: Teilen Sie den State in „Core Business State“ und „Temporäre Berechnungsdaten“ auf und behalten Sie nur wesentliche Cross-Node-Informationen im State.

CrewAI: Die Wahl für Teamzusammenarbeit

Kernvorteil: Rollenbasierte Abstraktion. Es verwendet Agent (definiert Rollen, Ziele, Hintergrundgeschichten), Task (definiert Ziele, erwartete Ausgabe) und Crew (organisiert Agenten und Aufgaben mit einem definierten Process, z. B. sequenziell oder parallel). Dies spiegelt eng wider, wie Menschen in Teams zusammenarbeiten.

Einzigartiges Konzept: Der hierarchische Modus im Process ermöglicht es einem „Manager“-Agenten, „Worker“-Agenten zu koordinieren, perfekt zur Simulation von Unternehmenshierarchien.

Anwendungsfälle:

- Content-Erstellungsteam: Planer (erstellt Gliederung), Autor (entwirft), Redakteur (überarbeitet) und Publishing Manager (formatiert) arbeiten synchron.

- Marktanalyseberichte: Forscher, Datenanalysten, Erkenntnis-Zusammenfasser und PPT-Ersteller erledigen Aufgaben im Wechsel.

- Agiles Projektmanagement: Produktmanager, Entwickler und QA-Agenten simulieren einen Sprint-Prozess.

Hinweis: Sein Prozess ist relativ strukturiert. Für Szenarien, die einen extrem freien, dynamischen Dialog erfordern (wie eine offene Debatte), ist es möglicherweise nicht so flexibel wie AutoGen.

Ein häufiger Fehler ist das Festlegen großer Rollenbeschreibungen (z. B. „Senior Market Expert“) ohne spezifische Verantwortlichkeiten oder Ausgabebeschränkungen, was zu einer Ergebnisdrift führt. Vorschlag: Definieren Sie „Input → Output-Format → Kriterien“ klar innerhalb des Agenten und halten Sie expected_output für Aufgaben strukturiert (z. B. Markdown-Vorlagen oder JSON-Felder).

AutoGen: Die Wahl für Multi-Agenten-Konversationsforschung

Kernvorteil: Flexibilität bei der Konversationsorchestrierung und Forschungstiefe. Das Herzstück von AutoGen ist der ConversableAgent, der durch das Senden von Nachrichten zusammenarbeitet. Es bietet reichhaltige Konversationsmuster (wie GroupChat mit GroupChatManager) und anpassbare „Human-in-the-loop“-Hooks, was es ideal für die explorative Multi-Agenten-Interaktionsforschung macht. Insbesondere Microsofts Überarbeitung im Jahr 2025 (AutoGen 0.4+ oder Magentic-One) führte native multimodale Unterstützung und die visuelle Oberfläche AutoGen Studio ein.

Anwendungsfälle:

- Akademische Forschung: Simulation mehrerer KI-Experten mit unterschiedlichem Hintergrund, die ein Problem diskutieren.

- Komplexe Dialogsysteme: Aufbau immersiver RPG-NPCs oder interaktiver Geschichten, die mehrere KI-Rollen erfordern.

- Code-Generierung & -Überprüfung: Erstellung eines „Programmierer“-Agenten und eines „Reviewer“-Agenten, die Code durch einen mehrstufigen Dialog optimieren.

Hinweis: Konfiguration und Debugging sind komplex. Es neigt eher zur Exploration und Interaktion als zu festen Pipelines und erfordert zusätzliche technische Einschränkungen für deterministische Produktionsaufgaben.

Vermeiden Sie „Endlosschleifen“, bei denen Agenten sich gegenseitig ständig befragen, ohne einen klaren Abbruch. Vorschlag: Legen Sie eine klare max_round oder eine Abbruchfunktion fest und verwenden Sie einen „Summarizer Agent“, um zu einem Ergebnis zu kommen.

Semantic Kernel: Die stabile Wahl für die Unternehmensintegration

Kernvorteil: Enterprise-taugliche Funktionen und nahtlose Microsoft-Integration. Von Microsoft entwickelt, unterstützt es nativ Azure OpenAI, Azure AI Search und andere Cloud-Dienste und zeichnet sich durch Sicherheit, Authentifizierung und Beobachtbarkeit (via Azure Monitor) aus. Sein mehrsprachiges SDK (Python, C#, Java) ist ein leistungsstarkes Werkzeug für große Unternehmen, um die KI-Entwicklung über heterogene Technologie-Stacks hinweg zu vereinheitlichen. Im Jahr 2025 betonte Semantic Kernel das Konzept des „Agentic SDK“ und konzentrierte sich auf verteilte Transaktionssicherheit.

Kernkonzepte: Plugin (Skills, die Functions enthalten), Planner (plant automatisch, welche Skills aufgerufen werden sollen) und Memory (Vektorspeicher).

Anwendungsfälle:

- Digitale Transformation von Unternehmen: Verpacken bestehender CRM-/ERP-APIs in Plugins, die es KI-Agenten ermöglichen, sicher mit Geschäftsdaten zu arbeiten.

- Aufbau interner Copilots: Tiefe Integration mit Microsoft 365 zur Bereitstellung intelligenter Assistenten für Mitarbeiter.

- Branchen mit hoher Compliance: Finanzen und Gesundheitswesen, wo strenge Zugriffskontrollen, Audit-Logs und Daten-Governance vorgeschrieben sind.

Hinweis: Wenn Ihr Team nicht an das Microsoft-Ökosystem (.NET, Azure) gebunden ist, könnten einige seiner Vorteile verloren gehen. Die Community ist kleiner als die der oben genannten Python-geführten Frameworks.

Teil 4: Praktischer Auswahlleitfaden

Um schnell das richtige Framework unter diesen fünf auszuwählen, können Sie einen Entscheidungsbaum verwenden oder Teamfähigkeiten, Projektphase und zukünftige Skalierbarkeit berücksichtigen.

Entscheidungsbaum: Basierend auf Ihren Kernbedürfnissen

Fragen Sie sich zuerst: Welches Kernproblem löse ich mit einem KI-Agenten?

- Geht es darum, „schnell eine KI-Idee zu validieren“ oder „Einsteigerwissen zu erlernen“?

- Ja → Wählen Sie LangChain. Reiches Ökosystem, leicht Beispiele zu finden.

- Nein → Gehen Sie zur nächsten Frage.

- Ist das Kernszenario die „Simulation eines Teams (z. B. Marketing, F&E) zur Erledigung von Aufgaben“?

- Ja → Wählen Sie CrewAI. Sein Rolle-Aufgaben-Modell passt am besten.

- Nein → Gehen Sie zur nächsten Frage.

- Ist das Kernszenario der „Aufbau eines Geschäftsprozesses mit komplexer Logik, Schleifen und Zustand“ (z. B. Genehmigungen, Tickets)?

- Ja → Wählen Sie LangGraph. Zustandsgraphen sind hier die ultimative Waffe.

- Nein → Gehen Sie zur nächsten Frage.

- Ist das Kernszenario die „Erforschung von Multi-Agenten-Dialogen/Debatten oder erfordert hochflexible Interaktion“?

- Ja → Wählen Sie AutoGen.

- Nein → Gehen Sie zur nächsten Frage.

- Befindet sich Ihr Projekt innerhalb des Microsoft-Stacks, oder haben Sie extreme Anforderungen an Sicherheit und Compliance?

- Ja → Wählen Sie Semantic Kernel.

- Nein → Kehren Sie zu Schritt 1 zurück oder beginnen Sie mit LangChain/CrewAI.

Auswahl nach Team und Projektphase

| Framework | Empfohlen für | Nicht empfohlen für |

|---|---|---|

| LangChain | Persönliches Lernen, Startup-Prototypen, POCs, die viele Integrationen erfordern. | Extrem komplexe, strikt zustandslogische Produktions-Workflows. |

| LangGraph | Mittelgroße bis große Teams, die komplexe Geschäftsabläufe entwickeln (z. B. E-Commerce-Bestellungen, Risikoaudits). | Einfache einmalige Skripte oder Szenarien, in denen der visuelle Fluss irrelevant ist. |

| CrewAI | Projekte, die sich auf „Rollenverteilung“ und „Teamleistung“ konzentrieren (z. B. Content-Erstellung). | Feingranulare Kontrolle der internen Logik oder hochgradig nicht-lineare, dynamische Abläufe. |

| AutoGen | Akademische Labore, die Multi-Agenten-Mechanismen oder experimentelle Dialogsysteme erforschen. | Stabile, vorhersehbare Ergebnisse für Produktionsaufgaben. |

| Semantic Kernel | Große Unternehmen, die .NET/C# und Azure nutzen und hohe Sicherheits-/Audit-Anforderungen haben. | Einzelentwickler oder Startups, die maximale Geschwindigkeit und Community-Support suchen. |

Schnelle Auswahl-Empfehlungen

Für schnelles Prototyping: LangChain

Für komplexe Workflows: LangGraph

Für Teamzusammenarbeit: CrewAI

Für die Forschung an Multi-Agenten-Konversationen: AutoGen

Für Systeme auf Unternehmensebene: Semantic Kernel

Teil 5: Performance- und Kostenüberlegungen

In KI-Agent-Systemen hängt die Performance nicht nur vom Framework ab, sondern auch von LLM-Modellaufrufen, Workflow-Strategie, Aufgabenkomplexität und Bereitstellungsarchitektur.

Performance-Benchmarks und reales Verhalten

LLM-Aufrufe sind der Hauptengpass: Die Anzahl der LLM-Aufrufe und die Kontextlänge sind die primären Faktoren, die Performance und Kosten beeinflussen. Bei einfachen Aufgaben sind die Performance-Unterschiede der Frameworks vernachlässigbar; der Engpass ist die LLM-Latenz und der Token-Verbrauch.

Mit anderen Worten, bei einfachen Prozessen wie „Inhalt in einem Schritt generieren → ein Tool-Aufruf → Ergebnis zurückgeben“ sind die Performance-Unterschiede des Frameworks selbst schwer zu erkennen.

Framework-Verhalten beeinflusst Kosten in komplexen Szenarien:

LangGraph reduziert redundante Aufrufe durch explizites Zustandsmanagement und DAG-Workflows, wodurch Token- und Zeitkosten bei der Fehlerbehebung gesenkt werden.

CrewAIs hierarchischer Fluss kann zusätzliche Aufrufe generieren, wenn Agenten Feedback austauschen oder Schritte koordinieren.

Semantic Kernels Planner neigt dazu, vor jeder Aufgabenteilung zu planen, was zusätzliche Modellaufruf-"Hotspots" erzeugen kann, die für feste, einfache Abläufe ineffizient sein könnten.

Entwicklungs- und Wartungskosten

Rangfolge der Lernkurve (Community-Feedback): AutoGen > LangGraph ≈ Semantic Kernel > LangChain > CrewAI

Dies spiegelt ein Spektrum wider, das von am komplexesten bis am einfachsten zu bedienen reicht: AutoGen bietet hohe Flexibilität, hat aber eine hohe Eintrittsbarriere in Bezug auf Einrichtung und Debugging; CrewAI ist aufgrund seiner Rollenabstraktion intuitiver und anfängerfreundlicher.

Wartung:

LangChain & CrewAI sind intuitiv für einfache bis mittelschwere Aufgaben, was die Teamzusammenarbeit oder Übergaben erleichtert.

LangGraph kann schwer zu warten werden, wenn der Graph mit zu vielen Knoten/Verzweigungen ohne ordnungsgemäße Dokumentation massiv wird.

Semantic Kernel erfordert oft vorhandene Infrastrukturkenntnisse (Azure DevOps, Sicherheits-Compliance).

Cloud-Bereitstellungs- und Betriebskosten

Kaltstart und Speicherverbrauch: Die Laufzeitabstraktionsschicht des Frameworks selbst wird unweigerlich den Speicherverbrauch beeinflussen. Leichtere Designs (wie der direkte Aufruf des Python SDK) haben in der Regel schnellere Kaltstarts, während Frameworks mit komplexeren zustandsbehafteten oder Planner-Modulen zusätzlichen Speicher benötigen können.

Containerisierung und Serverless-Freundlichkeit: Derzeit optimieren alle wichtigen Frameworks für containerisierte Bereitstellung (wie Docker/Kubernetes) und Serverless-Modi. Dies bedeutet, dass die Kosten durch Ressourcenisolation, automatische Skalierung usw. weiter gesenkt werden können, dies hängt jedoch auch von den richtigen Engineering-Praktiken ab.

Token- und Modellkosten: Selbst innerhalb desselben Frameworks variieren die Token-Preise verschiedener Modelle erheblich – leistungsfähigere Modelle wie GPT-4.1 sind weitaus teurer als leichtere Versionen (siehe Kostenvergleich für 2023–2025). Die Wahl des richtigen Modells und die Kontrolle der Kontextlänge sind entscheidende Schritte zur Kostenoptimierung.

Teil 6: Zukunftstrends (2025–2026)

Während die KI-Agenten-Technologie weiter reift, entwickelt sich das Ökosystem allmählich von einzelnen Tools und Frameworks zu einem größer angelegten, autonomeren, spezialisierteren und technisch ausgereifteren Architektursystem. Im Folgenden werden mehrere wichtige Trends für 2025–2026 vorgestellt:

1. Framework-Integration und das Aufkommen einer „Meta-Koordinationsschicht“

Das KI-Agenten-Ökosystem entwickelt sich von „einzelnen Frameworks, die isoliert arbeiten“ zu „Interkonnektivität und vereinheitlichter Governance“. Die Zukunft wird wahrscheinlich die Entstehung einer „Meta-Koordinationsschicht“ sehen, die in der Lage ist, verschiedene Agenten-Stacks über Frameworks hinweg zu planen, zu überwachen und zu koordinieren. Dies ermöglicht es Unternehmen, Daten, Ausführungsstrategien und Sicherheitsrichtlinien über verschiedene Agenten-Engines hinweg zu teilen. Zum Beispiel hat das Beratungsunternehmen PwC eine Middleware-Plattform gestartet, die Agenten aus verschiedenen Quellen koordinieren kann; diese Art von „KI-Agent-OS“ wird zu einer Schlüsselkomponente von Multi-Agenten-Architekturen in Unternehmen.

2. Low-Code/Visuelle Orchestrierung wird zum Standard

Die Senkung der Eintrittsbarriere für die Nutzung von KI-Agenten ist entscheidend für eine breite Akzeptanz. Low-Code- und visuelle Orchestrierungstools – nicht nur einfache Drag-and-Drop-Oberflächen, sondern solche, die Aufgaben-Workflows, Zustandsmaschinen-Visualisierung, Debugging-Tools und automatische Fehlerhinweise integrieren – wachsen rasant auf dem Markt. Zum Beispiel versprechen Drag-and-Drop Agent Builder-Tools von GitHub und anderen Plattformen, Entwicklern das Erstellen komplexer Agenten-Workflows ohne umfangreiche Programmierung zu ermöglichen. Dieser Trend wird KI-Agenten von einem spezialisierten Werkzeug für Entwicklungsteams in eine Produktivitätsplattform verwandeln, die für Geschäfts- und Produktteams zugänglich ist, was eine breitere Akzeptanz in verschiedenen Geschäftsszenarien vorantreibt.

3. Aufstieg branchenspezifischer KI-Agent-Frameworks und -Lösungen

Während allgemeine Frameworks wichtig sind, haben verschiedene vertikale Industrien unterschiedliche Anforderungen an Compliance, Sicherheit und szenariospezifische Funktionen. Wir erwarten die Entstehung weiterer branchenspezifischer KI-Agenten-Frameworks oder -Plattformen, wie z. B. spezielle Lösungen für Finanz-Compliance-Agenten, medizinische intelligente Assistenten, juristische Dokumentenagenten und Fertigungs-/Spielprozessautomatisierung. Diese Frameworks werden in Bezug auf integriertes Branchenwissen, Regelwerke und Prüfmechanismen ausgereifter sein.

4. Tiefe Integration mit AI-Native Entwicklungsparadigmen

In Zukunft werden KI-Agenten keine Funktionen mehr sein, die traditionellen Anwendungen hinzugefügt werden, sondern zum grundlegenden Paradigma für die Entwicklung KI-nativer Anwendungen. Das bedeutet, dass Agenten-Frameworks enger mit Konzepten wie Workflow-Programmierung, ereignisgesteuerten Systemen, Prompt-Engineering-Techniken (wie ReAct, Chain-of-Thought Reasoning usw.) und einheitlichen Schnittstellen für verschiedene Datenmodalitäten (Text, Bilder, strukturierte Daten) integriert werden. Diese Entwicklung wird die Transformation von Agenten von „Aufgabenausführern“ zu „intelligenten Geschäftskomponenten“ vorantreiben und zur Kernbasis der Entwicklung von Anwendungen der nächsten Generation werden.

5. Auseinandergehende Trends bei Open Source und Kommerzialisierung

Das KI-Agenten-Ökosystem wird seine Open-Source-Innovationskraft weiterhin aufrechterhalten, aber Mainstream-Frameworks beschleunigen auch die Veröffentlichung von kommerziellen Versionen und Managed Services, um den Anforderungen auf Unternehmensebene gerecht zu werden. Zum Beispiel entstehen in reifen Framework-Ökosystemen Mehrwertdienstmodule wie Überwachung, Hosting, automatische Skalierung, Sicherheitsrichtlinien und Audit-Logs. Dieses Entwicklungsmodell ähnelt dem Kommerzialisierungspfad grundlegender Software in der Vergangenheit. Die Open-Source-Seite konzentriert sich auf Innovation und die Erweiterung des Community-Ökosystems, während kommerzielle Versionen Unternehmenskunden bedienen, die Stabilität, Sicherheit und Beobachtbarkeit fordern.

6. Verbesserte Agenten-Standardisierung, Sicherheits- und Autorisierungsmechanismen

Da verschiedene Branchen beginnen, KI-Agenten in Produktionsumgebungen einzusetzen, werden Sicherheits- und Autorisierungsmechanismen zu einem wichtigen technischen Fokus. Aktuelle Agenten erfordern sicherere und kontrollierbarere Autorisierungsprotokolle beim Zugriff auf externe Systeme und Benutzerdaten, was die schrittweise Bildung neuer Standards (wie vereinheitlichte API-Authentifizierung, sichere Sandboxes und vertrauenswürdige Ausführungsumgebungen) vorantreibt. Für Bereitstellungen auf Unternehmensebene werden diese Standardisierungsmechanismen wichtige Indikatoren für die Bewertung der Framework-Auswahl und Implementierungsfähigkeiten sein.

7. Schnelles Marktwachstum und Integrationsdruck für Projekte

Branchenanalysten prognostizieren, dass, obwohl viele KI-Agenten-Projekte aufgrund von Kosten- und Geschäftsmodellproblemen aufgegeben werden könnten, die gesamte Markt Nachfrage und Investitionsbereitschaft für die Agenten-Technologie von 2026 bis 2028 weiter wachsen wird. Immer mehr Unternehmen planen, KI-Agenten in ihre Kern-Geschäftsprozesse zu integrieren, was einen Wandel von der „Pilotphase“ zur „Phase der großflächigen Anwendung“ vorantreibt.

Fazit: Kein „bestes“ Framework, nur die „richtige“ Wahl

Die Welt der KI-Agenten entwickelt sich rasant. Die Wahl eines Frameworks ist im Wesentlichen die Wahl einer Denkweise für den Aufbau komplexer intelligenter Systeme.

Unser letzter Ratschlag:

- Definieren Sie das Kernszenario: Skizzieren Sie Ihren idealen Agenten-Workflow, bevor Sie ein Tool auswählen.

- Schnell validieren: Verwenden Sie 1-2 Wochen, um ein Kernmodul in einem Kandidaten-Framework zu implementieren und die Erfahrung zu testen.

- Team & Ökosystem bewerten: Berücksichtigen Sie Ihren technischen Hintergrund und die erforderlichen Integrationen.

- Blicken Sie voraus: Stellen Sie sicher, dass die Roadmap des Frameworks mit der Richtung Ihres Produkts übereinstimmt.

Das tiefe Verständnis der Designphilosophie eines jeden Frameworks und der Beginn des Aufbaus ist wertvoller, als auf ein „perfektes“ zu warten.

Häufig gestellte Fragen (FAQ)

F1: Was sollte ich zuerst lernen, LangChain oder LangGraph? Es wird empfohlen, zuerst die Kernkonzepte von LangChain (Tools, Chains, Agents) zu beherrschen, da dies die Grundlage ist. Lernen Sie LangGraph, wenn Sie komplexe Workflows erstellen müssen. Sie ergänzen sich.

F2: Welches Framework ist am besten für ein Startup-Unternehmen? CrewAI oder LangChain. Wenn Ihre Produktidee naturgemäß „Multi-Agenten-Kollaboration“ beinhaltet (wie ein KI-Unternehmen), wählen Sie CrewAI; wenn Sie schnell iterieren und sich mit verschiedenen APIs integrieren müssen, wählen Sie LangChain.

F3: Wie viel Python-Kenntnisse sind erforderlich? Es sind mindestens fortgeschrittene Python-Kenntnisse erforderlich, einschließlich Vertrautheit mit asynchroner Programmierung, Dekoratoren und Pydantic-Modellen. Für Semantic Kernel, wenn die C#-Version verwendet wird, benötigen Sie entsprechende .NET-Kenntnisse.

F4: Können diese Frameworks in einer Produktionsumgebung eingesetzt werden? Ja, aber es erfordert zusätzliche Investitionen. LangGraph + LangSmith, CrewAI und Semantic Kernel verfügen alle über gute produktionsreife Funktionen. Der Schlüssel liegt in robusten Fehlerbehandlungs-, Protokollierungs-, Überwachungs- und Rollback-Mechanismen.

F5: Gibt es deutsche Dokumentationen und Community-Support? LangChain und CrewAI haben relativ aktive chinesische Communities (z. B. Zhihu-Spalten, technische Blogs, WeChat-Gruppen). Deutsche Ressourcen für LangGraph und AutoGen wachsen schnell. Deutsche Ressourcen für Semantic Kernel werden hauptsächlich von Microsoft bereitgestellt.

F6: Sind die Kosten für die Migration zwischen Frameworks hoch, wenn die anfängliche Wahl falsch ist? Ja, sie sind ziemlich hoch. Die Designparadigmen der verschiedenen Frameworks variieren erheblich, und eine Migration bedeutet, den Kern der Geschäftslogik-Orchestrierung neu zu schreiben. Daher ist die anfängliche Framework-Auswahl entscheidend. Es wird empfohlen, mit kleinen Prototypen zu beginnen, um die Eignung des Frameworks zu überprüfen.

Über den Autor

Dieser Inhalt wird vom Redaktionsteam von NavGood kuratiert. NavGood ist eine Plattform, die sich dem KI-Tool-Ökosystem widmet und die Entwicklung von KI-Agenten und automatisierten Workflows verfolgt.

Haftungsausschluss: Dieser Artikel repräsentiert nicht die offizielle Haltung eines Frameworks und stellt keine kommerzielle oder Anlageberatung dar. Die dargestellten experimentellen Daten basieren auf einer spezifischen Testumgebung und dienen lediglich als Vergleichsreferenz; tatsächliche Ergebnisse in einer Produktionsumgebung können abweichen.

Ressourcen

- Offizielle Links:

LangChain

LangGraph

CrewAI

AutoGen

Semantic Kernel