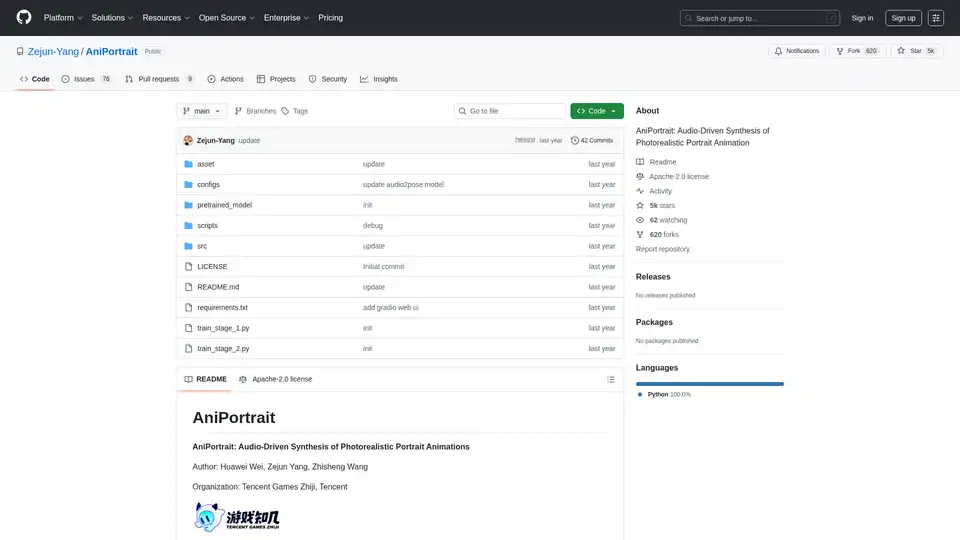

AniPortrait

Übersicht von AniPortrait

Was ist AniPortrait?

AniPortrait ist ein innovatives Open-Source-Framework, das für die audio-gesteuerte Synthese fotorealistischer Porträt-Animationen entwickelt wurde. Entwickelt von Huawei Wei, Zejun Yang und Zhisheng Wang von Tencent Games Zhiji und Tencent, nutzt dieses Tool fortschrittliche KI-Techniken, um hochwertige animierte Porträts aus einem einzelnen Referenzbild und Audio- oder Video-Eingaben zu erstellen. Ob Sie ein statisches Porträt mit Sprachaudio animieren oder Gesichtsausdrücke aus einem Quellvideo nachstellen – AniPortrait liefert lebensechte Ergebnisse, die subtile Nuancen wie Lippensynchronisation und Kopfbewegungen einfangen. Ideal für Content-Creator, Spieleentwickler und Forscher im Bereich Computer Vision, hebt es sich in der Welt der KI-Video-Generierungs-Tools durch den Fokus auf porträtspezifische Animationen ab.

Auf GitHub unter der Apache-2.0-Lizenz veröffentlicht, hat AniPortrait über 5.000 Sterne gesammelt, was seine Beliebtheit in der KI-Community widerspiegelt. Das Projekt legt Wert auf Zugänglichkeit, mit vortrainierten Modellen, detaillierten Installationsanleitungen und sogar einer Gradio-Web-UI für einfache Tests.

Wie funktioniert AniPortrait?

Im Kern verwendet AniPortrait eine mehrstufige Pipeline, die Diffusionsmodelle, Audioverarbeitung und Pose-Schätzung integriert, um Animationen zu erzeugen. Das Framework baut auf etablierten Modellen wie Stable Diffusion V1.5 und wav2vec2 für die Feature-Extraktion auf und gewährleistet eine robuste Handhabung der Audio-Visuellen Synchronisation.

Wichtige Komponenten und Workflow

- Eingabeverarbeitung: Beginnen Sie mit einem Referenz-Porträtbild. Im Audio-gesteuerten Modus werden Audio-Eingaben mit wav2vec2-base-960h verarbeitet, um Sprachmerkmale zu extrahieren. In Video-Modi werden Quellvideos in Pose-Sequenzen umgewandelt, indem Keypoints extrahiert werden.

- Pose-Generierung: Das audio2pose-Modell erzeugt Koppose-Sequenzen (z. B. pose_temp.npy) aus Audio, um die Kontrolle über Gesichtsausrichtungen zu ermöglichen. Für Face-Reenactment bildet eine Pose-Retargeting-Strategie Bewegungen aus dem Quellvideo auf das Referenzbild ab und unterstützt erhebliche Pose-Unterschiede.

- Animationssynthese: Nutzt Denoising-UNet, Referenz-UNet und Motion-Module, um Frames zu synthetisieren. Der Pose-Guider sorgt für Ausrichtung, während optionale Frame-Interpolation die Inferenz beschleunigt.

- Ausgabeverfeinerung: Erzeugt Videos in Auflösungen wie 512x512, mit Optionen zur Beschleunigung durch film_net_fp16.pt, um die Verarbeitungszeit zu reduzieren.

Dieser modulare Ansatz ermöglicht selbstgesteuerte Animationen (mit vordefinierten Posen), Face-Reenactment (Übertragung von Ausdrücken) und vollständig audio-gesteuerte Synthese, was es vielseitig für verschiedene Szenarien der KI-Porträt-Animation macht.

Kernfunktionen von AniPortrait

AniPortrait bietet eine Reihe leistungsstarker Funktionen, die speziell für realistische Porträt-Animationen zugeschnitten sind:

- Audio-gesteuerte Porträt-Animation: Synchronisiert Lippenbewegungen und Ausdrücke mit Audio-Eingaben, perfekt für Synchronisation oder virtuelle Avatare.

- Face-Reenactment: Überträgt Gesichtsperformances von einem Quellvideo auf ein Zielporträt, ideal für ethische Anwendungen im Medienbereich, die Deepfake-ähnlich sind.

- Pose-Kontrolle und Retargeting: Aktualisierte Strategien handhaben vielfältige Kopposen, einschließlich der Generierung benutzerdefinierter Pose-Dateien für präzise Kontrolle.

- Hochauflösende Ausgabe: Erzeugt fotorealistische Videos mit Unterstützung für längere Sequenzen (bis zu 300 Frames oder mehr).

- Beschleunigungsoptionen: Frame-Interpolation und FP16-Modelle beschleunigen die Inferenz, ohne die Qualität zu opfern.

- Gradio-Web-UI: Eine benutzerfreundliche Oberfläche für schnelle Demos, die auch auf Hugging Face Spaces online verfügbar ist.

- Vortrainierte Modelle: Enthält Gewichte für audio2mesh, audio2pose und Diffusionskomponenten, die von Quellen wie Wisemodel herunterladbar sind.

Diese Funktionen machen AniPortrait zu einem Go-to-Tool für KI-gesteuerte Video-Synthese, das grundlegende Tools übertrifft, indem es auf Porträt-Treue und Audio-Visuelle Kohärenz fokussiert.

Installation und Setup

Der Einstieg ist unkompliziert für Nutzer mit Python >=3.10 und CUDA 11.7:

- Klone das Repository:

git clone https://github.com/Zejun-Yang/AniPortrait. - Installiere Abhängigkeiten:

pip install -r requirements.txt. - Lade vortrainierte Gewichte in

./pretrained_weights/herunter, einschließlich Stable Diffusion-Komponenten, wav2vec2 und benutzerdefinierter Modelle wiedenoising_unet.pthundaudio2pose.pt. - Organisiere Dateien gemäß der Verzeichnisstruktur im README.

Für das Training bereite Datensätze wie VFHQ oder CelebV-HQ vor, indem du Keypoints extrahierst und Preprocessing-Skripte ausführst. Das Training erfolgt in zwei Stufen mit Accelerate für verteilte Verarbeitung.

Wie verwendet man AniPortrait?

Inferenz-Modi

AniPortrait unterstützt drei primäre Modi über Kommandozeilen-Skripte:

Selbstgesteuerte Animation:

python -m scripts.pose2vid --config ./configs/prompts/animation.yaml -W 512 -H 512 -accPasse es mit Referenzbildern oder Pose-Videos an. Konvertiere Videos in Posen mit

python -m scripts.vid2pose --video_path input.mp4.Face-Reenactment:

python -m scripts.vid2vid --config ./configs/prompts/animation_facereenac.yaml -W 512 -H 512 -accBearbeite das YAML, um Quellvideos und Referenzen einzuschließen.

Audio-gesteuerte Synthese:

python -m scripts.audio2vid --config ./configs/prompts/animation_audio.yaml -W 512 -H 512 -accFüge Audios und Bilder zur Konfiguration hinzu. Aktiviere audio2pose, indem du pose_temp entfernst, für automatische Pose-Generierung.

Für Koppose-Kontrolle generiere Referenzposen mit python -m scripts.generate_ref_pose.

Web-Demo

Starte die Gradio-UI: python -m scripts.app. Oder probiere die Online-Version auf Hugging Face Spaces aus.

Nutzer können mit Beispielevideos wie 'cxk.mp4' oder 'jijin.mp4' experimentieren, um Audio-Sync in Aktion zu sehen, die von Plattformen wie Bilibili stammen.

AniPortrait von Grund auf trainieren

Fortgeschrittene Nutzer können benutzerdefinierte Modelle trainieren:

- Daten-Vorbereitung: Lade Datensätze herunter, verarbeite sie mit

python -m scripts.preprocess_datasetund aktualisiere JSON-Pfade. - Stufe 1:

accelerate launch train_stage_1.py --config ./configs/train/stage1.yaml. - Stufe 2: Lade Motion-Module-Gewichte herunter, gib Stufe-1-Checkpoints an und führe

accelerate launch train_stage_2.py --config ./configs/train/stage2.yamlaus.

Dieser Prozess feinjustiert auf porträtspezifischen Daten und verbessert die Generalisierung für KI-Animationsaufgaben.

Warum AniPortrait wählen?

In einem überfüllten Feld von KI-Tools für Video-Generierung zeichnet sich AniPortrait durch seinen spezialisierten Fokus auf fotorealistische Porträts aus. Im Gegensatz zu allgemeinen Modellen handhabt es Audio-Lippensync und subtile Ausdrücke mit Präzision und reduziert Artefakte in Gesichtsanimationen. Die Open-Source-Natur ermöglicht Anpassungen, und aktuelle Updates – wie die April-2024-Veröffentlichung von audio2pose und Beschleunigungsmodulen – halten es zukunftsweisend. Anerkennungen der Community an Projekte wie EMO und AnimateAnyone unterstreichen seine kollaborativen Wurzeln und gewährleisten zuverlässige Leistung.

Der praktische Wert umfasst schnellere Prototyping für virtuelle Influencer, Bildungsvideos oder Spiel-Assets. Mit Verfügbarkeit des arXiv-Papiers (eprint 2403.17694) dient es Forschern, die Audio-Visuelle Synthese in der Computer Vision erkunden.

Für wen ist AniPortrait?

- Content-Creator und Filmemacher: Für schnelle Synchronisation oder Ausdrucksübertragungen in Kurzform-Videos.

- Spieleentwickler in Tencent-ähnlichen Studios: Integration animierter Porträts in interaktive Medien.

- KI-Forscher: Experimentieren mit diffusionsbasierten Animationen und Pose-Retargeting.

- Hobbyisten und Pädagogen: Nutzung der Web-UI, um KI-Konzepte ohne aufwändigen Setup zu lehren.

Wenn Sie den besten Weg suchen, um audio-gesteuerte Porträt-Animationen zu erstellen, macht AniPortraits Balance aus Qualität, Geschwindigkeit und Zugänglichkeit es zu einer Top-Wahl.

Potenzielle Anwendungen und Use Cases

- Virtuelle Avatare: Animieren digitaler Charaktere mit synchronisierter Sprache für Social Media oder Metaversen.

- Bildungstools: Generieren von sprechenden Kopf-Videos für Vorlesungen oder Tutorials.

- Medienproduktion: Ethisches Face-Reenactment für historische Nachstellungen oder Werbung.

- Forschungsprototyping: Benchmarking von Audio-zu-Video-Modellen in CV-Papieren.

Demonstrationen umfassen selbstgesteuerte Clips wie 'solo.mp4' und Audio-Beispiele wie 'kara.mp4', die nahtlose Integration zeigen.

Für Troubleshooting prüfen Sie die 76 offenen Issues auf GitHub oder tragen über Pull Requests bei. Insgesamt befähigt AniPortrait Nutzer, Grenzen in der KI-Porträt-Animation mit zuverlässigen, hochauflösenden Ergebnissen zu erweitern.

Beste Alternativwerkzeuge zu "AniPortrait"

TaleBot ist ein KI-Geschichtenerzähler, der personalisierte Gute-Nacht-Geschichten für Kinder erstellt. Passen Sie Charaktere, Handlungen und Moralvorstellungen an und erhalten Sie Ihre Geschichte im PDF-, Audio- oder Videoformat.

HoldSpeak ist eine KI-gestützte macOS-App, mit der Sie mithilfe von Sprache-zu-Text 3x schneller tippen können. Es bietet hohe Genauigkeit, Offline-Funktionalität und unterstützt über 100 Sprachen. Ideal für die Interaktion mit LLM-Apps und das schnelle Beantworten von E-Mails.

Media.io ist eine All-in-One-KI-Plattform für Video-, Bild- und Audioerstellung. Es bietet Tools wie KI-Videogenerator, Bild zu Video, Text zu Musik und Wasserzeichenentferner, die sowohl für den persönlichen als auch für den kommerziellen Gebrauch geeignet sind.

TheStoryGPT ist eine KI-gestützte Plattform, die es Nutzern ermöglicht, interaktive Geschichten zu erstellen und zu teilen. Sie verwandelt Ideen und Sprachaufnahmen in fesselnde Erzählungen und bietet ein personalisiertes Geschichtenerlebnis mit hoher Audioqualität.

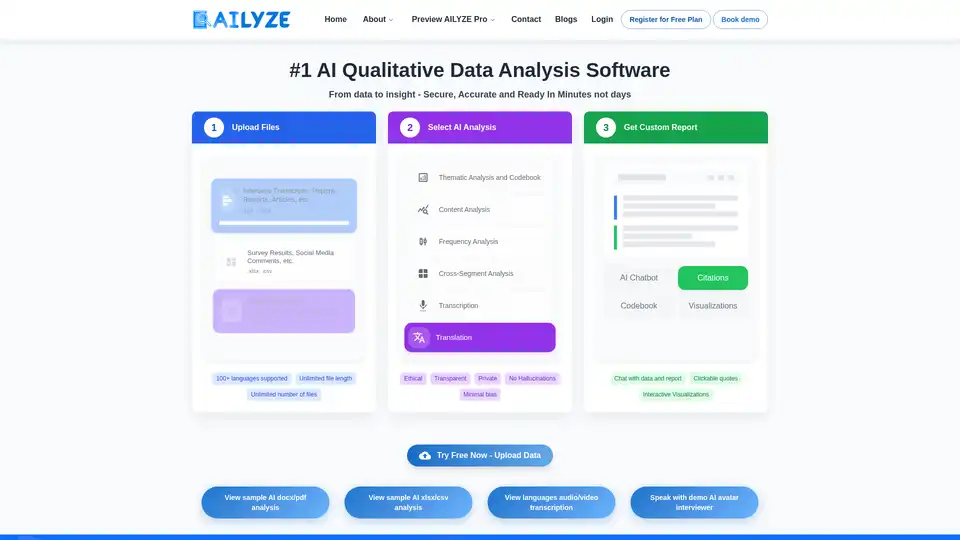

AILYZE ist eine KI-gestützte Software zur qualitativen Datenanalyse, die thematische Analysen, Inhaltsanalysen und einen KI-Chatbot für schnelle Datenerkenntnisse aus Dokumenten und Tabellenkalkulationen bietet.

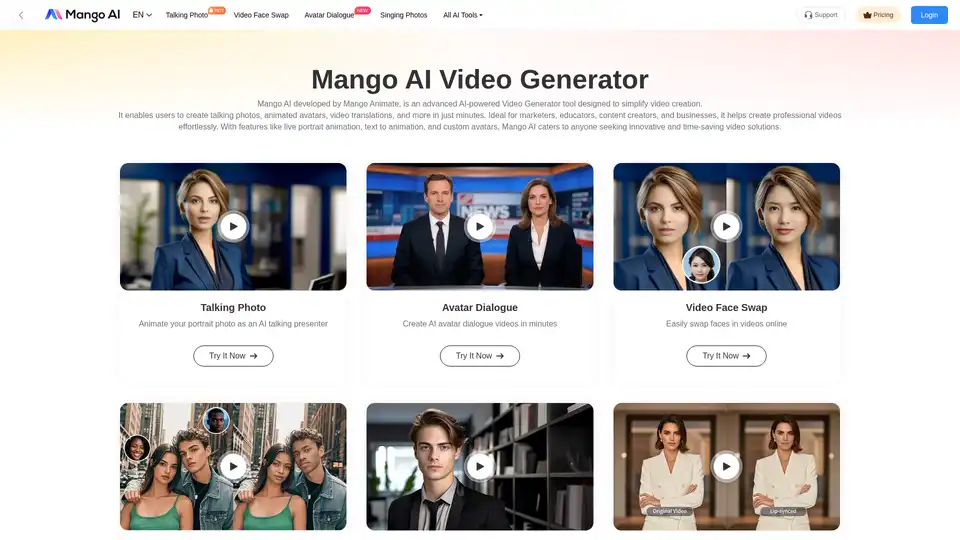

Mango AI ist ein KI-gestützter Videogenerator, mit dem Sie mühelos sprechende Fotos, Avatare und Gesichtstausche erstellen können. Ideal für Vermarkter, Pädagogen und Content-Ersteller.

Staccato AI Instrument™ ist ein KI-gestütztes MIDI-Plugin, das Musikproduzenten hilft, MIDI-Stems und -Loops zu erstellen, zu erweitern und umzuschreiben. Ideal, um Schreibblockaden zu überwinden und die Kreativität anzuregen.

Meistern Sie Ihre technischen Interviews mit Chadview, einer KI-gestützten Chrome-Erweiterung, die mit ChatGPT Echtzeit-Antworten liefert. Erhalten Sie sofortige Hilfe bei Zoom-, Google Meet- und Teams-Anrufen.

AIVidly ist eine All-in-One-KI-Video-Maker-App für iPhone, die Text in professionelle Videos mit KI-Sprachausgabe, Effekten und Optimierungen für TikTok und YouTube Shorts umwandelt – keine Bearbeitungsfähigkeiten erforderlich.

Steigern Sie Ihr Selbstvertrauen mit Interviews by AI, dem führenden KI-gestützten Tool zur Vorbereitung auf Vorstellungsgespräche. Üben Sie maßgeschneiderte Fragen zum Vorstellungsgespräch, erhalten Sie sofortiges KI-Feedback und meistern Sie Ihr nächstes Vorstellungsgespräch.

Revios ist Ihre KI-gestützte Plattform zum Entdecken authentischer Produktbewertungen. Tauchen Sie ein in Video- und Audiobewertungen, teilen Sie Erkenntnisse und vernetzen Sie sich mit einer Community versierter Rezensenten.

VoiceCanvas ist eine KI-gestützte Plattform für Sprachsynthese und -klonierung in über 50 Sprachen. Erstellen Sie natürlich klingende Stimmen für Story-Voiceovers, personalisiertes Stimmenklonen und mehr.

JSON Scout verwendet KI, um unstrukturierte Inhalte in strukturierte JSON-Daten umzuwandeln. Vereinfachen Sie die Datenextraktion mit benutzerdefinierten Formaten und ohne REGEX. Testen Sie es kostenlos!

CREATUS.AI bietet einen KI-nativen Arbeitsbereich mit autonomen Teammitgliedern, der KI-Funktionen für KMUs integriert, um die Produktivität zu steigern und die Ressourcenkosten zu optimieren. Testen Sie kostenlose KI-Tools und integrieren Sie sie in Apps wie Canva, Notion und Zapier.