DragGAN

Übersicht von DragGAN

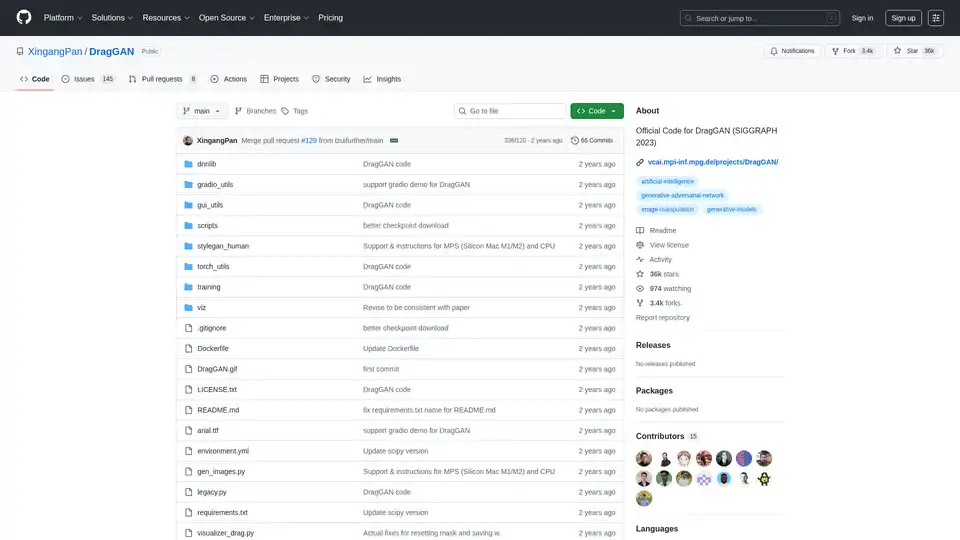

DragGAN: Interaktive punktbasierte Manipulation auf der generativen Bildmannigfaltigkeit

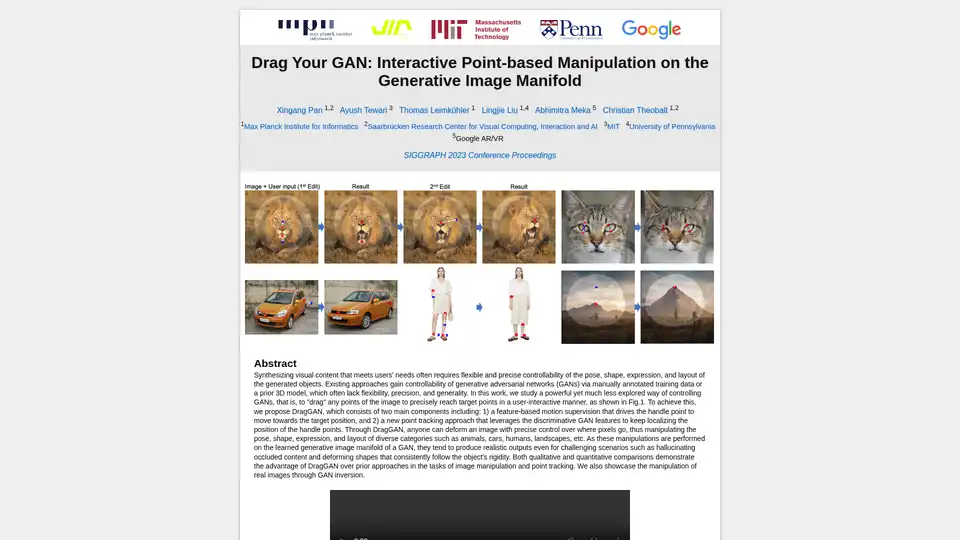

DragGAN ist eine hochmoderne Technik, die es Benutzern ermöglicht, interaktiv Bilder zu manipulieren, die von Generative Adversarial Networks (GANs) generiert werden. Dieser innovative Ansatz ermöglicht eine präzise, punktbasierte Kontrolle über Bildmerkmale und eröffnet neue Möglichkeiten für die kreative Bildbearbeitung und -manipulation. Der offizielle Code für DragGAN wurde auf der SIGGRAPH 2023 vorgestellt.

Was ist DragGAN?

DragGAN ist eine Methode zur Manipulation von Bildern, die von GANs, insbesondere StyleGAN, generiert werden. Es ermöglicht Benutzern, bestimmte Punkte auf einem Bild auszuwählen und diese an neue Positionen zu "ziehen", wodurch das Bild auf kontrollierte Weise verformt wird. Dies wird durch die Optimierung des latenten Raums des GAN erreicht, wodurch der Bildgenerierungsprozess so gesteuert wird, dass er mit der beabsichtigten Manipulation des Benutzers übereinstimmt.

Wie funktioniert DragGAN?

DragGAN funktioniert, indem es Benutzern ermöglicht, "Griffpunkte" auf einem Bild auszuwählen und Zielpositionen für diese Punkte anzugeben. Der Algorithmus optimiert dann die latente Raumdarstellung des GAN des Bildes, um die Griffpunkte an ihre Ziele zu bewegen, während die Gesamtbildqualität und der Realismus erhalten bleiben. Dies erfordert ein sorgfältiges Gleichgewicht zwischen dem Verschieben der angegebenen Punkte und der Aufrechterhaltung der Integrität der umgebenden Bildstrukturen.

Hauptmerkmale und Fähigkeiten:

- Interaktive punktbasierte Manipulation: DragGAN ermöglicht es Benutzern, Bilder direkt zu manipulieren, indem sie bestimmte Punkte auswählen und ziehen, was eine intuitive Kontrolle über die Bildbearbeitung bietet.

- Generative Bildmannigfaltigkeit: Die Methode arbeitet innerhalb der generativen Bildmannigfaltigkeit, die von GANs gelernt wurde, und stellt sicher, dass Manipulationen realistisch und konsistent mit den Trainingsdaten bleiben.

- Hochwertige Ergebnisse: DragGAN wurde entwickelt, um hochwertige Ergebnisse zu erzielen, Bilddetails zu erhalten und Artefakte während der Manipulation zu vermeiden.

- Integration mit StyleGAN: Die Implementierung basiert auf StyleGAN3 und nutzt dessen leistungsstarke Bildgenerierungsfunktionen.

Wie benutzt man DragGAN?

- Voraussetzungen:

- CUDA-fähige GPU (empfohlen)

- Conda-Umgebung

- Python 3.7+

- Abhängigkeiten, die in

environment.ymlundrequirements.txtangegeben sind

- Installation:

- Erstellen Sie eine Conda-Umgebung mit der bereitgestellten

environment.yml-Datei:conda env create -f environment.yml - Aktivieren Sie die Umgebung:

conda activate stylegan3 - Installieren Sie zusätzliche Anforderungen:

pip install -r requirements.txt

- Erstellen Sie eine Conda-Umgebung mit der bereitgestellten

- Laden Sie vortrainierte Gewichte herunter:

- Führen Sie

python scripts/download_model.pyaus, um die vortrainierten StyleGAN2-Gewichte herunterzuladen.

- Führen Sie

- DragGAN-GUI ausführen:

- Führen Sie

sh scripts/gui.sh(oder.\scripts\gui.batunter Windows) aus, um die DragGAN-GUI zu starten. Dies ermöglicht es Benutzern, GAN-generierte Bilder zu bearbeiten.

- Führen Sie

Warum DragGAN wählen?

DragGAN zeichnet sich durch seine intuitive Benutzeroberfläche und seine hochwertigen Ergebnisse aus. Im Gegensatz zu traditionellen Bildbearbeitungstechniken arbeitet DragGAN im latenten Raum des GAN und stellt so sicher, dass Manipulationen realistisch und konsistent bleiben. Dies macht es zu einem idealen Werkzeug für die kreative Bildbearbeitung, das es Benutzern ermöglicht, neue Möglichkeiten zu erkunden und einzigartige visuelle Inhalte zu generieren.

Für wen ist DragGAN geeignet?

DragGAN ist geeignet für:

- Forscher: Untersuchung von GANs und Bildmanipulationstechniken.

- Künstler und Designer: Erstellung einzigartiger und überzeugender visueller Inhalte.

- Hobbyisten: Erkundung der Fähigkeiten der KI-gesteuerten Bildbearbeitung.

Technische Details und Implementierung:

Die Implementierung von DragGAN basiert auf StyleGAN3 und enthält mehrere Schlüsselkomponenten:

- DNNLib: Eine Bibliothek für tiefe neuronale Netze.

- Gradio Utils: Dienstprogramme zum Erstellen eines Gradio-basierten Visualisierers.

- GUI Utils: Dienstprogramme für die DragGAN-GUI.

- Torch Utils: Dienstprogramme für PyTorch.

Lizenzinformationen:

Der Code, der sich auf den DragGAN-Algorithmus bezieht, ist unter CC-BY-NC lizenziert. Der größte Teil dieses Projekts ist jedoch unter separaten Lizenzbedingungen verfügbar: Alle von StyleGAN3 verwendeten oder geänderten Codes unterliegen der Nvidia Source Code License. Jede Form der Verwendung und Ableitung dieses Codes muss die Wasserzeichenfunktionalität beibehalten, die "AI Generated" anzeigt.

Beispiele für Anwendungsfälle

- Objektumformung: Ändern Sie die Form von Objekten innerhalb eines Bildes, z. B. das Ändern der Pose eines Gesichts oder das Umformen eines Autos.

- Szenenkomposition: Ordnen Sie Elemente innerhalb einer Szene neu an, um neue Kompositionen und visuelle Erzählungen zu erstellen.

- Künstlerische Erkundung: Experimentieren Sie mit verschiedenen Bildmanipulationen, um einzigartige und kreative Kunstwerke zu generieren.

DragGAN ist ein leistungsstarkes Werkzeug, das neue Möglichkeiten für die interaktive Bildmanipulation eröffnet. Durch die Kombination der Leistung von GANs mit intuitiver punktbasierter Steuerung ermöglicht DragGAN Benutzern, auf einfache Weise atemberaubende und realistische Bildbearbeitungen zu erstellen.

Beste Alternativwerkzeuge zu "DragGAN"

Mit DragGAN können Benutzer von GANs generierte Bilder interaktiv bearbeiten, indem sie Punkte an Zielpositionen ziehen und so die Pose, Form und das Layout präzise steuern.

Nightmare AI ist ein kostenloser KI-Bild-Upscaler und -Verbesserer, der Real-ESRGAN verwendet, um Bilder auf HD- und 4K-Qualität hochzuskalieren und zu verbessern. Stellen Sie alte Fotos wieder her und konvertieren Sie Bilder in den Anime-Stil von Studio Ghibli.

Video Watermark Remover verwendet KI, um Wasserzeichen, Logos und Text aus Videos auf TikTok, YouTube und Instagram sofort und ohne Qualitätsverlust zu entfernen. Perfekt für Content-Ersteller, Filmemacher und Unternehmen.

Gan.AI: Erstellen Sie sofort KI-Videos mit Text, KI-Avataren, Szenen und Voiceovers. Keine Kamera, Crew oder Bearbeitungskenntnisse erforderlich. Starten Sie Videos in wenigen Minuten.

Der kostenlose AI-Bild-Upscaler verbessert Fotos auf bis zu 16k/4k. Erhöhen Sie die Auflösung und verbessern Sie die Bildqualität in Sekunden mit AIImageUpscale.com.

UnrealPerson ist ein kostenloses KI-Tool, das einzigartige, nicht existierende Gesichter, Tiere und Kunstwerke generiert. Entdecken Sie die Leistungsfähigkeit von KI mit unbegrenzten, exklusiven Bildern.

DaVinciFace nutzt KI, um Ihre Fotos in atemberaubende Porträts im DaVinci-Stil zu verwandeln. Erleben Sie Renaissance-Kunst mit modernster Technologie. Probieren Sie es jetzt aus!

AI Art Generator ist eine Online-Plattform zum Erstellen von KI-generierter Kunst und zum Suchen nach KI-Bildern. Es bietet Stilübertragung, Bild-Upscaling und Videoerstellungsfunktionen, um den künstlerischen Ausdruck zu verbessern.

Metail EcoShot hilft Modemarken, in weniger als 24 Stunden Modellbilder aus 3D-Designs zu erstellen und so die Präsentationen über Geisterpuppen- und Avatar-Renderings hinaus zu verbessern.

Generieren Sie mit This Person Does Not Exist realistische, KI-generierte Gesichter. Laden Sie zufällige gefälschte Personenfotos für verschiedene Projekte herunter. Powered by StyleGAN.

SDXL Turbo ist ein KI-Text-zu-Bild-Generator in Echtzeit, der Adversarial Diffusion Distillation für hochwertige Bilder verwendet. Probieren Sie es kostenlos aus und entdecken Sie seine Möglichkeiten.

AVCLabs Video Enhancer AI verwendet fortschrittliche KI-Technologie zur Verbesserung der Videoqualität, Hochskalierung der Auflösung von SD auf 8K, Restaurierung alter Aufnahmen, Kolorierung von Schwarz-Weiß-Videos und Stabilisierung wackeliger Aufnahmen mit professionellen Ergebnissen.

Creata AI ist eine generative KI-Toolbox, die nützliche KI-Tools für den Alltag bietet. Es bietet Bild-zu-Bild-Modelle, Stable Diffusion Art und unterstützt GPT-4 Turbo. Verfügbar für iOS und Android.

Onison bietet eine Markenmanagementplattform mit Digital Asset Management, Web-to-Print-Publishing, Produktinformationsmanagement und automatisierter Katalogerstellung zur Optimierung von Marketing-Workflows.