FILM Frame Interpolation

Übersicht von FILM Frame Interpolation

Was ist FILM Frame Interpolation?

FILM, Abkürzung für Frame Interpolation for Large Motion, ist ein bahnbrechendes neuronales Netzwerk, das von Google Research entwickelt wurde, um glatte Zwischenbilder in Videos zu erzeugen, insbesondere in solchen mit erheblichen Szenenbewegungen. Im Gegensatz zu traditionellen Methoden, die auf vortrainierten Netzwerken für optischen Fluss oder Tiefenschätzung angewiesen sind, verwendet FILM einen einheitlichen Single-Network-Ansatz. Dies macht es effizient und leistungsstark für die Erstellung hochwertiger Interpolationen direkt aus Bildtriplets während des Trainings. Als open-source TensorFlow 2-Implementierung freigegeben, ist es zugänglich für Entwickler und Forscher, die die Video-Flüssigkeit verbessern möchten, ohne komplizierte Setups.

Das Modell zeichnet sich durch seine Fähigkeit aus, große Szenenbewegungen zu handhaben – denken Sie an schnell bewegte Objekte oder dynamische Kameraschwenks –, wo konventionelle Interpolationsverfahren oft scheitern und Artefakte oder Unschärfen erzeugen. Durch das Teilen von Faltungskerngewichten über Multi-Scale-Feature-Extraktoren erreicht FILM State-of-the-Art-Benchmark-Scores, während die Architektur leichtgewichtig und trainierbar aus grundlegenden Eingaben bleibt.

Wie funktioniert FILM?

Im Kern verarbeitet FILM zwei Eingabebilder (frame1 und frame2), um Zwischenbilder zu den angegebenen Zeitstempeln zu vorhersagen. Der Prozess beginnt mit einer Multi-Scale-Feature-Extraktionsstufe, in der Faltungsschichten die Eingaben in unterschiedlichen Auflösungen analysieren, um sowohl feine Details als auch breitere Bewegungs patterns zu erfassen. Diese Features werden dann durch eine Reihe von Upsampling- und Blending-Operationen fusioniert und verfeinert, um das Ausgabebild oder die Videosequenz zu erzeugen.

Schlüssel zu seiner Innovation ist die Vermeidung externer Abhängigkeiten. Traditionelle Frame-Interpolation könnte pixel-level Korrespondenzen mit optischem Fluss berechnen, aber FILM lernt diese implizit innerhalb seines Netzwerks. Während der Inferenz steuern Sie die InterpolationsTiefe mit dem Parameter 'times_to_interpolate': Auf 1 setzen für ein einzelnes Mittelbild (bei t=0.5) oder höher (bis zu 8) für ein vollständiges Video mit exponentiell mehr Frames (2^times_to_interpolate + 1 insgesamt, bei 30 FPS). Diese rekursive Aufrufung gewährleistet glatte Übergänge, sogar in anspruchsvollen Szenarien wie Okklusionen oder schnellen Deformationen.

Der zugrunde liegende technische Bericht aus 2022 beschreibt detailliert, wie das Modell auf diversen Video-Datensätzen trainiert wurde, optimiert für perzeptuelle Qualität statt pixelgenauer Genauigkeit. Dies führt zu visuell ansprechenden Ausgaben, die die menschliche Wahrnehmung nachahmen, und macht es ideal für Anwendungen jenseits der rohen Synthese.

Wie verwendet man FILM Frame Interpolation?

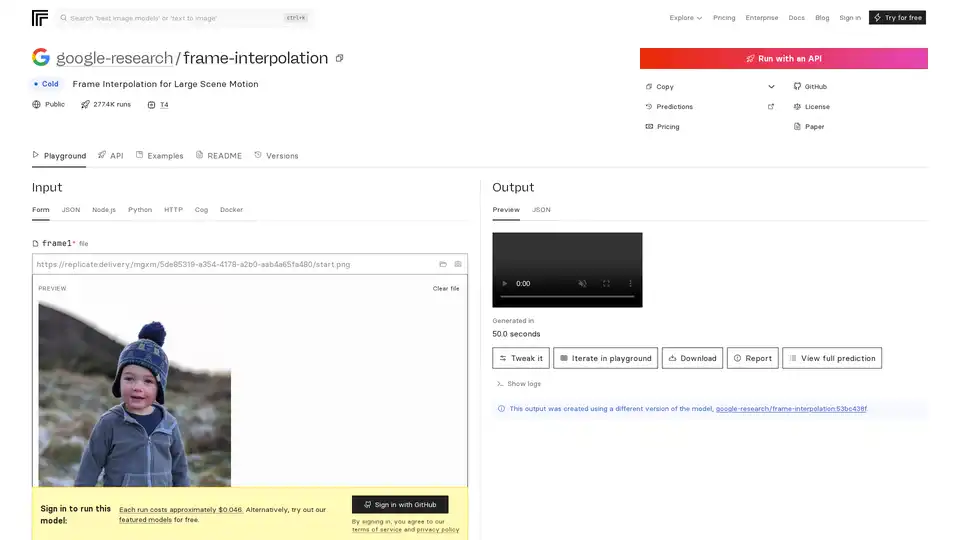

Der Einstieg in FILM ist unkompliziert, dank seiner Bereitstellung auf Plattformen wie Replicate für API-Zugriff oder seinem GitHub-Repository für lokale Ausführungen.

Via Replicate API: Laden Sie zwei Bilddateien als frame1 und frame2 hoch. Passen Sie 'times_to_interpolate' (Standard 1) an, um die Ausgabekomplexität zu definieren. Vorhersagen laufen auf Nvidia T4 GPUs und sind normalerweise in unter 4 Minuten abgeschlossen, mit Kosten von etwa $0.046 pro Lauf (ca. 21 Läufe pro Dollar). Ausgaben umfassen Vorschau-Bilder, herunterladbare Videos oder JSON-Metadaten. Kein Login erforderlich für kostenlose Tests bei featured Models, aber GitHub-Login schaltet vollen Zugriff frei.

Lokale Einrichtung mit Docker: Klonen Sie das GitHub-Repo unter https://github.com/google-research/frame-interpolation. Verwenden Sie Docker für einfache Umgebungsisolierung – ziehen Sie das Image und führen Sie Vorhersagen über die Kommandozeile aus oder integrieren Sie es in Python/Node.js-Skripte. Das Cog-Framework unterstützt benutzerdefinierte Eingaben und macht es erweiterbar für Batch-Verarbeitung.

Eingabeanforderungen: Frames sollten sequenzielle Bilder sein (z.B. JPEG/PNG). Für Video-Interpolation verarbeiten Sie Paare rekursiv. Webcam-Aufnahme wird für schnelle Tests unterstützt.

Beispiele auf Replicate zeigen reale Anwendungen, wie die Interpolation von Sportaufnahmen oder animierten Sequenzen, und demonstrieren artefaktfreie Ergebnisse.

Warum FILM für Ihre Projekte wählen?

FILM übertrifft dort, wo andere Tools scheitern, und bietet überlegene Handhabung großer Bewegungen ohne den Rechenaufwand von Multi-Model-Pipelines. Benchmark-Scores aus dem ECCV 2022-Papier heben seinen Vorteil gegenüber Konkurrenten in Metriken wie Interpolation PSNR und SSIM hervor. Es ist open-source unter einer permissiven Lizenz, fördert Community-Beiträge – Forks und verwandte Modelle wie zsxkib/film-frame-interpolation-for-large-motion passen es für video-spezifische Aufgaben an.

Kosteneffizienz ist ein weiterer Anreiz: Kostenlose lokale Läufe versus erschwingliche Cloud-Vorhersagen. Zudem bieten YouTube-Demos und das Paper transparente Validierung, um Vertrauen für den Produktionseinsatz aufzubauen. Wenn Sie mit ruckeligen Low-FPS-Videos von Drohnen oder Action-Cams umgehen, verwandelt FILM sie mühelos in kinematische Erlebnisse.

Für wen ist FILM Frame Interpolation?

Dieses Tool richtet sich an AI-Enthusiasten, Video-Editoren und Machine-Learning-Praktiker, die sich auf Computer Vision konzentrieren.

Entwickler und Forscher: Ideal für Experimente mit neuronaler Interpolation in Papieren oder Prototypen, besonders in Bereichen wie Video-Kompression oder Animation.

Content Creator: Filmemacher und YouTuber können Framerates hochskalieren für flüssigeres Playback und mobile oder Web-Videos verbessern, ohne teure Hardware.

Industry Pros: Im Gaming (z.B. Framerate-Boost für flüssigere Animationen) oder in der Überwachung (Interpolation von sparsamer Aufnahme) leuchtet FILMs Effizienz. Es eignet sich nicht für Echtzeit-Anwendungen aufgrund der Vorhersagezeiten, ist aber perfekt für Offline-Verbesserungen.

Verwandte Modelle auf Replicate, wie pollinations/rife-video-interpolation oder zsxkib/st-mfnet, ergänzen FILM durch Video-to-Video-Workflows, aber FILMs Fokus auf große Bewegungen gibt ihm einen Nischen-Vorteil.

Praktischer Wert und Anwendungsfälle

Die wahre Stärke von FILM liegt in seiner Vielseitigkeit. In der Bildung hilft es bei der Erstellung von Slow-Motion-Analysen für Physik-Demos. Für Marketing interpolieren Sie Produktaufnahmen, um fließende Rotationen zu präsentieren. User-Feedback von GitHub lobt seine Leichtigkeit bei der Handhabung von Okklusionen, die in realen Aufnahmen üblich sind.

Betrachten Sie einen Fall: Ein Wildlife-Videograf mit 15 FPS-Clips von einer wackeligen Handkamera. Mit FILM erzeugen sie 30 FPS-Ausgaben und erhalten Details in schnellen Tierbewegungen – transformieren rohe Aufnahmen in professionelle Reels.

Preismodelle sind transparent: Replicates Pay-per-Run-Modell skaliert mit der Nutzung, während Self-Hosting laufende Kosten eliminiert. Für FAQs prüfen Sie die README für Troubleshooting von Eingaben oder Versionsunterschiede (z.B. die aktuelle verwendet google-research/frame-interpolation:53bc438f).

Zusammenfassend repräsentiert FILM Googles Engagement für zugängliche AI zur Medienverbesserung. Ob Sie Workflows optimieren oder Forschung Grenzen erweitern, ist es eine zuverlässige Wahl für überlegene Frame-Interpolation. Tauchen Sie ein in das GitHub-Repo oder den Replicate-Playground, um es in Aktion zu sehen – Ihre Videos werden nie mehr gleich aussehen.