NativeMind

Übersicht von NativeMind

Was ist NativeMind?

NativeMind ist eine bahnbrechende Open-Source-Chrome-Browsererweiterung, die als vollständig offline verfügbare Alternative zu ChatGPT dient. Sie basiert ausschließlich auf lokalen Large Language Models (LLMs) wie Ollama und gewährleistet 100 % Datenschutz, da die gesamte Verarbeitung auf Ihrem Gerät erfolgt – keine Cloud-Server, keine Datenübertragung und kein Tracking. NativeMind wurde als kostenloses Tool für den persönlichen Gebrauch eingeführt und integriert sich nahtlos in Ihren Browsing-Workflow. Es bietet KI-Funktionen wie intelligentes Chatten, autonome Agenten, Inhaltsanalyse und mehr, während Sie die absolute Kontrolle über Ihre Informationen behalten.

In einer Zeit, in der Datenschutzverletzungen und Datenschutzbedenken die Schlagzeilen beherrschen, zeichnet sich NativeMind durch die Nutzung der Leistungsfähigkeit von Open-Source-Modellen wie gpt-oss, DeepSeek, Qwen, Llama, Gemma und Mistral aus. Benutzer können Modelle sofort wechseln, ohne komplexe Setups durchführen zu müssen, was es ideal für diejenigen macht, die Offline-ChatGPT-Alternativen suchen, die Sicherheit und Geschwindigkeit priorisieren.

Hauptmerkmale von NativeMind

NativeMind bietet eine Reihe leistungsstarker, auf den Datenschutz ausgerichteter Funktionen, die für die tägliche Produktivität entwickelt wurden:

- Kontextbezogener Chat über verschiedene Tabs hinweg: Fügen Sie geöffnete Browser-Tabs zu Konversationen hinzu, um Zusammenfassungen und Fragen zu erhalten, die sich über mehrere Websites erstrecken. Perfekt für Recherchen oder Multitasking ohne Beeinträchtigung der Privatsphäre.

- Chat mit PDFs, Bildern und Screenshots: Laden Sie lokale Dateien zur Analyse, Erkundung oder Recherche hoch – alles wird lokal verarbeitet.

- Agentenmodus: Ein autonomer Agent erledigt mehrstufige Aufgaben mit On-Device-Tools wie lokaler Websuche oder Dateianalyse.

- Lokale Websuche: Fragen Sie alles in Ihrem Browser ab; es werden keine externen APIs benötigt.

- Gmail-Assistent: Fassen Sie E-Mails zusammen und entwerfen Sie schneller Antworten, alles auf dem Gerät.

- Schreibwerkzeuge: Verfeinern, überarbeiten und brainstormen Sie Text überall als Ihr privater Schreibassistent.

- Immersive Übersetzung: Übersetzen Sie ganze Webseiten sofort und bewahren Sie dabei Layout und Privatsphäre.

- In-Browser-API: Lightweight-API für Entwickler zur Integration lokaler LLMs in Web-Apps ohne Server.

Diese Funktionen machen NativeMind nicht nur zu einem Chatbot, sondern zu einer vielseitigen privaten KI-Browsererweiterung, die Arbeitsabläufe beim Schreiben, Recherchieren und Automatisieren verbessert.

Wie funktioniert NativeMind?

NativeMind verbindet sich direkt mit Ollama, einem beliebten Framework zum lokalen Ausführen von LLMs auf Ihrem Rechner. Hier ist eine Schritt-für-Schritt-Aufschlüsselung:

- Installieren Sie die Erweiterung: Fügen Sie sie aus dem Chrome Web Store hinzu – kostenlos, keine Anmeldung erforderlich.

- Richten Sie Ollama ein: Führen Sie Ollama auf Ihrem Gerät aus (unterstützt CPU/GPU für optimale Leistung) und laden Sie Ihre bevorzugten Modelle.

- Nahtlose Integration: Die Erweiterung erkennt Ollama automatisch und ermöglicht sofortiges Umschalten der Modelle und Ausführen von Prompts.

- On-Device-Verarbeitung: Die gesamte KI-Inferenz erfolgt lokal. Prompts, Kontext von Tabs/Dateien und Antworten verlassen niemals Ihren Browser oder Rechner.

Minimale Hardwareanforderungen umfassen eine moderne CPU; GPU-Beschleunigung ist optional, wird aber für größere Modelle empfohlen. Es unterstützt gängige Browser über die Chrome-Kompatibilität.

Für Entwickler vereinfacht die In-Browser-API das Einbetten lokaler LLM-Antworten in Web-Apps: NativeMind.prompt('your query') gibt Ergebnisse ohne SDKs oder Backend-Server zurück.

Warum NativeMind gegenüber Cloud-basierten KI-Tools wählen?

Traditionelle Tools wie ChatGPT sind auf Cloud-Server angewiesen, wodurch Ihre Daten potenziellen Lecks, Protokollen und dem Zugriff Dritter ausgesetzt sind. NativeMind dreht den Spieß um:

- Absolute Privatsphäre: Keine Synchronisierung, keine Protokolle, keine Lecks – Ihre Daten bleiben Ihre.

- Offline-Zuverlässigkeit: Funktioniert ohne Internet, ideal für sichere Umgebungen oder Reisen.

- Kostenlos für den persönlichen Gebrauch: 100 % kostenlos; Enterprise-Optionen in Kürze verfügbar.

- Open-Source-Transparenz: Überprüfen Sie den Code auf GitHub, beteiligen Sie sich oder passen Sie ihn an.

- Enterprise-Ready-Geschwindigkeit: Optimiert für reale Aufgaben mit schneller lokaler Inferenz.

In Benchmarks konkurrieren lokale Modelle über Ollama mit der Cloud-Leistung auf leistungsfähiger Hardware, insbesondere für datenschutzsensible Aufgaben wie juristische Recherchen oder vertrauliches Schreiben.

Für wen ist NativeMind gedacht?

- Datenschutzbewusste Benutzer: Journalisten, Anwälte oder alle, die mit sensiblen Daten umgehen.

- Autoren und Forscher: Benötigen Sie eine On-Device-Zusammenfassung, Überarbeitung oder PDF-Analyse?

- Entwickler: Integrieren Sie lokale KI in Apps ohne Vendor Lock-in.

- Produktivitäts-Enthusiasten: Gmail-Entwürfe, mehrsprachige Browser oder Automatisierungssuchende.

- Offline-Mitarbeiter: Remote-Profis oder solche in Gebieten mit geringer Konnektivität.

Es ist besonders wertvoll für Benutzer von lokalen LLM-Browsererweiterungen, die von Cloud-Abhängigkeiten umsteigen.

So verwenden Sie NativeMind: Best Practices

- Erste Schritte: Installieren Sie es aus dem Chrome Web Store, stellen Sie sicher, dass Ollama lokal ausgeführt wird, und pinnen Sie die Erweiterung an.

- Täglicher Workflow: Klicken Sie mit der rechten Maustaste auf Tabs, um Kontext hinzuzufügen, laden Sie Dateien über das Popup hoch oder aktivieren Sie den Agentenmodus für komplexe Abfragen.

- Modelloptimierung: Beginnen Sie mit Lightweight-Modellen wie Gemma für Geschwindigkeit; upgraden Sie auf Llama für mehr Tiefe.

- Fehlerbehebung: Überprüfen Sie den Ollama-Status; FAQs bestätigen, dass keine Cloud-Daten gesendet werden und die volle Offline-Fähigkeit gegeben ist.

Real-User-Szenarien: Ein Marketer nutzt es für private E-Mail-Entwürfe, ein Student analysiert Forschungs-PDFs offline oder ein Entwickler erstellt KI-Funktionen lokal.

Praktischer Wert und Anwendungsfälle

NativeMind demokratisiert KI, indem es Cloud-Barrieren beseitigt. In der Bildung unterstützt es die KI-Übersetzung für das Sprachenlernen ohne Datenrisiken. Unternehmen nutzen es für sichere KI-Schreibunterstützung in Angeboten. Mit der wachsenden Akzeptanz von Edge AI – die laut Branchenberichten bis 2025 voraussichtlich um 40 % steigen wird – führen Tools wie NativeMind den Wandel zu souveräner KI an.

Kundenfeedback hebt seine Geschwindigkeit und Zuverlässigkeit hervor: "Endlich ein privater ChatGPT, der einfach funktioniert", wiederholen GitHub-Sterne. Für Unternehmen verspricht der Zugang zur Warteliste skalierte Lösungen.

Zusammenfassend lässt sich sagen, dass NativeMind Offline-KI-Assistenten mit unübertroffener Privatsphäre, Vielseitigkeit und Benutzerfreundlichkeit neu definiert. Installieren Sie es noch heute und erleben Sie KI nach Ihren Bedingungen – Ihre Daten, Ihre Kontrolle, keine Cloud.

Beste Alternativwerkzeuge zu "NativeMind"

OmniBot: Ein privater KI-Assistent, der WebGPU verwendet, um LLMs nativ in Ihrem Browser auszuführen und Ihnen ein In-Browser- und Offline-KI-Erlebnis zu bieten.

AIPal ist eine leistungsstarke Chrome-Erweiterung, die KI-Modelle wie GPT-4 und Claude 3 integriert, um direkt auf jeder Webseite zu chatten, zu schreiben, zu übersetzen und Inhalte zusammenzufassen – und so die Browsing-Produktivität zu steigern.

Text Generation Web UI ist eine leistungsstarke, benutzerfreundliche Gradio-Weboberfläche für lokale KI-basierte große Sprachmodelle. Unterstützt mehrere Backends, Erweiterungen und bietet Offline-Privatsphäre.

OpenUI ist ein Open-Source-Tool, das es Ihnen ermöglicht, UI-Komponenten in natürlicher Sprache zu beschreiben und sie live mit LLMs zu rendern. Konvertieren Sie Beschreibungen in HTML, React oder Svelte für schnelles Prototyping.

LM Studio: Führen Sie LLaMa, MPT, Gemma und andere LLMs lokal auf Ihrem Laptop aus. Laden Sie kompatible Modelle von Hugging Face herunter und verwenden Sie sie offline.

Enclave AI ist ein datenschutzorientierter KI-Assistent für iOS und macOS, der vollständig offline läuft. Er bietet lokale LLM-Verarbeitung, sichere Konversationen, Voice-Chat und Dokumenteninteraktion, ohne dass eine Internetverbindung erforderlich ist.

ProxyAI ist ein KI-gestützter Code-Assistent für JetBrains-IDEs, der Codevervollständigung, Bearbeitung in natürlicher Sprache und Offline-Support mit lokalen LLMs bietet. Verbessern Sie Ihre Codierung mit KI.

Worthify.ai bietet KI-gestützte Binäranalyse zur Schwachstellenerkennung und Malware-Analyse und lässt sich in bestehende Sicherheits-Workflows integrieren. Verbessern Sie Ihre Cybersicherheit mit KI-gestütztem Reverse Engineering.

Erleben Sie sichere KI-Gespräche mit Sanctum, unterstützt durch Open-Source-Modelle, die lokal auf Ihrem Gerät verschlüsselt werden. Führen Sie voll ausgestattete LLMs in Sekundenschnelle mit vollständiger Privatsphäre aus.

Private LLM ist ein lokaler KI-Chatbot für iOS und macOS, der offline funktioniert und Ihre Informationen vollständig auf dem Gerät, sicher und privat hält. Genießen Sie unzensierte Chats auf Ihrem iPhone, iPad und Mac.

AI Runner ist eine Offline-KI-Inferenz-Engine für Kunst, Echtzeit-Sprachkonversationen, LLM-gestützte Chatbots und automatisierte Arbeitsabläufe. Führen Sie Bilderzeugung, Voice-Chat und mehr lokal aus!

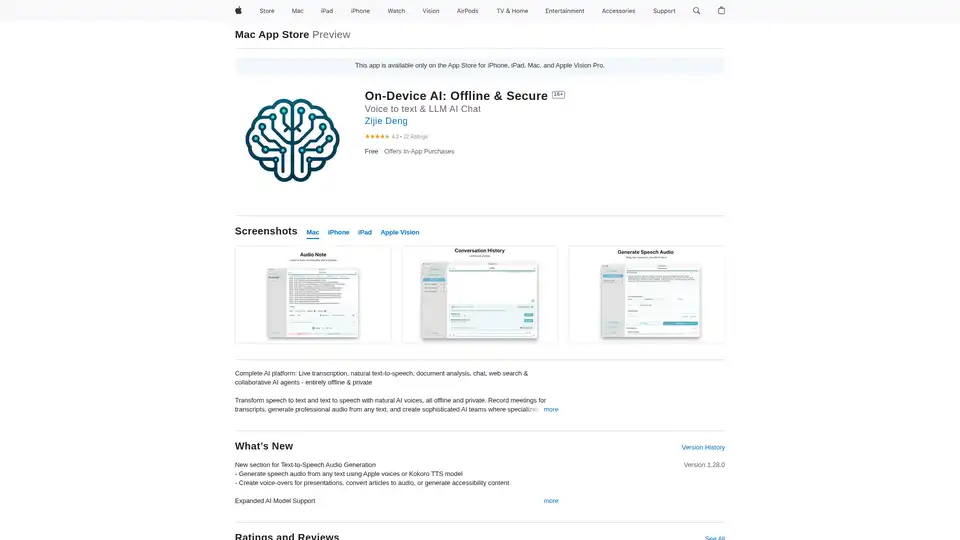

On-Device AI: Verwandeln Sie Sprache in Text, natürlichen Text in Sprache und chatten Sie offline und sicher mit LLMs auf Ihrem iPhone, iPad und Mac. Privat und leistungsstark!

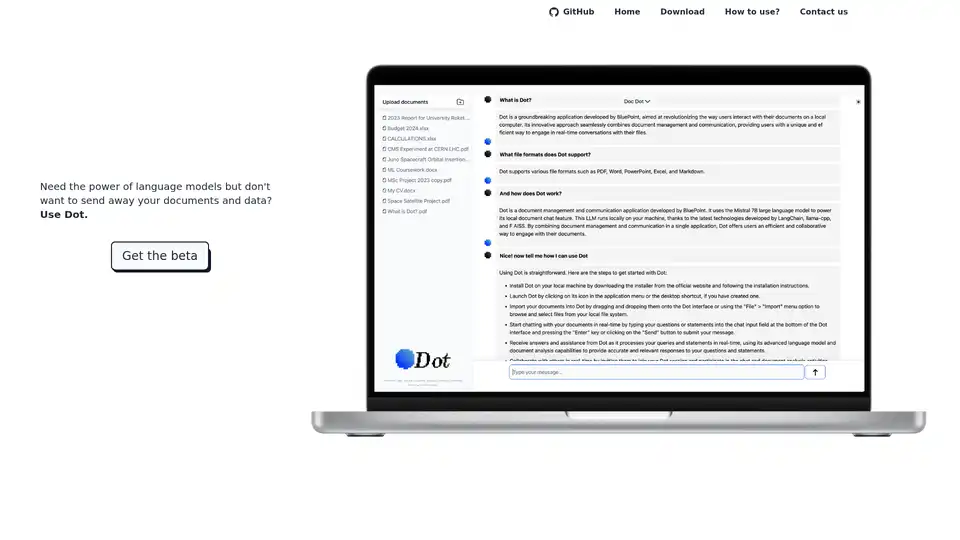

Dot ist ein lokales, Offline-KI-Chat-Tool, das von Mistral 7B unterstützt wird und es Ihnen ermöglicht, mit Dokumenten zu chatten, ohne Ihre Daten zu senden. Kostenlos und datenschutzorientiert.

RecurseChat: Eine persönliche KI-App, mit der Sie mit lokaler KI sprechen können, offline-fähig und mit PDF- und Markdown-Dateien chatten können.