OpenUI

Übersicht von OpenUI

Was ist OpenUI?

OpenUI ist ein innovatives Open-Source-Projekt, das darauf abzielt, zu revolutionieren, wie Entwickler und Designer Benutzeroberflächen erstellen. Es wird auf GitHub von Weights & Biases (W&B) gehostet und ermöglicht es Nutzern, UI-Elemente mit einfachen natürlichen Sprachprompts zu beschreiben, angetrieben von Large Language Models (LLMs), und sie sofort live im Browser gerendert zu sehen. Ob Sie Ideen brainstormen oder Anwendungen prototypen, OpenUI verwandelt imaginative Beschreibungen in funktionalen UI-Code, der Ausgaben wie HTML, React-Komponenten, Svelte oder sogar Web Components unterstützt. Dieses Tool ist besonders wertvoll in der Ära der generativen KI, wo schnelle Iteration der Schlüssel zur Innovation ist.

Im Gegensatz zu proprietären Alternativen ist OpenUI vollständig Open-Source unter der Apache-2.0-Lizenz, die es jedem ermöglicht, es zu forken, zu modifizieren oder zur Entwicklung beizutragen. Es hat bereits über 21,7k Sterne und 2k Forks auf GitHub gesammelt, was starkes Community-Interesse an KI-unterstützter UI-Generierung widerspiegelt. Im Kern nutzt OpenUI LLMs, um die Lücke zwischen konzeptionellen Ideen und ausführbarem Code zu überbrücken, und macht die UI-Entwicklung zugänglicher und unterhaltsamer.

Wie funktioniert OpenUI?

OpenUI arbeitet, indem es mit verschiedenen LLM-Anbietern integriert wird, um Ihre textuellen Beschreibungen zu verarbeiten und entsprechende UI-Markups zu generieren. Hier ist eine Aufschlüsselung seines zugrunde liegenden Mechanismus:

Eingabeverarbeitung: Sie beginnen damit, eine Beschreibung in der Weboberfläche einzugeben, wie z. B. „ein modernes Anmeldeformular mit E-Mail- und Passwortfeldern, gestylt in Tailwind CSS.“ Das Tool sendet diesen Prompt an den ausgewählten LLM-Backend.

LLM-Generierung: Mit Modellen von OpenAI (z. B. GPT-4o), Groq, Gemini, Anthropic (Claude) oder sogar lokalen Optionen wie Ollama und LiteLLM-kompatiblen Diensten interpretiert die KI den Prompt und gibt strukturierten Code aus. Es unterstützt multimodale Eingaben, wenn vision-fähige Modelle wie LLaVA verwendet werden.

Live-Rendering: Der generierte Code wird sofort in einem Live-Vorschau-Bereich gerendert. Sie können iterieren, indem Sie Änderungen anfordern, wie „fügen Sie einen ‚Passwort vergessen‘-Link hinzu“ oder „konvertieren Sie zu React-Komponenten.“

Code-Export und -Konvertierung: Über das Rendering hinaus kann OpenUI die Ausgabe in verschiedene Frameworks umwandeln. Zum Beispiel generiert es zunächst vanilla HTML/CSS/JS und konvertiert dann auf Anfrage zu React oder Svelte. Diese Flexibilität wird durch Backend-Python-Skripte und Frontend-TypeScript-Code angetrieben.

Die Architektur umfasst einen Python-Backend für LLM-Interaktionen über LiteLLM (ein einheitlicher Proxy für Hunderte von Modellen) und einen TypeScript-basierten Frontend für die interaktive UI. Umgebungsvariablen handhaben API-Schlüssel sicher und stellen nahtlose Integration ohne Hardcoding sensibler Daten sicher. Für lokale Setups verwendet es Tools wie uv für Abhängigkeitsmanagement und Docker für containerisierte Bereitstellung.

In Bezug auf technische Details trennt die Repo-Struktur von OpenUI Frontend (React-ähnlich mit Vite) und Backend (FastAPI-inspiriert), mit Assets für Demos und Docs. Neueste Updates umfassen i18n-Unterstützung, benutzerdefinierte Endpunkt-Konfigurationen und Monaco-Editor-Integration für Code-Anpassungen – was seine Evolution zu robusteren Funktionen zeigt.

Wie verwendet man OpenUI?

Der Einstieg in OpenUI ist unkompliziert, ob Sie es lokal ausführen oder über eine Demo. Folgen Sie diesen Schritten für optimale Ergebnisse:

Zugriff auf die Demo: Gehen Sie zur Live-Demo unter openui.fly.dev, um ohne Setup zu testen. Beschreiben Sie eine UI, wählen Sie ein Modell (falls API-Schlüssel konfiguriert sind) und sehen Sie zu, wie es rendert.

Lokale Installation über Docker (Empfohlen für Anfänger):

- Stellen Sie sicher, dass Docker installiert ist.

- Setzen Sie Ihre API-Schlüssel:

export OPENAI_API_KEY=your_key_here(und andere wie ANTHROPIC_API_KEY, falls benötigt). - Für Ollama-Integration: Installieren Sie Ollama lokal, ziehen Sie ein Modell (z. B.

ollama pull llava) und führen Sie aus:docker run --rm -p 7878:7878 -e OPENAI_API_KEY -e OLLAMA_HOST=http://host.docker.internal:11434 ghcr.io/wandb/openui. - Besuchen Sie http://localhost:7878, um mit der UI-Generierung zu beginnen.

Aus dem Quellcode (Für Entwickler):

- Klonen Sie das Repo:

git clone https://github.com/wandb/openui. - Navigieren Sie zum Backend:

cd openui/backend. - Installieren Sie Abhängigkeiten:

uv sync --frozen --extra litellm(uv ist ein schneller Python-Paketmanager). - Aktivieren Sie die virtuelle Umgebung:

source .venv/bin/activate. - Setzen Sie API-Schlüssel und führen Sie aus:

python -m openui. - Für Dev-Modus mit Frontend: Führen Sie

npm run devim Frontend-Verzeichnis für Hot-Reloading aus.

- Klonen Sie das Repo:

Erweiterte Konfigurationen:

- LiteLLM Custom Proxy: Erstellen Sie eine

litellm-config.yaml-Datei, um Modell-Endpunkte zu überschreiben, nützlich für selbst gehostete Setups wie LocalAI. - Ollama für Offline-Nutzung: Setzen Sie

OLLAMA_HOSTauf Ihre Instanz (z. B. http://127.0.0.1:11434). Modelle wie LLaVA ermöglichen bildbasierte Prompts. - Gitpod oder Codespaces: Für cloudbasierte Entwicklung konfigurieren diese die Umgebung im Voraus – ideal für Tests ohne lokale Hardware.

- LiteLLM Custom Proxy: Erstellen Sie eine

Tipps für beste Ergebnisse: Verwenden Sie beschreibende Prompts mit Spezifika (z. B. „responsive Navbar mit Tailwind-Klassen“). Wenn die Generierung langsam wird, wählen Sie schnellere Modelle wie Groq. Das Tool erkennt automatisch verfügbare Modelle aus Ihren Umgebungsvariablen und füllt das Einstellungsmodal entsprechend.

Warum OpenUI wählen?

In einem überfüllten Feld von KI-Tools sticht OpenUI durch seinen Open-Source-Geist und den Fokus auf UI-spezifische Generierung heraus. Traditionelles UI-Bauen beinhaltet oft mühsames Wireframing und Codieren, aber OpenUI beschleunigt dies mit generativer KI und verkürzt die Prototyping-Zeit von Stunden auf Minuten. Es ist nicht so poliert wie kommerzielle Tools wie v0, aber seine Transparenz ermöglicht Anpassungen – perfekt für Teams, die LLMs in Workflows integrieren.

Wichtige Vorteile umfassen:

- Breite Modellunterstützung: Funktioniert mit über 100 LLMs über LiteLLM, von Cloud-APIs bis zu lokaler Inferenz.

- Framework-agnostisch: Gibt anpassbaren Code für HTML, React, Svelte usw. aus und reduziert Vendor-Lock-in.

- Community-getrieben: Aktives GitHub mit 205 Commits, kürzlichen Redesigns und Beiträgen von über 20 Entwicklern.

- Kosteneffizient: Kostenlos lokal ausführbar; zahlen Sie nur für API-Nutzung bei bezahlten LLMs.

- Bildungswert: Großartig zum Lernen, wie LLMs Code-Generierung handhaben, mit transparenter Backend-Logik.

Nutzer loben seine unterhaltsame, iterative Natur – ideal, um Kreativität anzuregen, ohne Setup-Reibung. Zum Beispiel können Designer Ideen schnell visualisieren, während Entwickler AI-Ausgaben im Monaco-Editor debuggen.

Für wen ist OpenUI?

OpenUI richtet sich an ein vielfältiges Publikum im AI- und Entwicklungsraum:

- UI/UX-Designer: Schnelles Prototyping von Interfaces aus Skizzen oder Ideen, um Konzepte vor der vollständigen Umsetzung zu validieren.

- Frontend-Entwickler: Generieren von Boilerplate-Code für Tailwind-stylisierte Komponenten, um React- oder Svelte-Projekte zu beschleunigen.

- AI-Enthusiasten und Forscher: Experimentieren mit LLM-Anwendungen in der UI-Generierung, insbesondere mit offenen Modellen wie denen von Ollama.

- Produktteams in Startups: Günstiges Prototyping von MVPs, integriert mit dem W&B-Ökosystem für ML-App-Building.

- Pädagogen und Studenten: Lehren generativer AI-Konzepte durch hands-on UI-Erstellung.

Es eignet sich besonders für diejenigen, die mit grundlegenden Command-Line-Tools vertraut sind, obwohl die Docker-Option die Hürde senkt. Wenn Sie LLM-gestützte Apps bauen, dient OpenUI als praktisches Beispiel für AI-angereicherte Entwicklung.

Praktischer Wert und Anwendungsfälle

Der reale Nutzen von OpenUI leuchtet in Szenarien auf, die schnelle Iterationen erfordern:

Schnelles Prototyping: Beschreiben Sie ein Dashboard und erhalten Sie einen live, interaktiven Mockup – verfeinern Sie über chat-ähnliche Anpassungen.

Code-Snippet-Generierung: Brauchen Sie ein responsives Formular? Prompten Sie es, kopieren Sie den React-Code und integrieren Sie ihn in Ihre App.

Barrierefreiheits-Tests: Generieren Sie UIs und bewerten Sie die Einhaltung von Best Practices wie semantischem HTML durch die AI.

Kollaboratives Design: Teilen Sie Prompts in Team-Settings für konsistente UI-Visionen.

Aus Nutzerfeedback in GitHub-Issues (63 offen) umfassen gängige Verbesserungen besseres Fehlerhandling und Multi-Page-Unterstützung, was aktives Wachstum anzeigt. Preisgestaltung? Vollkommen kostenlos als Open-Source, obwohl LLM-Kosten anfallen (z. B. OpenAI-Tokens).

Zusammenfassend demokratisiert OpenUI die UI-Erstellung durch generative AI und fördert Effizienz und Innovation. Für das beste Erlebnis erkunden Sie die Docs des Repos und tragen Sie bei – es ist ein lebendiges Projekt, das die Grenzen von AI im Design vorantreibt.

Beste Alternativwerkzeuge zu "OpenUI"

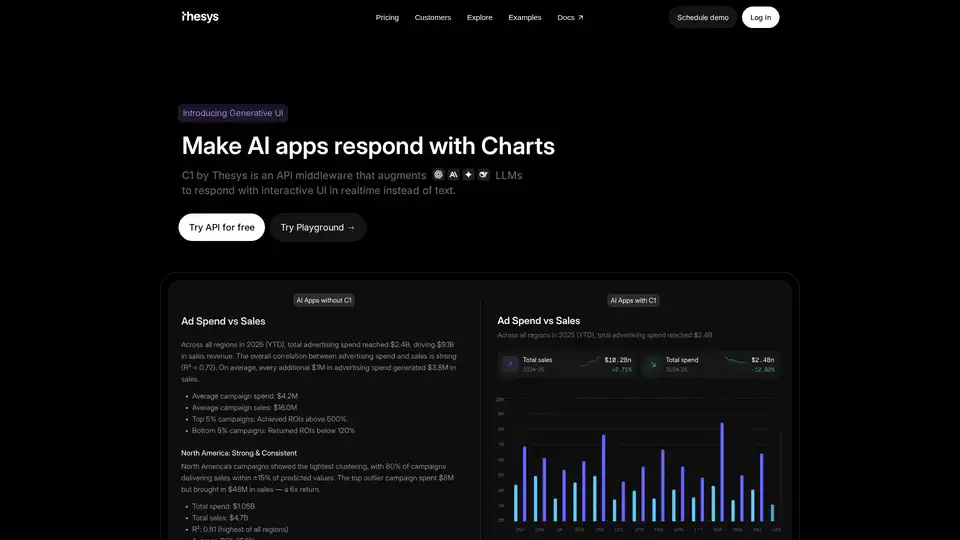

C1 von Thesys ist eine API-Middleware, die LLMs erweitert, um in Echtzeit mit interaktiven UIs anstelle von Text zu antworten und die Antworten Ihres Modells mithilfe von React SDK in Live-Schnittstellen zu verwandeln.

AI Runner ist eine Offline-KI-Inferenz-Engine für Kunst, Echtzeit-Sprachkonversationen, LLM-gestützte Chatbots und automatisierte Arbeitsabläufe. Führen Sie Bilderzeugung, Voice-Chat und mehr lokal aus!

GenSearch revolutioniert die Suche mithilfe generativer KI und ermöglicht es Benutzern, benutzerdefinierte KI-gestützte Suchmaschinen mit personalisierten Erlebnissen und nahtlosen Integrationen zu erstellen.

Devzery revolutioniert API-Tests mit KI-gestützter Automatisierung für Regressions-, Integrations- und Lasttests. Integrieren Sie in CI/CD-Pipelines für schnellere, fehlerfreie Releases und gesteigerte Effizienz in der Softwareentwicklung.

Erstellen Sie KI-gestützte Apps und KI-Agenten, die Ihre Aufgaben automatisch planen und ausführen. Bauen Sie Ihre Full-Stack-KI-Apps und monetarisieren Sie sie mit dem flexiblen GenAI-App-Entwicklungs-Framework von Momen. Starten Sie heute!

Chatten Sie mit KI unter Verwendung Ihrer API-Schlüssel. Zahlen Sie nur für das, was Sie nutzen. Unterstützt GPT-4, Gemini, Claude und andere LLMs. Die beste Chat-LLM-Frontend-OI für alle KI-Modelle.

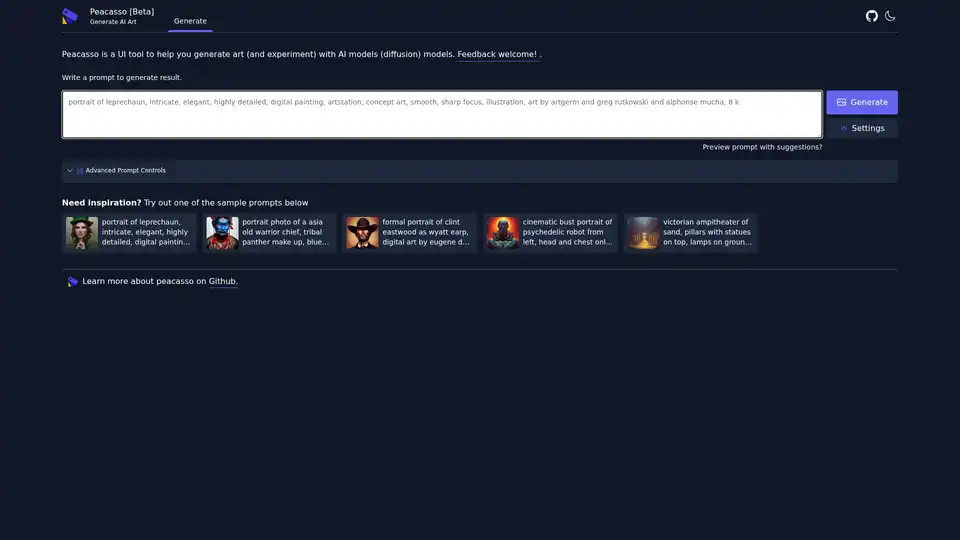

Peacasso ist ein Beta-UI-Tool zur Generierung von KI-Kunst mit Diffusionsmodellen. Erstellen Sie aufwendige digitale Gemälde und Konzeptkunst mühelos mit Prompts – ideal für Künstler, die mit KI-Kreativität experimentieren.

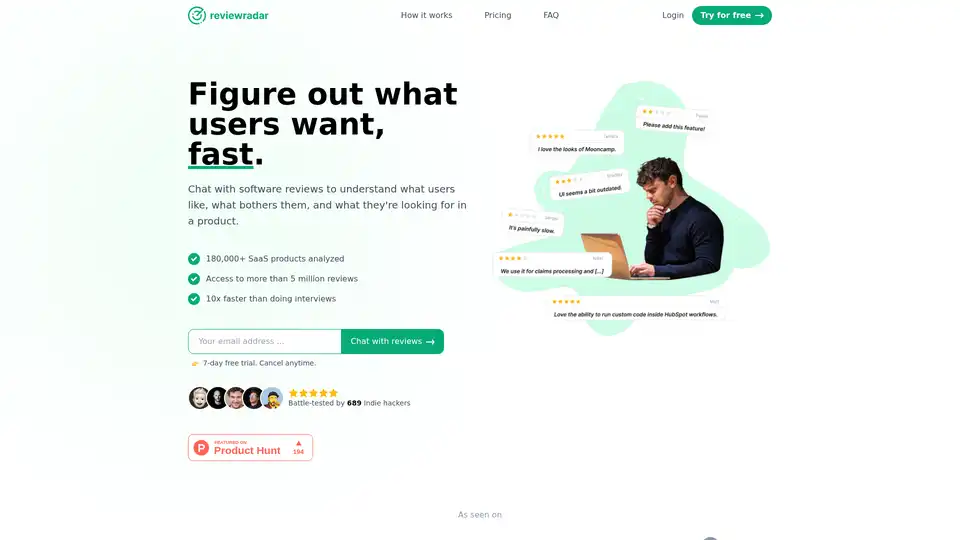

Reviewradar nutzt KI, um über 5 Millionen SaaS-Bewertungen zu analysieren und liefert sofortige Nutzer-Einblicke über einen einfachen Chatbot. Ideal für Produktmanager, die schnellere Marktforschung ohne Interviews suchen.

Entdecken Sie Lab2, das KI-Tool, das Text-Prompts in Python-Apps mit Streamlit, Gradio und Flask umwandelt. Ideal für schnelles Prototyping ohne Coding-Kenntnisse.

Soverin ist der ultimative AI-Marktplatz zum Entdecken, Kaufen und Nutzen der besten AI-Apps und Agents. Automatisieren Sie über 10.000 Aufgaben, von der Erstellung von Agents bis zur Skalierung des Kundensupports, und steigern Sie die Produktivität mit trendigen Automatisierungstools.

Entdecken Sie AIO, den wegweisenden KI-Kopiloten für Modemarken. Beschleunigen Sie Designprozesse, ermöglichen Sie virtuelle Abtastung und starten Sie produktionsreife Kollektionen schneller mit generativen KI-Tools für Skizzen bis zu fotorealistischer Kleidung.

JsonGPT ist eine KI-API, die die JSON-Datengenerierung mit OpenAI vereinfacht. Es bietet Funktionen wie JSON-Validierung, Caching und Streaming, um die Entwicklung zu beschleunigen und Kosten zu senken.

Meteron AI ist ein All-in-One-KI-Toolset, das LLM- und generative KI-Messung, Load-Balancing und Speicherung übernimmt, sodass sich Entwickler auf die Entwicklung von KI-gestützten Produkten konzentrieren können.

Bria.ai bietet Gen AI Developer Toolkits für Unternehmenslösungen. Greifen Sie auf vollständig lizenzierte Datensätze, quelloffene Modelle und APIs zu, um maßgeschneiderte generative KI-Lösungen für die Bilderzeugung und -bearbeitung zu erstellen.