xTuring

Übersicht von xTuring

Was ist xTuring?

xTuring ist eine innovative Open-Source-Bibliothek, die entwickelt wurde, um die Personalisierung von Large Language Models (LLMs) zu vereinfachen. Entwickelt vom Team bei Stochastic, befähigt sie Entwickler, Forscher und AI-Enthusiasten, benutzerdefinierte LLMs zu erstellen und zu steuern, die auf spezifische Bedürfnisse zugeschnitten sind. Im Gegensatz zu generischen AI-Frameworks legt xTuring den Schwerpunkt auf benutzerfreundliche Anpassung und ermöglicht es Ihnen, Modelle mit Ihren eigenen Datensätzen zu optimieren, ohne tiefe Expertise in komplexen Machine-Learning-Pipelines.

Im Kern adressiert xTuring eine zentrale Herausforderung in der KI: die Zugänglichkeit und Anpassungsfähigkeit leistungsstarker LLMs für reale Anwendungen. Egal ob Sie ein Modell für Nischenaufgaben wie domänenspezifische Inhaltsgenerierung verbessern oder für ressourcenbeschränkte Umgebungen optimieren – xTuring bietet die Tools, um das Potenzial von KI auf personalisierte Weise freizusetzen.

Wie funktioniert xTuring?

xTuring agiert als schlankes Toolkit, das nahtlos mit beliebten LLMs wie LLaMA, GPT-J, Bloom und mehr integriert. Seine Architektur basiert auf Effizienz und Modularität und ermöglicht es Nutzern, den gesamten Workflow – von der Datenaufbereitung bis zur Modell-Inferenz – mit minimalem Aufwand zu handhaben.

Wichtige Komponenten und Workflow

- Datenaufbereitung und Datensatzverwaltung: Beginnen Sie mit der Vorbereitung Ihres Datensatzes mithilfe der Utilities von xTuring. Es unterstützt das Laden, Speichern und Vorverarbeiten von Datensätzen wie Alpaca, was es einfach macht, Daten mit Ihren Personalisierungsgoals abzustimmen. Dieser Schritt stellt sicher, dass Ihr benutzerdefiniertes Modell aus relevanten, hochwertigen Eingaben lernt.

- Modellladen und Feinabstimmung: Laden Sie vortrainierte Modelle von Hugging Face oder anderen Quellen. xTuring zeichnet sich durch Feinabstimmung mit fortschrittlichen Techniken wie LoRA (Low-Rank Adaptation) und INT8-Quantisierung aus, die den Rechenaufwand reduzieren, während die Leistung erhalten bleibt. So können Sie beispielsweise ein 7B LLaMA 2-Modell auf dem Alpaca-Datensatz in Stunden statt Tagen feinabstimmen.

- Inferenz und Deployment: Sobald abgestimmt, deployen Sie Ihr Modell für Inferenz direkt in xTuring. Es unterstützt effiziente Speichernutzung und ermöglicht Inferenz auf Standardhardware ohne massive GPU-Cluster.

- Konfiguration und Anpassung: Ein flexibles Konfigurationssystem erlaubt es Ihnen, Hyperparameter anzupassen und agile Experimente zu ermöglichen. Dies ist besonders nützlich für iterative Entwicklungen in schnell evolvierenden AI-Landschaften.

Die Prinzipien der Bibliothek – Einfachheit, Effizienz und Agilität – sorgen dafür, dass Workflows intuitiv sind. Befehle wie xturing train handhaben die Feinabstimmung von Anfang bis Ende und abstrahieren den üblichen Boilerplate-Code in Tools wie Transformers.

Kernfunktionen von xTuring

xTuring hebt sich durch Funktionen hervor, die Produktivität und Leistung priorisieren:

- Unterstützung für vielfältige Modelle: Es funktioniert mit einer breiten Palette von LLMs, einschließlich Bloom, Cerebras-GPT, Falcon, Galactica, GPT-2, GPT-J, LLaMA, LLaMA 2 und OPT. Beispiele umfassen die Feinabstimmung von Falcon 7B mit oder ohne LoRA und INT8 für optimierte Speichernutzung.

- LoRA- und Quantisierungs-Integration: LoRA ermöglicht parameter-effiziente Feinabstimmung, indem nur ein kleiner Teil der Gewichte aktualisiert wird, was ideal für ressourcenschwache Setups ist. INT8-Quantisierung komprimiert Modelle weiter und beschleunigt Training und Inferenz um bis zu 4x, ohne signifikanten Genauigkeitsverlust.

- Ressourceneffizienz: Entwickelt für Optimierung von Rechenleistung und Speicher minimiert xTuring den Ressourcenverbrauch und macht es machbar, auf Laptops oder Edge-Geräten zu laufen. Dies ist ein Game-Changer für Indie-Entwickler oder kleine Teams ohne Enterprise-Hardware.

- Benutzerfreundliche Oberfläche: Mit einer einfachen API können sogar Anfänger AI personalisieren. Fortgeschrittene Nutzer schätzen die Erweiterbarkeit für benutzerdefinierte Wrapper um jedes LLM.

- Community-getriebene Beispiele: Vorgefertigte Notebooks und Skripte für gängige Aufgaben, wie Feinabstimmung auf Alpaca, beschleunigen den Einstieg.

Diese Funktionen machen xTuring zu einem vielseitigen Tool für die LLM-Personalisierung und senken die Einstiegshürden in der AI-Entwicklung.

Primäre Anwendungsfälle für xTuring

xTuring glänzt in Szenarien, in denen Standard-LLMs aufgrund fehlender Spezifität versagen. Hier sind einige praktische Anwendungen:

- Domänenspezifische AI-Anpassung: Feinabstimmen von Modellen für Branchen wie Gesundheitswesen, Finanzen oder Recht, unter Verwendung proprietärer Datensätze, um konforme, genaue Assistenten zu erstellen.

- Forschung und Experimente: Forscher können neue Anpassungstechniken schnell prototypen und Hypothesen mit LoRA auf Modellen wie Galactica für die Generierung wissenschaftlicher Texte testen.

- Produktentwicklung: Erstellen von Chatbots, Inhaltsgeneratoren oder virtuellen Assistenten, die auf Nutzerdaten zugeschnitten sind, um Datenschutz und Relevanz zu gewährleisten.

- Bildungstools: Lehrer und Studenten können mit AI-Ethik oder Sprachlernen experimentieren, indem sie offene Modelle personalisieren.

- Edge-AI-Deployment: Optimieren von Modellen für Mobile- oder IoT-Geräte, wo Effizienz entscheidend ist.

Für transaktionale Nutzer, die nach 'how to fine-tune LLM with LoRA' suchen, bietet xTuring Schritt-für-Schritt-Anleitungen und senkt die Lernkurve.

Warum xTuring wählen?

In einer überfüllten AI-Landschaft unterscheidet sich xTuring durch sein Engagement für Zugänglichkeit und Innovation. Lizenziert unter Apache 2.0 ist es kostenlos zu verwenden und zu modifizieren und fördert eine lebendige Open-Source-Community. Nutzer loben das Gleichgewicht aus Leistung und Einfachheit – 'Es ist wie eine persönliche AI-Werkstatt', wie ein Testimonial bemerkt.

Im Vergleich zu Alternativen wie der PEFT-Bibliothek von Hugging Face bietet xTuring eine integriertere Erfahrung mit integrierter Datensatzverwaltung und Inferenz-Unterstützung, die Stunden an Einrichtungszeit spart. Das globale Team von Stochastic sorgt für laufende Updates und hält Schritt mit LLM-Fortschritten.

Realer Wert? Entwickler berichten von 30-50 % schnelleren Trainingzeiten und reduzierten Speicherfootprints, was mehr iterative Arbeit ermöglicht. Für Unternehmen bedeutet das Kosteneinsparungen bei Cloud-Ressourcen, während Forscher ein zuverlässiges Tool für reproduzierbare Experimente gewinnen.

Für wen ist xTuring?

xTuring ist ideal für ein breites Publikum:

- Anfänger-Entwickler: Diejenigen, die neu in AI sind und in LLMs eintauchen wollen, ohne überwältigende Komplexität.

- Erfahrene ML-Ingenieure: Profis, die effiziente Feinabstimmung für produktionsreife Apps suchen.

- Forscher: Akademiker, die Modellanpassung in Bereichen wie Natural Language Processing erkunden.

- Startups und KMU: Teams, die anpassbare AI ohne große Budgets für proprietäre Lösungen brauchen.

- Hobbyisten und Pädagogen: Jeder, der leidenschaftlich an AI-Personalisierung für kreative oder Lehrrzwecke interessiert ist.

Wenn Sie nach 'best open-source LLM fine-tuning tool' suchen, passt xTuring perfekt und bietet Skalierbarkeit von persönlichen Projekten bis zu Enterprise-Deployments.

So starten Sie mit xTuring

Der Einstieg ist unkompliziert:

- Installation: Installieren Sie über pip:

pip install xturing. Es unterstützt Python 3.8+ und integriert sich mit PyTorch. - Quickstart: Folgen Sie der offiziellen Anleitung, um ein Modell wie LLaMA zu laden und auf einem Beispieldatensatz zu feinabstimmen.

- Beispiele erkunden: Tauchen Sie in Jupyter-Notebooks für LoRA-Experimente oder INT8-Optimierungen ein.

- Community-Support: Treten Sie dem Discord bei für Troubleshooting oder teilen Sie Ideen auf Twitter (@stochasticai).

Für fortgeschrittene Nutzer deckt die Dokumentation das Laden benutzerdefinierter Datensätze und die Konfiguration von Multi-GPU-Training ab.

Praktischer Wert und Nutzer-Einblicke

Die wahre Stärke von xTuring liegt in seinem Impact: Es demokratisiert AI, indem es Personalisierung für Nicht-Experten machbar macht. Nutzerfeedback hebt seine Rolle bei der Beschleunigung von Projekten hervor – ein Entwickler teilte, wie es seine Feinabstimmungszeit von Wochen auf Tage reduzierte und schnellere MVP-Launches ermöglichte.

In Bezug auf SEO für AI-Tools rangiert xTuring hoch für Queries wie 'open-source LLM customization library' dank umfassender Docs und aktiver Community. Sein E-E-A-T ist evident in der Expertise des Teams von Stochastic, unterstützt durch transparente Lizenzierung und Fokus auf ethische AI.

FAQs aus den Docs adressieren gängige Pain Points:

- Q: Unterstützt es quantisierte Modelle? A: Ja, INT8 ist integriert für Effizienz.

- Q: Kann ich meine eigenen Daten verwenden? A: Absolut, mit einfachen Tools für Datensatzvorbereitung.

- Q: Ist es produktionsreif? A: Ja, mit stabilen Inferenz-Endpunkten.

Kundenfälle umfassen akademische Papers, die xTuring für reproduzierbare LLM-Experimente zitieren, und Startups, die es für interne Wissensbasen nutzen.

Schlussfolgerung: Personalisierte AI mit xTuring freisetzen

xTuring ist nicht nur eine Bibliothek – es ist ein Tor zu innovativen AI-Anwendungen. Indem es Einfachheit, Effizienz und Anpassbarkeit priorisiert, befähigt es Sie, LLMs zu formen, die zu Ihrer Vision passen. Egal für Forschung, Business oder Neugier – xTuring liefert greifbaren Wert in der dynamischen Welt der Künstlichen Intelligenz. Starten Sie heute Ihre Reise und erleben Sie die Freiheit der personalisierten AI.

Beste Alternativwerkzeuge zu "xTuring"

Unsloth AI bietet Open-Source-Feinabstimmung und verstärkendes Lernen für LLMs wie gpt-oss und Llama, mit 30-mal schnellerem Training und reduziertem Speicherverbrauch, wodurch KI-Training zugänglich und effizient wird.

Olostep ist eine Webdaten-API für KI und Forschungsagenten. Sie ermöglicht es Ihnen, strukturierte Webdaten von jeder Website in Echtzeit zu extrahieren und Ihre Web-Research-Workflows zu automatisieren. Anwendungsfälle sind Daten für KI, Tabellenkalkulationsanreicherung, Leadgenerierung und mehr.

Mit UBIAI können Sie in wenigen Minuten leistungsstarke und genaue benutzerdefinierte LLMs erstellen. Optimieren Sie Ihren KI-Entwicklungsprozess und optimieren Sie LLMs für zuverlässige KI-Lösungen.

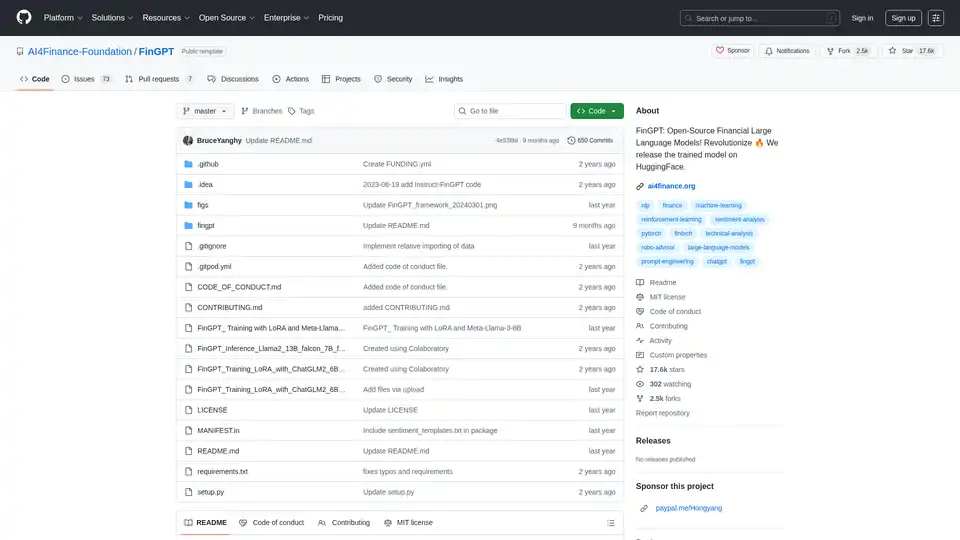

FinGPT: Ein Open-Source-Finanz-Large-Language-Modell zur Demokratisierung von Finanzdaten, Sentimentanalyse und Prognose. Schnelle Feinabstimmung für zeitnahe Markteinblicke.

Yepp AI ist eine KI-gestützte Marketingplattform, die Unternehmen dabei unterstützt, mehr Leads zu generieren und das Unternehmenswachstum durch Content-Erstellung, Datenanalyse und Marketing-Automatisierung voranzutreiben.

Coxwave Align ermöglicht modernen Organisationen, Daten aus LLM-basierten konversationellen Produkten einfach zu analysieren und zu bewerten.

Dynamiq ist eine On-Premise-Plattform zum Erstellen, Bereitstellen und Überwachen von GenAI-Anwendungen. Vereinfachen Sie die AI-Entwicklung mit Funktionen wie LLM-Feinabstimmung, RAG-Integration und Beobachtbarkeit, um Kosten zu senken und den Geschäfts-ROI zu steigern.

Xander ist eine Open-Source-Desktop-Plattform, die No-Code-KI-Modelltraining ermöglicht. Beschreiben Sie Aufgaben in natürlicher Sprache für automatisierte Pipelines in Textklassifikation, Bildanalyse und LLM-Fine-Tuning, mit Garantie für Datenschutz und Leistung auf Ihrem lokalen Gerät.

Label Studio ist eine flexible Open-Source-Datenkennzeichnungsplattform für die Feinabstimmung von LLMs, die Vorbereitung von Trainingsdaten und die Bewertung von KI-Modellen. Unterstützt verschiedene Datentypen wie Text, Bilder, Audio und Video.

Keywords AI ist eine führende LLM-Monitoring-Plattform, die für KI-Startups entwickelt wurde. Überwachen und verbessern Sie Ihre LLM-Anwendungen einfach mit nur 2 Codezeilen. Debuggen Sie, testen Sie Prompts, visualisieren Sie Protokolle und optimieren Sie die Leistung für zufriedene Benutzer.

Trainieren, verwalten und evaluieren Sie benutzerdefinierte große Sprachmodelle (LLMs) schnell und effizient auf Entry Point AI, ohne dass Code erforderlich ist.

Refact.ai, der führende Open-Source-KI-Agent für Softwareentwicklung, automatisiert Codierung, Debugging und Tests mit vollständiger Kontextsensitivität. Eine Open-Source-Alternative zu Cursor und Copilot.

Vext entwickelt kundenspezifische KI-Lösungen für Unternehmen, einschließlich LLM-Anwendungen, Modell-Feinabstimmung, Managed Hosting und kundenspezifische API-Dienste.

EvalsOne: Plattform zur iterativen Entwicklung und Perfektionierung generativer KI-Anwendungen, zur Rationalisierung des LLMOps-Workflows für Wettbewerbsvorteile.