Supermemory

Descripción general de Supermemory

Supermemoria: La capa de memoria para la era de la IA

¿Qué es Supermemoria? Supermemoria se presenta como un laboratorio de investigación y productos centrado en la construcción de la capa de memoria para la IA, con el objetivo de proporcionar una memoria dinámica, similar a la humana, que pueda escalar de manera eficiente. Proporciona herramientas tanto para desarrolladores como para usuarios finales para aprovechar la memoria de la IA en sus aplicaciones y flujos de trabajo.

Características clave:

- API de memoria y enrutador: Supermemoria ofrece una API de memoria y un enrutador rápidos y escalables, lo que permite a los desarrolladores agregar funciones de memoria a largo plazo a sus aplicaciones.

- Creación y almacenamiento de memoria eficientes: El sistema promete una creación, almacenamiento y capacidades de búsqueda de memoria eficientes.

- Rendimiento: Supermemoria afirma ser 2 veces más rápido y económico que las soluciones de memoria existentes.

- Memoria entre clientes: Los usuarios pueden acceder a sus recuerdos en varios clientes de IA, incluidos ChatGPT, Claude y Cursor.

- Integración: Supermemoria se integra con más de 100 clientes de IA a través de MCP (Panel de control de memoria).

- Creación e inferencia de memoria automáticas: El sistema admite la creación e inferencia de memoria automáticas mediante gráficos.

¿Cómo funciona Supermemoria?

Supermemoria funciona proporcionando una API y un SDK (Supermemory SDK) que los desarrolladores pueden usar para integrar capacidades de memoria en sus aplicaciones de IA. Permite el almacenamiento y la recuperación eficientes de información, lo que permite a los modelos de IA retener y recordar interacciones y datos pasados.

¿Cómo usar Supermemoria?

Para desarrolladores: Los desarrolladores pueden usar la API y el SDK de Supermemoria para agregar funciones de memoria a largo plazo a sus aplicaciones. Esto implica:

- Integrar la API en su aplicación de IA.

- Utilizar las funciones de creación, almacenamiento y búsqueda de memoria.

- Aprovechar el enrutador para una gestión eficiente de la memoria.

Para los usuarios: Los usuarios pueden acceder a sus recuerdos en diferentes clientes de IA mediante el MCP, que se integra con más de 100 clientes de IA. Esto permite a los usuarios tener una experiencia de memoria coherente en varias plataformas.

¿Para quién es Supermemoria?

Supermemoria se dirige a dos grupos principales:

- Desarrolladores de IA: Los desarrolladores que buscan agregar capacidades de memoria a sus aplicaciones de IA pueden usar la API y el SDK de memoria.

- Usuarios de IA: Los usuarios que desean una experiencia de memoria unificada en múltiples plataformas de IA pueden beneficiarse del MCP.

¿Por qué es importante Supermemoria?

La memoria es un componente crucial de los sistemas inteligentes. Al proporcionar una capa de memoria rápida, escalable y dinámica, Supermemoria mejora las capacidades de las aplicaciones de IA. Esto les permite:

- Retener información a lo largo del tiempo.

- Personalizar las interacciones.

- Tomar decisiones más informadas basadas en experiencias pasadas.

Casos de uso:

- Asistentes de IA personalizados: Cree asistentes de IA que recuerden las preferencias del usuario y las interacciones pasadas.

- Chatbots sensibles al contexto: Desarrolle chatbots que puedan mantener el contexto y proporcionar respuestas más relevantes.

- Agentes de IA mejorados: Cree agentes de IA que puedan aprender de la experiencia y adaptarse a los entornos cambiantes.

¿Hay una lista de espera para la aplicación Supermemoria?

Sí, hay una lista de espera para el nuevo MCP (Panel de control de memoria).

Conclusiones clave:

Supermemoria ofrece una solución para integrar la memoria en las aplicaciones de IA. Al ofrecer una capa de memoria que imita la memoria humana, tiene como objetivo mejorar el rendimiento y la personalización de las interacciones de la IA. Supermemoria es para aquellos que buscan mejorar las aplicaciones de IA con capacidades de memoria a largo plazo, proporcionando un medio para almacenar, recordar y personalizar datos de manera eficiente.

Gestión de Tareas y Proyectos con IA Resumido y Lectura de Documentos con IA Búsqueda Inteligente con IA Análisis de Datos con IA Flujo de Trabajo Automatizado

Mejores herramientas alternativas a "Supermemory"

Scoopika es una plataforma de código abierto para construir aplicaciones de IA multimodal con LLM y agentes de IA, con recuperación de errores, transmisión y validación de datos.

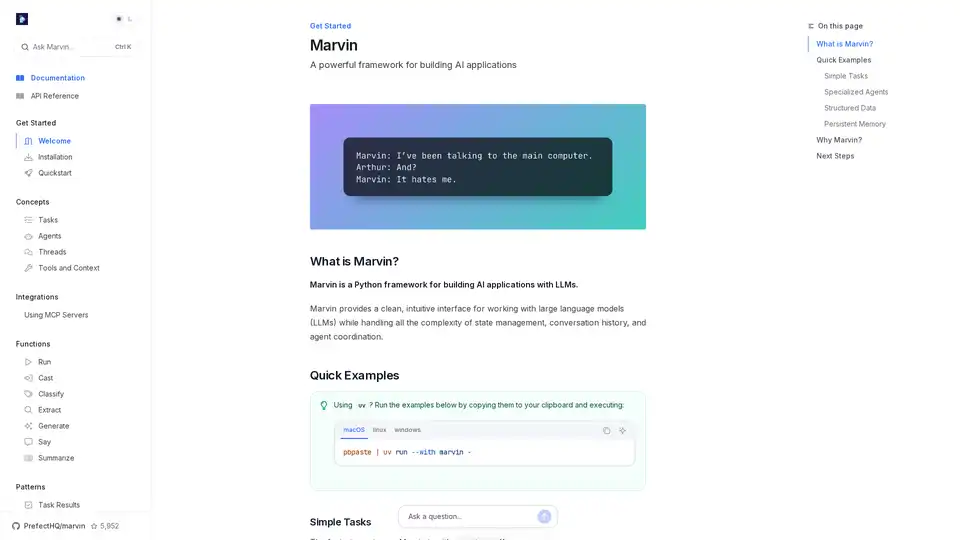

Marvin es un potente framework de Python para construir aplicaciones de IA con modelos de lenguaje grandes (LLM). Simplifica la gestión de estados, coordinación de agentes y salidas estructuradas para desarrolladores que crean apps inteligentes.

xMem sobrecarga las aplicaciones LLM con memoria híbrida, combinando conocimiento a largo plazo y contexto en tiempo real para una IA más inteligente.

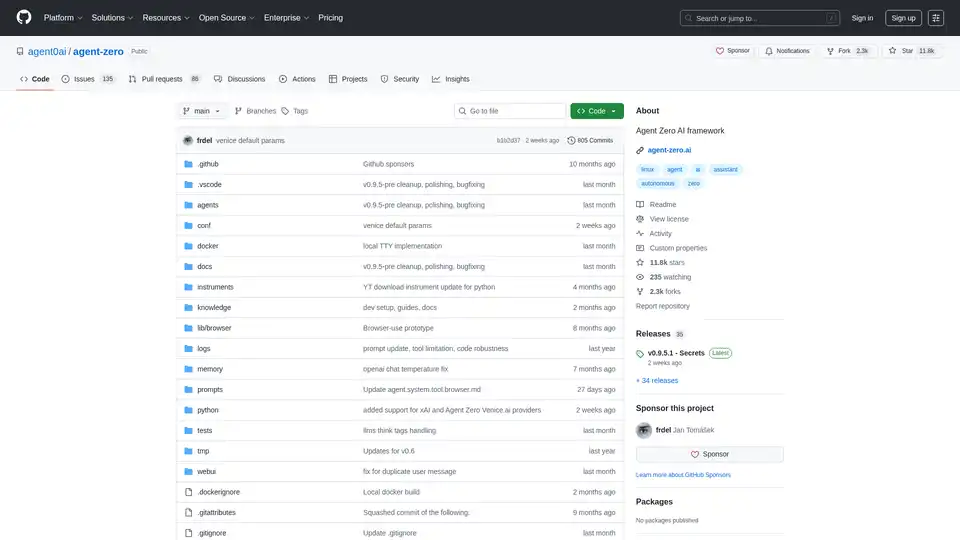

Agent Zero es un framework AI open source para construir agentes autónomos que aprenden y crecen orgánicamente. Cuenta con cooperación multiagente, ejecución de código y herramientas personalizables.