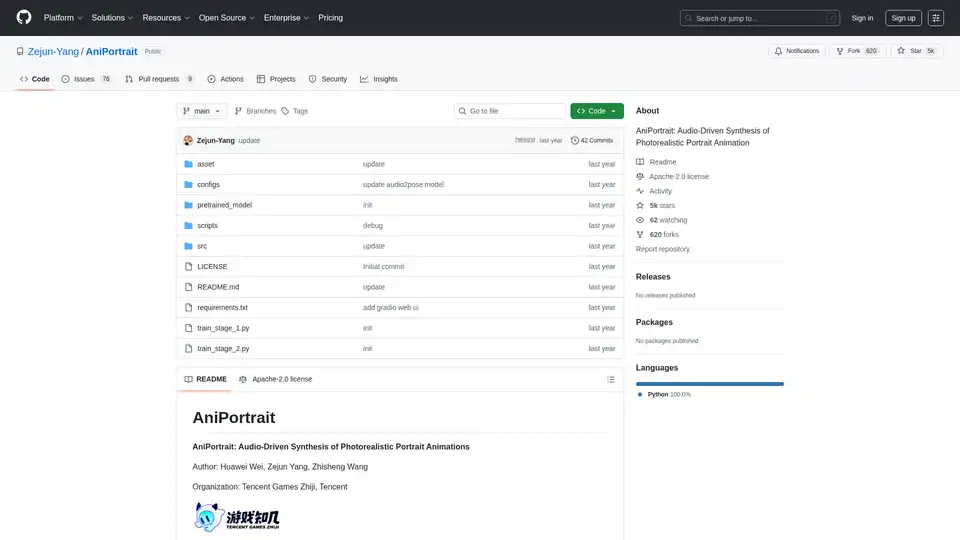

AniPortrait

Descripción general de AniPortrait

¿Qué es AniPortrait?

AniPortrait es un marco innovador de código abierto diseñado para la síntesis de animaciones de retratos fotorrealistas impulsada por audio. Desarrollado por Huawei Wei, Zejun Yang y Zhisheng Wang de Tencent Games Zhiji y Tencent, esta herramienta aprovecha técnicas avanzadas de IA para crear retratos animados de alta calidad a partir de una sola imagen de referencia y entradas de audio o video. Ya sea que estés animando un retrato estático con audio de voz o recreando expresiones faciales de un video fuente, AniPortrait entrega resultados realistas que capturan matices sutiles como la sincronización labial y los movimientos de cabeza. Ideal para creadores de contenido, desarrolladores de juegos e investigadores en visión por computadora, destaca en el ámbito de las herramientas de generación de video con IA al enfocarse en animaciones específicas de retratos.

Lanzado en GitHub bajo la licencia Apache-2.0, AniPortrait ha acumulado más de 5.000 estrellas, reflejando su popularidad en la comunidad de IA. El proyecto enfatiza la accesibilidad, con modelos preentrenados, guías detalladas de instalación e incluso una interfaz web Gradio para pruebas fáciles.

¿Cómo funciona AniPortrait?

En su núcleo, AniPortrait emplea un pipeline de múltiples etapas que integra modelos de difusión, procesamiento de audio y estimación de poses para generar animaciones. El marco se basa en modelos establecidos como Stable Diffusion V1.5 y wav2vec2 para la extracción de características, asegurando un manejo robusto de la sincronización audio-visual.

Componentes clave y flujo de trabajo

- Procesamiento de entrada: Comienza con una imagen de retrato de referencia. En el modo impulsado por audio, las entradas de audio se procesan usando wav2vec2-base-960h para extraer características de voz. En modos de video, los videos fuente se convierten en secuencias de poses mediante extracción de puntos clave.

- Generación de poses: El modelo audio2pose genera secuencias de poses de cabeza (por ejemplo, pose_temp.npy) a partir del audio, permitiendo el control sobre las orientaciones faciales. Para la recreación facial, una estrategia de retargeting de poses mapea movimientos del video fuente a la imagen de referencia, soportando diferencias sustanciales en las poses.

- Síntesis de animación: Utiliza UNet de denoising, UNet de referencia y módulos de movimiento para sintetizar frames. El guía de poses asegura la alineación, mientras que la interpolación de frames opcional acelera la inferencia.

- Refinamiento de salida: Genera videos en resoluciones como 512x512, con opciones de aceleración usando film_net_fp16.pt para reducir el tiempo de procesamiento.

Este enfoque modular permite animaciones autodirigidas (usando poses predefinidas), recreación facial (transfiriendo expresiones) y síntesis completamente impulsada por audio, haciendo que sea versátil para diversos escenarios de animación de retratos con IA.

Características principales de AniPortrait

AniPortrait incluye una gama de funciones potentes adaptadas para animación realista de retratos:

- Animación de retratos impulsada por audio: Sincroniza movimientos de labios y expresiones con entradas de audio, perfecto para doblaje o avatares virtuales.

- Recreación facial: Transfiere actuaciones faciales de un video fuente a un retrato objetivo, ideal para aplicaciones éticas similares a deepfake en medios.

- Control y retargeting de poses: Estrategias actualizadas manejan diversas poses de cabeza, incluyendo la generación de archivos de poses personalizados para control preciso.

- Salida de alta resolución: Produce videos fotorrealistas con soporte para secuencias más largas (hasta 300 frames o más).

- Opciones de aceleración: Interpolación de frames y modelos FP16 aceleran la inferencia sin sacrificar calidad.

- Interfaz web Gradio: Una interfaz amigable para demostraciones rápidas, también alojada en Hugging Face Spaces para acceso en línea.

- Modelos preentrenados: Incluye pesos para audio2mesh, audio2pose y componentes de difusión, descargables de fuentes como Wisemodel.

Estas características hacen de AniPortrait una herramienta esencial para la síntesis de video impulsada por IA, superando herramientas básicas al enfocarse en la fidelidad de retratos y la coherencia audio-visual.

Instalación y configuración

Comenzar es sencillo para usuarios con Python >=3.10 y CUDA 11.7:

- Clona el repositorio:

git clone https://github.com/Zejun-Yang/AniPortrait. - Instala dependencias:

pip install -r requirements.txt. - Descarga pesos preentrenados a

./pretrained_weights/, incluyendo componentes de Stable Diffusion, wav2vec2 y modelos personalizados comodenoising_unet.pthyaudio2pose.pt. - Organiza archivos según la estructura de directorios en el README.

Para entrenamiento, prepara conjuntos de datos como VFHQ o CelebV-HQ extrayendo puntos clave y ejecutando scripts de preprocesamiento. El entrenamiento ocurre en dos etapas usando Accelerate para procesamiento distribuido.

¿Cómo usar AniPortrait?

Modos de inferencia

AniPortrait soporta tres modos principales a través de scripts de línea de comandos:

Animación autodirigida:

python -m scripts.pose2vid --config ./configs/prompts/animation.yaml -W 512 -H 512 -accPersonaliza con imágenes de referencia o videos de poses. Convierte videos a poses usando

python -m scripts.vid2pose --video_path input.mp4.Recreación facial:

python -m scripts.vid2vid --config ./configs/prompts/animation_facereenac.yaml -W 512 -H 512 -accEdita el YAML para incluir videos fuente y referencias.

Síntesis impulsada por audio:

python -m scripts.audio2vid --config ./configs/prompts/animation_audio.yaml -W 512 -H 512 -accAgrega audios e imágenes a la configuración. Habilita audio2pose eliminando pose_temp para generación automática de poses.

Para control de pose de cabeza, genera poses de referencia con python -m scripts.generate_ref_pose.

Demostración web

Lanza la interfaz Gradio: python -m scripts.app. O prueba la versión en línea en Hugging Face Spaces.

Los usuarios pueden experimentar con videos de muestra como 'cxk.mp4' o 'jijin.mp4' para ver la sincronización de audio en acción, obtenidos de plataformas como Bilibili.

Entrenamiento de AniPortrait desde cero

Usuarios avanzados pueden entrenar modelos personalizados:

- Preparación de datos: Descarga conjuntos de datos, preprocesa con

python -m scripts.preprocess_datasety actualiza rutas JSON. - Etapa 1:

accelerate launch train_stage_1.py --config ./configs/train/stage1.yaml. - Etapa 2: Descarga pesos del módulo de movimiento, especifica checkpoints de Etapa 1 y ejecuta

accelerate launch train_stage_2.py --config ./configs/train/stage2.yaml.

Este proceso ajusta finamente en datos específicos de retratos, mejorando la generalización para tareas de animación con IA.

¿Por qué elegir AniPortrait?

En un campo abarrotado de herramientas de IA para generación de video, AniPortrait destaca por su enfoque especializado en retratos fotorrealistas. A diferencia de modelos de propósito general, maneja la sincronización audio-labial y expresiones sutiles con precisión, reduciendo artefactos en animaciones faciales. La naturaleza de código abierto permite personalización, y actualizaciones recientes —como la liberación de audio2pose en abril de 2024 y módulos de aceleración— lo mantienen a la vanguardia. Reconocimientos de la comunidad a proyectos como EMO y AnimateAnyone resaltan sus raíces colaborativas, asegurando un rendimiento confiable.

El valor práctico incluye prototipado más rápido para influencers virtuales, videos educativos o activos de juegos. Con disponibilidad del paper en arXiv (eprint 2403.17694), sirve a investigadores que exploran síntesis audio-visual en visión por computadora.

¿Para quién es AniPortrait?

- Creadores de contenido y cineastas: Para doblaje rápido o transferencias de expresiones en videos de formato corto.

- Desarrolladores de juegos en estudios como Tencent: Integrando retratos animados en medios interactivos.

- Investigadores de IA: Experimentando con animación basada en difusión y retargeting de poses.

- Aficionados y educadores: Usando la interfaz web para enseñar conceptos de IA sin configuración pesada.

Si buscas la mejor manera de crear animaciones de retratos impulsadas por audio, el equilibrio de AniPortrait en calidad, velocidad y accesibilidad lo convierte en una opción principal.

Aplicaciones potenciales y casos de uso

- Avatares virtuales: Anima personajes digitales con voz sincronizada para redes sociales o metaversos.

- Herramientas educativas: Genera videos de cabezas parlantes para conferencias o tutoriales.

- Producción de medios: Recreación facial ética para recreaciones históricas o anuncios.

- Prototipado de investigación: Benchmark de modelos audio-to-video en papers de CV.

Demostraciones incluyen clips autodirigidos como 'solo.mp4' y ejemplos de audio como 'kara.mp4', mostrando integración fluida.

Para resolución de problemas, revisa las 76 cuestiones abiertas en GitHub o contribuye vía pull requests. En general, AniPortrait empodera a los usuarios para empujar los límites en animación de retratos con IA con resultados confiables y de alta fidelidad.

Mejores herramientas alternativas a "AniPortrait"

StreamChatAI es un bot de chat de Twitch impulsado por IA que mejora la participación del espectador y automatiza la moderación. Ofrece comandos personalizados, contenido generado por IA, moderación inteligente y herramientas de gestión de transmisión.

CAMB.AI es una plataforma de localización impulsada por IA que proporciona traducción en tiempo real en más de 150 idiomas, en la que confían IMAX, el Abierto de Australia y la MLS. Revolucionando la accesibilidad al contenido en entretenimiento, deportes y más.

Media.io es una plataforma de inteligencia artificial todo en uno para la creación de video, imagen y audio. Ofrece herramientas como el generador de video con IA, imagen a video, texto a música y eliminación de marcas de agua, que atienden tanto al uso personal como comercial.

Mango AI es un generador de videos impulsado por IA que crea fotos parlantes, avatares e intercambios de rostros sin esfuerzo. Ideal para especialistas en marketing, educadores y creadores de contenido.

HitPaw VoicePea es un cambiador de voz en tiempo real y mesa de sonido meme impulsado por IA con más de 300 efectos de voz AI. Perfecto para juegos, streaming y reuniones en línea. ¡Cambia tu voz y domina el momento!

Fineshare FineCam es un software de cámara virtual AI para grabación de video de alta definición y videoconferencias atractivas en Windows y Mac. Utilice su teléfono como una cámara web y elimine el fondo en tiempo real.

VisionFX es un estudio creativo de IA todo en uno que genera imágenes, videos, música y contenido de voz utilizando tecnología de IA avanzada. Perfecto para creadores de contenido, diseñadores y especialistas en marketing.

AIVidly es una app todo-en-uno de creador de video IA para iPhone que convierte texto en videos profesionales con voces en off IA, efectos y optimizaciones para TikTok y YouTube Shorts, sin habilidades de edición.

MirrorizeAI es una comunidad de arte IA vibrante que empodera a los creadores para generar imágenes, videos y música impresionantes con realismo cinematográfico. Colabora globalmente, itera rápido y desbloquea tu imaginación sin suscripciones.

LMNT ofrece voz AI rápida, realista y asequible. Disfruta de clones de voz de calidad de estudio y streaming de baja latencia ideal para apps conversacionales, juegos y agentes. Diseñado para fiabilidad, escala sin esfuerzo con tecnología creada por un equipo ex-Google.

CharGen es un generador de contenido fantástico impulsado por IA que crea personajes, NPCs, monstruos, mapas y herramientas de campaña para entusiastas de D&D, Pathfinder y RPG.

UniFab AI es una solución impulsada por IA que mejora la calidad de video y audio. Las características incluyen potenciadores de video/audio, convertidor, editor. Mejora a 16K, reduce el ruido, colorea y más.

Easy-Peasy.AI es una plataforma de IA todo en uno que ofrece herramientas de creación de contenido, generación de imágenes, transcripción de audio y generación de video con IA. Crea contenido sorprendente 10 veces más rápido con IA.

El editor de video AI de Filmora ofrece clips cortos inteligentes, mejora de video AI y activos creativos, lo que facilita la creación de videos para todos los niveles de habilidad.