FILM Frame Interpolation

Descripción general de FILM Frame Interpolation

¿Qué es la Interpolación de Marcos FILM?

FILM, abreviatura de Frame Interpolation for Large Motion, es una red neuronal de vanguardia desarrollada por Google Research para generar marcos intermedios suaves en videos, particularmente aquellos que involucran movimientos significativos de la escena. A diferencia de los métodos tradicionales que dependen de redes preentrenadas para flujo óptico o estimación de profundidad, FILM utiliza un enfoque unificado de una sola red. Esto la hace eficiente y poderosa para crear interpolaciones de alta calidad directamente a partir de tripletes de marcos durante el entrenamiento. Lanzada como una implementación open-source de TensorFlow 2, es accesible para desarrolladores e investigadores que buscan mejorar la fluidez de los videos sin configuraciones complejas.

El modelo destaca por su capacidad para manejar movimientos grandes de la escena—piense en objetos en movimiento rápido o paneos dinámicos de la cámara—donde las técnicas de interpolación convencionales a menudo fallan, produciendo artefactos o desenfoques. Al compartir pesos de convolución a través de extractores de características multi-escala, FILM logra puntuaciones de referencia de vanguardia mientras mantiene la arquitectura ligera y entrenable a partir de entradas básicas.

¿Cómo funciona FILM?

En su núcleo, FILM procesa dos marcos de entrada (frame1 y frame2) para predecir marcos intermedios en marcas de tiempo especificadas. El proceso comienza con una etapa de extracción de características multi-escala, donde las capas convolucionales analizan las entradas en diferentes resoluciones para capturar tanto detalles finos como patrones de movimiento más amplios. Estas características se fusionan y refinan a través de una serie de operaciones de sobremuestreo y mezcla para generar el marco de salida o la secuencia de video.

Clave para su innovación es la evitación de dependencias externas. La interpolación de marcos tradicional podría calcular correspondencias a nivel de píxel usando flujo óptico, pero FILM aprende estas implícitamente dentro de su red. Durante la inferencia, controla la profundidad de interpolación con el parámetro 'times_to_interpolate': configure en 1 para un solo marco intermedio (en t=0.5), o más alto (hasta 8) para un video completo con marcos exponencialmente más (2^times_to_interpolate + 1 total, a 30 FPS). Esta invocación recursiva asegura transiciones suaves, incluso en escenarios desafiantes como oclusiones o deformaciones rápidas.

El informe técnico subyacente de 2022 detalla cómo se entrenó el modelo en conjuntos de datos de video diversos, optimizando para calidad perceptual sobre precisión píxel-perfecta. Esto resulta en salidas visualmente agradables que imitan la percepción humana, lo que lo hace ideal para aplicaciones más allá de la síntesis cruda.

¿Cómo usar la Interpolación de Marcos FILM?

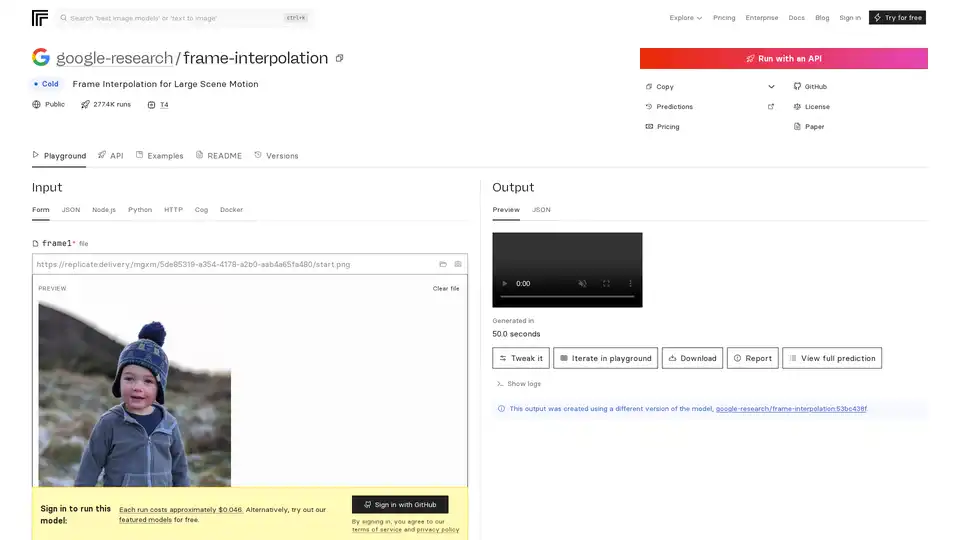

Comenzar con FILM es sencillo, gracias a su despliegue en plataformas como Replicate para acceso API o su repositorio de GitHub para ejecuciones locales.

Vía API de Replicate: Suba dos archivos de imagen como frame1 y frame2. Ajuste 'times_to_interpolate' (predeterminado 1) para definir la complejidad de salida. Las predicciones se ejecutan en GPUs Nvidia T4, típicamente completando en menos de 4 minutos, con costos alrededor de $0.046 por ejecución (aproximadamente 21 ejecuciones por dólar). Las salidas incluyen imágenes de vista previa, videos descargables o metadatos JSON. No se requiere inicio de sesión para pruebas gratuitas en modelos destacados, pero el inicio de sesión de GitHub desbloquea acceso completo.

Configuración Local con Docker: Clone el repositorio de GitHub en https://github.com/google-research/frame-interpolation. Use Docker para un aislamiento de entorno fácil—descargue la imagen y ejecute predicciones vía línea de comandos o integre en scripts de Python/Node.js. El marco Cog soporta entradas personalizadas, lo que lo hace extensible para procesamiento por lotes.

Requisitos de Entrada: Los marcos deben ser imágenes secuenciales (p. ej., JPEG/PNG). Para interpolación de video, procese pares recursivamente. Se soporta captura con webcam para pruebas rápidas.

Ejemplos en Replicate muestran usos del mundo real, como interpolar footage deportivo o secuencias animadas, demostrando resultados sin artefactos.

¿Por qué elegir FILM para sus proyectos?

FILM destaca donde otras herramientas fallan, ofreciendo un manejo superior de movimientos grandes sin la sobrecarga computacional de pipelines multi-modelo. Las puntuaciones de referencia del artículo de ECCV 2022 resaltan su ventaja sobre competidores en métricas como PSNR y SSIM de interpolación. Es open-source bajo una licencia permisiva, fomentando contribuciones de la comunidad—forks y modelos relacionados como zsxkib/film-frame-interpolation-for-large-motion lo adaptan para tareas específicas de video.

La rentabilidad es otro atractivo: ejecuciones locales gratuitas versus predicciones en la nube asequibles. Además, sus demos en YouTube y el artículo proporcionan validación transparente, construyendo confianza para uso en producción. Si está lidiando con videos de baja FPS entrecortados de drones o cámaras de acción, FILM los convierte en experiencias cinematográficas sin esfuerzo.

¿Para quién es la Interpolación de Marcos FILM?

Esta herramienta se dirige a entusiastas de AI, editores de video y practicantes de machine learning enfocados en visión por computadora.

Desarrolladores e Investigadores: Ideal para experimentar con interpolación neural en artículos o prototipos, especialmente en áreas como compresión de video o animación.

Creadores de Contenido: Cineastas y YouTubers pueden escalar tasas de marcos para reproducción más suave, mejorando videos móviles o web sin hardware costoso.

Profesionales de la Industria: En gaming (p. ej., boosting de tasa de marcos para animaciones más suaves) o vigilancia (interpolando footage escaso), la eficiencia de FILM brilla. No es adecuado para aplicaciones en tiempo real debido a los tiempos de predicción, pero perfecto para mejora offline.

Modelos relacionados en Replicate, como pollinations/rife-video-interpolation o zsxkib/st-mfnet, complementan FILM ofreciendo flujos de trabajo de video a video, pero el enfoque de FILM en movimiento grande le da una ventaja nicho.

Valor Práctico y Casos de Uso

El verdadero poder de FILM radica en su versatilidad. En educación, ayuda en la creación de análisis en cámara lenta para demos de física. Para marketing, interpole tomas de productos para mostrar rotaciones fluidas. Retroalimentación de usuarios de GitHub elogia su facilidad en manejar oclusiones, comunes en footage real.

Considere un caso: Un videógrafo de vida silvestre con clips de 15 FPS de una cámara de mano inestable. Usando FILM, generan salidas de 30 FPS, preservando detalles en movimientos rápidos de animales—transformando footage crudo en reels profesionales.

Los esquemas de precios son transparentes: El modelo pay-per-run de Replicate escala con el uso, mientras que el auto-hosting elimina costos continuos. Para FAQs, revise el README para troubleshooting de entradas o diferencias de versión (p. ej., el actual usa google-research/frame-interpolation:53bc438f).

En resumen, FILM representa el compromiso de Google con AI accesible para mejora de medios. Ya sea que esté optimizando flujos de trabajo o empujando límites de investigación, es una elección confiable para interpolación de marcos superior. Sumérjase en el repositorio de GitHub o el playground de Replicate para verlo en acción—sus videos nunca se verán igual.

Mejores herramientas alternativas a "FILM Frame Interpolation"

VideoProc Converter AI es una solución integral de procesamiento de medios con IA para mejorar, convertir, editar, comprimir, descargar y grabar videos, imágenes y audio con aceleración GPU. Admite videos 4K/8K, DVDs y medios en línea.

VIDIO simplifica la edición de video con IA, reduciendo el tiempo y haciéndola accesible para principiantes. Las funciones incluyen gráficos en movimiento impulsados por IA, creación de resaltados, transformación de objetos y mejora de video. Compatible con almacenamiento en la nube y editores de escritorio.

Mejore la calidad de video a 8K con HitPaw VikPea, el mejorador de video AI que desenfoca, restaura y colorea sus videos con un solo clic. Experimente una mejora de video rápida, estable y a gran escala.

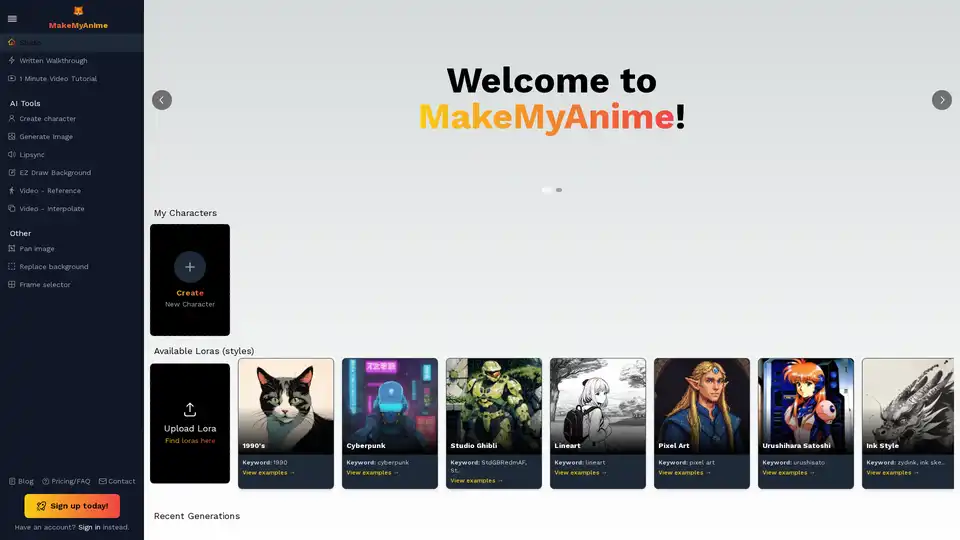

MakeMyAnime ofrece herramientas impulsadas por IA para crear animaciones fácilmente. Las características incluyen la creación de personajes, la generación de imágenes, la sincronización labial y el dibujo de fondos EZ. ¡Regístrate gratis y empieza a animar hoy mismo!

Mejora tus vídeos con Topaz Video, un software impulsado por IA para mejorar la resolución, reducir el ruido, estabilizar y suavizar el metraje. Con la confianza de los profesionales creativos para obtener resultados de calidad cinematográfica.

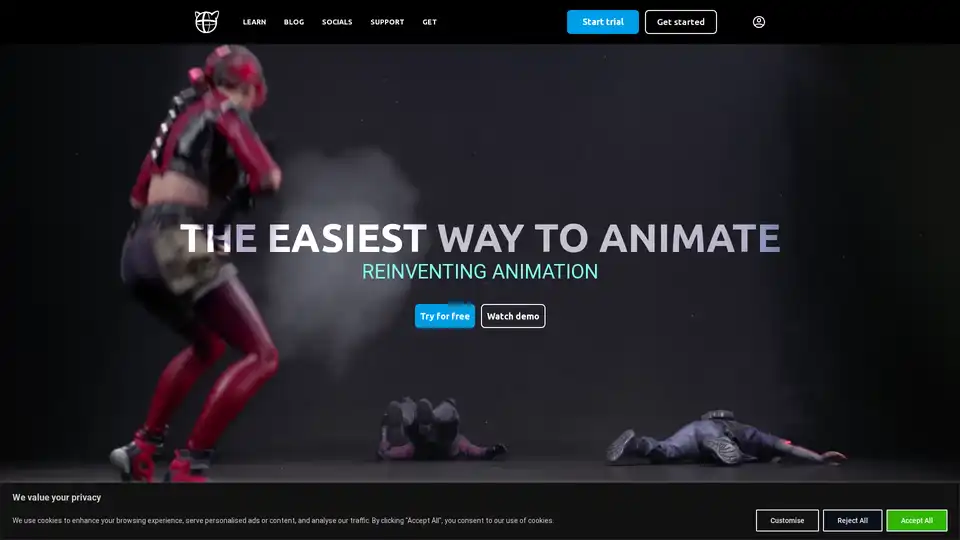

Cascadeur es un software de animación 3D independiente que utiliza IA para ayudar en la animación de fotogramas clave. Ofrece funciones como AutoPosing, AutoPhysics y rigging de personajes fácil para acelerar el proceso de animación y producir resultados de alta calidad.

Winxvideo AI es un completo kit de herramientas de video con IA para mejorar la calidad de video/imagen a 4K, estabilizar videos temblorosos, aumentar los fps, convertir, comprimir, editar video y grabar la pantalla con aceleración de GPU.

AVCLabs Video Enhancer AI utiliza tecnología IA avanzada para mejorar la calidad del video, aumentar la resolución de SD a 8K, restaurar material antiguo, colorear videos en blanco y negro y estabilizar imágenes temblorosas con resultados profesionales.

Descubre bigmp4, una herramienta IA de vanguardia para ampliación de video sin pérdida a 2K/4K/8K, colorización de blanco y negro, interpolación IA para 60-240fps suaves y movimiento lento sedoso. Soporta MP4, MOV y más.

AnyEnhancer es un mejorador de video AI que transforma los videos en alta calidad al aumentar la escala a 4K, reducir el ruido, colorear, suavizar y restaurar rostros. ¡Mejora tu video ahora!

Crea tus propios programas de televisión y películas con el software de creación de video impulsado por IA de Focal. Genere a partir de un guión, edite con chat y use los últimos modelos de IA para extensión de video, interpolación de fotogramas y más.

Transforma fotos en dibujos animados cautivadores con ToonCrafter AI, una herramienta de IA de código abierto para la interpolación de dibujos animados y la generación de video sin problemas. Perfecto para entusiastas de la animación y directores creativos.

Anvsoft ofrece herramientas de video y foto impulsadas por IA, incluido AVCLabs Video Enhancer AI, diseñado para mejorar las experiencias multimedia.

Aiarty ofrece software de mejora y mate de imagen/video con IA para mejorar, realzar, restaurar imágenes/videos, eliminar o cambiar fondos.