Friendli Inference

Descripción general de Friendli Inference

Friendli Inference: El motor de inferencia LLM más rápido

¿Qué es Friendli Inference?

Friendli Inference es un motor altamente optimizado diseñado para acelerar el servicio de Modelos de Lenguaje Grandes (LLM), reduciendo significativamente los costos entre un 50% y un 90%. Destaca como el motor de inferencia LLM más rápido del mercado, superando a vLLM y TensorRT-LLM en las pruebas de rendimiento.

¿Cómo funciona Friendli Inference?

Friendli Inference logra su notable rendimiento a través de varias tecnologías clave:

- Batching de Iteración: Esta innovadora tecnología de batching gestiona eficientemente las solicitudes de generación concurrentes, logrando un rendimiento de inferencia LLM hasta diez veces mayor en comparación con el batching convencional, manteniendo los mismos requisitos de latencia. Está protegido por patentes en EE. UU., Corea y China.

- Librería DNN: Friendli DNN Library comprende un conjunto de kernels de GPU optimizados diseñados específicamente para la IA generativa. Esta biblioteca permite una inferencia LLM más rápida para varias formas de tensores y tipos de datos, admite la cuantificación, Mixture of Experts (MoE) y adaptadores LoRA.

- Friendli TCache: Este sistema de almacenamiento en caché inteligente identifica y almacena los resultados computacionales de uso frecuente, reduciendo la carga de trabajo en las GPU al aprovechar los resultados almacenados en caché.

- Decodificación Especulativa: Friendli Inference admite de forma nativa la decodificación especulativa, una técnica de optimización que acelera la inferencia LLM/LMM al hacer conjeturas fundamentadas sobre los tokens futuros en paralelo mientras se genera el token actual. Esto garantiza salidas de modelo idénticas en una fracción del tiempo de inferencia.

Características y Beneficios Clave

- Ahorro de Costos Significativo: Reduce los costos de servicio de LLM entre un 50% y un 90%.

- Servicio Multi-LoRA: Admite simultáneamente múltiples modelos LoRA en menos GPU, incluso en una sola GPU.

- Amplio Soporte de Modelos: Admite una amplia gama de modelos de IA generativa, incluidos los modelos cuantificados y MoE.

- Rendimiento Innovador:

- Se requieren hasta 6 veces menos GPU.

- Hasta 10.7 veces más rendimiento.

- Hasta 6.2 veces menos latencia.

Aspectos Destacados

- Ejecución de Mixtral 8x7B Cuantificado en una Sola GPU: Friendli Inference puede ejecutar un modelo Mixtral-7x8B-instruct v0.1 cuantificado en una sola GPU NVIDIA A100 de 80 GB, logrando al menos 4.1 veces más rápido el tiempo de respuesta y entre 3.8x y 23.8x mayor rendimiento de tokens en comparación con un sistema vLLM de referencia.

- Llama 2 70B Cuantificado en una Sola GPU: Ejecute sin problemas LLM AWQ-ed, como Llama 2 70B de 4 bits, en una sola GPU A100 de 80 GB, lo que permite una implementación LLM eficiente y ganancias de eficiencia notables sin sacrificar la precisión.

- TTFT Aún Más Rápido con Friendli TCache: Friendli TCache optimiza el Time to First Token (TTFT) reutilizando los cálculos recurrentes, entregando un TTFT de 11.3x a 23x más rápido en comparación con vLLM.

Cómo Usar Friendli Inference

Friendli Inference ofrece tres formas de ejecutar modelos de IA generativa:

- Friendli Dedicated Endpoints: Cree y ejecute modelos de IA generativa en piloto automático.

- Friendli Container: Sirva inferencias LLM y LMM con Friendli Inference en su entorno privado.

- Friendli Serverless Endpoints: Llame a la API rápida y asequible para modelos de IA generativa de código abierto.

¿Por qué elegir Friendli Inference?

Friendli Inference es la solución ideal para las organizaciones que buscan optimizar el rendimiento y la rentabilidad de sus cargas de trabajo de inferencia LLM. Sus tecnologías innovadoras y su amplia gama de características lo convierten en una herramienta poderosa para implementar y escalar modelos de IA generativa.

¿Para quién es Friendli Inference?

Friendli Inference es adecuado para:

- Empresas que implementan modelos de lenguaje grandes.

- Investigadores que trabajan con IA generativa.

- Desarrolladores que construyen aplicaciones impulsadas por IA.

¿La mejor manera de optimizar la inferencia LLM?

La mejor manera de optimizar la inferencia LLM es usar Friendli Inference, que ofrece ahorros de costos significativos, alto rendimiento y baja latencia en comparación con otras soluciones.

Mejores herramientas alternativas a "Friendli Inference"

Xander es una plataforma de escritorio de código abierto que permite el entrenamiento de modelos de IA sin código. Describe tareas en lenguaje natural para pipelines automatizados en clasificación de texto, análisis de imágenes y ajuste fino de LLM, garantizando privacidad y rendimiento en tu máquina local.

Nebius es una plataforma de nube de IA diseñada para democratizar la infraestructura de IA, que ofrece una arquitectura flexible, rendimiento probado y valor a largo plazo con GPU NVIDIA y clústeres optimizados para el entrenamiento y la inferencia.

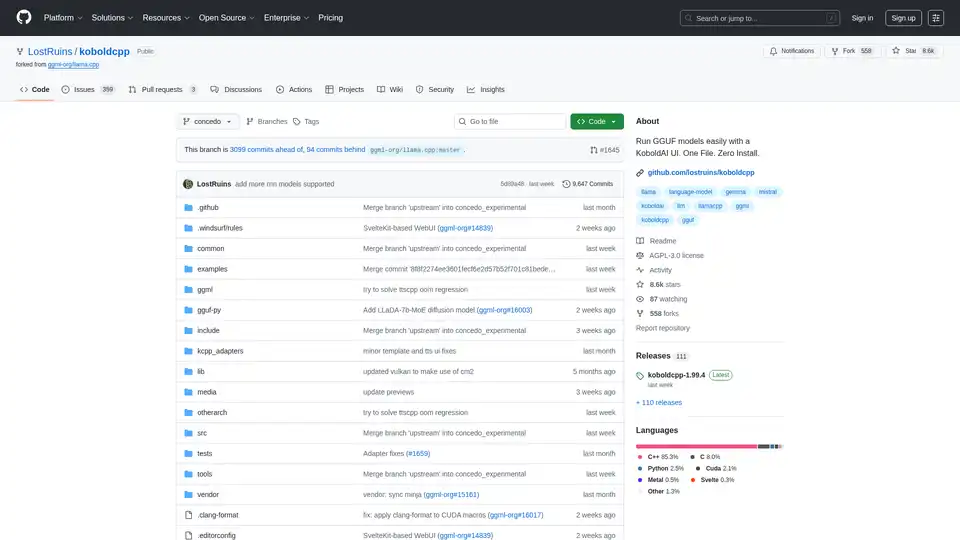

KoboldCpp: Ejecuta modelos GGUF fácilmente para generación de texto e imágenes con IA usando una interfaz de KoboldAI. Un solo archivo, sin instalación. Compatible con CPU/GPU, STT, TTS y Stable Diffusion.

Habilite la inferencia LLM eficiente con llama.cpp, una biblioteca C/C++ optimizada para diversos hardware, que admite cuantificación, CUDA y modelos GGUF. Ideal para implementación local y en la nube.

Vivgrid es una plataforma de infraestructura de agentes de IA que ayuda a los desarrolladores a construir, observar, evaluar e implementar agentes de IA con protecciones de seguridad e inferencia de baja latencia. Es compatible con GPT-5, Gemini 2.5 Pro y DeepSeek-V3.

Anyscale, impulsado por Ray, es una plataforma para ejecutar y escalar todas las cargas de trabajo de ML e IA en cualquier nube o entorno local. Construye, depura e implementa aplicaciones de IA con facilidad y eficiencia.

Conversed.ai proporciona un Estudio de Optimización de Agentes de IA que automatiza el servicio al cliente, RR.HH. y soporte de TI. Se integra con varias plataformas, garantizando un soporte 24/7 sin problemas y una mayor satisfacción del cliente.

Yellow.ai ofrece una plataforma de IA agentic de nivel empresarial que transforma CX y EX con agentes de IA capaces de conversaciones similares a las humanas. Admite la orquestación omnicanal, la optimización basada en análisis y la arquitectura multi-LLM.

Prompt Engine es una herramienta impulsada por IA que transforma ideas simples en indicaciones de nivel profesional para obtener resultados consistentemente de alta calidad de LLM como ChatGPT y Gemini, ahorrando tiempo y maximizando el valor de la IA.

Centrox AI: Servicios de desarrollo de Gen AI de ciclo completo, desde LLM personalizados hasta anotación de datos, impulsando la innovación de IA en todas las industrias.

SaasPedia es la agencia de SEO de IA de SaaS número 1 que ayuda a las empresas emergentes y empresas de IA B2B/B2C a dominar la búsqueda de IA. Optimizamos para AEO, GEO y LLM SEO para que su marca sea citada, recomendada y confiable por ChatGPT, Gemini y Google.

Tovie AI ofrece una plataforma de nivel empresarial para la orquestación de agentes de IA, búsqueda basada en LLM y consultoría de IA generativa. Agilice la adopción de la IA en los flujos de trabajo empresariales con soluciones escalables y seguras.

Translated.BEST ofrece traducción de documentos impulsada por IA en más de 80 idiomas, preservando el diseño original. Secure Local LLM garantiza la privacidad de los datos. ¡Traduce ahora!

Firecrawl es la API líder de rastreo, raspado y búsqueda web diseñada para aplicaciones de IA. Convierte sitios web en datos limpios, estructurados y listos para LLM a escala, impulsando agentes de IA con extracción web confiable sin proxies ni complicaciones.