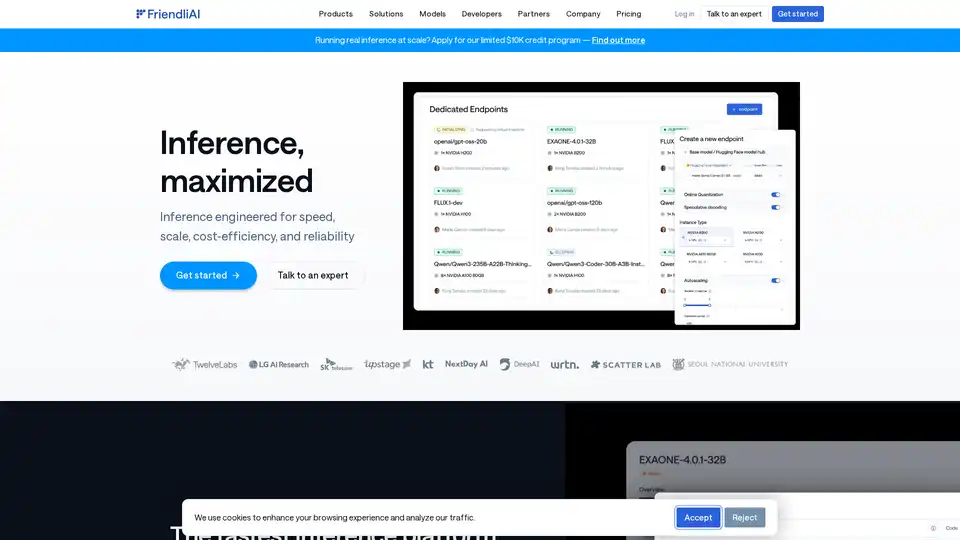

FriendliAI

Descripción general de FriendliAI

FriendliAI: La empresa de infraestructura de IA generativa

FriendliAI es una empresa especializada en infraestructura de IA generativa, que proporciona una plataforma diseñada para la velocidad, la escala, la rentabilidad y la fiabilidad en la inferencia de AI. Su objetivo es maximizar el rendimiento de los modelos de AI, ofreciendo soluciones para las empresas que buscan implementar AI a escala.

¿Qué es FriendliAI?

FriendliAI es una plataforma de inferencia diseñada para proporcionar una implementación de modelos de AI rápida y fiable. Destaca por ofrecer una pila creada específicamente que ofrece una inferencia 2 veces más rápida, combinando avances a nivel de modelo con optimizaciones a nivel de infraestructura.

¿Cómo funciona FriendliAI?

FriendliAI alcanza un alto rendimiento a través de varias características clave:

- Kernels de GPU personalizados: Optimiza la ejecución de modelos de AI en GPUs.

- Caché inteligente: Almacena y recupera eficientemente los datos utilizados con frecuencia.

- Batching continuo: Agrupa varias solicitudes para mejorar el rendimiento.

- Decodificación especulativa: Acelera la generación de texto prediciendo los siguientes tokens.

- Inferencia paralela: Distribuye la carga de trabajo entre múltiples GPUs.

- Caché avanzada: Mejora aún más los mecanismos de caché para un acceso a los datos más rápido.

- Escalado multi-nube: Permite el escalado a través de diferentes proveedores de nube para la flexibilidad y la redundancia.

Características y beneficios clave

- Alta velocidad: Reduce la latencia para proporcionar una ventaja competitiva.

- Fiabilidad garantizada: Ofrece SLAs de tiempo de actividad del 99,99% con infraestructura geo-distribuida.

- Rentabilidad: Logra importantes ahorros de costes al optimizar el uso de la GPU.

- Escalabilidad: Escala sin problemas a través de abundantes recursos de GPU.

- Facilidad de uso: Soporta la implementación con un solo clic para más de 459,400 modelos de Hugging Face.

- Soporte de modelos personalizados: Permite a los usuarios traer sus propios modelos afinados o patentados.

¿Por qué elegir FriendliAI?

- Rendimiento inigualable: Ofrece un alto rendimiento para el procesamiento de grandes volúmenes de datos.

- Latencia ultrabaja: Garantiza tiempos de respuesta rápidos para aplicaciones en tiempo real.

- Disponibilidad global: Proporciona un rendimiento fiable en todas las regiones globales.

- Tolerancia a fallos de grado empresarial: Asegura que la AI permanezca en línea y responda a través de picos de tráfico.

- Monitorización y cumplimiento incorporados: Ofrece herramientas de monitorización y una arquitectura lista para el cumplimiento.

¿Para quién es FriendliAI?

FriendliAI es adecuado para:

- Empresas que escalan aplicaciones de AI.

- Desarrolladores que implementan modelos de AI.

- Organizaciones que buscan una inferencia de AI rentable.

- Empresas que requieren un rendimiento de AI fiable.

¿Cómo usar FriendliAI?

Para empezar con FriendliAI:

- Regístrese: Cree una cuenta en la plataforma FriendliAI.

- Implemente un modelo: Elija entre más de 459,400 modelos de Hugging Face o traiga el suyo propio.

- Configure los ajustes: Ajuste los ajustes para el escalado y el rendimiento.

- Supervise el rendimiento: Utilice las herramientas de supervisión integradas para realizar un seguimiento del tiempo de actividad y la latencia.

Valor práctico y casos de uso

FriendliAI admite una amplia variedad de modelos, desde el lenguaje hasta el audio y la visión. Entre los modelos de ejemplo que se enumeran se incluyen:

- Llama-3.2-11B-Vision (Meta)

- whisper-small-wolof (M9and2M)

- Qwen2.5-VL-7B-Instruct-Android-Control (OfficerChul)

- Muchos más en diferentes modalidades

Estos modelos destacan la diversa aplicabilidad de la plataforma de FriendliAI en el manejo de varios tipos de tareas de AI.

Fiabilidad sólida y ahorro de costes

Los usuarios informan de importantes beneficios:

- APIs de modelos personalizados lanzadas en aproximadamente un día con monitorización integrada.

- Procesamiento de tokens escalado a billones utilizando un 50% menos de GPUs.

- El tráfico fluctuante se gestiona sin problemas gracias al autoescalado.

Conclusión

FriendliAI ofrece una solución integral para la inferencia de AI, centrándose en la velocidad, la fiabilidad y la rentabilidad. Su plataforma soporta una amplia gama de modelos y proporciona las herramientas necesarias para implementar la AI a escala, convirtiéndola en un valioso recurso para las empresas que buscan aprovechar las tecnologías de AI de forma eficaz.

Mejores herramientas alternativas a "FriendliAI"

Avian API ofrece la inferencia de IA más rápida para LLM de código abierto, alcanzando 351 TPS en DeepSeek R1. Implemente cualquier LLM de HuggingFace a una velocidad de 3 a 10 veces mayor con una API compatible con OpenAI. Rendimiento y privacidad de nivel empresarial.

Datature es una plataforma integral de IA de visión que acelera el etiquetado de datos, el entrenamiento de modelos y la implementación para empresas y desarrolladores. Construya conjuntos de datos listos para la producción 10 veces más rápido e integre a la perfección la inteligencia de visión.

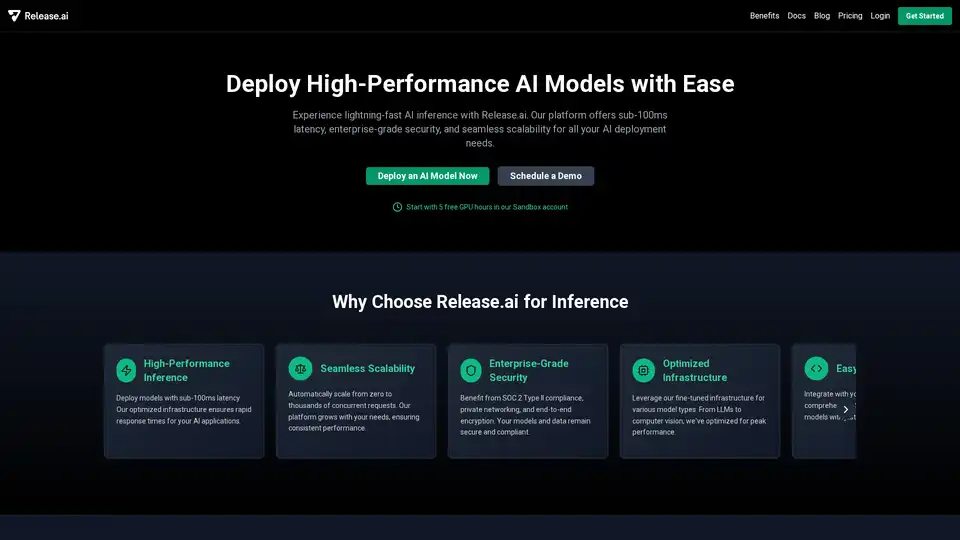

Release.ai simplifica la implementación de modelos de IA con una latencia inferior a 100 ms, seguridad de nivel empresarial y escalabilidad sin interrupciones. Implemente modelos de IA listos para producción en minutos.

UsageGuard ofrece una plataforma unificada de IA para acceso seguro a LLMs de OpenAI, Anthropic y más, con salvaguardas integradas, optimización de costos, monitoreo en tiempo real y seguridad de grado empresarial para agilizar el desarrollo de IA.

Runpod es una plataforma de nube de IA todo en uno que simplifica la creación e implementación de modelos de IA. Entrena, ajusta e implementa IA sin esfuerzo con una computación potente y escalado automático.

Predibase es una plataforma de desarrolladores para ajustar y servir LLM de código abierto. Logre una precisión y velocidad inigualables con la infraestructura de entrenamiento y servicio de extremo a extremo, que incluye el ajuste fino de refuerzo.

LandingAI es una plataforma de IA visual que transforma la visión artificial con IA avanzada y aprendizaje profundo. Automatice el procesamiento de documentos y cree modelos de visión artificial con LandingLens.

Simplifique la implementación de IA con Synexa. Ejecute potentes modelos de IA al instante con solo una línea de código. Plataforma API de IA sin servidor rápida, estable y fácil de usar para desarrolladores.

XenonStack es un data foundry para construir sistemas agentic para procesos de negocio y agentes de IA autónomos.

Modal: Plataforma sin servidor para equipos de IA y datos. Ejecute cómputo intensivo de CPU, GPU y datos a escala con su propio código.

Batteries Included es una plataforma de IA autoalojada que simplifica la implementación de LLM, bases de datos vectoriales y Jupyter notebooks. Construye aplicaciones de IA de clase mundial en tu infraestructura.

Lightning AI es un espacio de trabajo en la nube todo en uno diseñado para crear, implementar y entrenar agentes de IA, datos y aplicaciones de IA. Obtenga API de modelos, entrenamiento de GPU e implementación multi-nube en una sola suscripción.

Meteron AI es un conjunto de herramientas de IA todo en uno que gestiona la medición, el equilibrio de carga y el almacenamiento de LLM y la IA generativa, lo que permite a los desarrolladores centrarse en la creación de productos impulsados por la IA.

Anyscale, impulsado por Ray, es una plataforma para ejecutar y escalar todas las cargas de trabajo de ML e IA en cualquier nube o entorno local. Construye, depura e implementa aplicaciones de IA con facilidad y eficiencia.