huntr

Descripción general de huntr

huntr: La Plataforma de Bug Bounty para la Seguridad de AI/ML

¿Qué es huntr?

Huntr es la primera plataforma de bug bounty del mundo diseñada específicamente para proyectos de AI y Machine Learning (ML). Sirve como un centro central donde los investigadores de seguridad pueden reportar vulnerabilidades en aplicaciones, librerías y formatos de archivos de modelos de código abierto de AI/ML, ayudando a reforzar la seguridad y la estabilidad de estos componentes críticos. Al proporcionar un entorno estructurado e incentivado para la divulgación de vulnerabilidades, huntr desempeña un papel vital en el creciente campo de la seguridad de la AI.

¿Cómo funciona huntr?

Huntr facilita un proceso optimizado para el reporte y la resolución de vulnerabilidades:

- Divulgación: Los investigadores de seguridad identifican y envían vulnerabilidades a través de un formulario seguro en la plataforma de huntr.

- Validación: El equipo de huntr se pone en contacto con el mantenedor del proyecto afectado y le da 31 días para responder al reporte. Si no se recibe respuesta, huntr resuelve manualmente los reportes de alta y crítica gravedad en un plazo de 14 días.

- Recompensa: Si el reporte es validado por el mantenedor o por huntr, el investigador recibe una recompensa como premio por su contribución.

- Publicación: Para los proyectos de código abierto, los reportes de vulnerabilidades se hacen públicos después de 90 días, lo que permite a los mantenedores tiempo para abordar el problema. Los mantenedores pueden solicitar extensiones si es necesario. Los reportes sobre formatos de archivos de modelos no se divulgan públicamente.

¿Por qué es importante huntr?

A medida que la AI y el ML se integran cada vez más en varios aspectos de nuestras vidas, la necesidad de garantizar la seguridad de estos sistemas es primordial. Huntr aborda esta necesidad al:

- Incentivar el descubrimiento de vulnerabilidades: Al ofrecer recompensas, huntr anima a los investigadores de seguridad a buscar y reportar activamente vulnerabilidades en los proyectos de AI/ML.

- Facilitar la colaboración: Huntr proporciona una plataforma para que investigadores y mantenedores colaboren en la resolución de problemas de seguridad.

- Mejorar la seguridad de AI/ML: Al identificar y resolver vulnerabilidades, huntr contribuye a la seguridad y estabilidad general de los sistemas de AI/ML.

¿Para quién es huntr?

Huntr es valioso para una variedad de partes interesadas:

- Investigadores de seguridad: Una plataforma para reportar vulnerabilidades y ganar recompensas, contribuyendo a la seguridad de los proyectos de AI/ML.

- Mantenedores de proyectos de AI/ML: Una forma de identificar y abordar proactivamente los problemas de seguridad en sus proyectos.

- Organizaciones que utilizan AI/ML: Mayor confianza en la seguridad de los componentes de AI/ML en los que confían.

Proyectos de AI/ML Soportados:

Huntr soporta más de 240 programas de AI/ML, incluyendo proyectos populares como:

- NVIDIA/nvidia-container-toolkit

- apache/spark

- huggingface/text-generation-inference

- intel/neural-compressor

- mongodb/mongo-python-driver

- huggingface/transformers

- pytorch/pytorch

- scikit-learn/scikit-learn

- keras-team/keras

- apache/airflow

- numpy/numpy

- microsoft/LightGBM

- onnx/onnx

- jupyter/jupyter

- mlflow/mlflow

- aws/aws-cli

- nltk/nltk

- kubeflow/kubeflow

- apache/arrow

- apache/tvm

- microsoft/onnxruntime

- deepmind/sonnet

- NVIDIA/TensorRT

- triton-inference-server/server

- huggingface/tokenizers

- Netflix/metaflow

- elastic/elasticsearch-py

- pytorch/serve

- h5py/h5py

- aimhubio/aim

- joblib/joblib

- scikit-optimize/scikit-optimize

- keras-team/keras-tuner

- aws/sagemaker-python-sdk

- run-llama/llama_index

- facebookresearch/faiss

- facebookresearch/fairseq

- deepjavalibrary/djl

- microsoft/autogen

- microsoft/promptbench

- ollama/ollama

- huggingface/smolagents

Estos proyectos cubren una amplia gama de aplicaciones de AI/ML, destacando el enfoque integral de huntr para la seguridad de la AI.

Características clave

- Plataforma de Bug Bounty para proyectos de AI/ML

- Proceso seguro de divulgación de vulnerabilidades

- Sistema de recompensas incentivado para investigadores

- Colaboración entre investigadores y mantenedores

- Reportes públicos de vulnerabilidades para proyectos de código abierto

Huntr está apoyado por Protect AI y está liderando el camino hacia MLSecOps y una mayor seguridad de la AI.

¿La mejor manera de asegurar tus proyectos de AI/ML? Únete a huntr hoy y contribuye a un ecosistema de AI más seguro.

Mejores herramientas alternativas a "huntr"

Moderniza tus aplicaciones legacy en semanas con el proceso de 4 pasos impulsado por IA de iBEAM. Aumenta el rendimiento, reduce costos, mejora la seguridad y asegura escalabilidad con transformación de apps liderada por expertos.

Pervaziv AI proporciona seguridad de software impulsada por IA generativa para entornos multi-nube, escaneando, remediando, construyendo e implementando aplicaciones de forma segura. Flujos de trabajo DevSecOps más rápidos y seguros en Azure, Google Cloud y AWS.

Eleve la calidad de su software con los servicios de ingeniería de calidad impulsados por IA de BugRaptors. Benefíciese de las pruebas manuales aumentadas por IA, la automatización impulsada por IA y las pruebas de seguridad de IA.

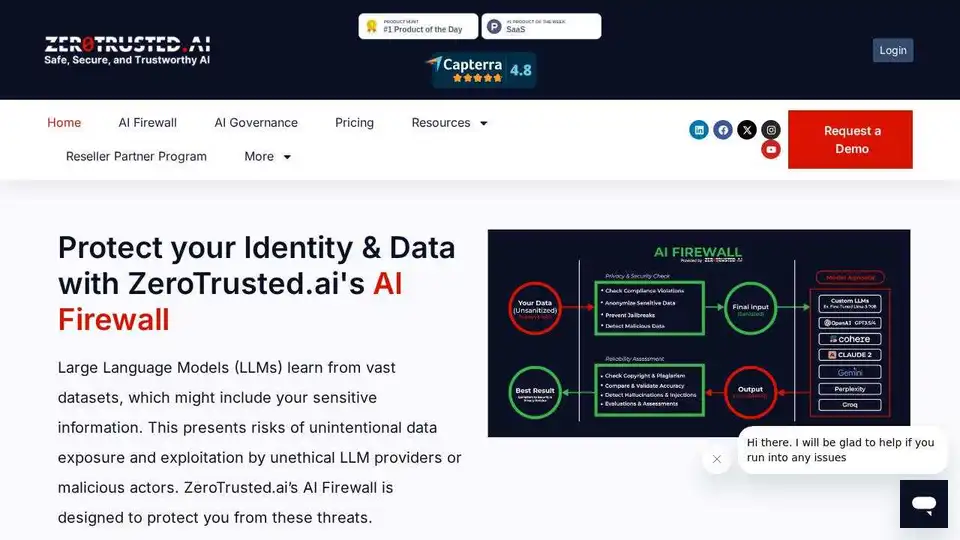

ZeroTrusted.ai ofrece un firewall de IA, una puerta de enlace de IA y una verificación de estado de IA para proteger su ecosistema de IA. Descubra y bloquee herramientas de IA no autorizadas, garantice la seguridad de los datos y mantenga el cumplimiento.

AquilaX Security es una plataforma DevSecOps impulsada por IA que automatiza el escaneo de seguridad, reduce los falsos positivos y ayuda a los desarrolladores a enviar código seguro más rápido. Integra escáneres SAST, SCA, de contenedores, IaC, secretos y malware.

nbot.ai es un curador de contenido impulsado por IA que crea feeds personalizados de fuentes web, resume insights, filtra ruido y permite refinamiento por chat en tiempo real para cualquier nicho.

Amazon Q Developer es un asistente de IA generativa en AWS para el desarrollo de software, que ofrece funciones como la implementación de código, las pruebas y la refactorización para acelerar el ciclo de vida del desarrollo.

WhyLabs ofrece observabilidad de la IA, seguridad LLM y monitorización de modelos. Proteja las aplicaciones de IA generativa en tiempo real para mitigar los riesgos.

Snowflake AI Data Cloud es una plataforma totalmente gestionada que simplifica los datos empresariales y la IA. Permite a las empresas crear, implementar y escalar aplicaciones de IA con seguridad y gobernanza unificadas en todas las nubes.

Monitorea, analiza y protege agentes de IA, LLM y modelos ML con Fiddler AI. Obtén visibilidad e información práctica con la plataforma unificada de observabilidad de IA de Fiddler.

zMaticoo es la principal plataforma de monetización móvil en APAC, que aprovecha IA/ML para publicidad programática. Conecta más de 8,000 apps, 1,500 anunciantes y 1.33 mil millones de usuarios únicos para impulsar ingresos y crecimiento global.

BasicAI ofrece una plataforma líder de anotación de datos y servicios de etiquetado profesional para modelos de IA/ML, confiable por miles en aplicaciones de AV, ADAS y Smart City. Con más de 7 años de experiencia, garantiza soluciones de datos de alta calidad y eficiencia.

Rev AI ofrece la API de texto hablado más precisa del mundo con opciones de transcripción asíncrona, en streaming y humana, más insights como análisis de sentimientos y resúmenes. Soporta 58+ idiomas con alta precisión y seguridad.

Athina es una plataforma colaborativa de IA que ayuda a los equipos a construir, probar y monitorear funciones basadas en LLM 10 veces más rápido. Con herramientas para gestión de prompts, evaluaciones y observabilidad, garantiza la privacidad de datos y soporta modelos personalizados.