LMQL

Descripción general de LMQL

¿Qué es LMQL?

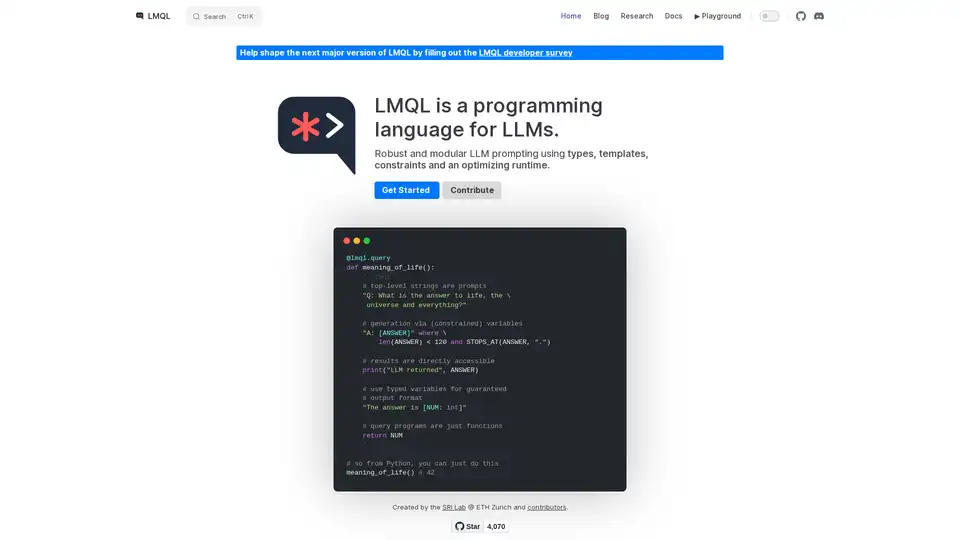

LMQL (Language Model Query Language) es un lenguaje de programación diseñado específicamente para interactuar con Modelos de Lenguaje Grandes (LLMs). Proporciona un enfoque robusto y modular para el prompting de LLMs, aprovechando tipos, plantillas, restricciones y un tiempo de ejecución de optimización para garantizar resultados confiables y controlables. LMQL tiene como objetivo cerrar la brecha entre los paradigmas de programación tradicionales y la naturaleza probabilística de los LLMs, lo que permite a los desarrolladores crear aplicaciones de AI más sofisticadas y predecibles.

¿Cómo funciona LMQL?

LMQL opera permitiendo a los desarrolladores definir prompts como código, incorporando variables, restricciones y flujo de control. Este enfoque contrasta con el prompting tradicional basado en cadenas, que puede ser menos estructurado y más difícil de administrar. Aquí hay un desglose de las características clave de LMQL:

- Variables Tipadas: LMQL le permite definir variables con tipos de datos específicos (por ejemplo,

int,str), lo que garantiza que la salida del LLM se ajuste al formato esperado. Esta característica es crucial para crear aplicaciones que requieran datos estructurados. - Plantillas: LMQL admite plantillas, lo que permite la creación de componentes de prompt reutilizables. Las plantillas se pueden parametrizar con variables, lo que facilita la generación de prompts dinámicos.

- Restricciones: LMQL le permite especificar restricciones en la salida del LLM, como la longitud máxima o palabras clave específicas. Estas restricciones son impuestas por el tiempo de ejecución de LMQL, lo que garantiza que la respuesta del LLM cumpla con sus requisitos.

- Consultas Anidadas: LMQL admite consultas anidadas, lo que le permite modularizar sus prompts y reutilizar componentes de prompt. Esta característica es particularmente útil para tareas complejas que requieren múltiples pasos de interacción con el LLM.

- Múltiples Backends: LMQL puede hacer que su código LLM sea automáticamente portátil a través de varios backends. Puede cambiar entre ellos con una sola línea de código.

Ejemplo

@lmql.query

def meaning_of_life():

'''lmql

# top-level strings are prompts

"Q: What is the answer to life, the \

universe and everything?"

# generation via (constrained) variables

"A: [ANSWER]" where \

len(ANSWER) < 120 and STOPS_AT(ANSWER, ".")

# results are directly accessible

print("LLM returned", ANSWER)

# use typed variables for guaranteed

# output format

"The answer is [NUM: int]"

# query programs are just functions

return NUM

'''

## so from Python, you can just do this

meaning_of_life() # 42

¿Cómo usar LMQL?

Instalación:

Instale LMQL usando pip:

pip install lmqlDefinir Consultas:

Escriba consultas LMQL usando el decorador

@lmql.query. Estas consultas pueden incluir prompts, variables y restricciones.Ejecutar Consultas:

Ejecute consultas LMQL como funciones regulares de Python. El tiempo de ejecución de LMQL manejará la interacción con el LLM y aplicará las restricciones especificadas.

Acceder a los Resultados:

Acceda a la salida del LLM a través de las variables definidas en su consulta LMQL.

¿Por qué elegir LMQL?

- Robustez: Los tipos y restricciones de LMQL ayudan a garantizar que la salida del LLM sea confiable y consistente.

- Modularidad: Las plantillas y las consultas anidadas de LMQL promueven la reutilización de código y la modularidad.

- Portabilidad: LMQL funciona en múltiples backends de LLM, lo que le permite cambiar fácilmente entre diferentes modelos.

- Expresividad: La integración de LMQL con Python le permite aprovechar toda la potencia de Python para la construcción de prompts y el post-procesamiento.

¿Para quién es LMQL?

LMQL es adecuado para desarrolladores que desean crear aplicaciones de AI que requieran un control preciso sobre el comportamiento del LLM. Es particularmente útil para tareas como:

- Extracción de datos: Extracción de datos estructurados del texto.

- Generación de código: Generación de código basado en descripciones en lenguaje natural.

- Chatbots: Creación de chatbots con respuestas predecibles y consistentes.

- Respuesta a preguntas: Responder preguntas basadas en conocimiento estructurado.

Al usar LMQL, los desarrolladores pueden crear aplicaciones de AI más confiables, modulares y portátiles que aprovechen el poder de los LLMs.

La mejor manera de usar LMQL es consultar la documentación y comenzar con un ejemplo simple, luego aumentar gradualmente la complejidad de los prompts para que se adapten a sus necesidades.

Etiquetas Relacionadas con LMQL