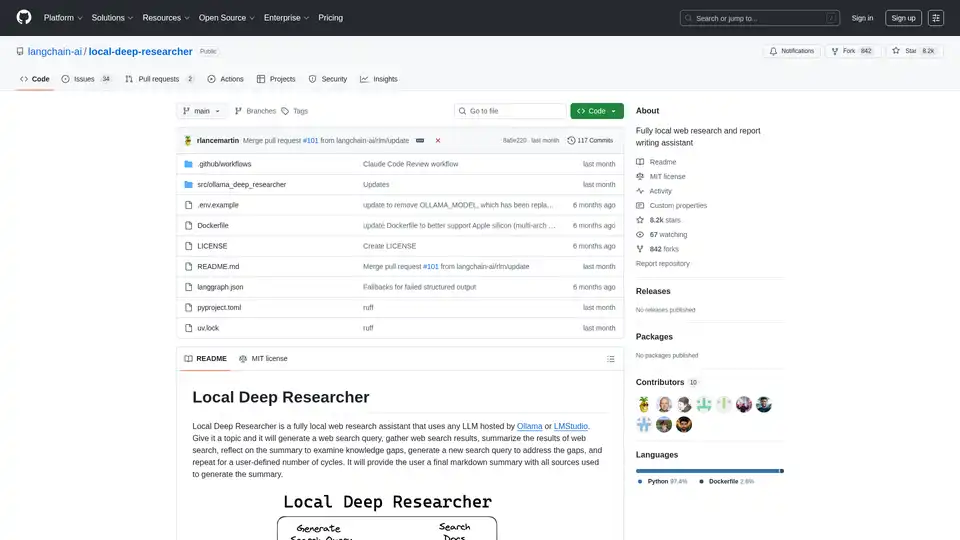

Local Deep Researcher

Descripción general de Local Deep Researcher

¿Qué es Local Deep Researcher?

Local Deep Researcher es un innovador asistente de investigación web de código abierto diseñado para operar completamente de forma local en tu máquina. Esta potente herramienta aprovecha los grandes modelos de lenguaje (LLMs) a través de Ollama o LMStudio para realizar investigaciones web exhaustivas y generar informes detallados con las citas de fuentes adecuadas.

¿Cómo funciona Local Deep Researcher?

El sistema sigue un proceso de investigación iterativo inteligente:

Proceso de ciclo de investigación:

- Generación de consultas: Dado un tema proporcionado por el usuario, el LLM local genera una consulta de búsqueda web optimizada

- Recuperación de fuentes: Utiliza herramientas de búsqueda configuradas (DuckDuckGo, SearXNG, Tavily o Perplexity) para encontrar fuentes en línea relevantes

- Resumen de contenido: El LLM analiza y resume los hallazgos de los resultados de búsqueda web

- Análisis de brechas: El sistema reflexiona sobre el resumen para identificar brechas de conocimiento e información faltante

- Refinamiento iterativo: Genera nuevas consultas de búsqueda para abordar las brechas identificadas y repite el proceso

- Generación de informe final: Después de múltiples ciclos (configurables por el usuario), produce un informe completo en formato markdown con todas las fuentes debidamente citadas

Características y capacidades principales

- Operación completamente local: Todo el procesamiento ocurre localmente, garantizando privacidad y seguridad de datos

- Soporte múltiple de LLMs: Compatible con cualquier LLM alojado a través de Ollama o LMStudio

- Integración flexible de búsqueda: Soporta APIs de búsqueda de DuckDuckGo (predeterminado), SearXNG, Tavily y Perplexity

- Profundidad de investigación configurable: Los usuarios pueden establecer el número de ciclos de investigación (predeterminado: 3 iteraciones)

- Salida estructurada: Genera informes en formato markdown bien estructurados con citas de fuentes adecuadas

- Monitoreo visual del flujo de trabajo: Integrado con LangGraph Studio para visualización en tiempo real del proceso

Requisitos técnicos y configuración

Plataformas soportadas:

- macOS (recomendado)

- Windows

- Linux mediante Docker

Componentes requeridos:

- Python 3.11+

- Ollama o LMStudio para alojamiento local de LLMs

- Claves API opcionales para servicios de búsqueda premium

Instalación y configuración

Proceso de configuración rápida:

- Clona el repositorio desde GitHub

- Configura las variables de entorno en el archivo .env

- Selecciona tu proveedor de LLM preferido (Ollama o LMStudio)

- Elige la configuración de API de búsqueda

- Inicia a través de LangGraph Studio

Implementación con Docker: El proyecto incluye soporte Docker para implementación en contenedores, aunque Ollama debe ejecutarse por separado con la configuración de red adecuada.

Consideraciones de compatibilidad de modelos

El sistema requiere LLMs capaces de producir salida JSON estructurada. Algunos modelos como DeepSeek R1 (7B y 1.5B) pueden tener limitaciones con el modo JSON, pero el asistente incluye mecanismos de respaldo para manejar estos casos.

¿Quién debería usar Local Deep Researcher?

Usuarios ideales incluyen:

- Investigadores y académicos que necesitan revisiones de literatura exhaustivas

- Creadores de contenido que requieren información de fondo bien investigada

- Estudiantes que trabajan en documentos de investigación y tareas

- Periodistas que realizan investigación investigativa

- Profesionales de negocios que necesitan investigación de mercado y análisis competitivo

- Usuarios conscientes de la privacidad que prefieren procesamiento local sobre soluciones basadas en la nube

Aplicaciones prácticas y casos de uso

- Investigación académica: Realizar revisiones de literatura y recopilar fuentes para artículos

- Análisis de mercado: Investigar competidores y tendencias de la industria

- Investigación de contenido: Recopilar información para publicaciones de blog, artículos e informes

- Debida diligencia: Investigar temas a fondo con documentación adecuada de fuentes

- Aprendizaje y educación: Explorar temas en profundidad con asistencia de investigación automatizada

¿Por qué elegir Local Deep Researcher?

Ventajas clave:

- Privacidad completa: Tus temas de investigación y datos nunca salen de tu máquina local

- Rentable: Sin costos de API para funcionalidad básica de búsqueda

- Personalizable: Ajusta la profundidad de investigación y fuentes según tus necesidades específicas

- Transparente: Visibilidad completa del proceso de investigación y fuentes utilizadas

- Código abierto: Desarrollo impulsado por la comunidad y mejoras continuas

Obteniendo los mejores resultados

Para un rendimiento óptimo:

- Utiliza modelos LLM más grandes y capaces cuando sea posible

- Configura APIs de búsqueda apropiadas para tus necesidades específicas

- Ajusta el número de ciclos de investigación según la complejidad del tema

- Revisa y verifica manualmente fuentes importantes para investigación crítica

Local Deep Researcher representa un avance significativo en herramientas de investigación local con IA, combinando el poder de los grandes modelos de lenguaje con capacidades prácticas de investigación web mientras mantiene privacidad y control completo de datos.

Mejores herramientas alternativas a "Local Deep Researcher"

GPT Researcher es un asistente de investigación de IA de código abierto que automatiza la investigación en profundidad. Recopila información de fuentes confiables, agrega resultados y genera informes completos rápidamente. Ideal para personas y equipos que buscan información imparcial.

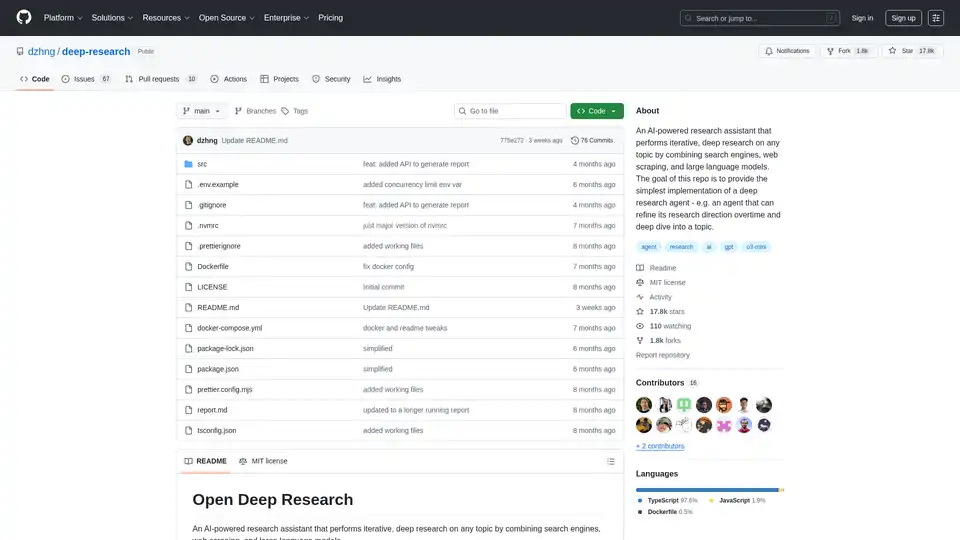

Deep Research es un asistente de investigación impulsado por IA que combina motores de búsqueda, web scraping y LLM para una investigación iterativa y en profundidad sobre cualquier tema. Simplifica las inmersiones profundas con generación de consultas inteligente e informes completos.

¡Transforma tu flujo de trabajo con BrainSoup! Crea agentes de IA personalizados para manejar tareas y automatizar procesos a través del lenguaje natural. Mejora la IA con tus datos mientras priorizas la privacidad y la seguridad.

Chatea con IA usando tus claves API. Paga solo por lo que uses. Soporta GPT-4, Gemini, Claude y otros LLMs. La mejor interfaz de chat frontend LLM para todos los modelos de IA.

Learnitive Notepad es una app de toma de notas todo en uno con IA para crear notas Markdown, códigos, fotos, páginas web y más. Aumenta la productividad con 50GB de almacenamiento, asistencia IA ilimitada y soporte multiplataforma.

Transforma tus interacciones con IA con Promptly AI. Crea mejores prompts, accede a nuestra biblioteca curada y exporta conversaciones entre ChatGPT, Claude, Perplexity, Gemini y Deepseek.

Descubre Mindpool, la plataforma definitiva para consultar múltiples modelos de IA líderes como ChatGPT y Gemini con un solo prompt, compara salidas para obtener insights precisos y potenciar tu investigación, creatividad y marketing de forma segura.

El Escritor de Blog AI de Bloggr.AI te ayuda a generar publicaciones de blog optimizadas para SEO y libres de plagio rápidamente—gratuito con voz de marca, esquemas e inserción de enlaces.

Carga archivos CSV y analízalos en una interfaz visual paso a paso. Limpia, extrae, resume o realiza análisis de sentimientos con tu agente AI personal.

Nightwatch es una herramienta de monitoreo SEO impulsada por IA que ofrece un seguimiento preciso del ranking, auditoría del sitio y generación de informes. Rastrea palabras clave, monitorea la visibilidad en las búsquedas y optimiza tu sitio web para obtener un mejor posicionamiento.

SmythOS es un sistema operativo de código abierto para la era de la IA, que permite una implementación rápida, confiable y auditable de flujos de trabajo complejos de agentes de IA. Construye, depura e implementa agentes de IA con facilidad.

Acuration IQ es un decodificador de mercado impulsado por IA que transforma datos complejos en información útil para sinergias B2B, investigación de mercado y toma de decisiones basada en datos.

Onpage.ai es una extensión gratuita de Chrome impulsada por IA para el análisis SEO y la creación de contenido. Analice el SEO en la página, investigue palabras clave y optimice el contenido con preguntas de PAA.

UpGrow es un servicio de crecimiento de Instagram impulsado por IA para 2025, que ofrece seguidores reales y crecimiento orgánico a través de la automatización. Obtén resultados garantizados o te devolvemos tu dinero.