NativeMind

Descripción general de NativeMind

¿Qué es NativeMind?

NativeMind es una innovadora extensión de código abierto para el navegador Chrome que sirve como una alternativa totalmente offline a ChatGPT. Impulsada exclusivamente por modelos de lenguaje grandes (LLM) locales como Ollama, garantiza la privacidad de los datos al 100% manteniendo todo el procesamiento en tu dispositivo: sin servidores en la nube, sin transmisión de datos y sin seguimiento. Lanzada como una herramienta gratuita para uso personal, NativeMind se integra a la perfección en tu flujo de trabajo de navegación, ofreciendo capacidades de IA como chat inteligente, agentes autónomos, análisis de contenido y más, todo ello manteniendo un control absoluto sobre tu información.

En una era en la que las filtraciones de datos y las preocupaciones por la privacidad dominan los titulares, NativeMind destaca por aprovechar el poder de los modelos de código abierto como gpt-oss, DeepSeek, Qwen, Llama, Gemma y Mistral. Los usuarios pueden cambiar de modelo al instante sin configuraciones complejas, lo que lo hace ideal para aquellos que buscan alternativas offline a ChatGPT que prioricen la seguridad y la velocidad.

Características clave de NativeMind

NativeMind incluye un conjunto de funciones potentes y centradas en la privacidad, diseñadas para la productividad diaria:

- Chat contextual en todas las pestañas: Añade pestañas abiertas del navegador a las conversaciones para obtener resúmenes y preguntas que abarquen varios sitios. Perfecto para la investigación o la multitarea sin comprometer la privacidad.

- Chatea con archivos PDF, imágenes y capturas de pantalla: Sube archivos locales para su análisis, exploración o investigación, todo procesado localmente.

- Modo Agente: Un agente autónomo gestiona tareas de varios pasos utilizando herramientas en el dispositivo como la búsqueda web local o el análisis de archivos.

- Búsqueda web local: Consulta cualquier cosa dentro de tu navegador; no se necesitan APIs externas.

- Asistente de Gmail: Resume correos electrónicos y redacta respuestas más rápido, todo en el dispositivo.

- Herramientas de escritura: Refina, reescribe y genera ideas de texto en cualquier lugar como tu asistente de escritura privado.

- Traducción inmersiva: Traduce páginas web completas al instante preservando el diseño y la privacidad.

- API en el navegador: API ligera para que los desarrolladores integren LLM locales en aplicaciones web sin servidores.

Estas características hacen de NativeMind no solo un chatbot, sino una extensión de navegador de IA privada versátil que mejora los flujos de trabajo en la escritura, la investigación y la automatización.

¿Cómo funciona NativeMind?

NativeMind se conecta directamente a Ollama, un marco de trabajo popular para ejecutar LLM localmente en tu máquina. Aquí tienes un desglose paso a paso:

- Instala la extensión: Añádela desde la Chrome Web Store: gratis, sin necesidad de registrarse.

- Configura Ollama: Ejecuta Ollama en tu dispositivo (compatible con CPU/GPU para un rendimiento óptimo) y carga tus modelos preferidos.

- Integración perfecta: La extensión detecta Ollama automáticamente, lo que permite el cambio instantáneo de modelo y la ejecución de indicaciones.

- Procesamiento en el dispositivo: Toda la inferencia de la IA se realiza localmente. Las indicaciones, el contexto de las pestañas/archivos y las respuestas nunca salen de tu navegador o máquina.

Los requisitos mínimos de hardware incluyen una CPU moderna; la aceleración de la GPU es opcional pero recomendada para modelos más grandes. Es compatible con los principales navegadores a través de la compatibilidad con Chrome.

Para los desarrolladores, la API en el navegador simplifica la incrustación de respuestas LLM locales en aplicaciones web: NativeMind.prompt('your query') devuelve resultados sin SDKs ni servidores backend.

¿Por qué elegir NativeMind en lugar de herramientas de IA basadas en la nube?

Las herramientas tradicionales como ChatGPT se basan en servidores en la nube, exponiendo tus datos a posibles fugas, registros y acceso de terceros. NativeMind cambia el guion:

- Privacidad absoluta: Sin sincronización, sin registros, sin fugas: tus datos son tuyos.

- Fiabilidad sin conexión: Funciona sin internet, ideal para entornos seguros o viajes.

- Gratis para uso personal: 100% gratis; opciones empresariales próximamente.

- Transparencia de código abierto: Audita el código en GitHub, contribuye o personaliza.

- Velocidad lista para la empresa: Optimizado para tareas del mundo real con inferencia local rápida.

En las pruebas de referencia, los modelos locales a través de Ollama rivalizan con el rendimiento de la nube en hardware capaz, especialmente para tareas sensibles a la privacidad como la investigación legal o la escritura confidencial.

¿Para quién es NativeMind?

- Usuarios preocupados por la privacidad: Periodistas, abogados o cualquier persona que maneje datos confidenciales.

- Escritores e investigadores: ¿Necesitas resumen, reescritura o análisis de PDF en el dispositivo?

- Desarrolladores: Integra la IA local en aplicaciones sin bloqueo de proveedores.

- Entusiastas de la productividad: Redactores de Gmail, navegadores multilingües o buscadores de automatización.

- Trabajadores sin conexión: Profesionales remotos o aquellos en áreas de baja conectividad.

Es particularmente valioso para los usuarios de extensiones de navegador LLM locales que hacen la transición desde las dependencias de la nube.

Cómo usar NativeMind: Mejores prácticas

- Primeros pasos: Instala desde Chrome Web Store, asegúrate de que Ollama se ejecuta localmente y fija la extensión.

- Flujo de trabajo diario: Haz clic con el botón derecho en las pestañas para añadir contexto, sube archivos a través de la ventana emergente o activa el modo agente para consultas complejas.

- Optimización del modelo: Empieza con modelos ligeros como Gemma para la velocidad; actualiza a Llama para la profundidad.

- Solución de problemas: Comprueba el estado de Ollama; las preguntas frecuentes confirman que no se envían datos a la nube y que la capacidad offline es total.

Escenarios de usuarios reales: Un profesional del marketing lo utiliza para redacción privada de correos electrónicos, un estudiante analiza archivos PDF de investigación offline o un desarrollador crea prototipos de funciones de IA localmente.

Valor práctico y casos de uso

NativeMind democratiza la IA eliminando las barreras de la nube. En la educación, ayuda a la traducción de IA para el aprendizaje de idiomas sin riesgos para los datos. Las empresas lo aprovechan para la asistencia de escritura de IA segura en propuestas. Con la creciente adopción de la IA en el borde (que se prevé que aumente un 40% para 2025 según los informes de la industria), herramientas como NativeMind lideran el cambio hacia la IA soberana.

Los comentarios de los clientes destacan su velocidad y fiabilidad: "Por fin, un ChatGPT privado que simplemente funciona", se repite en las estrellas de GitHub. Para las empresas, el acceso a la lista de espera promete soluciones escaladas.

En resumen, NativeMind redefine los asistentes de IA offline con una privacidad, versatilidad y facilidad incomparables. Instálalo hoy mismo y experimenta la IA en tus términos: tus datos, tu control, cero nube.

Mejores herramientas alternativas a "NativeMind"

Worthify.ai proporciona análisis binario impulsado por IA para la detección de vulnerabilidades y el análisis de malware, integrándose con los flujos de trabajo de seguridad existentes. Mejore su ciberseguridad con la ingeniería inversa impulsada por IA.

AI Runner es un motor de inferencia de IA sin conexión para arte, conversaciones de voz en tiempo real, chatbots impulsados por LLM y flujos de trabajo automatizados. ¡Ejecute la generación de imágenes, el chat de voz y más localmente!

On-Device AI: Transforma voz a texto, texto a voz natural y chatea con LLM sin conexión y de forma segura en tu iPhone, iPad y Mac. ¡Privado y poderoso!

Enclave AI es un asistente de IA centrado en la privacidad para iOS y macOS que se ejecuta completamente sin conexión. Ofrece procesamiento local de LLM, conversaciones seguras, chat de voz e interacción con documentos sin necesidad de una conexión a Internet.

ProxyAI es un asistente de código impulsado por IA para IDE de JetBrains, que ofrece finalización de código, edición en lenguaje natural y soporte offline con LLM locales. Mejora tu codificación con IA.

Experimente conversaciones seguras de IA con Sanctum, impulsado por modelos de código abierto encriptados localmente en su dispositivo. Ejecute LLM con todas las funciones en segundos con total privacidad.

Private LLM es un chatbot de IA local para iOS y macOS que funciona sin conexión, manteniendo su información completamente en el dispositivo, segura y privada. Disfrute de un chat sin censura en su iPhone, iPad y Mac.

Dot es una herramienta de chat de IA local y fuera de línea impulsada por Mistral 7B, que le permite chatear con documentos sin enviar sus datos. Gratuito y centrado en la privacidad.

RecurseChat: Una aplicación de IA personal que te permite hablar con IA local, sin conexión y chatear con archivos PDF y markdown.

Muah AI es una plataforma de compañeros de IA para mayores de 18 años que ofrece interacciones LLM sin censura, intercambio de fotos y llamadas telefónicas en tiempo real. Personaliza el personaje de IA de tus sueños con posibilidades ilimitadas y absoluta privacidad.

Sagify es una herramienta Python de código abierto que simplifica los pipelines de ML en AWS SageMaker, con una Gateway LLM unificada para integrar modelos de lenguaje grandes propietarios y de código abierto sin problemas.

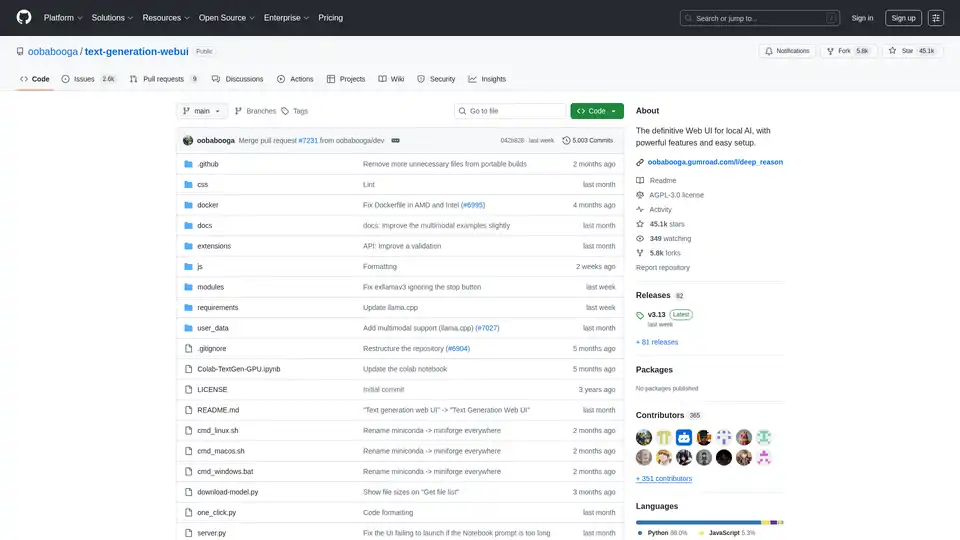

Text Generation Web UI es una interfaz web Gradio potente y fácil de usar para modelos de lenguaje grandes de IA local. Admite múltiples backends, extensiones y ofrece privacidad sin conexión.

Znote potencia los archivos Markdown con asistencia de IA y ejecución de código. Edita localmente, chatea con IA y ejecuta fragmentos de código JavaScript. Ideal para estudiantes, desarrolladores y creadores.

ProxyAI es un copiloto de IA para IDE de JetBrains que ofrece funciones como finalización de código, edición en lenguaje natural e integración con LLM líderes. Admite el desarrollo sin conexión y varios modelos a través de claves API.