AnimateDiff

Vue d'ensemble de AnimateDiff

Qu'est-ce qu'AnimateDiff ?

AnimateDiff est un outil innovant d'IA qui transforme des images statiques ou des invites de texte en vidéos animées dynamiques en générant des séquences fluides de cadres. Construit sur la base de Stable Diffusion, il intègre des modules de mouvement spécialisés pour prédire et appliquer des mouvements réalistes, en faisant un changement de jeu pour la création de vidéos pilotée par l'IA. Que vous soyez un artiste esquissant des idées ou un développeur prototypant des visuels, AnimateDiff rationalise le processus de transformation de concepts en animations engageantes sans le besoin de travail manuel cadre par cadre. Ce framework open-source, disponible via des extensions comme celles pour l'interface WebUI d'AUTOMATIC1111, permet aux utilisateurs d'exploiter des modèles de diffusion pour la génération de texte vers vidéo et d'image vers vidéo, ouvrant des portes à une création de contenu efficace dans des domaines comme l'art, les jeux et l'éducation.

Comment fonctionne AnimateDiff ?

Au cœur, AnimateDiff combine des modèles de diffusion pré-entraînés de texte vers image ou d'image vers image, tels que Stable Diffusion, avec un module de mouvement dédié. Ce module est entraîné sur des clips vidéo du monde réel diversifiés pour capturer des motifs de mouvement courants, des dynamiques et des transitions, assurant que les animations paraissent naturelles et vivantes.

Processus Texte vers Vidéo

- Invite d'Entrée : Commencez par une invite de texte descriptive esquissant la scène, les personnages, les actions ou les concepts—par exemple, « une forêt sereine avec des lucioles dansantes au crépuscule ».

- Génération du Modèle de Base : La colonne vertébrale Stable Diffusion génère des cadres clés initiaux basés sur l'invite, en se concentrant sur le contenu visuel.

- Intégration de Mouvement : Le module de mouvement analyse l'invite et les cadres précédents pour prédire les dynamiques, en interpolant des cadres intermédiaires pour des transitions fluides.

- Rendu de Sortie : Le système coordonné produit un clip vidéo court ou un GIF, typiquement 16-24 cadres à 8-16 FPS, mettant en scène des éléments animés en mouvement.

Processus Image vers Vidéo

Pour animer des visuels existants :

- Télécharger une Image : Fournissez une photo statique, une œuvre d'art ou une image générée par IA.

- Génération de Variations : Utilisez le img2img de Stable Diffusion pour créer des variations subtiles de cadres clés.

- Application de Mouvement : Le module de mouvement ajoute des dynamiques inférées, en animant des éléments comme des objets ou des arrière-plans.

- Vidéo Finale : Résultant en un clip vivant où l'image originale prend vie, idéal pour insuffler de la vie à l'art numérique ou aux photos personnelles.

Cette approche plug-and-play signifie qu'aucun réentraînement extensif n'est requis—il suffit d'intégrer les modules de mouvement dans votre configuration Stable Diffusion. Les utilisateurs peuvent affiner les sorties avec des options avancées comme Motion LoRA pour des effets de caméra (panoramique, zoom) ou ControlNet pour des mouvements guidés à partir de vidéos de référence, améliorant la contrôlabilité et la créativité.

Fonctionnalités Clés d'AnimateDiff

- Intégration Plug-and-Play : Fonctionne de manière fluide avec les modèles Stable Diffusion v1.5 via des extensions, sans configuration lourde nécessaire pour un usage basique.

- Modes de Génération Polyvalents : Prend en charge le texte vers vidéo, l'image vers vidéo, les animations en boucle, et même l'édition vidéo vers vidéo avec guidance textuelle.

- Options de Personnalisation : Combinez avec DreamBooth ou LoRA pour animer des sujets personnalisés entraînés sur vos ensembles de données.

- Contrôles Avancés : Ajustez FPS, nombre de cadres, taille de lot de contexte pour des mouvements plus fluides ; activez des boucles fermées pour des cycles sans couture ou des cadres inversés pour une fluidité étendue.

- Efficacité : Génère des clips courts rapidement sur du matériel capable, plus rapide que de construire des modèles vidéo monolithiques à partir de zéro.

Ces fonctionnalités font d'AnimateDiff un outil flexible pour le prototypage rapide, réduisant le temps de l'idée à la sortie animée.

Comment Utiliser AnimateDiff

Commencer est simple, surtout avec la version gratuite en ligne sur animatediff.org, qui ne nécessite aucune installation.

Utilisation en Ligne (Aucune Configuration Requise)

- Visitez animatediff.org.

- Entrez votre invite de texte (par exemple, « un chat sautant par-dessus un arc-en-ciel »).

- Sélectionnez un modèle et un style de mouvement si disponible.

- Cliquez sur générer—l'IA le traite côté serveur et fournit un GIF ou une vidéo téléchargeable.

- Idéal pour les débutants ou les tests rapides, entièrement en ligne sans ressources locales.

Installation Locale pour Utilisateurs Avancés

Pour débloquer le plein potentiel :

- Installez le WebUI Stable Diffusion d'AUTOMATIC1111.

- Allez dans Extensions > Installer depuis URL, collez : https://github.com/continue-revolution/sd-webui-animatediff.

- Téléchargez les modules de mouvement (par exemple, mm_sd_v15_v2.ckpt) et placez-les dans le dossier extensions/animatediff/model.

- Redémarrez WebUI ; AnimateDiff apparaît dans les onglets txt2img/img2img.

- Entrez l'invite, activez AnimateDiff, définissez les cadres/FPS, et générez.

Pour les utilisateurs de Google Colab, des notebooks sont disponibles pour des exécutions basées sur le cloud. Aucune expertise en codage n'est nécessaire au-delà de la configuration basique—des tutoriels guident à travers les dépendances comme Python et Nvidia CUDA.

Exigences Système

- GPU : Nvidia avec 8GB+ VRAM (10GB+ pour vidéo vers vidéo) ; RTX 3060 ou mieux recommandé.

- OS : Windows/Linux principal ; macOS via Docker.

- RAM/Stockage : 16GB RAM, 1TB stockage pour modèles et sorties.

- Compatibilité : Stable Diffusion v1.5 uniquement ; vérifiez les mises à jour sur GitHub.

Avec cela, les temps de génération tombent à quelques minutes par clip, en fonction de la puissance du matériel.

Cas d'Utilisation Potentiels et Applications

AnimateDiff excelle dans les scénarios exigeant des animations rapides assistées par IA, s'alignant sur les intentions de recherche pour une narration visuelle efficace.

Art et Animation

Les artistes peuvent prototyper des esquisses ou des storyboards à partir de texte, économisant des heures sur le dessin manuel. Par exemple, visualisez instantanément le cycle de marche d'un personnage, itérant plus rapidement dans les flux de travail créatifs.

Développement de Jeux

Générez rapidement des animations d'actifs pour des prototypes—par exemple, mouvements d'ennemis ou transitions UI—accélérant la pré-production sans équipes d'animation complètes.

Éducation et Visualisation

Transformez des concepts abstraits en vidéos engageantes, comme animer des événements historiques ou des processus scientifiques, rendant l'apprentissage interactif et mémorable.

Réseaux Sociaux et Marketing

Créez des posts ou des pubs accrocheuses : décrivez une révélation de produit, et obtenez une animation en boucle prête pour Instagram ou TikTok, boostant l'engagement avec un effort minimal.

Graphismes en Mouvement et Prévisualisation

Produisez des intros dynamiques pour vidéos ou prévisualisez des scènes complexes avant des rendus/films coûteux, idéal pour les cinéastes ou développeurs AR/VR.

En réalité augmentée, il anime des personnages avec des mouvements naturels ; en publicité, il crée des clips promo personnalisés à partir d'images de marque.

Pourquoi Choisir AnimateDiff ?

Comparé à des outils traditionnels comme Adobe After Effects, AnimateDiff automatise le gros du travail, rendant les animations de haute qualité accessibles sans compétences pro. Sa dépendance à des priors de mouvement appris de vidéos réelles assure le réalisme, tandis que la contrôlabilité via invites adresse les points de douleur courants en génération IA. Gratuit et open-source, il est économique pour les hobbyistes et pros, avec des mises à jour communautaires via GitHub. Bien qu'imparfait pour la complexité hollywoodienne, il est imbattable pour l'idéation et le contenu court, favorisant l'innovation dans les outils vidéo IA.

Pour les utilisateurs cherchant 'meilleure IA texte vers vidéo' ou 'animer des images avec Stable Diffusion', AnimateDiff livre des résultats fiables, soutenus par son héritage de modèle de diffusion et son expertise en mouvement.

Pour Qui est AnimateDiff ?

- Professionnels Créatifs : Artistes, animateurs et designers ayant besoin de visualisations rapides.

- Développeurs et Gamers : Pour prototyper des éléments interactifs.

- Éducateurs/Créateurs de Contenu : Construisant des médias explicatifs ou divertissants.

- Marketeurs/Influenceurs Sociaux : Actifs animés rapides et personnalisables.

- Hobbyistes : Quiconque curieux de l'animation IA sans barrières techniques profondes.

Il est particulièrement adapté à ceux familiers avec Stable Diffusion, mais la démo en ligne abaisse le point d'entrée.

Limitations et Astuces pour Meilleurs Résultats

Bien que puissant, AnimateDiff a des contraintes :

- Portée du Mouvement : Meilleur pour des mouvements simples alignés sur les données d'entraînement ; actions complexes peuvent nécessiter un ajustement.

- Artefacts : Des mouvements plus élevés peuvent introduire des glitches—commencez avec des comptes de cadres inférieurs.

- Longueur/Cohérence : Excelle en clips courts (moins de 50 cadres) ; vidéos longues risquent l'inconsistance.

- Limites du Modèle : SD v1.5 uniquement ; surveillez la compatibilité v2.

Astuces : Utilisez des invites détaillées avec des descripteurs d'action (par exemple, « caméra tournant lentement »), expérimentez avec des LoRAs pour les styles, et post-traitez dans des outils comme Premiere pour le polissage. À mesure que la technologie de diffusion évolue, la communauté AnimateDiff continue d'affiner ces aspects, promettant des sorties encore plus fluides.

En résumé, AnimateDiff révolutionne la façon dont nous créons des animations, fusionnant la prouesse en image de Stable Diffusion avec une prédiction intelligente de mouvement. Pour quiconque explorant la génération vidéo IA, c'est un outil incontournable qui transforme l'imagination en mouvement sans effort.

Meilleurs outils alternatifs à "AnimateDiff"

BrainFever AI est une application de studio créatif qui utilise l'IA pour générer des images à partir d'invites textuelles et les animer. Disponible sur iOS et Mac, elle offre des modèles d'image puissants, une animation vidéo et une large gamme de styles.

SotaVideo est une plateforme de génération de vidéos IA qui donne accès à des modèles de pointe tels que Sora 2 et Veo 3. Générez instantanément des vidéos époustouflantes et réalistes avec audio à partir de texte ou d’images. Essayez-le gratuitement !

Lumiere, de Google Research, est un modèle de diffusion spatio-temporel pour la génération de vidéos. Il prend en charge le texte-vers-vidéo, l'image-vers-vidéo, la stylisation vidéo, les cinémagraphes et le remplissage, générant ainsi un mouvement réaliste et cohérent.

VisionFX est un studio créatif IA tout-en-un qui génère des images, des vidéos, de la musique et du contenu vocal en utilisant une technologie IA avancée. Parfait pour les créateurs de contenu, les designers et les marketeurs.

Transformez des images statiques en vidéos dynamiques avec une technologie d'IA avancée. Conversion rapide de 30 à 120 secondes, sortie de haute qualité et interface conviviale pour une création vidéo sans effort.

Outils de Création IA Tout-en-Un : Votre Plateforme IA Tout-en-Un pour la Création de Texte, Image, Vidéo et Humains Numériques. Transformez vos idées en visuels époustouflants rapidement avec des fonctionnalités IA avancées.

Découvrez Veo3.bot, un générateur de vidéo AI Veo 3 de Google gratuit avec audio natif. Créez des vidéos 1080p de haute qualité à partir de texte ou d'images, avec synchronisation labiale précise et physique réaliste—sans abonnement Gemini.

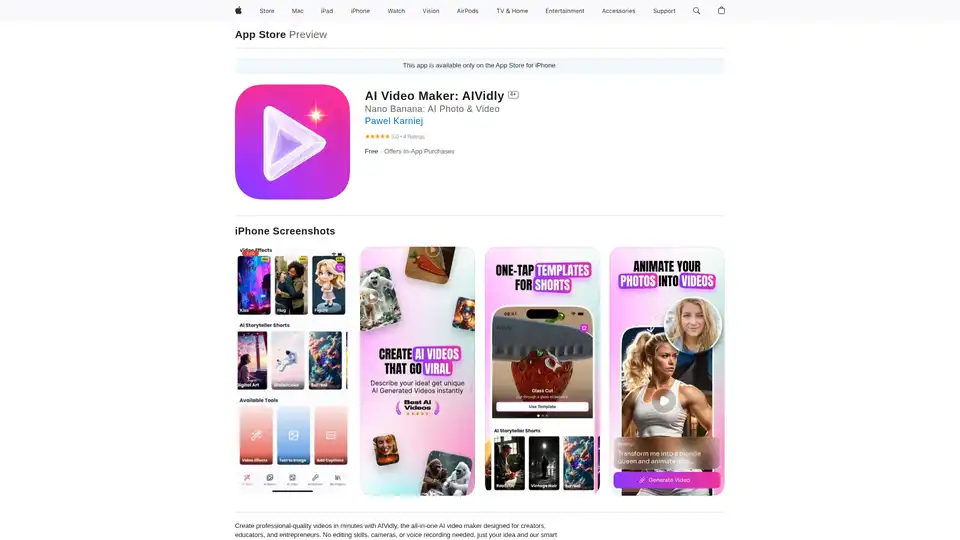

AIVidly est une application tout-en-un de créateur de vidéo IA pour iPhone qui transforme le texte en vidéos professionnelles avec des voix off IA, des effets et des optimisations pour TikTok et YouTube Shorts, sans compétences en édition.

AIEasyPic est une plateforme propulsée par l'IA qui transforme vos mots en art. Que vous imaginiez un paysage serein, un personnage excentrique ou des visuels abstraits avec des superpositions de texte puissantes, notre plateforme est équipée pour concrétiser vos idées créatives.

Utilisez Pollo AI, le générateur d'images et de vidéos IA gratuit et ultime tout-en-un, pour créer des images/vidéos avec des invites textuelles, des images ou des vidéos. Transformez vos idées en images et vidéos en haute résolution et qualité.

Découvrez Wan 2.2 AI, une plateforme de pointe pour la génération de texte vers vidéo et d'image vers vidéo avec des contrôles de qualité cinéma, un mouvement professionnel et une résolution 720p. Idéal pour les créateurs, les marketeurs et les producteurs à la recherche d'outils vidéo AI de haute qualité.

Meilleur générateur d'art IA gratuit : Générez des images et vidéos époustouflantes à partir de texte, ou créez des vidéos à partir d'images, le tout propulsé par la dernière technologie IA.

Transformez vos idées en vidéos en quelques secondes avec le Générateur de Vidéo IA de Media.io. Il suffit d'entrer du texte ou de télécharger une image pour créer des vidéos époustouflantes sans filigrane—100% gratuit.

DomoAI est un studio de création IA gratuit qui convertit des vidéos, du texte et des images en animation de haute qualité. Animez n'importe quel personnage avec DomoAI. Générez des vidéos IA à partir de texte, animez des images et transformez des séquences en contenu créatif.