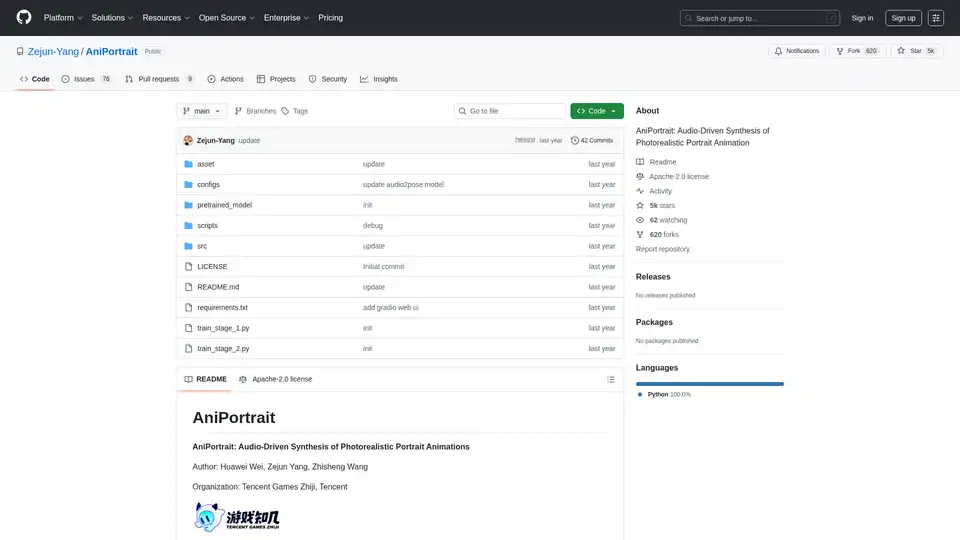

AniPortrait

Vue d'ensemble de AniPortrait

Qu'est-ce qu'AniPortrait ?

AniPortrait est un framework open-source innovant conçu pour la synthèse d'animations de portraits photoréalistes pilotées par l'audio. Développé par Huawei Wei, Zejun Yang et Zhisheng Wang de Tencent Games Zhiji et Tencent, cet outil exploite des techniques avancées d'IA pour créer des portraits animés de haute qualité à partir d'une seule image de référence et d'entrées audio ou vidéo. Que vous animiez un portrait statique avec un audio vocal ou que vous recréiez des expressions faciales à partir d'une vidéo source, AniPortrait produit des résultats réalistes qui capturent des nuances subtiles comme la synchronisation labiale et les mouvements de tête. Idéal pour les créateurs de contenu, les développeurs de jeux et les chercheurs en vision par ordinateur, il se distingue dans le domaine des outils de génération vidéo IA en se concentrant sur des animations spécifiques aux portraits.

Publié sur GitHub sous la licence Apache-2.0, AniPortrait a récolté plus de 5 000 étoiles, reflétant sa popularité dans la communauté IA. Le projet met l'accent sur l'accessibilité, avec des modèles pré-entraînés, des guides d'installation détaillés et même une interface web Gradio pour des tests faciles.

Comment fonctionne AniPortrait ?

Au cœur d'AniPortrait, un pipeline multi-étapes intègre des modèles de diffusion, le traitement audio et l'estimation de poses pour générer des animations. Le framework s'appuie sur des modèles établis comme Stable Diffusion V1.5 et wav2vec2 pour l'extraction de caractéristiques, assurant une gestion robuste de la synchronisation audio-visuelle.

Composants clés et flux de travail

- Traitement d'entrée : Commencez par une image de portrait de référence. En mode piloté par audio, les entrées audio sont traitées avec wav2vec2-base-960h pour extraire les caractéristiques vocales. En modes vidéo, les vidéos source sont converties en séquences de poses via l'extraction de points clés.

- Génération de poses : Le modèle audio2pose génère des séquences de poses de tête (par exemple, pose_temp.npy) à partir de l'audio, permettant un contrôle sur les orientations faciales. Pour la réenactation faciale, une stratégie de retargeting de poses mappe les mouvements de la vidéo source sur l'image de référence, supportant des différences de poses substantielles.

- Synthèse d'animation : Utilise un UNet de débruitage, un UNet de référence et des modules de mouvement pour synthétiser les frames. Le guide de poses assure l'alignement, tandis que l'interpolation de frames optionnelle accélère l'inférence.

- Raffinement de sortie : Génère des vidéos en résolutions comme 512x512, avec des options d'accélération utilisant film_net_fp16.pt pour réduire le temps de traitement.

Cette approche modulaire permet des animations auto-dirigées (en utilisant des poses prédéfinies), une réenactation faciale (transfert d'expressions) et une synthèse entièrement pilotée par audio, la rendant polyvalente pour divers scénarios d'animation de portraits IA.

Fonctionnalités principales d'AniPortrait

AniPortrait regorge de fonctionnalités puissantes adaptées à l'animation réaliste de portraits :

- Animation de portraits pilotée par audio : Synchronise les mouvements des lèvres et les expressions avec les entrées audio, parfait pour le doublage ou les avatars virtuels.

- Réenactation faciale : Transfère les performances faciales d'une vidéo source vers un portrait cible, idéal pour des applications éthiques similaires à deepfake dans les médias.

- Contrôle et retargeting de poses : Des stratégies mises à jour gèrent diverses poses de tête, y compris la génération de fichiers de poses personnalisés pour un contrôle précis.

- Sortie haute résolution : Produit des vidéos photoréalistes avec support pour des séquences plus longues (jusqu'à 300 frames ou plus).

- Options d'accélération : Interpolation de frames et modèles FP16 accélèrent l'inférence sans sacrifier la qualité.

- Interface web Gradio : Une interface conviviale pour des démos rapides, également hébergée sur Hugging Face Spaces pour un accès en ligne.

- Modèles pré-entraînés : Inclut des poids pour audio2mesh, audio2pose et composants de diffusion, téléchargeables depuis des sources comme Wisemodel.

Ces fonctionnalités font d'AniPortrait un outil incontournable pour la synthèse vidéo pilotée par IA, surpassant les outils basiques en se concentrant sur la fidélité des portraits et la cohérence audio-visuelle.

Installation et configuration

Démarrer est simple pour les utilisateurs avec Python >=3.10 et CUDA 11.7 :

- Clonez le dépôt :

git clone https://github.com/Zejun-Yang/AniPortrait. - Installez les dépendances :

pip install -r requirements.txt. - Téléchargez les poids pré-entraînés dans

./pretrained_weights/, incluant les composants Stable Diffusion, wav2vec2 et modèles personnalisés commedenoising_unet.pthetaudio2pose.pt. - Organisez les fichiers selon la structure de répertoires dans le README.

Pour l'entraînement, préparez des datasets comme VFHQ ou CelebV-HQ en extrayant les points clés et en exécutant des scripts de prétraitement. L'entraînement se déroule en deux étapes en utilisant Accelerate pour le traitement distribué.

Comment utiliser AniPortrait ?

Modes d'inférence

AniPortrait supporte trois modes principaux via des scripts en ligne de commande :

Animation auto-dirigée :

python -m scripts.pose2vid --config ./configs/prompts/animation.yaml -W 512 -H 512 -accPersonnalisez avec des images de référence ou des vidéos de poses. Convertissez les vidéos en poses avec

python -m scripts.vid2pose --video_path input.mp4.Réenactation faciale :

python -m scripts.vid2vid --config ./configs/prompts/animation_facereenac.yaml -W 512 -H 512 -accÉditez le YAML pour inclure les vidéos source et références.

Synthèse pilotée par audio :

python -m scripts.audio2vid --config ./configs/prompts/animation_audio.yaml -W 512 -H 512 -accAjoutez les audios et images à la config. Activez audio2pose en supprimant pose_temp pour une génération automatique de poses.

Pour le contrôle de pose de tête, générez des poses de référence avec python -m scripts.generate_ref_pose.

Démo web

Lancez l'interface Gradio : python -m scripts.app. Ou essayez la version en ligne sur Hugging Face Spaces.

Les utilisateurs peuvent expérimenter avec des vidéos d'exemple comme 'cxk.mp4' ou 'jijin.mp4' pour voir la synchronisation audio en action, sourcées de plateformes comme Bilibili.

Entraîner AniPortrait depuis zéro

Les utilisateurs avancés peuvent entraîner des modèles personnalisés :

- Préparation des données : Téléchargez les datasets, prétraitez avec

python -m scripts.preprocess_datasetet mettez à jour les chemins JSON. - Étape 1 :

accelerate launch train_stage_1.py --config ./configs/train/stage1.yaml. - Étape 2 : Téléchargez les poids du module de mouvement, spécifiez les checkpoints de l'Étape 1 et exécutez

accelerate launch train_stage_2.py --config ./configs/train/stage2.yaml.

Ce processus affine sur des données spécifiques aux portraits, améliorant la généralisation pour les tâches d'animation IA.

Pourquoi choisir AniPortrait ?

Dans un domaine encombré d'outils IA pour la génération vidéo, AniPortrait excelle grâce à son focus spécialisé sur les portraits photoréalistes. Contrairement aux modèles polyvalents, il gère la synchronisation audio-lèvre et les expressions subtiles avec précision, réduisant les artefacts dans les animations faciales. La nature open-source permet la personnalisation, et les mises à jour récentes — comme la sortie audio2pose d'avril 2024 et les modules d'accélération — le maintiennent à la pointe. Les remerciements de la communauté à des projets comme EMO et AnimateAnyone soulignent ses racines collaboratives, assurant des performances fiables.

La valeur pratique inclut un prototypage plus rapide pour les influenceurs virtuels, les vidéos éducatives ou les assets de jeux. Avec la disponibilité du papier arXiv (eprint 2403.17694), il sert les chercheurs explorant la synthèse audio-visuelle en vision par ordinateur.

Pour qui est AniPortrait ?

- Créateurs de contenu et cinéastes : Pour un doublage rapide ou des transferts d'expressions dans des vidéos courtes.

- Développeurs de jeux dans des studios comme Tencent : Intégrant des portraits animés dans des médias interactifs.

- Chercheurs IA : Expérimentant avec l'animation basée sur la diffusion et le retargeting de poses.

- Amateurs et éducateurs : Utilisant l'interface web pour enseigner les concepts IA sans configuration lourde.

Si vous cherchez la meilleure façon de créer des animations de portraits pilotées par audio, l'équilibre d'AniPortrait en qualité, vitesse et accessibilité en fait un choix de premier plan.

Applications potentielles et cas d'usage

- Avatars virtuels : Animez des personnages numériques avec un discours synchronisé pour les réseaux sociaux ou les métavers.

- Outils éducatifs : Générez des vidéos de têtes parlantes pour des conférences ou tutoriels.

- Production médiatique : Réenactation faciale éthique pour des reconstitutions historiques ou publicités.

- Prototypage de recherche : Benchmark de modèles audio-to-vidéo dans des papiers CV.

Les démonstrations incluent des clips auto-dirigés comme 'solo.mp4' et des exemples audio comme 'kara.mp4', montrant une intégration fluide.

Pour le dépannage, consultez les 76 issues ouvertes sur GitHub ou contribuez via des pull requests. Globalement, AniPortrait permet aux utilisateurs de repousser les limites de l'animation de portraits IA avec des résultats fiables et de haute fidélité.

Meilleurs outils alternatifs à "AniPortrait"

Lip Sync AI transforme des photos statiques en vidéos parlantes en utilisant une technologie avancée de synchronisation labiale avec l'IA. Téléchargez une photo et un fichier audio pour générer des vidéos réalistes synchronisées avec les lèvres avec des expressions naturelles.

Obtenez rapidement de l'inspiration couleur avec notre générateur de palettes de couleurs IA.

AIVidly est une application tout-en-un de créateur de vidéo IA pour iPhone qui transforme le texte en vidéos professionnelles avec des voix off IA, des effets et des optimisations pour TikTok et YouTube Shorts, sans compétences en édition.

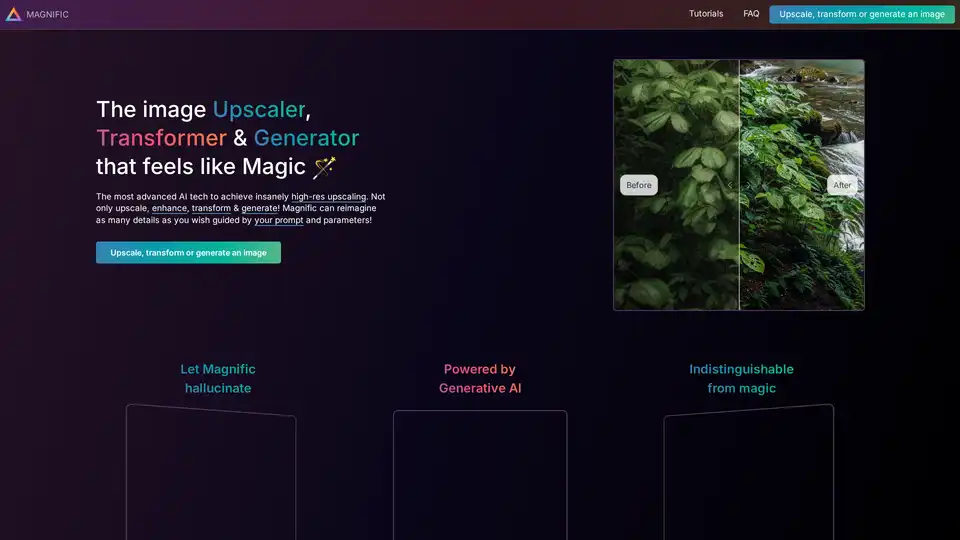

Découvrez Magnific AI, le meilleur upscaler et améliorateur IA qui transforme les images avec des détails guidés par des prompts et une magie haute résolution. Idéal pour les portraits, illustrations et plus.

Créez des images professionnelles avec Nano Banana, l'IA révolutionnaire de Google dotée d'une cohérence des personnages, d'une fusion multi-images et d'une vitesse en temps réel.

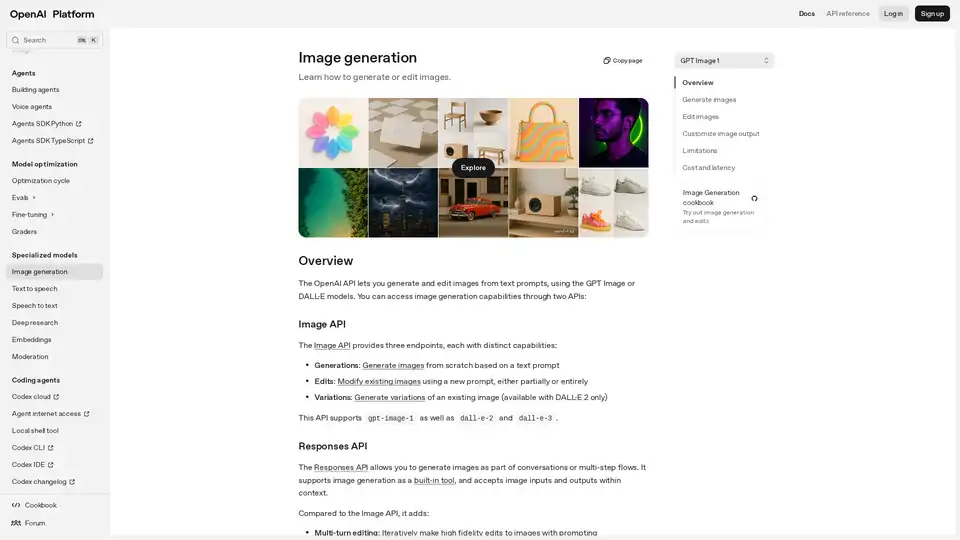

Découvrez l'API de génération d'images OpenAI pour créer et modifier des images époustouflantes à partir de prompts textuels avec des modèles comme GPT Image et DALL·E. Idéal pour les développeurs intégrant du contenu visuel piloté par l'IA.

MirrorizeAI est une communauté d'art IA dynamique qui permet aux créateurs de générer des images, vidéos et musiques époustouflantes avec un réalisme cinématographique. Collaborez mondialement, itérez rapidement et libérez votre imagination sans abonnements.

Photoflow AI révolutionne l'imagerie professionnelle avec des headshots ultra-réalistes en 8K. Téléchargez une photo, personnalisez les styles et fonds, et obtenez des résultats de haute qualité pour LinkedIn, sites corporatifs et plus en minutes.

Découvrez Slides to Videos, l'outil IA qui transforme Google Slides en vidéos professionnelles avec images, animations et narration IA. Idéal pour les créateurs de contenu, marketeurs et éducateurs pour produire du contenu engageant sur les réseaux sociaux et YouTube rapidement.

Découvrez Wan 2.2 AI, une plateforme de pointe pour la génération de texte vers vidéo et d'image vers vidéo avec des contrôles de qualité cinéma, un mouvement professionnel et une résolution 720p. Idéal pour les créateurs, les marketeurs et les producteurs à la recherche d'outils vidéo AI de haute qualité.

Découvrez l'Éditeur d'Images AI : transformez des photos sans effort avec des invites textuelles. Éditez, améliorez et fusionnez des images tout en maintenant la cohérence, idéal pour les flux de travail créatifs et professionnels.

Créez des photos d'identité conformes aux exigences gouvernementales en quelques secondes grâce au créateur de photos d'identité IA de PhotoGov. Téléchargez, recadrez et téléchargez des feuilles imprimables pour les passeports, les visas et les pièces d'identité.

Transformez des images statiques en vidéos animées réalistes avec LivePortrait, un créateur de portraits en direct alimenté par l'IA. Essayez-le gratuitement pour créer des animations personnalisables de haute qualité.

CreativeMagicPanel est un plugin de retouche alimenté par l'IA pour Photoshop qui accélère l'édition de photos. Obtenez une peau parfaite, utilisez la reconnaissance faciale de l'IA et appliquez des looks époustouflants en un seul clic.