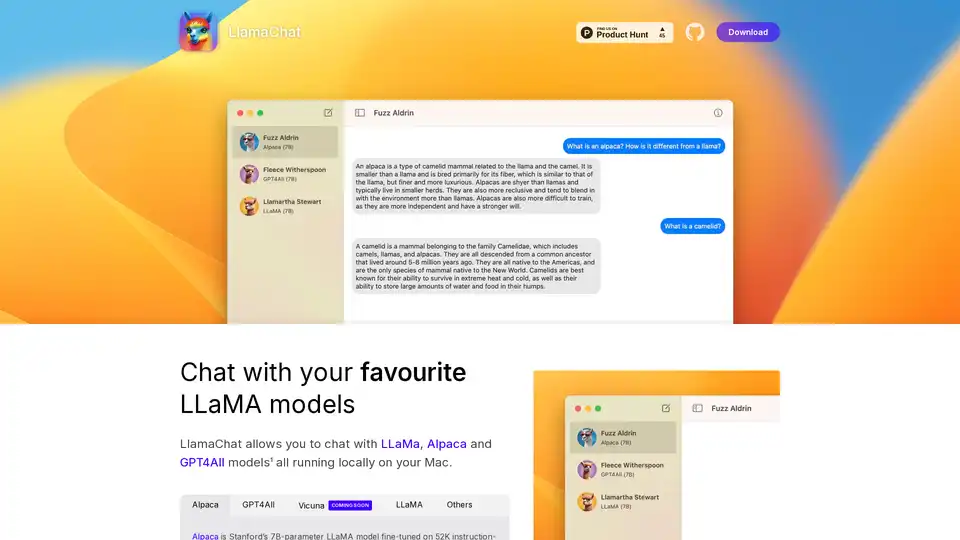

LlamaChat

Vue d'ensemble de LlamaChat

LlamaChat : Discutez avec des modèles LLaMA locaux sur votre Mac

Qu'est-ce que LlamaChat ? LlamaChat est une application macOS qui permet aux utilisateurs d'interagir avec divers grands modèles linguistiques (LLM) tels que LLaMA, Alpaca et GPT4All directement sur leur Mac, sans dépendre des services basés sur le cloud. Cela signifie que les modèles s'exécutent localement, offrant une confidentialité et un contrôle améliorés.

Principales caractéristiques et fonctionnalités

- Prise en charge locale des LLM: LlamaChat prend en charge plusieurs LLM, notamment LLaMA, Alpaca et GPT4All, tous s'exécutant localement sur votre Mac.

- Conversion de modèle: LlamaChat peut importer des points de contrôle de modèle PyTorch bruts ou des fichiers de modèle .ggml préconvertis pour une utilisation facile.

- Open Source: Propulsé par des bibliothèques open source telles que llama.cpp et llama.swift, garantissant la transparence et le développement axé sur la communauté.

- Gratuit et Open Source: LlamaChat est entièrement gratuit et open source, garantissant l'accessibilité et la contribution de la communauté.

Modèles pris en charge

- Alpaca: Le modèle LLaMA à 7 milliards de paramètres de Stanford affiné sur 52 000 démonstrations de suivi d'instructions générées à partir du text-davinci-003 d'OpenAI.

- GPT4All: Un LLM open source.

- Vicuna: Un LLM open source.

- LLaMA: Le LLM fondamental de Meta.

Comment fonctionne LlamaChat ?

LlamaChat exploite des bibliothèques open source pour exécuter des LLM directement sur votre machine. Il est construit à l'aide de llama.cpp et llama.swift. Cela vous permet de convertir et d'importer des points de contrôle de modèle PyTorch bruts ou des fichiers de modèle .ggml préconvertis.

Comment utiliser LlamaChat ?

- Télécharger: Téléchargez LlamaChat depuis le site Web officiel ou en utilisant

brew install --cask llamachat. - Installer: Installez l'application sur votre macOS 13 ou version ultérieure.

- Importer des modèles: Importez vos modèles LLaMA, Alpaca ou GPT4All dans l'application.

- Discuter: Commencez à discuter avec vos modèles LLM préférés localement.

Pourquoi choisir LlamaChat ?

- Confidentialité: Exécutez des modèles localement sans envoyer de données à des serveurs externes.

- Contrôle: Contrôle total sur les modèles et les données utilisés.

- Rentable: Pas de frais d'abonnement ni de frais d'utilisation.

- Open Source: Bénéficiez des améliorations et de la transparence axées sur la communauté.

À qui s'adresse LlamaChat ?

LlamaChat est idéal pour :

- Développeurs: Expérimenter avec des LLM sur des machines locales.

- Chercheurs: Mener des recherches sans dépendre de services externes.

- Utilisateurs soucieux de la confidentialité: Les utilisateurs qui souhaitent conserver leurs données locales et privées.

Installation

LlamaChat peut être installé via :

- Télécharger: Directement depuis la page GitHub du projet ou Product Hunt.

- Homebrew: En utilisant la commande

brew install --cask llamachat.

Bibliothèques Open Source

LlamaChat est construit sur :

- llama.cpp: Pour une inférence efficace des LLM sur le CPU.

- llama.swift: Fournissant une interface macOS native pour les LLM.

Clause de non-responsabilité

LlamaChat n'est pas affilié à Meta Platforms, Inc., Leland Stanford Junior University ou Nomic AI, Inc. Les utilisateurs sont responsables de l'obtention et de l'intégration des fichiers de modèle appropriés conformément aux conditions générales respectives définies par leurs fournisseurs.

Meilleurs outils alternatifs à "LlamaChat"

Private LLM est un chatbot d'IA local pour iOS et macOS qui fonctionne hors ligne, gardant vos informations entièrement sur l'appareil, en sécurité et privées. Profitez d'une conversation sans censure sur votre iPhone, iPad et Mac.

Nexa SDK permet une inférence IA rapide et privée sur l'appareil pour les modèles LLM, multimodaux, ASR et TTS. Déployez sur les appareils mobiles, PC, automobiles et IoT avec des performances prêtes pour la production sur NPU, GPU et CPU.

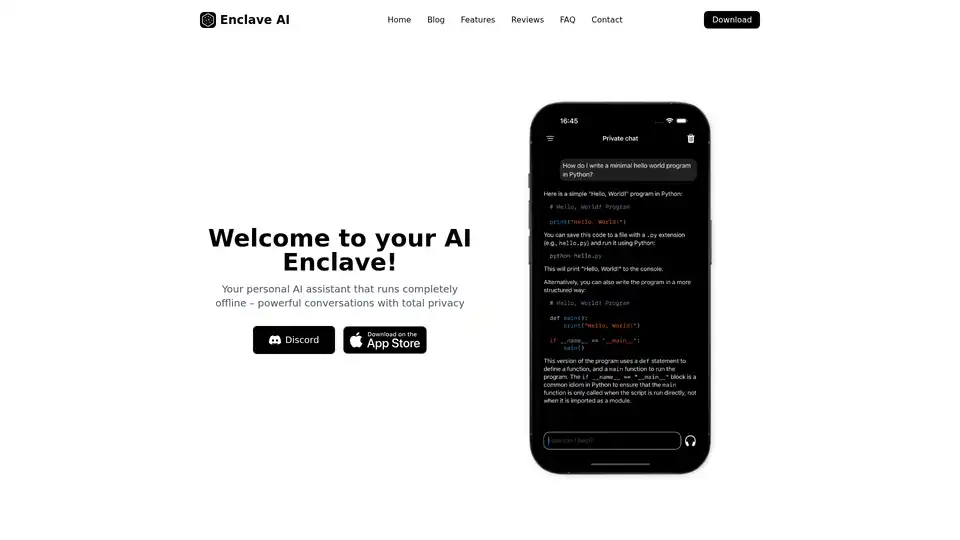

Enclave AI est un assistant IA axé sur la confidentialité pour iOS et macOS qui fonctionne complètement hors ligne. Il offre un traitement LLM local, des conversations sécurisées, un chat vocal et une interaction avec des documents sans avoir besoin d'une connexion Internet.

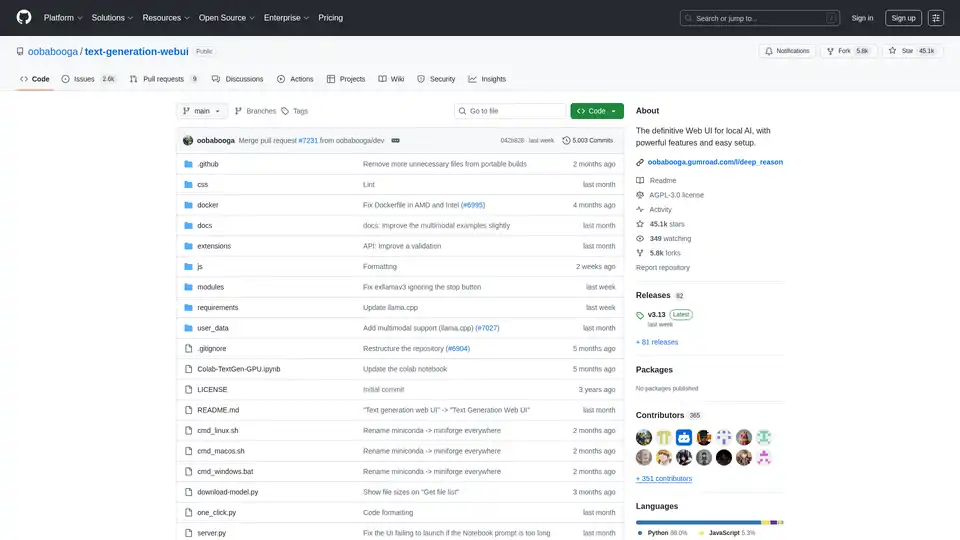

Text Generation Web UI est une interface web Gradio puissante et conviviale pour les grands modèles de langage IA locaux. Prend en charge plusieurs backends, extensions et offre une confidentialité hors ligne.

Repo Prompt améliore le codage assisté par l'IA grâce à l'ingénierie de contexte visuel, aux cartes de code et à l'intégration du serveur MCP, permettant des interactions d'IA plus rapides et plus précises avec votre base de code. Parfait pour les développeurs utilisant des outils d'IA.

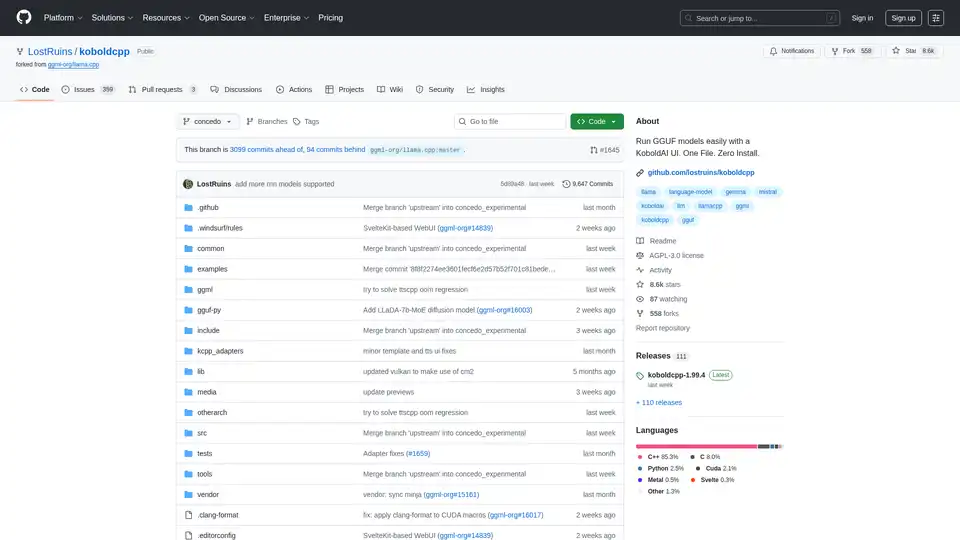

KoboldCpp : Exécutez facilement des modèles GGUF pour la génération de texte et d'images IA avec une interface utilisateur KoboldAI. Fichier unique, installation zéro. Prend en charge CPU/GPU, STT, TTS et Stable Diffusion.

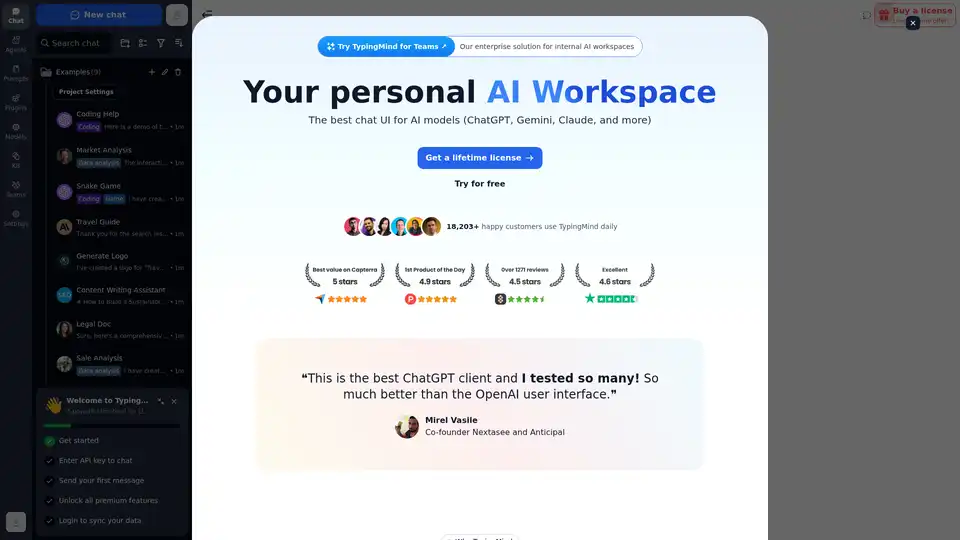

Discutez avec l'IA en utilisant vos clés API. Payez uniquement ce que vous utilisez. Prend en charge GPT-4, Gemini, Claude et autres LLMs. La meilleure interface de chat frontend LLM pour tous les modèles d'IA.

Remind AI est un outil de mémoire artificielle locale open-source qui capture vos activités numériques à l'aide d'une IA avancée, boostant la productivité sans dépendance au cloud. Téléchargez et personnalisez pour un usage personnel.

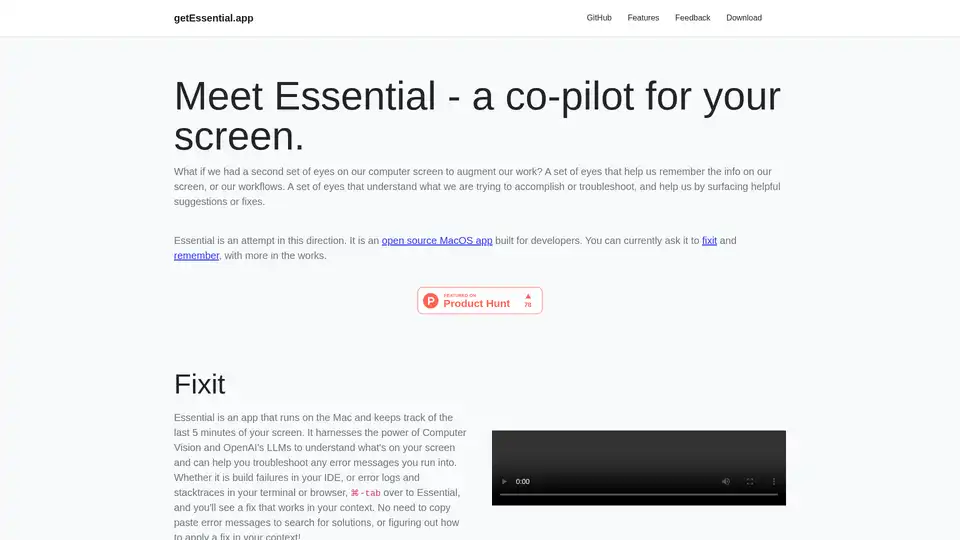

Essential est une app open-source pour MacOS qui agit comme un copilote IA pour votre écran, aidant les développeurs à corriger les erreurs instantanément et à se souvenir des flux de travail clés avec des résumés et captures d'écran—aucun data ne quitte l'appareil.

GrammarBot est un vérificateur de grammaire et d'orthographe basé sur l'IA pour MacOS qui fonctionne hors ligne. Téléchargez l'application et le modèle d'IA une fois et améliorez votre anglais pour toujours. Licence personnelle 12 $.

AnythingLLM est une application d'IA tout-en-un qui vous permet de discuter avec vos documents, d'améliorer votre productivité et d'exécuter des LLM de pointe localement et en privé. Tirez parti des agents d'IA et des modèles personnalisés sans aucune configuration.

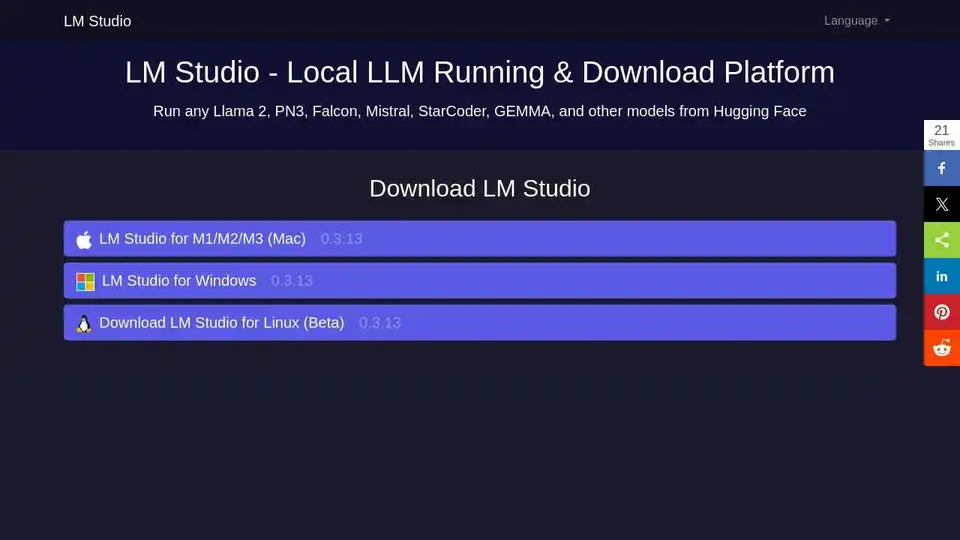

LM Studio : exécutez LLaMa, MPT, Gemma et d'autres LLM localement sur votre ordinateur portable. Téléchargez des modèles compatibles à partir de Hugging Face et utilisez-les hors ligne.

RecurseChat : Une application d'IA personnelle qui vous permet de parler avec l'IA locale, hors ligne, et de discuter avec des fichiers PDF et markdown.

MacCopilot: Copilot AI natif pour macOS. Interagissez avec n'importe quel contenu d'écran en utilisant GPT-4o, ClaudeAI et Google Gemini.