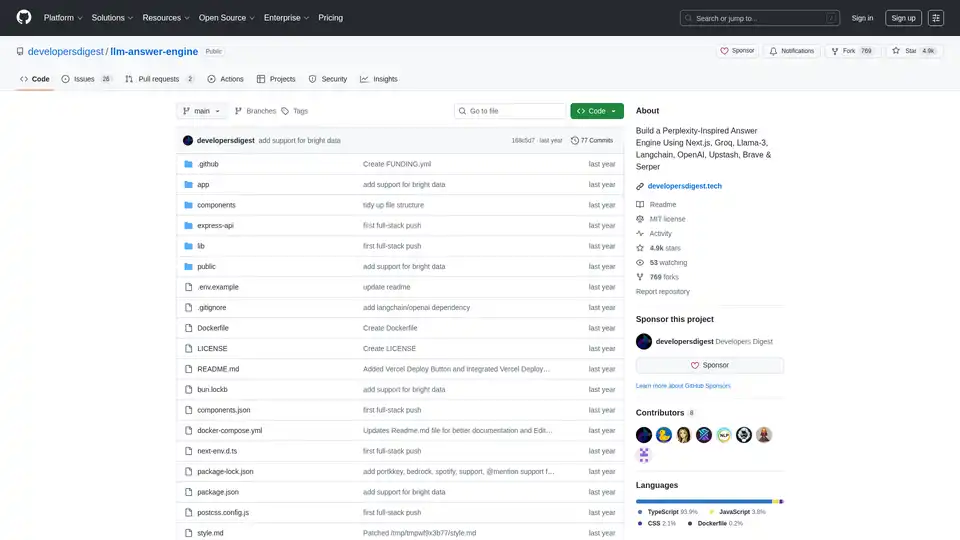

llm-answer-engine

Vue d'ensemble de llm-answer-engine

Moteur de réponse LLM : construisez votre propre système de questions-réponses alimenté par l'IA

Ce projet open source, llm-answer-engine, fournit le code et les instructions pour construire un moteur de réponse d'IA sophistiqué inspiré de Perplexity. Il exploite des technologies de pointe telles que Groq, Mixtral de Mistral AI, Langchain.JS, Brave Search, Serper API et OpenAI pour fournir des réponses complètes aux requêtes des utilisateurs, avec des sources, des images, des vidéos et des questions de suivi.

Qu'est-ce que llm-answer-engine ?

llm-answer-engine est un point de départ pour les développeurs intéressés par l'exploration du traitement du langage naturel et des technologies de recherche. Il vous permet de créer un système qui répond efficacement aux questions en :

- Récupérant des informations pertinentes provenant de diverses sources.

- Générant des réponses concises et informatives.

- Fournissant des preuves à l'appui et des médias connexes.

- Suggérant des questions de suivi pour guider l'exploration plus approfondie.

Comment fonctionne llm-answer-engine ?

Le moteur utilise une combinaison de technologies pour traiter les requêtes des utilisateurs et générer des réponses pertinentes :

- Compréhension des requêtes: Des technologies telles que Groq et Mixtral sont utilisées pour traiter et comprendre la question de l'utilisateur.

- Récupération d'informations:

- Brave Search: Un moteur de recherche axé sur la confidentialité est utilisé pour trouver du contenu et des images pertinents.

- Serper API: Utilisée pour récupérer des résultats vidéo et image pertinents en fonction de la requête de l'utilisateur.

- Cheerio: Utilisée pour l'analyse HTML, permettant l'extraction de contenu à partir de pages web.

- Traitement du texte:

- Langchain.JS: Une bibliothèque JavaScript axée sur les opérations de texte, telles que la division de texte et les intégrations.

- OpenAI Embeddings: Utilisée pour créer des représentations vectorielles de morceaux de texte.

- Composants optionnels:

- Ollama: Utilisée pour l'inférence et les intégrations en streaming.

- Upstash Redis Rate Limiting: Utilisée pour configurer la limitation de débit pour l'application.

- Upstash Semantic Cache: Utilisée pour la mise en cache des données afin d'accélérer les temps de réponse.

Principales caractéristiques et technologies:

- Next.js: Un framework React pour la création d'applications web statiques et rendues côté serveur, fournissant une base solide pour l'interface utilisateur.

- Tailwind CSS: Un framework CSS utilitaire pour la création rapide d'interfaces utilisateur personnalisées, permettant un style et une personnalisation efficaces.

- Vercel AI SDK: Une bibliothèque pour la création d'interfaces utilisateur de texte et de chat en streaming alimentées par l'IA, améliorant l'expérience utilisateur avec un retour d'information en temps réel.

- Prise en charge des appels de fonction (Beta): Étend les fonctionnalités avec des intégrations pour les cartes et les lieux (Serper Locations API), le shopping (Serper Shopping API), les données boursières de TradingView et Spotify.

- Prise en charge d'Ollama (partiellement prise en charge): Offre une compatibilité avec Ollama pour le streaming de réponses textuelles et d'intégrations, permettant l'exécution de modèles locaux.

Comment utiliser llm-answer-engine ?

Pour commencer avec llm-answer-engine, suivez ces étapes :

- Prérequis:

- Obtenez les clés API d'OpenAI, Groq, Brave Search et Serper.

- Assurez-vous que Node.js et npm (ou bun) sont installés.

- (Facultatif) Installez Docker et Docker Compose pour le déploiement en conteneur.

- Installation:

git clone https://github.com/developersdigest/llm-answer-engine.git

cd llm-answer-engine

3. **Configuration**: * **Docker**: Modifiez le fichier `docker-compose.yml` et ajoutez vos clés API. * **Non-Docker**: Créez un fichier `.env` à la racine de votre projet et ajoutez vos clés API. 4. **Exécutez le serveur**: * **Docker**:bash

docker compose up -d

* **Non-Docker**:bash

npm install # or bun install

npm run dev # or bun run dev

```

Le serveur sera à l'écoute sur le port spécifié.

Pourquoi choisir llm-answer-engine ?

- Inspiré par Perplexity: Offre une expérience utilisateur similaire à celle d'un moteur de réponse d'IA de premier plan.

- Exploite des technologies puissantes: Combine le meilleur des technologies NLP, de recherche et de développement web.

- Open source et personnalisable: Vous permet d'adapter le moteur à vos besoins spécifiques.

- Prise en charge des appels de fonction: Étend les fonctionnalités avec des intégrations pour les cartes et les lieux, le shopping, les données boursières de TradingView et Spotify.

À qui s'adresse llm-answer-engine ?

Ce projet est idéal pour :

- Les développeurs intéressés par le traitement du langage naturel et les technologies de recherche.

- Les chercheurs qui explorent les systèmes de questions-réponses.

- Toute personne souhaitant construire sa propre base de connaissances alimentée par l'IA.

Feuille de route:

La feuille de route du projet comprend des fonctionnalités intéressantes telles que :

- Téléchargement de documents + RAG pour la recherche/récupération de documents.

- Un composant de paramètres pour permettre aux utilisateurs de sélectionner le modèle, le modèle d'intégrations et d'autres paramètres à partir de l'interface utilisateur.

- Ajout de la prise en charge des questions de suivi lors de l'utilisation d'Ollama

Contribution:

Les contributions sont les bienvenues ! Fourchez le dépôt, effectuez vos modifications et soumettez une demande de tirage.

Ce projet est sous licence MIT.

Construisez votre propre moteur de réponse alimenté par l'IA et explorez les possibilités du traitement du langage naturel avec llm-answer-engine !

Meilleurs outils alternatifs à "llm-answer-engine"

Airweave est un outil open source qui centralise les données de diverses applications et bases de données, permettant aux agents d'IA de fournir des réponses précises et fondées instantanément. Créez des agents d'IA plus intelligents dès aujourd'hui !

LangSearch fournit une API de recherche Web et une API de reclassement sémantique pour connecter les applications LLM à un contexte propre et précis.

La plate-forme d'activation de l'IA de BA Insight fournit une recherche d'entreprise basée sur l'IA, connectant les utilisateurs au contenu pertinent de systèmes disparates, améliorée par la compréhension sémantique et RAG pour l'IA générative.

AI Answer Generator vous aide à générer des réponses instantanées de l'IA pour toute question. Obtenez des réponses rapides et précises avec cet outil gratuit de questions-réponses de l'IA en ligne.

Helpjuice : Logiciel de Base de Connaissances approuvé par plus de 130 000 utilisateurs d'Amazon, Hertz, Shipt. Rationalisez le support, boostez la productivité avec une recherche et une création de contenu alimentées par l'IA. Essai gratuit de 14 jours.

GenSearch révolutionne la recherche grâce à l'IA générative, permettant aux utilisateurs de créer des moteurs de recherche personnalisés basés sur l'IA avec des expériences personnalisées et des intégrations transparentes.

Albus AI est un espace de travail cloud qui rationalise l'indexation des documents et fournit une recherche sémantique. Il organise automatiquement les fichiers, ce qui permet deeffectuer des recherches dans différents types de documents et offre des réponses optimisées par l'IA avec des références.

Transformez votre stratégie de médias sociaux avec Currents AI. Découvrez les sujets tendances, analysez vos concurrents et interagissez avec votre public sur les principales plateformes.

Albus AI est un espace de travail cloud qui crée des bases de connaissances IA, rationalise les documents et fournit un moteur d'IA sans hallucination pour un référencement précis et une cartographie sémantique. Organisez automatiquement vos fichiers, effectuez des recherches dans plusieurs formats et obtenez des réponses avec des références.

INSIGHT DOCUMENT est une plateforme basée sur l'IA pour l'analyse de documents et la génération de rapports. Extrayez des connaissances, analysez le contenu et obtenez des informations significatives à partir de vos documents grâce à l'IA avancée.

Lettria est une plateforme d'IA transformant les données non structurées en connaissances structurées pour une prise de décision plus intelligente. Améliorez la précision de RAG grâce à l'IA basée sur des graphes de Lettria.

SummyMonkey révolutionne la productivité en résumant les enregistrements audio et emails en insights actionnables. Des fonctionnalités comme NoteTaker, Summariser et Compiler économisent du temps sur les réunions et boîtes de réception, transformant des heures en minutes avec une efficacité alimentée par l'IA.

Découvrez Veo3.bot, un générateur de vidéo AI Veo 3 de Google gratuit avec audio natif. Créez des vidéos 1080p de haute qualité à partir de texte ou d'images, avec synchronisation labiale précise et physique réaliste—sans abonnement Gemini.

Exa est un moteur de recherche alimenté par l'IA et une API de données Web conçue pour les développeurs. Il offre une recherche Web rapide, des ensembles Web pour les requêtes complexes et des outils d'exploration, de réponse et de recherche approfondie, permettant à l'IA d'accéder à des informations en temps réel.