lluminy

Vue d'ensemble de lluminy

lluminy est un outil alimenté par l'IA conçu pour automatiser le processus de documentation des projets Python. Il exploite l'IA, en particulier LLama3, pour générer des commentaires de code et des docstrings, ce qui permet aux développeurs de gagner du temps et de l'énergie. Avec lluminy, vous pouvez rapidement documenter l'ensemble de votre base de code, améliorer la collaboration au sein de l'équipe et simplifier la maintenance de la base de code. L'outil s'intègre de manière transparente à GitHub, ce qui vous permet de sélectionner des référentiels et de générer des commentaires de code en quelques clics. Il offre des options de personnalisation pour documenter toutes les fonctions ou uniquement celles qui n'ont pas de docstrings et prend en charge la création de demandes d'extraction pour fusionner les résultats.

Principales caractéristiques :

- Génération de Docstrings Alimentée par l'IA : Automatisez la création de commentaires de code et de docstrings à l'aide de LLama3.

- Intégration GitHub : Connectez votre compte GitHub et sélectionnez les référentiels pour la documentation.

- Sortie Personnalisable : Choisissez de documenter toutes les fonctions ou uniquement celles qui n'ont pas de docstrings.

- Suggestions Automatisées : Le bot GitHub (à venir) fournira des suggestions pour les commentaires de code dans les demandes d'extraction.

lluminy est idéal pour les développeurs et les équipes qui cherchent à améliorer la documentation du code, à accélérer l'intégration des développeurs et à simplifier la maintenance de la base de code. Améliorez vos projets Python avec des fonctions claires et faciles à maintenir et gagnez un temps précieux grâce à l'assistance automatisée de l'IA.

Meilleurs outils alternatifs à "lluminy"

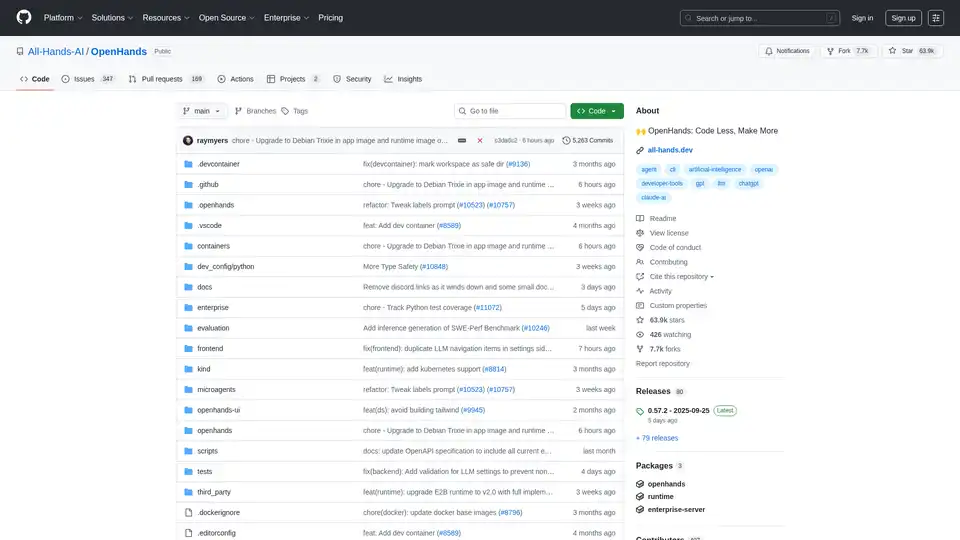

OpenHands est un agent de développement logiciel alimenté par l'IA qui peut modifier le code, exécuter des commandes, naviguer sur le Web et appeler des API. Inscrivez-vous à OpenHands Cloud pour commencer.

Activez l'inférence LLM efficace avec llama.cpp, une bibliothèque C/C++ optimisée pour divers matériels, prenant en charge la quantification, CUDA et les modèles GGUF. Idéal pour un déploiement local et cloud.

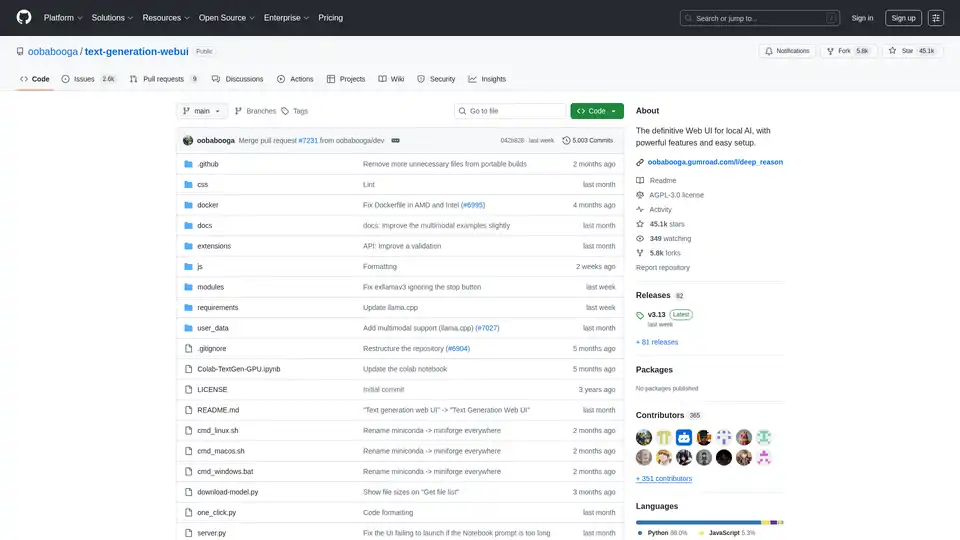

Text Generation Web UI est une interface web Gradio puissante et conviviale pour les grands modèles de langage IA locaux. Prend en charge plusieurs backends, extensions et offre une confidentialité hors ligne.

Firecrawl est l'API de crawling, scraping et recherche web leader conçue pour les applications IA. Elle transforme les sites web en données propres, structurées et prêtes pour LLM à grande échelle, alimentant les agents IA avec une extraction web fiable sans proxies ni tracas.

Découvrez Lab2, l'outil IA qui transforme des prompts textuels en apps Python avec Streamlit, Gradio et Flask. Idéal pour le prototypage rapide sans expertise en codage.

Figstack est un outil alimenté par l'IA qui booste les développeurs en expliquant le code, traduisant les langages, automatisant la documentation et analysant la complexité temporelle pour un codage efficace dans plusieurs langues.

Transformez l'analyse de données complexe avec la plateforme tout-en-un de Fabi.ai. Combinez SQL, Python et automatisation IA pour des insights, tableaux de bord et flux de travail plus rapides à partir de vos sources de données.

Marvin est un framework Python puissant pour construire des applications IA avec des modèles de langage large (LLM). Il simplifie la gestion d'états, la coordination d'agents et les sorties structurées pour les développeurs créant des apps intelligentes.

Code2Docs automatise la documentation de code grâce à la technologie IA, s'intègre parfaitement à GitHub et génère une documentation complète incluant des guides d'utilisation et une documentation API pour booster la productivité des développeurs.

GitHub Copilot est un assistant de codage alimenté par IA qui s'intègre dans votre IDE, suggérant des lignes de code, gérant les problèmes via le mode agent et fournissant des revues pour booster la productivité des développeurs.

Découvrez DataChain, une plateforme native IA pour curater, enrichir et versionner des ensembles de données multimodaux comme vidéos, audio, PDF et scans IRM. Elle empower les équipes avec des pipelines ETL, lignage de données et traitement scalable sans duplication.

mistral.rs est un moteur d'inférence LLM ultra-rapide écrit en Rust, prenant en charge les flux de travail multimodaux et la quantification. Offre des API Rust, Python et serveur HTTP compatible OpenAI.

Superlinked : Framework Python et infrastructure cloud pour les ingénieurs IA construisant des applications de recherche et de recommandation hautes performances.

Fournissez des applications d'IA prêtes pour la production avec Myple. Agents d'IA et modèles RAG sécurisés et gérés sans souci.