Local Deep Researcher

Vue d'ensemble de Local Deep Researcher

Qu'est-ce que Local Deep Researcher ?

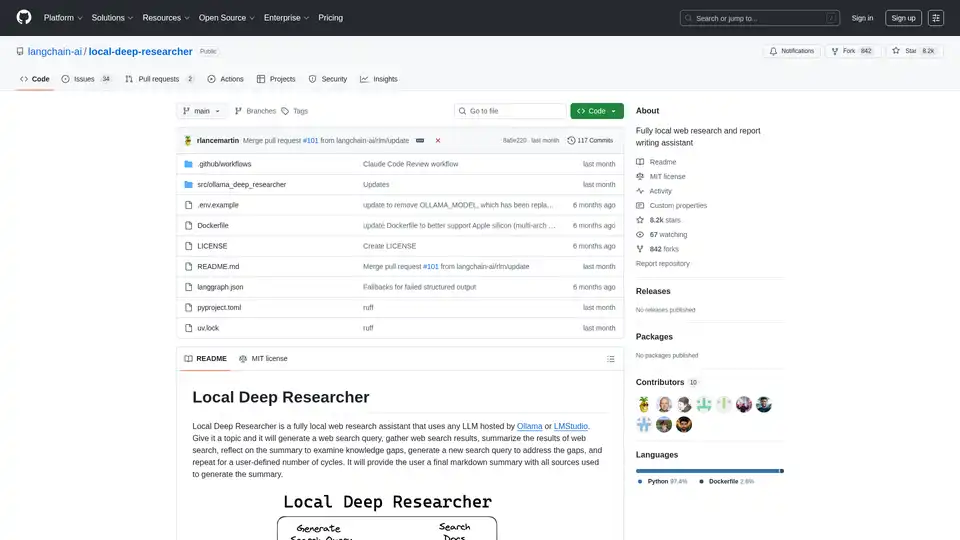

Local Deep Researcher est un assistant de recherche web innovant en open source conçu pour fonctionner entièrement localement sur votre machine. Cet outil puissant utilise des grands modèles de langage (LLMs) via Ollama ou LMStudio pour mener des recherches web complètes et générer des rapports détaillés avec des citations de sources appropriées.

Comment fonctionne Local Deep Researcher ?

Le système suit un processus de recherche itératif intelligent :

Processus de cycle de recherche:

- Génération de requêtes: Étant donné un sujet fourni par l'utilisateur, le LLM local génère une requête de recherche web optimisée

- Récupération de sources: Utilise des outils de recherche configurés (DuckDuckGo, SearXNG, Tavily ou Perplexity) pour trouver des sources en ligne pertinentes

- Résumé de contenu: Le LLM analyse et résume les résultats des recherches web

- Analyse des lacunes: Le système réfléchit au résumé pour identifier les lacunes de connaissances et les informations manquantes

- Affinement itératif: Génère de nouvelles requêtes de recherche pour combler les lacunes identifiées et répète le processus

- Génération du rapport final: Après plusieurs cycles (configurables par l'utilisateur), produit un rapport complet au format markdown avec toutes les sources correctement citées

Fonctionnalités et capacités principales

- Fonctionnement entièrement local: Tout le traitement se fait localement, garantissant la confidentialité et la sécurité des données

- Support multiple de LLMs: Compatible avec tout LLM hébergé via Ollama ou LMStudio

- Intégration flexible de recherche: Prend en charge les APIs de recherche DuckDuckGo (par défaut), SearXNG, Tavily et Perplexity

- Profondeur de recherche configurable: Les utilisateurs peuvent définir le nombre de cycles de recherche (par défaut : 3 itérations)

- Sortie structurée: Génère des rapports au format markdown bien formatés avec des citations de sources appropriées

- Surveillance visuelle du flux de travail: Intégré à LangGraph Studio pour la visualisation en temps réel du processus

Exigences techniques et configuration

Plateformes supportées:

- macOS (recommandé)

- Windows

- Linux via Docker

Composants requis:

- Python 3.11+

- Ollama ou LMStudio pour l'hébergement local de LLMs

- Clés API optionnelles pour les services de recherche premium

Installation et configuration

Processus de configuration rapide:

- Clonez le dépôt depuis GitHub

- Configurez les variables d'environnement dans le fichier .env

- Sélectionnez votre fournisseur de LLM préféré (Ollama ou LMStudio)

- Choisissez la configuration de l'API de recherche

- Lancez via LangGraph Studio

Déploiement Docker: Le projet inclut le support Docker pour le déploiement en conteneurs, bien qu'Ollama doive fonctionner séparément avec une configuration réseau appropriée.

Considérations de compatibilité des modèles

Le système nécessite des LLMs capables de produire une sortie JSON structurée. Certains modèles comme DeepSeek R1 (7B et 1.5B) peuvent avoir des limitations avec le mode JSON, mais l'assistant inclut des mécanismes de secours pour gérer ces cas.

Qui devrait utiliser Local Deep Researcher ?

Utilisateurs idéaux incluent:

- Chercheurs et universitaires ayant besoin de revues de littérature complètes

- Créateurs de contenu nécessitant des informations de fond bien recherchées

- Étudiants travaillant sur des documents de recherche et des devoirs

- Journalistes menant des recherches d'investigation

- Professionnels des affaires ayant besoin de recherches market et d'analyses concurrentielles

- Utilisateurs soucieux de la confidentialité qui préfèrent le traitement local aux solutions cloud

Applications pratiques et cas d'utilisation

- Recherche académique: Effectuer des revues de littérature et collecter des sources pour des articles

- Analyse de marché: Rechercher des concurrents et des tendances industrielles

- Recherche de contenu: Collecter des informations pour des articles de blog, articles et rapports

- Due diligence: Investiguer des sujets en profondeur avec une documentation appropriée des sources

- Apprentissage et éducation: Explorer des sujets en profondeur avec une assistance de recherche automatisée

Pourquoi choisir Local Deep Researcher ?

Avantages clés:

- Confidentialité complète: Vos sujets de recherche et données ne quittent jamais votre machine locale

- Rentable: Aucun coût d'API pour les fonctionnalités de recherche de base

- Personnalisable: Ajustez la profondeur de recherche et les sources selon vos besoins spécifiques

- Transparent: Visibilité complète du processus de recherche et des sources utilisées

- Open Source: Développement communautaire et améliorations continues

Obtenir les meilleurs résultats

Pour des performances optimales :

- Utilisez des modèles LLM plus grands et plus performants lorsque possible

- Configurez des APIs de recherche appropriées à vos besoins spécifiques

- Ajustez le nombre de cycles de recherche en fonction de la complexité du sujet

- Revérifiez manuellement les sources importantes pour les recherches critiques

Local Deep Researcher représente une avancée significative dans les outils de recherche locaux alimentés par l'IA, combinant la puissance des grands modèles de langage avec des capacités pratiques de recherche web tout en maintenant une confidentialité et un contrôle complets des données.

Meilleurs outils alternatifs à "Local Deep Researcher"

Reviewly est une plateforme de gestion des avis Google basée sur l'IA qui automatise la collecte et la réponse aux avis, améliorant ainsi la réputation en ligne. Il offre une configuration facile, des réponses générées par l'IA et des invitations par SMS pour une plus grande participation.

Alter est un assistant IA pour macOS qui s'intègre aux applications et automatise les tâches grâce à la voix et à l'IA intelligente. Il comprend votre flux de travail et privilégie la confidentialité grâce au traitement local des données chiffrées.

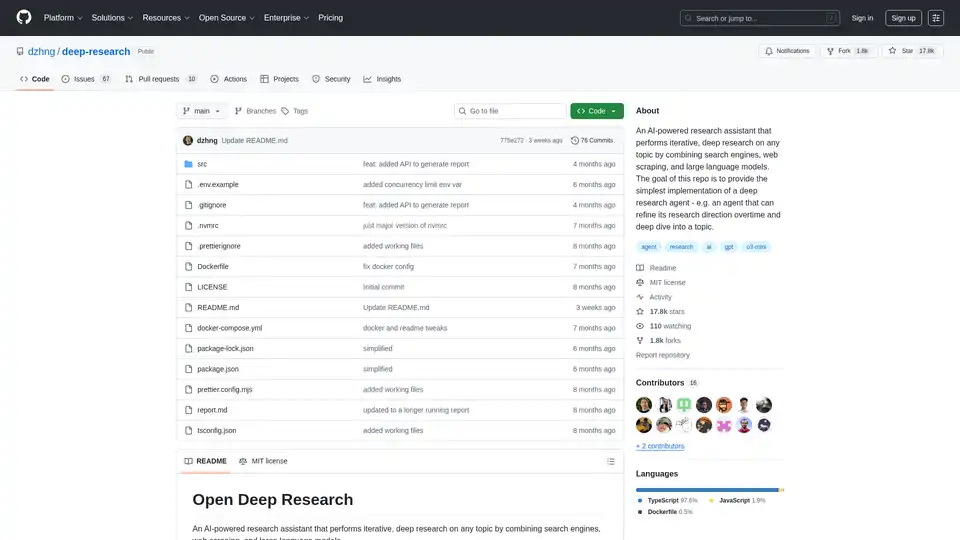

Deep Research est un assistant de recherche basé sur l’IA qui combine des moteurs de recherche, le web scraping et les LLM pour une recherche itérative et approfondie sur n’importe quel sujet. Simplifie les analyses approfondies grâce à la génération de requêtes intelligentes et à des rapports complets.

Transformez votre flux de travail avec BrainSoup ! Créez des agents IA personnalisés pour gérer les tâches et automatiser les processus via un langage naturel. Améliorez l'IA avec vos données tout en priorisant la confidentialité et la sécurité.

Discutez avec l'IA en utilisant vos clés API. Payez uniquement ce que vous utilisez. Prend en charge GPT-4, Gemini, Claude et autres LLMs. La meilleure interface de chat frontend LLM pour tous les modèles d'IA.

Learnitive Notepad est une application de prise de notes tout-en-un alimentée par l'IA pour créer des notes Markdown, du code, des photos, des pages web et plus. Boostez votre productivité avec 50 Go de stockage, une assistance IA illimitée et un support multi-appareils.

Transformez vos interactions IA avec Promptly AI. Créez de meilleurs prompts, accédez à notre bibliothèque curated et exportez des conversations entre ChatGPT, Claude, Perplexity, Gemini et Deepseek.

Découvrez Mindpool, la plateforme ultime pour interroger plusieurs modèles d'IA leaders comme ChatGPT et Gemini avec une seule invite, comparez les sorties pour des insights précis et boostez votre recherche, créativité et efforts marketing en toute sécurité.

AI Arkitechs est une plateforme tout-en-un alimentée par l'IA qui simplifie le marketing, le CRM et la génération de leads pour les entreprises. Automatisez les e-mails, gérez les réseaux sociaux, traitez les avis et plus pour gagner du temps et booster la croissance sans coûts élevés.

Chargez un CSV et analysez-le dans une interface visuelle étape par étape. Nettoyez, extrayez, résumez ou effectuez une analyse de sentiments avec votre agent AI personnel.

Otto SEO est une plateforme avancée alimentée par l'IA qui simplifie les stratégies SEO avec une génération de contenu automatisée, une personnalisation de marque et des intégrations fluides. Optimisez votre marketing numérique pour de meilleurs classements et une efficacité accrue.

Constructeur de sites web IA fait confiance par plus de 10 millions d'utilisateurs pour augmenter le trafic et surpasser la concurrence. Créez des sites web professionnels avec SEO automatisé, rédaction et sécurité en minutes.

TypingMind est une interface utilisateur de chat IA qui prend en charge GPT-4, Gemini, Claude et autres LLM. Utilisez vos clés API et ne payez que ce que vous utilisez. Meilleure interface utilisateur frontend LLM de chat pour tous les modèles d'IA.

Ghost Craft AI est un outil de création d'articles d'IA qui vous aide à créer des articles de blog optimisés pour le référencement à partir d'actualités tendances en quelques minutes. Commencez votre essai gratuit dès maintenant !