OpenUI

Vue d'ensemble de OpenUI

Qu'est-ce qu'OpenUI ?

OpenUI est un projet open-source innovant conçu pour révolutionner la façon dont les développeurs et les designers construisent des interfaces utilisateur. Hébergé sur GitHub par Weights & Biases (W&B), il permet aux utilisateurs de décrire des éléments d'UI à l'aide de prompts simples en langage naturel, alimentés par de grands modèles de langage (LLMs), et de les voir rendus en direct instantanément dans le navigateur. Que vous brainstormiez des idées ou prototypiez des applications, OpenUI transforme des descriptions imaginatives en code UI fonctionnel, compatible avec des sorties comme HTML, des composants React, Svelte ou même des Web Components. Cet outil est particulièrement précieux à l'ère de l'IA générative, où l'itération rapide est la clé de l'innovation.

Contrairement aux alternatives propriétaires, OpenUI est entièrement open-source sous la licence Apache-2.0, permettant à quiconque de forker, modifier ou contribuer à son développement. Il a déjà accumulé plus de 21,7 k étoiles et 2 k forks sur GitHub, reflétant un fort intérêt communautaire pour la génération d'UI assistée par IA. Au cœur d'OpenUI, les LLMs comblent l'écart entre les idées conceptuelles et le code exécutable, rendant le développement d'UI plus accessible et amusant.

Comment fonctionne OpenUI ?

OpenUI opère en s'intégrant à divers fournisseurs de LLM pour traiter vos descriptions textuelles et générer le balisage UI correspondant. Voici un aperçu de son mécanisme sous-jacent :

Traitement d'entrée : Vous commencez par taper une description dans l'interface web, comme « un formulaire de connexion moderne avec des champs email et mot de passe, stylisé en Tailwind CSS. » L'outil envoie ce prompt au backend LLM sélectionné.

Génération LLM : En utilisant des modèles d'OpenAI (par exemple, GPT-4o), Groq, Gemini, Anthropic (Claude) ou même des options locales comme Ollama et des services compatibles avec LiteLLM, l'IA interprète le prompt et produit du code structuré. Il prend en charge les entrées multimodales si vous utilisez des modèles avec vision comme LLaVA.

Rendu en direct : Le code généré est immédiatement rendu dans un panneau de prévisualisation en direct. Vous pouvez itérer en demandant des changements, comme « ajouter un lien mot de passe oublié » ou « convertir en composants React. »

Export et conversion de code : Au-delà du rendu, OpenUI peut transformer la sortie en différents frameworks. Par exemple, il pourrait générer d'abord du HTML/CSS/JS vanilla, puis le convertir en React ou Svelte sur demande. Cette flexibilité est alimentée par des scripts Python dans le backend et du code TypeScript dans le frontend.

L'architecture inclut un backend Python pour les interactions avec les LLM via LiteLLM (un proxy unifié pour des centaines de modèles) et un frontend basé sur TypeScript pour l'UI interactive. Les variables d'environnement gèrent les clés API de manière sécurisée, assurant une intégration fluide sans coder en dur des données sensibles. Pour les configurations locales, il utilise des outils comme uv pour la gestion des dépendances et Docker pour le déploiement conteneurisé.

En termes de détails techniques, la structure du repo d'OpenUI sépare le frontend (similaire à React avec Vite) et le backend (inspiré de FastAPI), avec des actifs pour les démos et les docs. Les mises à jour récentes incluent le support i18n, les configurations d'endpoints personnalisés et l'intégration de l'éditeur Monaco pour les ajustements de code — démontrant son évolution vers des fonctionnalités plus robustes.

Comment utiliser OpenUI ?

Se lancer avec OpenUI est simple, que vous l'exécutiez localement ou via une démo. Suivez ces étapes pour des résultats optimaux :

Accéder à la démo : Rendez-vous sur la démo en direct à openui.fly.dev pour tester sans configuration. Décrivez une UI, sélectionnez un modèle (si les clés API sont configurées) et regardez-la se rendre.

Installation locale via Docker (Recommandé pour les débutants) :

- Assurez-vous que Docker est installé.

- Définissez vos clés API :

export OPENAI_API_KEY=your_key_here(et d'autres comme ANTHROPIC_API_KEY si nécessaire). - Pour l'intégration Ollama : Installez Ollama localement, téléchargez un modèle (par exemple,

ollama pull llava) et exécutez :docker run --rm -p 7878:7878 -e OPENAI_API_KEY -e OLLAMA_HOST=http://host.docker.internal:11434 ghcr.io/wandb/openui. - Visitez http://localhost:7878 pour commencer à générer des UIs.

Depuis la source (Pour les développeurs) :

- Clonez le repo :

git clone https://github.com/wandb/openui. - Naviguez vers le backend :

cd openui/backend. - Installez les dépendances :

uv sync --frozen --extra litellm(uv est un gestionnaire de paquets Python rapide). - Activez l'environnement virtuel :

source .venv/bin/activate. - Définissez les clés API et exécutez :

python -m openui. - Pour le mode dev avec frontend : Exécutez

npm run devdans le répertoire frontend pour un rechargement à chaud.

- Clonez le repo :

Configurations avancées :

- Proxy LiteLLM personnalisé : Créez un fichier

litellm-config.yamlpour surcharger les endpoints de modèles, utile pour les configurations auto-hébergées comme LocalAI. - Ollama pour une utilisation hors ligne : Définissez

OLLAMA_HOSTpour pointer vers votre instance (par exemple, http://127.0.0.1:11434). Des modèles comme LLaVA permettent des prompts basés sur des images. - Gitpod ou Codespaces : Pour le dev basé sur le cloud, ces outils préconfigurent l'environnement — idéal pour tester sans matériel local.

- Proxy LiteLLM personnalisé : Créez un fichier

Astuces pour de meilleurs résultats : Utilisez des prompts descriptifs avec des spécificités (par exemple, « navbar responsive avec des classes Tailwind »). Si la génération ralentit, optez pour des modèles plus rapides comme Groq. L'outil détecte automatiquement les modèles disponibles à partir de vos variables d'environnement, peuplant le modal des paramètres en conséquence.

Pourquoi choisir OpenUI ?

Dans un champ encombré d'outils IA, OpenUI se distingue par son ethos open-source et son focus sur la génération spécifique d'UI. La construction d'UI traditionnelle implique souvent un wireframing fastidieux et du codage, mais OpenUI accélère cela avec l'IA générative, réduisant le temps de prototypage de heures à minutes. Il n'est pas aussi poli que des outils commerciaux comme v0, mais sa transparence permet la personnalisation — parfait pour les équipes intégrant des LLMs dans leurs workflows.

Avantages clés :

- Large support de modèles : Fonctionne avec plus de 100 LLMs via LiteLLM, des APIs cloud à l'inférence locale.

- Agnostique de frameworks : Produit du code adaptable pour HTML, React, Svelte, etc., réduisant le verrouillage de fournisseurs.

- Dirigé par la communauté : GitHub actif avec 205 commits, redéfinitions récentes et contributions de plus de 20 développeurs.

- Économique : Gratuit à exécuter localement ; ne payez que pour l'usage API si vous utilisez des LLMs payants.

- Valeur éducative : Excellent pour apprendre comment les LLMs gèrent la génération de code, avec une logique backend transparente.

Les utilisateurs louent sa nature amusante et itérative — idéale pour stimuler la créativité sans friction de configuration. Par exemple, les designers peuvent visualiser des idées rapidement, tandis que les développeurs déboguent les sorties IA dans l'éditeur Monaco.

Pour qui est OpenUI ?

OpenUI cible un public diversifié dans l'espace IA et développement :

- Designers UI/UX : Prototyper rapidement des interfaces à partir d'esquisses ou d'idées, validant des concepts avant une implémentation complète.

- Développeurs frontend : Générer du code boilerplate pour des composants stylisés avec Tailwind, accélérant les projets React ou Svelte.

- Enthousiastes et chercheurs IA : Expérimenter avec des applications LLM dans la génération d'UI, surtout avec des modèles ouverts comme ceux d'Ollama.

- Équipes produit dans les startups : Prototyper des MVPs de manière abordable, en s'intégrant à l'écosystème de W&B pour la construction d'apps ML.

- Éducateurs et étudiants : Enseigner les concepts d'IA générative via la création d'UI pratique.

Il est particulièrement adapté à ceux familiers avec les outils de ligne de commande basiques, bien que l'option Docker abaisse la barrière. Si vous construisez des apps alimentées par LLM, OpenUI sert d'exemple pratique de développement augmenté par IA.

Valeur pratique et cas d'usage

L'utilité réelle d'OpenUI brille dans les scénarios exigeant des itérations rapides :

Prototypage rapide : Décrivez un tableau de bord et obtenez un mockup interactif en direct — ajustez via des raffinements similaires à un chat.

Génération de snippets de code : Besoin d'un formulaire responsive ? Prompt, copiez le code React et intégrez-le dans votre app.

Tests d'accessibilité : Générez des UIs et évaluez l'adhésion de l'IA aux meilleures pratiques comme le HTML sémantique.

Design collaboratif : Partagez des prompts en équipe pour des visions d'UI cohérentes.

Des retours d'utilisateurs sur les issues GitHub (63 ouvertes), les améliorations courantes incluent un meilleur gestion d'erreurs et un support multi-pages, indiquant une croissance active. Tarification ? Entièrement gratuit en open-source, bien que les coûts LLM s'appliquent (par exemple, tokens OpenAI).

En résumé, OpenUI démocratise la création d'UI via l'IA générative, favorisant l'efficacité et l'innovation. Pour la meilleure expérience, explorez les docs du repo et contribuez — c'est un projet vibrant qui repousse les limites de l'IA dans le design.

Meilleurs outils alternatifs à "OpenUI"

GitHub Next explore l'avenir du développement logiciel en protégeant des outils et des technologies qui modifieront notre métier. Ils identifient de nouvelles approches pour constituer des équipes d'ingénierie logicielle saines et productives.

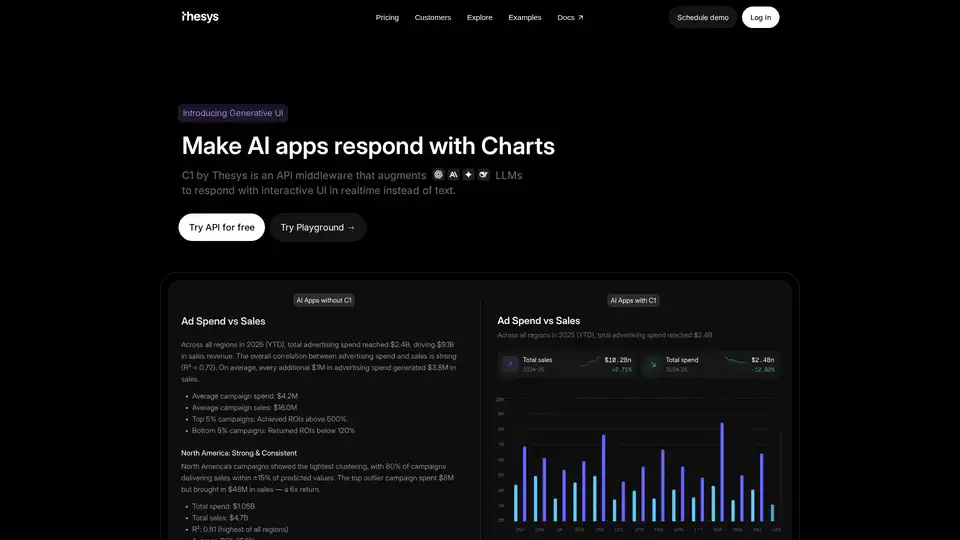

C1 par Thesys est un middleware API qui augmente les LLM pour répondre avec une interface utilisateur interactive en temps réel au lieu de texte, transformant les réponses de votre modèle en interfaces en direct à l'aide de React SDK.

AI Runner est un moteur d'inférence d'IA hors ligne pour l'art, les conversations vocales en temps réel, les chatbots alimentés par LLM et les flux de travail automatisés. Exécutez la génération d'images, le chat vocal et plus encore localement !

KoboldCpp : Exécutez facilement des modèles GGUF pour la génération de texte et d'images IA avec une interface utilisateur KoboldAI. Fichier unique, installation zéro. Prend en charge CPU/GPU, STT, TTS et Stable Diffusion.

Créez des apps alimentées par l'IA et des agents IA qui planifient et exécutent automatiquement vos tâches. Construisez vos apps IA full-stack et monétisez-les avec le framework de développement d'apps GenAI flexible de Momen. Commencez aujourd'hui !

Discutez avec l'IA en utilisant vos clés API. Payez uniquement ce que vous utilisez. Prend en charge GPT-4, Gemini, Claude et autres LLMs. La meilleure interface de chat frontend LLM pour tous les modèles d'IA.

MotionAgent est un outil IA open-source qui transforme les idées en films en mouvement en générant des scripts, des images fixes de films, des vidéos haute résolution et une musique de fond personnalisée avec des modèles comme Qwen-7B-Chat et SDXL.

Soverin est le marché ultime d'IA pour découvrir, acheter et exploiter les meilleures apps et agents d'IA. Automatisez plus de 10 000 tâches, de la construction d'agents à l'extension du support client, et boostez la productivité avec des outils d'automatisation tendance.

TemplateAI est le modèle NextJS leader pour les apps IA, avec authentification Supabase, paiements Stripe, intégration OpenAI/Claude et composants AI prêts à l'emploi pour un développement full-stack rapide.

Roo Code est un assistant de codage open-source propulsé par IA pour VS Code, avec des agents IA pour l'édition multi-fichiers, le débogage et l'architecture. Il prend en charge divers modèles, assure la confidentialité et se personnalise pour un développement efficace.

Créez un chatbot IA pour le support client et la génération de leads en utilisant des contenus de site web, PDF, mots, texte, etc., alimenté par ChatGPT et le grand modèle de langage LLaMa 3.

Rierino est une plateforme low-code puissante qui accélère l'ecommerce et la transformation numérique avec des agents IA, un commerce composable et des intégrations fluides pour une innovation évolutive.

Devika AI est un ingénieur logiciel IA open source qui comprend les instructions de haut niveau, les décompose, effectue des recherches et génère du code à l'aide de Claude 3, GPT-4, GPT-3.5 et des LLM locaux.

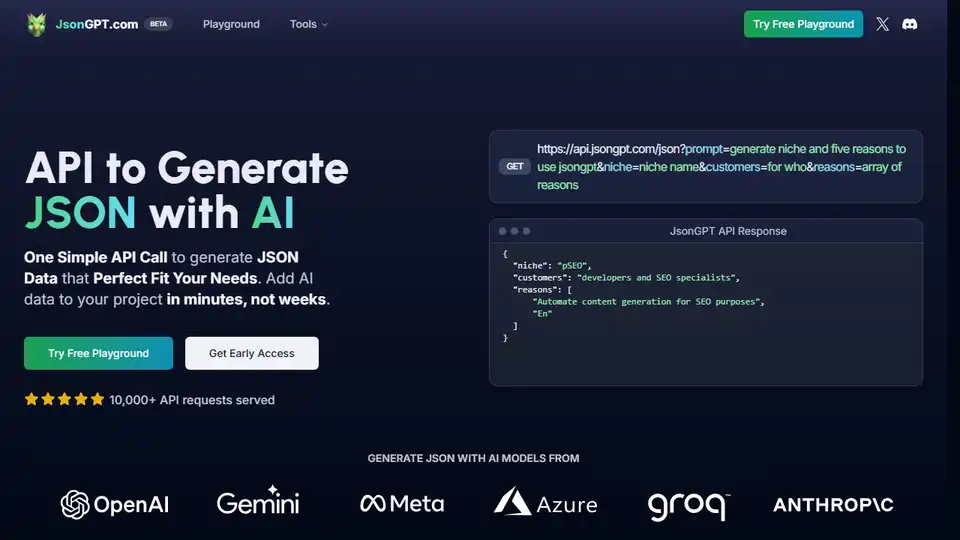

JsonGPT est une API d'IA qui simplifie la génération de données JSON à l'aide d'OpenAI. Il offre des fonctionnalités telles que la validation JSON, la mise en cache et la diffusion en continu pour accélérer le développement et réduire les coûts.