AniPortrait の概要

AniPortrait とは?

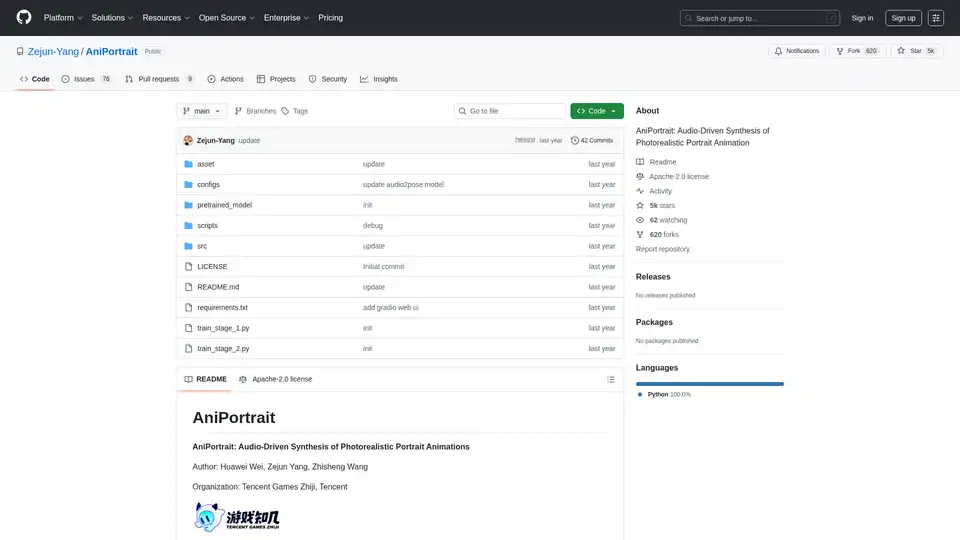

AniPortrait は、オーディオ駆動のフォトリアリスティックなポートレートアニメーション合成のための革新的なオープンソースフレームワークです。Huawei Wei、Zejun Yang、Zhisheng Wang によって Tencent Games Zhiji および Tencent で開発されたこのツールは、高度な AI 技術を活用して、単一の参照画像とオーディオまたはビデオ入力から高品質のアニメーテッドポートレートを作成します。静的なポートレートをスピーチオーディオでアニメートしたり、ソースビデオから顔の表情を再現したりする場合、AniPortrait は唇同期や頭部の動きなどの微妙なニュアンスを捉えたリアルな結果を提供します。コンテンツクリエイター、ゲーム開発者、コンピュータビジョンの研究者にとって理想的で、AI ビデオ生成ツールの分野でポートレート特化のアニメーションに焦点を当てて際立っています。

GitHub で Apache-2.0 ライセンスの下でリリースされ、AniPortrait は AI コミュニティで 5,000 以上のスターを集め、その人気を反映しています。プロジェクトはアクセシビリティを重視し、事前訓練モデル、詳細なインストールガイド、簡単なテストのための Gradio Web UI を提供しています。

AniPortrait の仕組み

その核心では、AniPortrait は拡散モデル、オーディオ処理、ポーズ推定を統合した多段階パイプラインを採用してアニメーションを生成します。このフレームワークは、Stable Diffusion V1.5 や wav2vec2 などの確立されたモデルを特徴抽出に基盤とし、オーディオビジュアル同期の堅牢な処理を確保します。

主要コンポーネントとワークフロー

- 入力処理: 参照ポートレート画像から開始します。オーディオ駆動モードでは、wav2vec2-base-960h を使用してオーディオ入力を処理し、スピーチ特徴を抽出します。ビデオモードでは、キー点抽出によりソースビデオをポーズシーケンスに変換します。

- ポーズ生成: audio2pose モデルがオーディオから頭部ポーズシーケンス(例: pose_temp.npy)を生成し、顔の向きを制御します。顔再現の場合、ポーズリターゲティング戦略がソースビデオの動きを参照画像にマッピングし、大きなポーズ差をサポートします。

- アニメーション合成: デノイジング UNet、参照 UNet、モーションモジュールを使用してフレームを合成します。ポーズガイダーがアライメントを確保し、オプションのフレーム補間が推論を加速します。

- 出力洗練: 512x512 などの解像度でビデオを生成し、film_net_fp16.pt を使用した加速オプションで処理時間を短縮します。

このモジュール式アプローチにより、自己駆動アニメーション(事前定義ポーズ使用)、顔再現(表情転送)、完全オーディオ駆動合成が可能で、さまざまな AI ポートレートアニメーションシナリオに適応します。

AniPortrait のコア機能

AniPortrait は、現実的なポートレートアニメーションに特化した強力な機能群を備えています:

- オーディオ駆動ポートレートアニメーション: オーディオ入力に唇の動きと表情を同期し、吹き替えや仮想アバターに最適です。

- 顔再現: ソースビデオの顔のパフォーマンスをターゲットポートレートに転送し、メディアでのディープフェイク風の倫理的アプリケーションに理想的です。

- ポーズ制御とリターゲティング: 更新された戦略で多様な頭部ポーズを扱い、カスタムポーズファイルの生成で精密制御をサポートします。

- 高解像度出力: フォトリアリスティックなビデオを生成し、長シーケンス(300 フレーム以上)をサポートします。

- 加速オプション: フレーム補間と FP16 モデルで推論を高速化し、品質を犠牲にしません。

- Gradio Web UI: クイックデモのためのユーザー友好インターフェースで、Hugging Face Spaces でオンラインアクセス可能。

- 事前訓練モデル: audio2mesh、audio2pose、拡散コンポーネントのウェイトを含み、Wisemodel などのソースからダウンロード可能。

これらの機能により、AniPortrait は AI 駆動ビデオ合成の定番ツールとなり、ポートレートの忠実度とオーディオビジュアルの一貫性に焦点を当てて基本ツールを上回ります。

インストールとセットアップ

Python >=3.10 と CUDA 11.7 を使用するユーザーにとって、開始は簡単です:

- リポジトリをクローン:

git clone https://github.com/Zejun-Yang/AniPortrait。 - 依存関係をインストール:

pip install -r requirements.txt。 - 事前訓練ウェイトを

./pretrained_weights/にダウンロード、Stable Diffusion コンポーネント、wav2vec2、カスタムモデル如denoising_unet.pthとaudio2pose.ptを含む。 - README のディレクトリ構造に従ってファイルを整理。

トレーニングのため、VFHQ や CelebV-HQ などのデータセットを準備し、キー点を抽出してプリプロセッシングスクリプトを実行。Accelerate を使用した分散処理で 2 段階のトレーニングを行います。

AniPortrait の使い方

推論モード

AniPortrait はコマンドラインスクリプト経由で 3 つの主要モードをサポートします:

自己駆動アニメーション:

python -m scripts.pose2vid --config ./configs/prompts/animation.yaml -W 512 -H 512 -acc参照画像やポーズビデオでカスタマイズ。ビデオをポーズに変換:

python -m scripts.vid2pose --video_path input.mp4。顔再現:

python -m scripts.vid2vid --config ./configs/prompts/animation_facereenac.yaml -W 512 -H 512 -accYAML を編集してソースビデオと参照を追加。

オーディオ駆動合成:

python -m scripts.audio2vid --config ./configs/prompts/animation_audio.yaml -W 512 -H 512 -accコンフィグにオーディオと画像を追加。pose_temp を削除して audio2pose を有効にし、自動ポーズ生成。

頭部ポーズ制御のため、python -m scripts.generate_ref_pose で参照ポーズを生成。

Web デモ

Gradio UI を起動:python -m scripts.app。または Hugging Face Spaces のオンライン版を試す。

ユーザーは 'cxk.mp4' や 'jijin.mp4' などのサンプルビデオでオーディオ同期を実験可能、こうしたサンプルは Bilibili などのプラットフォームから来ています。

ゼロから AniPortrait をトレーニング

上級ユーザーはカスタムモデルをトレーニング可能:

- データ準備: データセットをダウンロード、

python -m scripts.preprocess_datasetでプリプロセスし、JSON パスを更新。 - ステージ 1:

accelerate launch train_stage_1.py --config ./configs/train/stage1.yaml。 - ステージ 2: モーションモジュールウェイトをダウンロード、ステージ 1 チェックポイントを指定し、

accelerate launch train_stage_2.py --config ./configs/train/stage2.yamlを実行。

このプロセスはポートレート特化データで微調整し、AI アニメーションタスクの汎用性を向上させます。

なぜ AniPortrait を選ぶか?

AI ビデオ生成ツールの混雑した分野で、AniPortrait はフォトリアリスティックなポートレートへの特化で優れています。一般目的モデルとは異なり、オーディオリップシンクと微妙な表情を精密に扱い、顔アニメーションの偽影を低減します。オープンソースの性質がカスタマイズを可能にし、2024 年 4 月の audio2pose リリースや加速モジュールなどの最近の更新が最先端を維持します。EMO や AnimateAnyone などのプロジェクトへのコミュニティの感謝がその協力的なルーツを強調し、信頼性の高いパフォーマンスを確保します。

実用的価値には、仮想インフルエンサー、教育ビデオ、ゲームアセットの高速プロトタイピングが含まれます。arXiv 論文(eprint 2403.17694)の利用可能性により、コンピュータビジョンでのオーディオビジュアル合成を探求する研究者に役立ちます。

AniPortrait は誰向けか?

- コンテンツクリエイターと映画製作者: ショートフォームビデオのクイック吹き替えや表情転送に。

- Tencent 風スタジオのゲーム開発者: インタラクティブメディアへのアニメーテッドポートレート統合。

- AI 研究者: 拡散ベースアニメーションとポーズリターゲティングの実験。

- 趣味家と教育者: 重いセットアップなしで Web UI を使用して AI 概念を教える。

オーディオ駆動ポートレートアニメーションを作成する最高の方法を探しているなら、AniPortrait の品質、速度、アクセシビリティのバランスがトップチョイスにします。

潜在的なアプリケーションとユースケース

- 仮想アバター: ソーシャルメディアやメタバース向けに同期スピーチでデジタルキャラクターをアニメート。

- 教育ツール: 講義やチュートリアル向けのトーキングヘッドビデオ生成。

- メディア制作: 歴史再現や広告のための倫理的顔再現。

- 研究プロトタイピング: CV 論文でのオーディオtoビデオモデルのベンチマーク。

デモンストレーションには 'solo.mp4' のような自己駆動クリップと 'kara.mp4' のようなオーディオ例が含まれ、無縫の統合を示します。

トラブルシューティングのため、GitHub の 76 のオープンイシューを確認するか、プルリクエストで貢献。全体として、AniPortrait は信頼性が高く高忠実度の結果で AI ポートレートアニメーションの限界を押し広げるユーザーをエンパワーします。

"AniPortrait" のベストな代替ツール

Lip Sync AIは、高度なAIリップシンク技術を使用して、静止写真をトーキングビデオに変換します。写真とオーディオファイルをアップロードして、自然な表情でリアルなリップシンクビデオを生成します。

Media.io は、ビデオ、画像、オーディオ作成のためのオールインワン AI プラットフォームです。AI ビデオ ジェネレーター、画像からビデオ、テキストから音楽、ウォーターマーク削除などのツールを提供し、個人用と商用利用の両方に対応します。

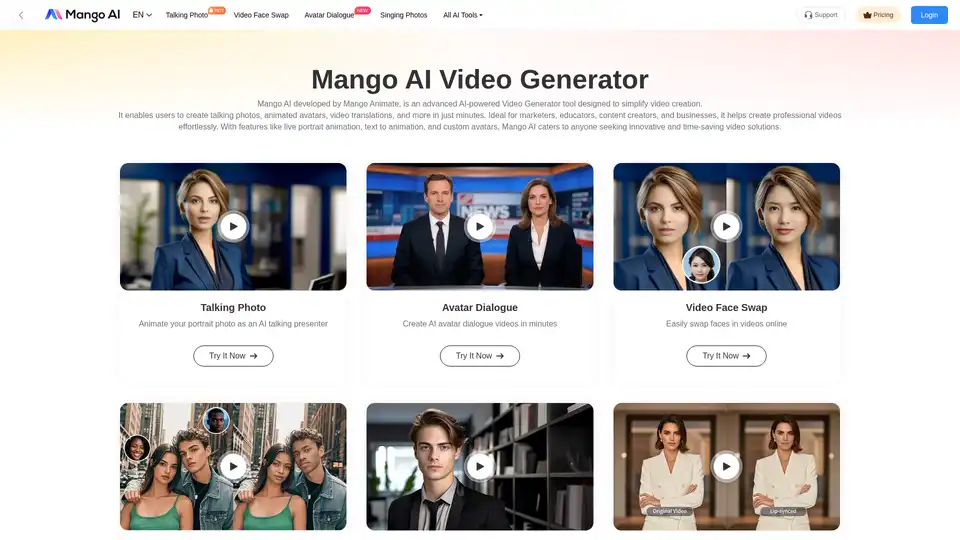

Mango AIは、AIを利用したビデオジェネレーターで、トーキングフォト、アバター、顔交換を簡単に作成できます。マーケター、教育者、コンテンツクリエイターに最適です。

HitPaw AI Marvelsは、高度なAI技術を使用して写真や動画を変換するオールインワンモバイルアプリです。AIダンス動画、アニメフィルター、オブジェクト除去、写真修復、スタイル変換などの機能をワンクリック編集で提供します。

AIVidlyはiPhone向けのオールインワンAIビデオメーカーアプリで、テキストをAIボイスオーバー、エフェクト、TikTokやYouTube Shorts向け最適化のプロフェッショナルビデオに変換します。編集スキル不要。

PICOAI.app は、最先端の AI ツールを提供し、驚くべき画像とビデオを生成します。最新の生成 AI モデルを使用して、簡単にプロフェッショナルなコンテンツを作成。

Wan 2.2 AIを発見してください。これは、映画級コントロール、专业的なモーション、720p解像度でのテキスト-to-ビデオおよび画像-to-ビデオ生成のための最先端プラットフォームです。高品質のAIビデオツールを求めるクリエイター、マーケター、プロデューサーに最適です。

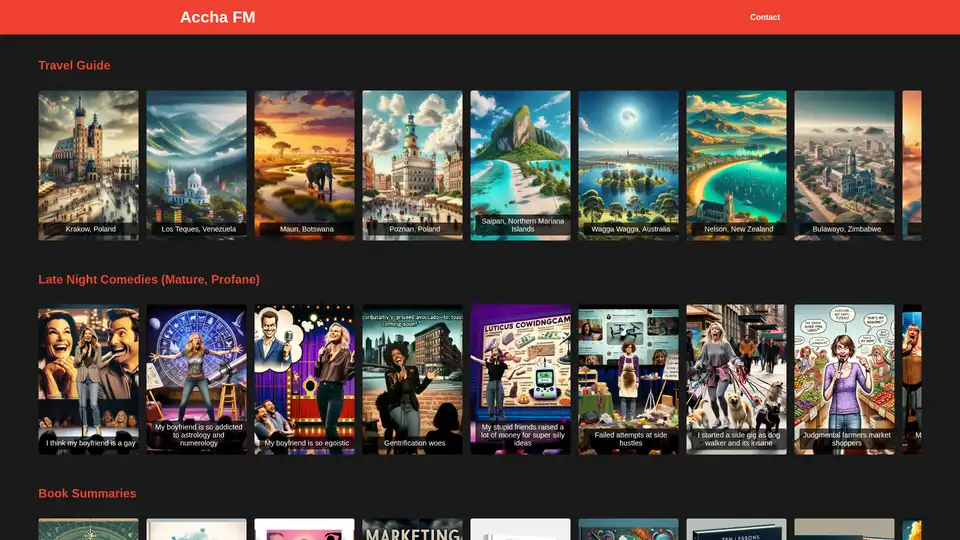

Accha FMを探求せよ、世界初のAI駆動オーディオエンターテイメントスーパーアプリで、コメディ、書籍要約、楽しい教育、ミステリー、レシピ、伝記、子供向けストーリー、ガイド付き瞑想を提供し、いつでもどこでも没入型リスニング体験を。

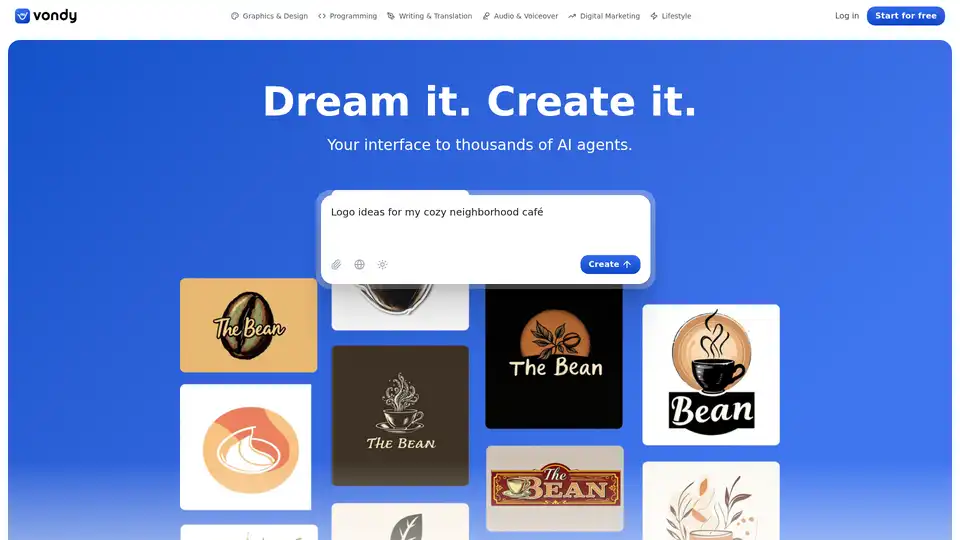

Vondyは、革命的なAIプラットフォームで、ロゴ、アート、執筆、オーディオなどの数千のジェネレーターを即座に作成します。100万人以上のクリエイターに参加して、夢見て、構築し、デジタル資産を簡単に洗練しましょう。

VidHexは、Video EnhancerなどのさまざまなAIビデオツールを統合し、効率的かつ簡単にコンテンツを改善し、視覚体験を最適化します。1クリックでぼやけた動画を高品質なビジュアルに変身させます。

Clipticsは、画像編集、テキスト読み上げ、背景除去、コンテンツ作成のための無料のAIツールを提供しています。サインアップ不要、ウォーターマークなし。画像を強化し、ボイスオーバーを生成し、コンテンツを簡単に作成します。

UniFab AIは、ビデオとオーディオの品質を向上させるAI搭載ソリューションです。ビデオ/オーディオエンハンサー、コンバーター、エディターなどの機能を備えています。16Kへのアップスケール、ノイズリダクション、カラーライズなど。

Rapport Softwareは、リアルタイムのインタラクティブな体験のためにAI生成されたキャラクターアニメーションを提供します。信じられるAI駆動のデジタルキャラクターでエンゲージメントを最大化します。

CREATUS.AIは、AIネイティブワークスペースと自律型チームメンバーを提供し、中小企業が生産性を向上させ、リソースコストを最適化するためのAI機能を統合します。無料のAIツールを試して、Canva、Notion、Zapierなどのアプリと統合します。