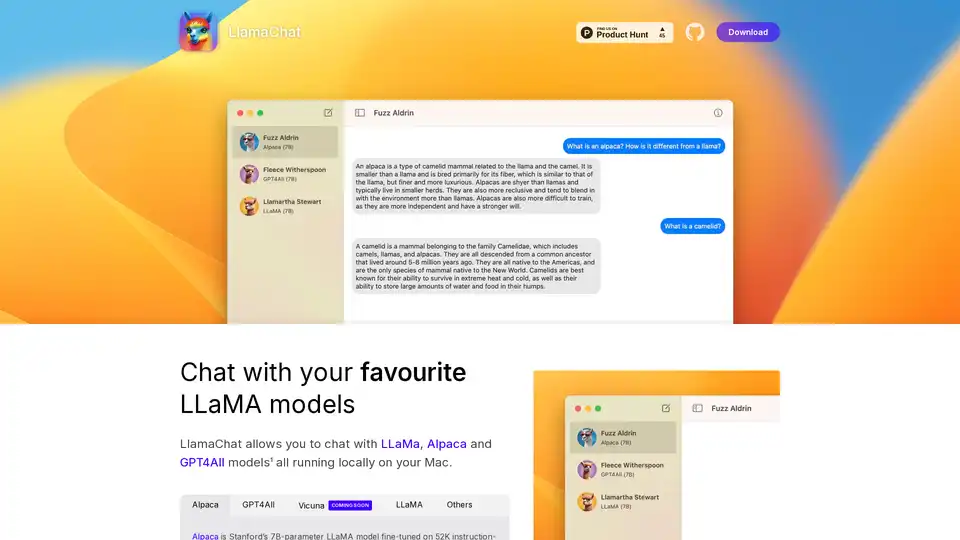

LlamaChat の概要

LlamaChat: MacでローカルのLLaMAモデルとチャット

LlamaChatとは? LlamaChatは、クラウドベースのサービスに頼らずに、LLaMA、Alpaca、GPT4Allなどのさまざまな大規模言語モデル(LLM)とMac上で直接やり取りできるmacOSアプリケーションです。これは、モデルがローカルで実行されることを意味し、強化されたプライバシーと制御を提供します。

主な機能

- ローカルLLMサポート: LlamaChatは、LLaMA、Alpaca、GPT4Allを含む複数のLLMをサポートしており、これらはすべてMac上でローカルに実行されます。

- モデル変換: LlamaChatは、生のPyTorchモデルチェックポイントまたは事前に変換された.ggmlモデルファイルをインポートして、使いやすくすることができます。

- オープンソース: llama.cppやllama.swiftなどのオープンソースライブラリを利用しており、透明性とコミュニティ主導の開発を保証します。

- 無料およびオープンソース: LlamaChatは完全に無料かつオープンソースであり、アクセシビリティとコミュニティの貢献を保証します。

サポートされているモデル

- Alpaca: OpenAIのtext-davinci-003から生成された52Kの指示追跡デモンストレーションでファインチューニングされた、スタンフォード大学の7BパラメータLLaMAモデル。

- GPT4All: オープンソースのLLM。

- Vicuna: オープンソースのLLM。

- LLaMA: Metaの基盤LLM。

LlamaChatの仕組み

LlamaChatは、オープンソースライブラリを利用してLLMをマシン上で直接実行します。これはllama.cppとllama.swiftを使用して構築されています。これにより、生のPyTorchモデルチェックポイントまたは事前に変換された.ggmlモデルファイルを変換およびインポートできます。

LlamaChatの使い方

- ダウンロード: 公式ウェブサイトまたは

brew install --cask llamachatを使用してLlamaChatをダウンロードします。 - インストール: macOS 13以降にアプリケーションをインストールします。

- モデルのインポート: LLaMA、Alpaca、またはGPT4Allモデルをアプリケーションにインポートします。

- チャット: お気に入りのLLMモデルとローカルでチャットを開始します。

LlamaChatを選ぶ理由

- プライバシー: データを外部サーバーに送信せずに、ローカルでモデルを実行します。

- 制御: 使用するモデルとデータを完全に制御できます。

- 費用対効果: サブスクリプション料金や使用料はかかりません。

- オープンソース: コミュニティ主導の改善と透明性の恩恵を受けられます。

LlamaChatは誰のため?

LlamaChatは以下に最適です。

- 開発者: ローカルマシンでLLMを試している。

- 研究者: 外部サービスに依存せずに研究を行っている。

- プライバシーを重視するユーザー: データをローカルでプライベートに保ちたいユーザー。

インストール

LlamaChatは以下からインストールできます。

- ダウンロード: プロジェクトのGitHubページまたはProduct Huntから直接ダウンロード。

- Homebrew: コマンド

brew install --cask llamachatを使用。

オープンソースライブラリ

LlamaChatは以下に基づいて構築されています。

- llama.cpp: CPU上でのLLMの効率的な推論のため。

- llama.swift: LLM用のネイティブmacOSインターフェースの提供。

免責事項

LlamaChatは、Meta Platforms, Inc.、Leland Stanford Junior University、またはNomic AI, Inc.とは提携していません。ユーザーは、プロバイダーが定めるそれぞれの条件に従って、適切なモデルファイルを取得して統合する責任があります。

"LlamaChat" のベストな代替ツール

Private LLMは、オフラインで動作するiOSおよびmacOS用のローカルAIチャットボットであり、情報を完全にデバイス上に保持し、安全かつプライベートに保ちます。 iPhone、iPad、Macで検閲されていないチャットをお楽しみください。

120 AI Chatは、最大120FPSの驚異的なパフォーマンスを備えたAI搭載のネイティブアプリを提供します。複数のAIモデルをサポートし、マルチスレッドや開発者向けに最適化されたインターフェースなどの機能を提供します。

Nexa SDK は、LLM、マルチモーダル、ASR および TTS モデルの高速かつプライベートなデバイス上 AI 推論を可能にします。NPU、GPU、CPU を介して、モバイル、PC、自動車、IoT デバイスに本番環境対応のパフォーマンスでデプロイ。

FridayGPTは、Mac用のAIコパイロットであり、ChatGPT、Claude、その他のLLMにすぐにアクセスできます。Whisperを搭載した音声テキスト変換やワンクリックAIアクションなどの機能により、生産性が向上します。

Enclave AIは、完全にオフラインで動作するiOSおよびmacOS用のプライバシー重視のAIアシスタントです。インターネット接続を必要とせずに、ローカルLLM処理、安全な会話、ボイスチャット、ドキュメントインタラクションを提供します。

BrainSoupでワークフローを変革!自然言語でカスタムAIエージェントを作成し、タスクを処理し、プロセスを自動化します。データでAIを強化し、プライバシーとセキュリティを優先します。

Remind AI は、オープンソースのローカル人工記憶ツールで、先进的な AI を使用してデジタル活動をキャプチャし、クラウド依存なしで生産性を向上させます。ダウンロードして個人用にカスタマイズしてください。

Agent TARS は、オープンソースのマルチモーダル AI エージェントで、ブラウザ操作、コマンドライン、ファイルシステムをシームレスに統合し、ワークフロー自動化を強化します。高度な視覚解釈と洗練された推論でタスクを効率的に処理します。

Essential はオープンソースの MacOS アプリで、画面の AI 共同パイロットとして機能し、開発者がエラーを即座に修正し、要約とスクリーンショットで重要なワークフローを記憶します—データはデバイスを離れません。

GrammarBotは、オフラインで動作するMacOS用のAI搭載の文法およびスペルチェッカーです。アプリとAIモデルを一度ダウンロードするだけで、英語力を永久に向上させることができます。個人ライセンスは12ドルです。

AnythingLLMは、ドキュメントとチャットしたり、生産性を向上させたり、最先端のLLMをローカルおよびプライベートで実行したりできるオールインワンAIアプリケーションです。セットアップなしでAIエージェントとカスタムモデルを活用できます。

LM Studio:Llama、MPT、Gemma、その他のLLMをローカルのラップトップで実行します。 Hugging Faceから互換性のあるモデルをダウンロードして、オフラインで使用します。

RecurseChat:ローカルAIと対話できるパーソナルAIアプリ。オフライン対応で、PDFやmarkdownファイルとのチャットも可能です。

MacCopilot:macOS用ネイティブCopilot AI。GPT-4o、ClaudeAI、Google Geminiを使用して、あらゆる画面コンテンツと対話します。