local.ai の概要

ローカル AI プレイグラウンド:オフライン AI 実験へのゲートウェイ

Local AI Playground とは?

Local AI Playground は、local.ai を搭載した、無料でオープンソースのネイティブアプリケーションであり、GPU がなくてもローカルで AI モデルの実験プロセスを簡素化するように設計されています。オフラインで、プライベートに AI 推論を実行でき、初心者から上級者まで、合理化されたエクスペリエンスを提供します。

local.ai はどのように機能しますか?

Local.ai は、ユーザーフレンドリーなインターフェースと効率的な Rust バックエンドを通じて、AI モデルの管理、検証、および推論を簡素化します。主な機能と機能の内訳は次のとおりです。

主な機能:

- CPU 推論: 利用可能なスレッドに適応し、効率的な CPU ベースの AI 推論のために GGML 量子化(q4、5.1、8、f16)をサポートします。

- モデル管理: AI モデルを追跡するための一元化された場所。再開可能な同時ダウンローダー、使用状況に基づくソート、ディレクトリに依存しないセットアップなどの機能があります。

- ダイジェスト検証: BLAKE3 および SHA256 ダイジェスト計算、既知の適切なモデル API、およびライセンス/使用状況チップを使用して、モデルの整合性を保証します。

- 推論サーバー: AI 推論用のローカルストリーミングサーバーをわずか 2 回のクリックで起動し、迅速な推論 UI を提供し、出力を .mdx ファイルに書き込みます。

利用可能な機能:

- ストリーミングサーバー

- クイック推論 UI

- .mdx に書き込み

- 推論パラメータ

- リモートボキャブラリー

- ダイジェスト計算

- 既知の適切なモデル API

- ライセンスおよび使用状況チップ

- BLAKE3 クイックチェック

- モデル情報カード

今後の機能:

- GPU 推論

- 並列セッション

- ネストされたディレクトリ

- カスタムソートと検索

- モデルエクスプローラー

- モデル検索

- モデルの推奨

- サーバーマネージャー

- /audio

- /image

local.ai の使い方:

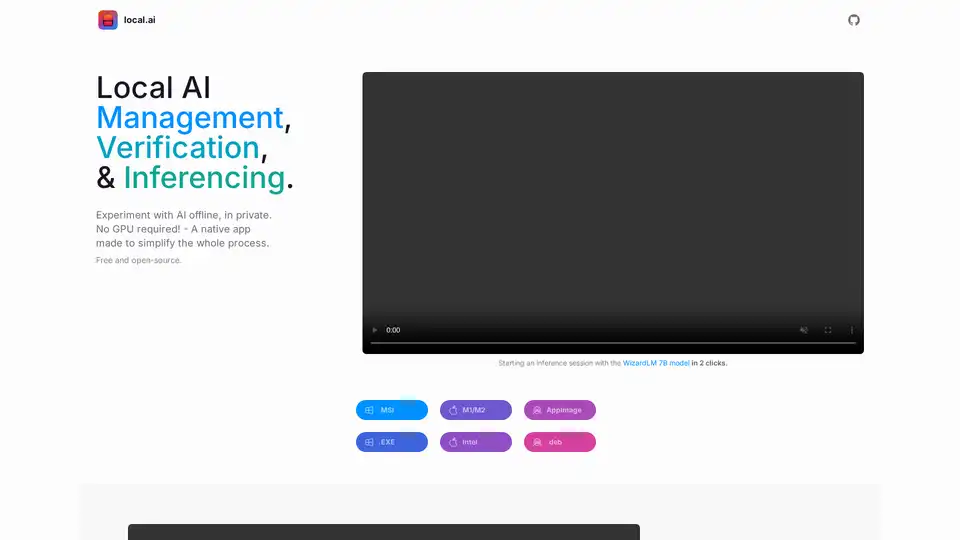

- ダウンロードとインストール: オペレーティングシステムに適したバージョン(.MSI、.EXE、M1/M2、Intel、AppImage、.deb)をダウンロードします。

- モデル管理: AI モデルを追跡するためのディレクトリを選択します。このアプリは、再開可能なダウンロードや使用状況に基づくソートなどの機能を提供します。

- 推論サーバー: モデルをロードし、わずか 2 回のクリックでサーバーを起動して、AI 推論を開始します。

local.ai が重要な理由は何ですか?

- プライバシー: オフラインで、プライベートに AI モデルを実行します。

- アクセシビリティ: GPU は不要で、より多くのユーザーが AI 実験にアクセスできるようになります。

- 効率: Rust バックエンドにより、メモリ効率とコンパクトなフットプリントが保証されます。

- オープンソース: 無料でオープンソースであり、コミュニティの貢献と透明性を促進します。

どこで local.ai を使用できますか?

Local.ai は、次のようなさまざまな設定で使用できます。

- AI 開発: クラウドサービスに依存せずに、AI モデルのテストと実験を行います。

- 教育目的: 実践的なオフライン環境で AI 概念を学習および理解します。

- プライバシーを重視するアプリケーション: データを外部サーバーに送信せずに、機密データで AI モデルを実行します。

local.ai を使い始めるための最良の方法は何ですか?

local.ai をダウンロードし、数回クリックするだけで WizardLM 7B モデルまたはその他のオープンソースモデルを試してみてください。 local.ai は、すべての AI モデルをオフラインまたはオンラインで管理するのに役立つ、合理化されたプロセスと強力な機能を提供します。

"local.ai" のベストな代替ツール

Local AI は、ローカルでの AI モデルの実験を簡素化する無料のオープンソース ネイティブ アプリケーションです。 CPU 推論、モデル管理、ダイジェスト検証を提供し、GPU は必要ありません。

AI Runnerは、アート、リアルタイムの音声会話、LLMを搭載したチャットボット、および自動化されたワークフローのためのオフラインAI推論エンジンです。画像生成、音声チャットなどをローカルで実行します!

NativeMindはオープンソースChrome拡張で、OllamaなどのローカルLLMを実行し、完全にオフラインでプライベートなChatGPT代替を提供。コンテキスト認識チャット、エージェントモード、PDF分析、執筆ツール、翻訳を特徴とし、すべてデバイス上で100%クラウド不要。

Agent Herbieは、プライベート環境でのリアルタイム、ミッションクリティカルな運用向けに設計されたオフラインAIエージェントです。データの流出なしに、比類のない柔軟性と信頼性のためにLLM、SLM、MLを活用します。

LM Studioは、LLaMaやGemmaなどのオープンソース大規模言語モデル(LLM)をローカルPCで実行およびダウンロードするための使いやすいデスクトップアプリケーションです。アプリ内チャットUIとOpenAI互換のローカルサーバーを備え、プログラミングスキルなしでオフラインAIモデルとの対話を可能にします。

Janは、オープンソースのオフライン優先AIクライアントです。プライバシーを保護し、API料金なしで大規模言語モデル(LLM)をローカルで実行します。さまざまなモデルやサービスに接続します。

Hachiは、AIを活用したツールで、ビデオや画像全体で自然言語検索を可能にします。また、迅速かつ簡単な検索のための顔認識も提供します。プライバシーに焦点を当て、オフラインで動作します。

HaiVEは、音声通信用のオンプレミスAIエージェントを提供し、データの主権、低レイテンシ、予測可能なコストを保証します。実際にチケットと取引を成立させるAIエージェントをデプロイします。

Synthesizer V Studio 2 Proは、倫理的に調達されたAIボーカルモデルを使用してプロのボーカルを生成するAI駆動のボーカル合成ソフトウェアです。多言語機能を備えたMIDI入力から表現力豊かなボーカルを作成します。

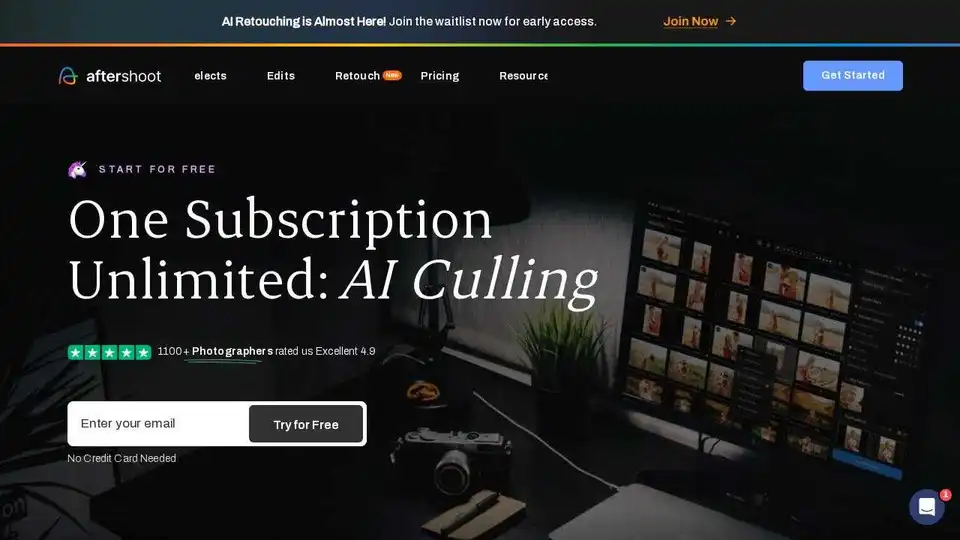

Aftershoot:AI写真編集ソフトウェアによる選択、編集、レタッチ。 写真撮影のワークフローを合理化し、毎月18時間以上を節約します。

AmuseはAMDハードウェア向けに最適化されたStable Diffusionモデルを使用する無料のAIアート生成ツールで、インターネット接続なしで個人PC上で画像と動画の生成が可能です。

DrawingPicsは、粗いスケッチを美しい画像に変えるオフラインAIアートジェネレーターです。カスタムモデルとLoRAをサポートし、100%ローカルで実行されます。

Skribrは、iPhone、iPad、Mac上でローカルに実行されるツールを備えた、プライベートなオンデバイスAIチャットアプリであり、データセキュリティとオフラインアクセスを保証します。

Layla AIは、AndroidおよびiOS向けの最高のオフラインAIアシスタントアプリです。LaylaでオフラインAIのパワーを体験してください。最先端のAIツールでスマートフォン可能性を最大限に引き出してください。