NVIDIA NIM の概要

NVIDIA NIM API: エンタープライズ生成 AI の加速

NVIDIA NIM (NVIDIA Inference Microservices) API は、主要な AI モデル向けに最適化された推論を提供するように設計されており、開発者はエンタープライズグレードの生成 AI アプリケーションを構築およびデプロイできます。これらの API は、開発用のサーバーレスデプロイメントと、独自の GPU インフラストラクチャでのセルフホスティングオプションの両方を通じて柔軟性を提供します。

NVIDIA NIM とは?

NVIDIA NIM は、AI モデルのデプロイメントを加速する推論マイクロサービスのスイートです。パフォーマンス、セキュリティ、および信頼性を最適化するように設計されており、エンタープライズアプリケーションに適しています。NIM は継続的な脆弱性修正を提供し、AI モデルを実行するための安全で安定した環境を保証します。

NVIDIA NIM の仕組み

NVIDIA NIM は、推論、ビジョン、ビジュアルデザイン、検索、音声、生物学、シミュレーション、気候と天気、および安全性とモデレーションモデルを含む、さまざまな AI モデルに対して最適化された推論を提供することによって機能します。さまざまなユースケースに合わせて、gpt-oss、qwen、nvidia-nemotron-nano-9b-v2 などのさまざまなモデルをサポートしています。

主な機能は次のとおりです。

- 最適化された推論: NVIDIA のエンタープライズ対応の推論ランタイムは、コミュニティによって構築されたオープンモデルを最適化および高速化します。

- 柔軟なデプロイメント: 開発用のサーバーレス API または GPU インフラストラクチャでのセルフホスティングのオプションを使用して、どこでもモデルを実行します。

- 継続的なセキュリティ: 継続的な脆弱性修正の恩恵を受け、AI モデルを実行するための安全な環境を確保します。

主な機能と利点

- 無料のサーバーレス API: 開発目的で無料のサーバーレス API にアクセスします。

- セルフホスティング: 独自の GPU インフラストラクチャにデプロイして、より優れた制御とカスタマイズを実現します。

- 幅広いモデルサポート:

qwen、gpt-oss、nvidia-nemotron-nano-9b-v2を含む幅広いモデルをサポートします。 - NVIDIA RTX 向けに最適化: NVIDIA RTX GPU で効率的に実行できるように設計されています。

NVIDIA NIM の使用方法

- API キーの取得: サーバーレス API にアクセスするための API キーを取得します。

- モデルの探索: 推論、ビジョン、音声などの利用可能なモデルを検出します。

- デプロイメントの選択: サーバーレスデプロイメントまたは GPU インフラストラクチャでのセルフホスティングのいずれかを選択します。

- アプリケーションへの統合: 最適化された推論を活用するために、API を AI アプリケーションに統合します。

NVIDIA NIM は誰のためのものか?

NVIDIA NIM は、以下に最適です。

- 開発者: 生成 AI アプリケーションの構築。

- エンタープライズ: 大規模な AI モデルのデプロイメント。

- 研究者: 最先端の AI モデルの実験。

ユースケース

NVIDIA NIM は、次のようないくつかの業界で使用できます。

- 自動車: AI を活用した運転支援システムの開発。

- ゲーム: AI によるゲーム体験の強化。

- ヘルスケア: 医学研究と診断の加速。

- 産業: AI による製造プロセスの最適化。

- ロボティクス: さまざまなアプリケーション向けのインテリジェントなロボットの作成。

ブループリント

NVIDIA は、AI アプリケーションの構築を開始するのに役立つブループリントを提供しています。

- エンタープライズリサーチ向け AI エージェント: マルチモーダルエンタープライズデータを処理および合成するためのカスタムディープリサーチャーを構築します。

- ビデオ検索と要約 (VSS) エージェント: 大量のビデオデータからインサイトを取り込み、抽出します。

- エンタープライズ RAG パイプライン: 高速で正確なセマンティック検索のために、マルチモーダルデータを抽出、埋め込み、およびインデックス化します。

- エージェント AI の安全性: AI システムの安全性、セキュリティ、およびプライバシーを向上させます。

NVIDIA NIM を選択する理由

NVIDIA NIM は、最適化された推論、柔軟なデプロイメントオプション、および継続的なセキュリティを備えた AI モデルをデプロイするための包括的なソリューションを提供します。AI と GPU テクノロジーに関する NVIDIA の専門知識を活用することで、NIM を使用して、エンタープライズグレードの生成 AI アプリケーションをより効率的に構築およびデプロイできます。

最適化された推論、幅広いサポート対象モデル、および柔軟なデプロイメントオプションを提供することで、NVIDIA NIM は、生成 AI の力を活用しようとする企業にとって優れた選択肢です。AI エージェント、ビデオ要約ツール、またはエンタープライズ検索アプリケーションを構築する場合でも、NVIDIA NIM は成功に必要なツールとインフラストラクチャを提供します。

NVIDIA NIM とは何ですか? AI モデルのデプロイメントを強化する推論マイクロサービスです。NVIDIA NIM はどのように機能しますか? 最先端の API とブループリントを通じて AI モデルのデプロイメントを最適化することによって機能します。NVIDIA NIM の使用方法 API キーから始めて、モデルを選択し、エンタープライズ AI アプリケーションに統合します。

"NVIDIA NIM" のベストな代替ツール

Rierino は、AI エージェント、可構成型コマース、無縫の統合により、eコマースとデジタル変革を加速する強力なローコードプラットフォームで、スケーラブルなイノベーションを実現します。

Bind AI IDEは、Claude 4 Sonnet、Gemini 2.5 Pro、ChatGPT 4.1などの先進的なAIモデルを使用して、開発者が即座にフルスタックWebアプリケーションを作成できる強力なコードエディター兼AIコードジェネレーターです。

Brilliant Labs Haloは、開発者とクリエイター向けのリアルタイムマルチモーダル会話、オンデバイスAI処理、14時間のバッテリー寿命を備えたオープンソースAIスマートグラスプラットフォームです。

DaveAI は、AI エージェント、アバター、および視覚化を使用して、顧客のジャーニーをパーソナライズし、Web、キオスク、WhatsApp、およびエッジ展開全体でエンゲージメントを高める会話型エクスペリエンス クラウドです。

GitHub Sparkを使用して、自然言語でWebアプリを構築します。これは、GitHubと統合されたAI搭載プラットフォームです。開発者と非コーダーの両方に最適です。無料でお試しください!

Fireworks AIは、最先端のオープンソースモデルを使用して、生成AI向けの非常に高速な推論を提供します。追加費用なしで独自のモデルを微調整してデプロイできます。AIワークロードをグローバルに拡張します。

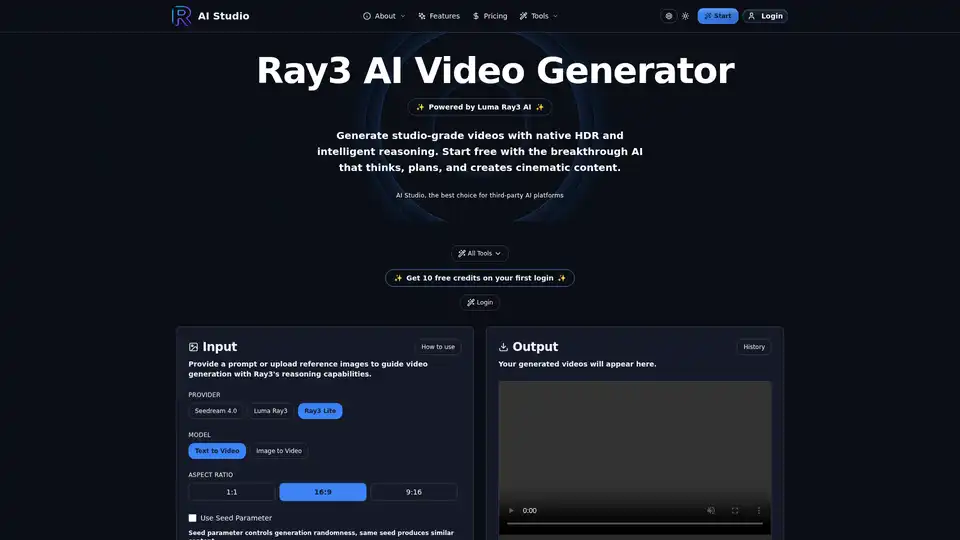

Ray3 で考え、自己改善するビデオを生成。これは世界初の推論 AI ビデオモデルです。テキストプロンプトからインテリジェントな自己批評で驚くべき 4K HDR コンテンツを作成。

Groq は、高速、高品質、エネルギー効率の高い AI 推論のためのハードウェアおよびソフトウェアプラットフォーム(LPU 推論エンジン)を提供します。 GroqCloud は、AI アプリケーション向けのクラウドおよびオンプレミスソリューションを提供します。

Spice.ai は、エンタープライズデータに基づいた SQL クエリフェデレーション、アクセラレーション、検索、および取得を使用して AI アプリを構築するためのオープンソースのデータおよび AI 推論エンジンです。

mistral.rsは、Rustで記述された非常に高速なLLM推論エンジンであり、マルチモーダルワークフローと量子化をサポートしています。Rust、Python、およびOpenAI互換のHTTPサーバーAPIを提供します。

Nebius AI Studio Inference Service は、ホストされたオープンソースモデルを提供し、独自 API よりも高速で安価で正確な推論結果を実現します。MLOps 不要でシームレスにスケールし、RAG や本番ワークロードに最適です。

vLLMは、LLM のための高スループットかつメモリ効率の良い推論およびサービングエンジンであり、最適化されたパフォーマンスのためにPagedAttentionと継続的なバッチ処理を備えています。

GPUXは、StableDiffusionXL、ESRGAN、AlpacaLLMなどのAIモデル向けに1秒のコールドスタートを実現するサーバーレスGPU推論プラットフォームで、最適化されたパフォーマンスとP2P機能を備えています。

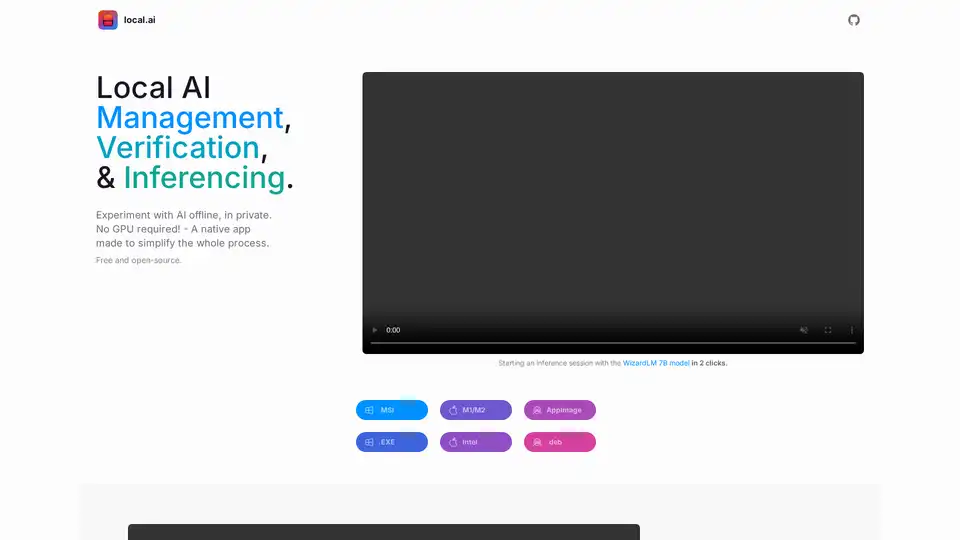

Local AI は、ローカルでの AI モデルの実験を簡素化する無料のオープンソース ネイティブ アプリケーションです。 CPU 推論、モデル管理、ダイジェスト検証を提供し、GPU は必要ありません。