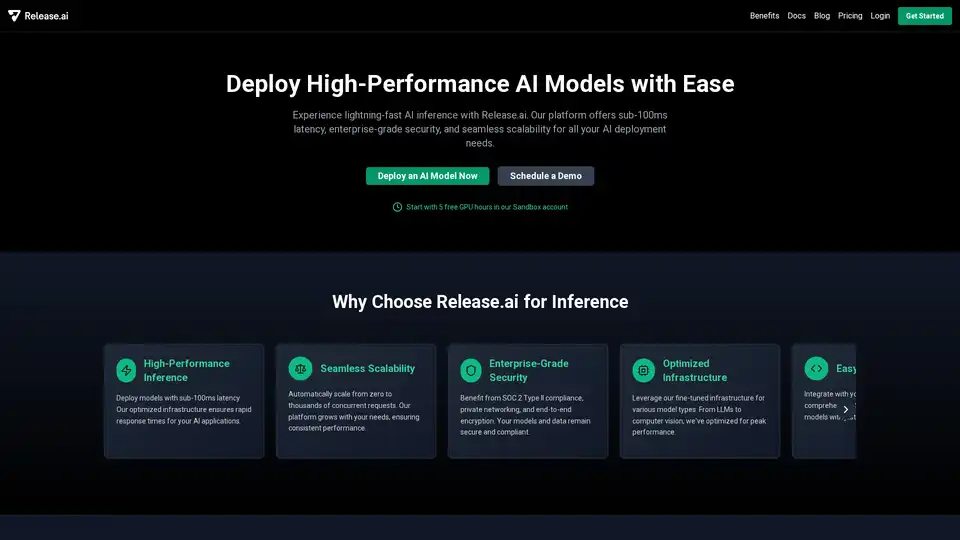

Release.ai の概要

Release.aiとは?

Release.aiは、AIモデルのデプロイメントと管理を簡素化するために設計されたプラットフォームです。100ms未満の低遅延、エンタープライズグレードのセキュリティ、シームレスなスケーラビリティを備えた高性能な推論機能を提供し、開発者がAIをアプリケーションに統合するのを容易にします。

Release.aiの仕組み

Release.aiは、大規模言語モデル(LLM)からコンピュータビジョンモデルまで、さまざまなAIモデルタイプに最適化されたインフラストラクチャを提供します。包括的なSDKとAPIを使用して、わずか数行のコードでモデルを迅速にデプロイできます。プラットフォームは自動的にスケールし、一貫したパフォーマンスを確保しながら、数千もの同時リクエストを処理します。

Release.aiの主な機能:

- High-Performance Inference: 100ms未満の低遅延でモデルをデプロイし、AIアプリケーションの迅速な応答時間を保証します。

- Seamless Scalability: ニーズに合わせて、ゼロから数千の同時リクエストに自動的にスケールします。

- Enterprise-Grade Security: SOC 2 Type II準拠、プライベートネットワーク、エンドツーエンドの暗号化の恩恵を受けます。

- Optimized Infrastructure: LLM、コンピュータビジョン、その他のモデルタイプ向けに微調整されたインフラストラクチャを活用します。

- Easy Integration: 包括的なSDKとAPIを使用して、既存の技術スタックと統合します。

- Reliable Monitoring: リアルタイムのモニタリングと詳細な分析でモデルのパフォーマンスを追跡します。

- Cost-Effective Pricing: 使用量に応じてスケーリングする料金体系で、使用した分だけ支払います。

- Expert Support: MLエキスパートからの支援を受けて、モデルを最適化し、問題を解決します。

Release.aiを選ぶ理由

大手企業がRelease.aiを選ぶのは、AIモデルを迅速かつ効率的にデプロイできるからです。他のプラットフォームとは異なり、Release.aiは完全に自動化されたインフラストラクチャ管理、エンタープライズグレードのセキュリティ、優れたパフォーマンス最適化を提供します。

| Feature | Release.ai | Baseten.co |

|---|---|---|

| Model Deployment Time | Under 5 minutes | 15-30 minutes |

| Infrastructure Management | Fully automated | Partially automated |

| Performance Optimization | Sub-100ms latency | Variable latency |

| Security Features | Enterprise-grade (SOC 2 Type II compliant) | Standard |

| Scaling Capabilities | Automatic (zero to thousands of concurrent requests) | Manual configuration required |

Release.aiの使い方

- Sign Up: Release.aiアカウントを作成して、プラットフォームにアクセスします。

- Deploy Model: SDKとAPIを使用して、わずか数行のコードでAIモデルをデプロイします。

- Integrate: デプロイされたモデルを既存のアプリケーションに統合します。

- Monitor: リアルタイムのモニタリングと分析を使用して、モデルのパフォーマンスを追跡します。

Release.aiは誰のため?

Release.aiは、以下のような場合に最適です。

- Developers: AIモデルを迅速にデプロイし、アプリケーションに統合します。

- AI Engineers: モデルのパフォーマンスとスケーラビリティを最適化します。

- Businesses: エンタープライズグレードのセキュリティで、さまざまなユースケースにAIを活用します。

Release.aiでAIモデルを探す

Release.aiは、デプロイできるさまざまな事前トレーニング済みのAIモデルを提供しています。

- deepseek-r1: OpenAI-o1に匹敵するパフォーマンスを備えた推論モデル。

- olmo2: 最大5Tトークンでトレーニングされたモデルで、Llama 3.1と競合します。

- command-r7b: コモディティGPUでAIアプリケーションを構築するための効率的なモデル。

- phi4: Microsoftの最先端のオープンモデル。

- dolphin3: コーディング、数学、および一般的なユースケース向けに調整されたInstructモデル。

AIモデルをデプロイする最良の方法は?

Release.aiは、高性能、セキュリティ、スケーラビリティを備えたAIモデルをデプロイするための合理化されたソリューションを提供します。最適化されたインフラストラクチャと簡単な統合ツールにより、AIを活用しようとしている開発者や企業にとって最適な選択肢となっています。

Release.aiのプラットフォームは、最適化されたデプロイメントプラットフォームを通じて、高性能、安全、スケーラブルなAI推論を提供するように設計されています。100ms未満の低遅延、エンタープライズグレードのセキュリティ、シームレスなスケーラビリティを提供することで際立っており、AIアプリケーションの迅速な応答時間と一貫したパフォーマンスを保証します。

Release.aiは、LLMやコンピュータビジョンを含むさまざまなモデルタイプに最適化されており、包括的なSDKとAPIにより、わずか数行のコードで迅速なデプロイが可能です。その機能には、モデルのパフォーマンスを追跡するためのリアルタイムモニタリングと詳細な分析が含まれており、ユーザーが問題を迅速に特定して解決できることを保証します。

Release.aiは、使用量に応じてスケーリングする費用対効果の高い料金設定で、ユーザーがモデルを最適化し、問題を解決するのを支援するための専門家によるサポートも提供しています。エンタープライズグレードのセキュリティ、SOC 2 Type II準拠、プライベートネットワーク、エンドツーエンドの暗号化に対するプラットフォームの取り組みにより、モデルとデータが安全でコンプライアンスを維持することが保証されます。

"Release.ai" のベストな代替ツール

AIビルダー向けの次世代エンタープライズスタジオで、AIモデルをトレーニング、検証、チューニング、デプロイ。IBM watsonx.aiの統合ツールでスケーラブルな生成AI開発を発見。

ハイブリッドAIを搭載したBeyond Limitsの産業用エンタープライズAIをご覧ください。石油・ガス、製造、ヘルスケアなどの産業向けに、運用を最適化し、データに基づいた意思決定を推進する、安全でスケーラブルなAIソリューションを提供します。

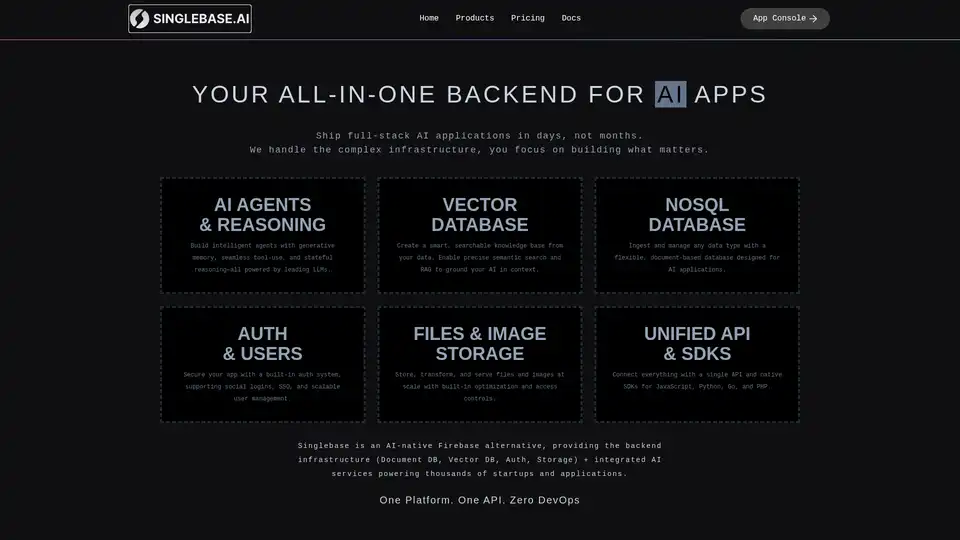

Singlebase は、AI ネイティブの Firebase の代替であり、AI アプリケーションに統合バックエンドを提供します。 ベクトル DB、NoSQL DB、認証、ストレージ、統合 AI サービスを 1 つのプラットフォームで提供します。

Avian APIは、オープンソースLLMに最速のAI推論を提供し、DeepSeek R1で351 TPSを達成します。OpenAI互換APIを使用して、HuggingFace LLMを3〜10倍の速度でデプロイします。エンタープライズグレードのパフォーマンスとプライバシー。

Agent TARS は、オープンソースのマルチモーダル AI エージェントで、ブラウザ操作、コマンドライン、ファイルシステムをシームレスに統合し、ワークフロー自動化を強化します。高度な視覚解釈と洗練された推論でタスクを効率的に処理します。

Runpodは、AIモデルの構築とデプロイメントを簡素化するAIクラウドプラットフォームです。 AI開発者向けに、オンデマンドGPUリソース、サーバーレススケーリング、およびエンタープライズグレードの稼働時間を提供します。

H2O.aiだけが、スタックのすべての部分を所有できるエンドツーエンドのGenAIプラットフォームを提供します。エアギャップ、オンプレミスまたはクラウドVPCデプロイメント向けに構築。

TwelveLabsは、マルチモーダルAIを使用してビデオコンテンツを検索、分析、理解できるAIプラットフォームです。メディア、広告、政府部門に、ビデオの価値を最大限に引き出すためのソリューションを提供します。

Datatureは、企業や開発者向けにデータラベリング、モデルトレーニング、デプロイメントを加速するエンドツーエンドのビジョンAIプラットフォームです。本番環境対応のデータセットを10倍高速に構築し、ビジョンインテリジェンスをシームレスに統合します。

Rierino は、AI エージェント、可構成型コマース、無縫の統合により、eコマースとデジタル変革を加速する強力なローコードプラットフォームで、スケーラブルなイノベーションを実現します。

Magic Loopsは、LLMとコードを組み合わせ、無コードプラットフォームで数分でプロフェッショナルなAIネイティブアプリを構築します。コーディングスキルなしでタスクを自動化し、カスタムツールを作成し、コミュニティアプリを探求。

応用AI研究ラボで、自律型エージェントのインフラを構築。OpenServがエージェントアプリの迅速な開発を可能にし、暗号通貨およびそれ以上の分野でのAI駆動イノベーションのエコシステムを育む方法を発見。