Stable Diffusion の概要

Stable Diffusion AIとは何ですか?

Stable Diffusionは、テキスト記述を驚くべきリアリスティックな画像に変換する画期的なオープンソースAIシステムです。ミュンヘン大学のルートヴィヒ・マクシミリアン大学のCompVisグループによって開発され、Runway MLおよびStability AIと協力して、拡散モデルを活用してテキスト-to-イメージ生成、イメージ編集などを可能にします。プロプライエタリツールとは異なり、Stable Diffusionのコード、事前訓練モデル、ライセンスは完全にオープンソース化されており、ユーザーは単一のGPU上で自分のデバイス上で直接実行できます。このアクセシビリティは、AI駆動の創造性を民主化し、アーティスト、デザイナー、趣味家がエンタープライズレベルのリソースなしで高品質なイメージ生成を可能にします。

その核心では、Stable Diffusionはシンプルなプロンプトから詳細なビジュアルを生成することに優れ、最大1024x1024ピクセルの解像度をサポートします。特に、風景、ポートレート、抽象アート、さらにはコンセプチュアルデザインの生成における汎用性で知られています。AIアートに足を踏み入れる人々にとって、Stable Diffusionは信頼できるエントリーポイントとして際立ち、創造的な自由を提供しつつ、トレーニングデータからのバイアスを避けるための倫理的使用を考慮します。

Stable Diffusionの仕組み

Stable Diffusionは、Latent Diffusion Model (LDM)アーキテクチャに基づいて動作し、完全なピクセル空間ではなく潜在空間で画像を効率的に圧縮・処理し、計算負荷を低減します。システムは3つの主要コンポーネントで構成されます:

- Variational Autoencoder (VAE):入力画像をコンパクトな潜在表現に圧縮し、本質的なセマンティック詳細を保持しつつノイズを破棄します。

- U-Net:ResNet構造に基づくデノイジングのバックボーンで、前方拡散プロセス中に追加されたガウスノイズを反復的に除去します。クロスアテンションメカニズムを使用してテキストプロンプトを組み込み、生成をユーザー記述の出力に向けます。

- Text Encoder (Optional):テキスト記述をデノイジングステップに影響を与えるエンベディングに変換します。

プロセスは、潜在画像にノイズを追加するところから始まります(または生成のために純粋なノイズから開始)。U-Netはこれをステップバイステップで逆転し、出力を洗練して一貫した画像を出現させます。デノイズされた後、VAEデコーダーが最終的なピクセルベースの画像を再構築します。この洗練されたワークフローは、スタイル、構成、または主題を含む複雑なプロンプトでも高忠実度の結果を保証します。

膨大なLAION-5Bデータセット—ウェブソースからの数十億のイメージ-テキストペア—でトレーニングされることで、Stable Diffusionは多様な視覚概念を学習します。データは品質、解像度、美学でフィルタリングされ、Classifier-Free Guidanceのような技術がプロンプト遵守を強化します。しかし、このウェブソースデータは、主に英語と西洋コンテンツへの文化的バイアスを引き起こし、多様な表現を生成する際にユーザーが考慮すべきです。

Stable Diffusionのコア機能と能力

Stable Diffusionは基本的なイメージ作成にとどまらず、先進的な機能のスイートを提供します:

- テキスト-to-イメージ生成:"夕暮れ時の穏やかな山の風景"のような記述的プロンプトを入力し、数秒でオリジナルアートワークを生成します。

- イメージ編集ツール:インペインティングを使用して画像の一部を埋めたり修正したり(例:背景の変更)、アウトペインティングで元の境界を超えて拡張します。

- イメージ-to-イメージ変換:新しいテキストガイダンスで既存の写真を再描画し、構造を保持しつつスタイルや要素を変更します。

- ControlNet統合:参照画像からの幾何学的構造、ポーズ、またはエッジを維持しつつ、スタイル変更を適用します。

- 高解像度サポート:XLバリアント(Stable Diffusion XL 1.0)は60億パラメータのデュアルモデルで能力を向上させ、1024x1024出力、画像内のより良いテキストレンダリング、迅速でより現実的な結果のための簡略化されたプロンプティングを可能にします。

LoRAs(Low-Rank Adaptations)のような強化により、顔、服装、アニメスタイルなどの特定詳細をモデル全体の再トレーニングなしで微調整できます。エンベディングは一貫した出力のための視覚スタイルをキャプチャし、ネガティブプロンプトは歪みや余分な肢体などの不要要素を排除して品質を洗練します。

Stable Diffusion AIの使用方法

Stable Diffusionの開始は、オンラインでもオフラインでも簡単です。

プラットフォーム経由のオンラインアクセス

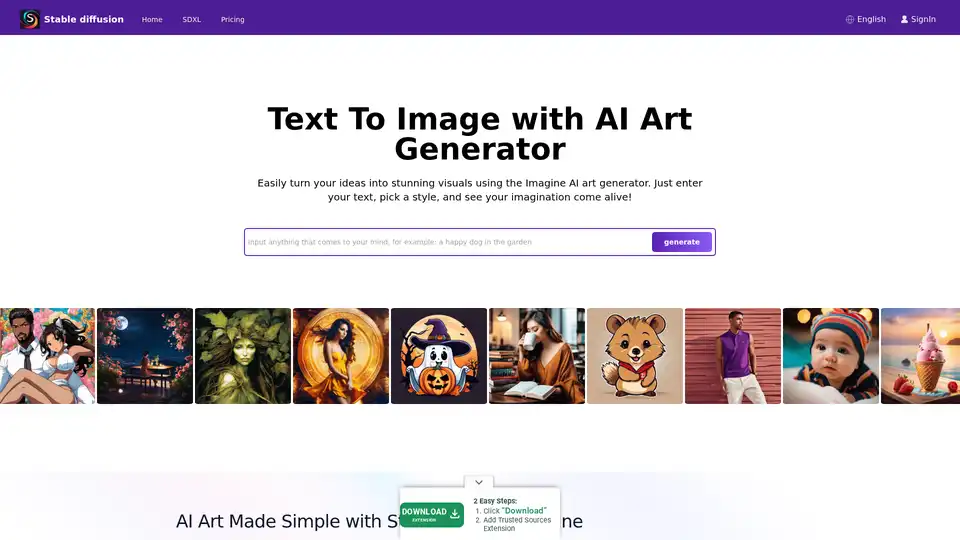

初心者向けに、Stablediffusionai.aiのようなプラットフォームがユーザー友好なウェブインターフェースを提供します:

- stablediffusionai.aiにアクセスしてサインインします。

- 入力フィールドにテキストプロンプトを入力します。

- スタイル、解像度(例:高解像度のためのSDXL)、サンプリングステップなどのパラメータを調整します。

- 「Generate」または「Dream」をクリックして画像を作成します。

- ネガティブプロンプト(例:「blurry, low quality」)で洗練し、お気に入りをダウンロードします。

このインストール不要のオプションは、迅速な実験に理想的ですが、インターネットが必要です。

ローカルインストールとダウンロード

完全な制御とオフライン使用のために:

- GitHub(github.com/CompVis/stable-diffusion)からダウンロードし、「Code」 > 「Download ZIP」をクリック(約10GBのスペースが必要)。

- 前提条件をインストール:Python 3.10+、Git、および4GB+ VRAMのGPU(NVIDIA推奨)。

- ZIPを解凍し、モデルチェックポイント(例:Hugging Faceから)をmodelsフォルダに配置します。

- webui-user.bat(Windows)または同等のスクリプトを実行してローカルUIを起動します。

- プロンプトを入力し、推論ステップ(バランスのための20-50)などの設定を調整して生成します。

Automatic1111のweb UIのような拡張機能は、バッチ処理などの機能を追加します。一度セットアップすれば、完全にオフラインで動作し、プライバシーを優先します。

独自のStable Diffusionモデルをトレーニングする

上級ユーザーはStable Diffusionをカスタマイズできます:

- イメージ-テキストペアのデータセットを集めます(例:ニッチスタイル用)。

- データのクリーンアップとキャプション付けで準備します。

- データセットとハイパーパラメータ(バッチサイズ、学習率)のためのコンフィグを修正します。

- スクリプトを使用してコンポーネント(VAE、U-Net、テキストエンコーダー)を個別にトレーニング—重い作業のためにクラウドGPUをレンタルします。

- 反復的に評価と微調整を行います。

このプロセスは技術的知識を要求しますが、ファッションや建築などの特定ドメイン向けのテーラードモデルを解禁します。

Stable Diffusion XL:アップグレード版

2023年7月にStability AIによってリリースされたSDXLは、オリジナルを基にパラメータ数を増やして優れた詳細を実現します。プロンプトを簡素化(必要な単語が少ない)、組み込みスタイルを含み、画像内の読みやすいテキストに優れています。プロフェッショナル向けに、専用プラットフォーム経由のSDXL Onlineは、マーケティングビジュアル、ゲームアセット、またはプリントのための超高解像度出力を提供します。フォトリアリズムや複雑なデザインを速度を損なわずに求める人にとってのステップアップです。

LoRAs、エンベディング、ネガティブプロンプトの使用

- LoRAs:ポートレートなどの専門ファイル(例)をダウンロードし、"lora:portrait_style:1.0"のようなプロンプトでアクティブ化します。それらは効率的に詳細を強化します。

- エンベディング:スタイルデータセットでトレーニングし、プロンプト内の":style_name:"でテーマの一貫性を呼び出します。

- ネガティブプロンプト:"deformed, ugly"のような回避を指定して欠陥を最小限に抑え、全体の出力精度を向上させます。

実用的アプリケーションとユースケース

Stable Diffusionはさまざまなシナリオで輝きます:

- アーティストとデザイナー:コンセプトのプロトタイピング、参照生成、またはデジタルアート、イラスト、UI/UXモックアップのためのスタイル実験。

- マーケティングとメディア:広告、ソーシャルメディア、またはコンテンツのためのカスタムビジュアルを作成—ストック写真なしで、eコマース製品レンダリングに理想的。

- 教育と趣味家:AIコンセプトを教えるか、ファンタジー設定の家族ポートレートのようなパーソナライズドアートを趣味で作成。

- ゲーム開発:キャラクター、環境、またはテクスチャの資産作成、特にControlNetでポーズ制御。

オフライン機能はリモートクリエイターに適し、APIアクセス(Dream StudioまたはHugging Face経由)はワークフローに統合します。

Stable Diffusionは誰のため?

このツールは、初心者のデジタルアーティストから経験豊富な開発者までのクリエイティブプロフェッショナルを対象とします。初心者は直感的なインターフェースを評価し、専門家は微調整のようなカスタマイズオプションを重視します。オープンソースの倫理とローカルプライバシーをクラウド依存よりも優先する人に最適です。ただし、非クリエイティブタスクや基本的な技術セットアップのないユーザーには適しません。

制限とベストプラクティス

強みにもかかわらず、Stable Diffusionには課題があります:

- バイアス:出力は西洋的美学を好む可能性;多様なプロンプトと微調整で緩和。

- 解剖学的課題:手や顔が歪む可能性—ネガティブプロンプトまたはLoRAsを使用。

- リソース要件:ローカル実行には適切なハードウェアが必要;Stablediffusionai.aiのようなクラウド代替がギャップを埋めます。

常にトレーニングデータの著作権などの倫理的問題をレビューしてください。CivitaiやRedditのコミュニティは、欠陥を克服するためのモデルとTipsを提供します。

なぜStable Diffusionを選ぶのか?

混雑したAIランドスケープで、Stable Diffusionのオープンソース性はイノベーションを育み、継続的なコミュニティアップデートがあります。DALL-Eのようなクローズドツールと比較して、無制限の生成をクォータなしで提供し、出力を完全に所有できます。高解像度ニーズに対して、SDXLは手頃な価格でプロレベルの品質を提供します。アイデアの喚起からプロジェクトの最終化まで、人間の独創性とAIの効率を融合させる力をユーザーに与えます。

価格とアクセス

コアStable Diffusionはダウンロードと使用が無料です。Stablediffusionai.aiのようなプラットフォームは、無料ティアと高速生成や先進機能のための有料アップグレードを提供する可能性があります。Dream Studio APIクレジットは低価格から始まり、重い使用にスケーリングします。ローカルセットアップは継続コストを排除し、持続的な創造性に経済的です。

本質的に、Stable Diffusionはユーザーの手に力を置くことでAIアート生成を再定義します。GitHubやオンラインデモを通じてそのエコシステムに飛び込み、ビジュアルストーリーテリングの無限の可能性を解き放ちましょう。

Stable Diffusion関連タグ