UsageGuard の概要

UsageGuard とは?

UsageGuard は、企業向けの包括的なプラットフォームで、ビジネスが自信を持って AI アプリケーションを構築、展開、監視できるように設計されています。これは、OpenAI、Anthropic、Meta、Google などの主要な大規模言語モデル (LLM) にアクセスするための統一ゲートウェイとして機能し、セキュリティ保護、コスト管理、リアルタイム観測可能性などの重要な機能を組み込んでいます。断片化されたソリューションとは異なり、UsageGuard は AI 開発、ガバナンス、分析を一つのシームレスなインターフェースに統合し、パフォーマンスやコンプライアンスを犠牲にせずに AI イニシアチブをスケーリングするチームに最適です。

その核心では、UsageGuard は AI 採用の一般的な痛み点を解決します:複数のモデルの統合の複雑さ、不安全な展開のリスク、使用の抑制されないコストの上昇、AI 操作の可視性の欠如です。アプリケーションと LLM プロバイダの間の仲介層として機能することで、安全で効率的でコスト効果の高い AI 利用を保証します。Web アプリ、モバイルソリューション、API を開発しているかどうかにかかわらず、UsageGuard のモデル非依存アプローチにより、コードを書き直すことなく GPT-4o、Claude 3.5 Sonnet、Llama 3.2 などのプロバイダー間でのシームレスな切り替えが可能です。

UsageGuard はどのように動作する?

UsageGuard の開始は簡単で、最小限のセットアップで済みます—通常、既存のインフラに数分で統合可能です。プラットフォームは AI API 呼び出しのプロキシとして機能します:アプリケーションが UsageGuard の統一エンドポイント(例: https://api.usageguard.com/v1/inference/chat)にリクエストを送信すると、選択した LLM へのルーティングを処理し、セキュリティポリシーを適用し、インタラクションを監視し、低遅延(通常 150ms 未満、50-100ms のオーバーヘッドのみ)でレスポンスを返します。

そのワークフローのステップバイステップの内訳は以下の通りです:

- 統合フェーズ: API エンドポイントを UsageGuard に更新し、API キーと接続 ID を追加します。この単一の統一 API はすべてのモデルをサポートし、リアルタイムストリーミング、状態保持会話のためのセッション管理、完全な可視性のためのリクエスト監視を可能にします。

- リクエスト処理: リクエストが流れる中で、UsageGuard は入力のサニタイズを行い、プロンプトインジェクション攻撃を防ぎ、コンテンツをモデレーションのためにフィルタリングし、個人識別情報 (PII) を保護します。また、使用パターンを追跡して予算と制限を施行します。

- レスポンスと監視: レスポンスは迅速にストリーミングされ、バックエンド分析が遅延、トークン使用、エラー率などのメトリクスをキャプチャします。このデータはダッシュボードに供給され、リアルタイムの洞察を提供し、開発者が問題をデバッグしたりパフォーマンスを最適化したりするのに役立ちます。

- ガバナンス層: SOC2 Type II と GDPR 遵守を含むセキュリティとコンプライアンスツールが、エンタープライズグレードの保護を保証します。例えば、カスタムポリシーをプロジェクト、チーム、環境(dev、staging、production)ごとに設定できます。

この仲介モデルは、多プロバイダー使用を簡素化するだけでなく、エンドツーエンドの暗号化と最小限の保持慣行でデータを隔離し、不正アクセスを防ぎます。

UsageGuard の主な機能

UsageGuard はオールインワンアプローチで際立ち、AI アプリケーションライフサイクルのすべての段階をカバーします。以下はその堅牢な機能から抽出された主な機能です:

AI 開発ツール

- 統一推論: 1 つの API で十数以上のモデルにアクセス可能で、OpenAI の o1 や GPT-4o-mini、Anthropic の Claude バリエーション、Meta の Llama 3.2、Mistral、Google Gemini を含みます。各タスクに最適なプロバイダーを努力せずに切り替えられます。

- エンタープライズ RAG (Retrieval-Augmented Generation): ドキュメントをインテリジェントに処理し、独自のデータでレスポンスを強化しますが、外部プロバイダーに公開しません。

- エージェント (Beta): 複雑なワークフロー(例: 多段階推論やツール統合)のための自律 AI エージェントを構築・展開します。

観測可能性と分析

- リアルタイム監視: パフォーマンスメトリクス、使用パターン、システムヘルスを 99.9% のアップタイムで追跡します。機能にはログ、トレース、メトリクスダッシュボードが含まれ、積極的なデバッグに役立ちます。

- セッション管理: 会話のコンテキストを維持し、チャットボットやインタラクティブアプリに最適です。

セキュリティとガバナンス

- 組み込み保護: コンテンツフィルタリング、PII 保護、プロンプトサニタイズがインジェクション攻撃や有害出力などのリスクを軽減します。

- コンプライアンスツール: SOC2 Type II 認定、GDPR 準拠で、データ隔離とカスタムポリシーのオプションを提供します。

コスト制御と最適化

- 使用追跡: トークン消費を監視し、予算を設定し、アラートを受信して超過を避けます—ユーザーは最大 45% のコスト削減を報告しています。

- 自動管理: 接続ごとの制限を施行し、プロジェクト全体の支出を最適化します。

展開の柔軟性

- プライベートクラウドとオンプレミス: AWS インフラ(米国、欧州、中東地域)上でホストし、完全制御とエアギャップセキュリティを実現します。

- グローバル可用性: 世界中の低遅延アクセスで、信頼性とデータ居住地コンプライアンスを確保します。

Langfuse、OpenAI のネイティブツール、AWS Bedrock などの代替品と比較して、UsageGuard はマルチ LLM サポート、包括的な観測可能性、統合された支出管理で優位性を持ち、その機能比較で強調されています。

ユースケースと実用的価値

UsageGuard は、本番グレードの AI アプリケーションを構築する企業に特に価値があります。例えば:

- コラボラティブ AI プラットフォーム: Spanat などの企業チームが、共有 AI ツールのための信頼性が高く安全な環境を作成し、監視とコンプライアンスのカスタム開発で数ヶ月を節約します。

- エンタープライズソフトウェアのスケーリング: CorporateStack のリーダーが ERP システムに統合し、AI 機能を拡張しながらコストとパフォーマンスを制御—高ボリューム運用に不可欠です。

- R&D とプロトタイピング: 開発者が複数のモデルを迅速に実験し、観測可能性を使ってセキュリティの心配なく高速イテレーションします。

実用的価値の観点から、統合時間を数週間から数分に短縮し、インテリジェント追跡でコストを削減(例: 不要な高級モデル呼び出しの回避)、99.9% アップタイムと <150ms 遅延で信頼性を向上させます。AI ガバナンスの課題に直面するビジネスには、カスタマイズ可能なポリシーと専用 24/7 サポート(SLA 付き)で安心を提供します。

UsageGuard は誰向けか?

このプラットフォームは、AI を真剣に扱う中規模から大規模企業および開発チームを対象としています:

- エンジニアリングリーダー: ベンダーロックインなしの安全でスケーラブルな AI インフラを必要とする。

- DevOps とセキュリティのプロ: コンプライアンス、PII 保護、コストガバナンスに焦点を当てる。

- プロダクトマネージャー: チャットボット、アナリティクツール、ドキュメントプロセッサなどの顧客向けアプリを構築。

- 急速にスケーリングするスタートアップ: オーバーヘッドなしでエンタープライズ機能を求める。

エンタープライズフォーカスによりホビイストには適さないが、大規模 AI 展開の組織は、その堅牢なツールキットから利益を得ます。

なぜ UsageGuard を選ぶか?

混雑した AI ランドスケープで、UsageGuard は真にモデル非依存で機能完備であることで差別化されます。証言がその影響を強調します:「UsageGuard's security features were crucial in helping us build a collaborative AI platform that our enterprise customers could trust,」と Spanat のエンジニアリング責任者 Eden Köhler は述べています。最小限のコード変更、グローバル展開オプション、積極的なコストツールが長期的な AI 成功のための戦略的投資にします。

実装詳細については、ドキュメントのクイックスタートガイドを確認するか、デモをリクエストしてください。サポートモデルと機能の継続的な拡張により、UsageGuard は AI エコシステムとともに進化し、アプリケーションが先を行くことを保証します。

よくある質問

UsageGuard はデータプライバシーをどのように確保するか?

UsageGuard はデータ隔離、エンドツーエンド暗号化、カスタマイズ可能な保持を採用し、情報を保護し、第三者と共有しません。

カスタム LLM をサポートするか?

はい。主要プロバイダーに加え、カスタムモデルをカスタマイズされた統合のために収容します。

問題が発生したら?

トラブルシューティングガイド、ステータスページ、または 24/7 サポートにアクセスして迅速に解決します。

UsageGuard を活用することで、ビジネスは AI をリスクの高い実験から信頼できるイノベーションの推進力に変え、セキュリティ、コスト、パフォーマンスの制御を維持できます。

"UsageGuard" のベストな代替ツール

Agent Herbieは、プライベート環境でのリアルタイム、ミッションクリティカルな運用向けに設計されたオフラインAIエージェントです。データの流出なしに、比類のない柔軟性と信頼性のためにLLM、SLM、MLを活用します。

MultiChat AIを使用すると、GPT-4、Claude-3、Gemini 1.5 ProなどのトップLLMと1か所でチャットできます。 AI画像生成および編集ツールも提供します。

Xanderは、オープンソースのデスクトッププラットフォームで、ノーコードAIモデルトレーニングを可能にします。自然言語でタスクを記述するだけで、テキスト分類、画像分析、LLMファインチューニングの自動化パイプラインを実行し、ローカルマシンでプライバシーとパフォーマンスを確保します。

xTuring は、オープンソースのライブラリで、ユーザーが大規模言語モデル(LLM)を効率的にカスタマイズおよび微調整できるようにし、シンプルさ、リソース最適化、AI パーソナライゼーションのための柔軟性に焦点を当てています。

Sagify は、オープンソースの Python ツールで、AWS SageMaker 上の機械学習パイプラインを簡素化し、独自およびオープンソースの大規模言語モデルをシームレスに統合する統一 LLM ゲートウェイを提供します。

ApX Machine Learning:LLM を探索し、学生、ML プロフェッショナル、ローカル LLM 愛好家向けの実際的なガイド、ツール、コースにアクセスするためのプラットフォーム。 最高の LLM を見つけて、AI ワークフローを最適化します。

APIPark は、本番環境で LLM を管理し、安定性とセキュリティを確保するためのオープンソースの LLM ゲートウェイおよび API 開発者ポータルです。 LLM のコストを最適化し、独自の API ポータルを構築します。

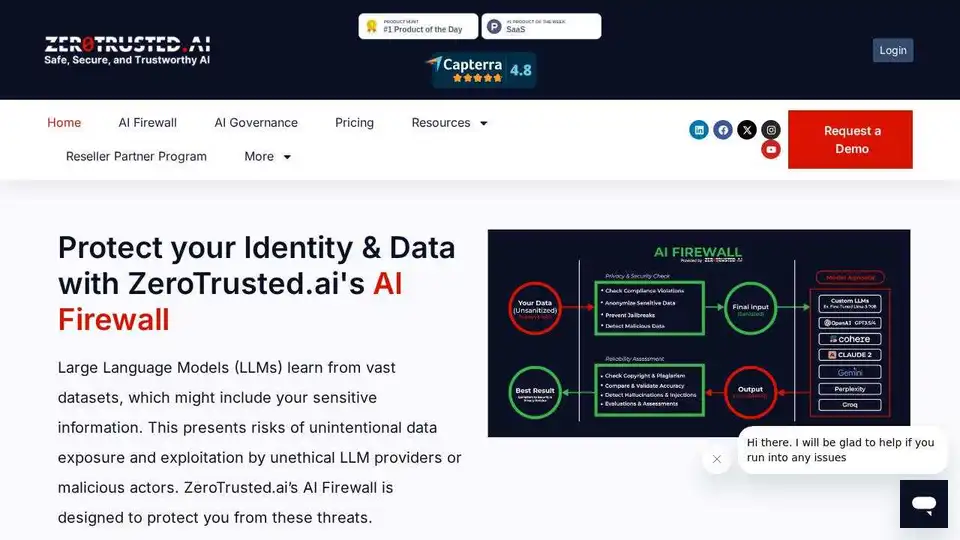

ZeroTrusted.ai は、AI エコシステムを保護するための AI ファイアウォール、AI ゲートウェイ、AI ヘルスチェックを提供します。 未承認の AI ツールを検出してブロックし、データ セキュリティを確保し、コンプライアンスを維持します。

Latitudeは、プロンプトエンジニアリングのためのオープンソースプラットフォームであり、ドメインの専門家がエンジニアと協力して、本番環境グレードのLLM機能を提供できるようにします。自信を持ってAI製品を構築、評価、デプロイします。

Privee AI を探索して、AI キャラクター、チャット、ロールプレイ、ライティングのアプリを作成します。 キャラクターを作成するか、AI アニメやファンタジー キャラクターと対話して、無限の可能性を実現します。

トップ大学の人工知能コースと認定を見つけましょう。 AI、機械学習、深層学習などを学びます。レビューを読んで、適切なクラスを選択してください。

Portkeyは、AIチームに本番環境に対応したスタックを提供します。ゲートウェイ、可観測性、ガードレール、ガバナンス、プロンプト管理を1つのプラットフォームに統合。

Helicone AI Gateway:信頼性の高いAIアプリのルーティングと監視。急速に成長しているAI企業のLLMOpsプラットフォーム。