Cloudflare Workers AI 개요

Cloudflare Workers AI란 무엇인가요?

Cloudflare Workers AI는 개발자가 Cloudflare의 글로벌 네트워크에서 직접 머신 러닝 추론 작업을 실행할 수 있도록 지원하는 서버리스 AI 플랫폼입니다. 즉, AI 애플리케이션을 사용자에게 더 가까이 배포하여 더 빠른 성능과 낮은 대기 시간을 제공할 수 있습니다. 복잡한 인프라 설정을 없애 AI를 애플리케이션에 더 쉽고 비용 효율적으로 통합할 수 있습니다.

Cloudflare Workers AI는 어떻게 작동하나요?

Cloudflare Workers AI는 Cloudflare Workers 플랫폼을 활용하여 Cloudflare의 글로벌 네트워크에 분산된 NVIDIA GPU에서 AI 모델을 실행합니다. 이를 통해 추가 설정 없이 생성적 AI 작업을 실행할 수 있습니다.

주요 기능은 다음과 같습니다.

- GPU 기반 서버리스 AI: NVIDIA GPU의 글로벌 네트워크에서 AI 모델을 실행합니다.

- 사전 훈련된 모델: Llama-2, Whisper, ResNet50과 같은 인기 모델 카탈로그에서 선택합니다.

- 글로벌 가용성: REST API를 통해 Workers, Pages 또는 모든 서비스에서 AI 모델에 액세스합니다.

- 벡터 데이터베이스 통합: Vectorize를 사용하여 향상된 AI 워크플로우를 위한 임베딩을 생성하고 저장합니다.

- AI Gateway: 캐싱, 속도 제한 및 분석을 통해 안정성과 확장성을 개선합니다.

- 멀티 클라우드 훈련: R2를 사용하여 멀티 클라우드 훈련 아키텍처를 위한 비용 효율적이고 이그레스 없는 데이터 스토리지를 제공합니다.

Cloudflare Workers AI 사용 방법

- 모델 선택: 텍스트 생성, 이미지 분류, 음성 인식 등 필요에 따라 Workers AI 카탈로그에서 사전 훈련된 모델을 선택합니다.

- Workers와 통합: Cloudflare Worker 내에서 Workers AI API를 사용하여 데이터를 모델로 보내고 추론 결과를 받습니다.

- 글로벌 배포: Cloudflare는 AI 애플리케이션을 글로벌 네트워크에 자동으로 배포하여 전 세계 사용자에게 낮은 대기 시간을 보장합니다.

사용 사례 예시:

- 이미지 분류: 이미지에서 객체 또는 장면을 식별합니다.

- 감성 분석: 텍스트의 감성(긍정, 부정, 중립)을 판단합니다.

- 음성 인식: 오디오를 텍스트로 변환합니다.

- 텍스트 생성: 콘텐츠의 창의적인 텍스트 형식을 생성합니다.

- 번역: 텍스트를 한 언어에서 다른 언어로 번역합니다.

Cloudflare Workers AI를 선택해야 하는 이유

- 낮은 대기 시간: 사용자에게 더 가까운 곳에서 AI 모델을 실행하여 더 빠른 응답 시간을 제공합니다.

- 확장성: Cloudflare의 글로벌 네트워크는 증가하는 수요를 처리하기 위해 자동으로 확장됩니다.

- 비용 효율성: 종량제 가격 책정으로 초기 인프라 투자가 필요하지 않습니다. 이 플랫폼은 청구가 시작되기 전에 매일 10,000개의 무료 뉴런을 제공합니다.

- 사용 편의성: 간소화된 설정과 다른 Cloudflare 서비스와의 통합으로 AI 개발이 간소화됩니다.

- 향상된 제어 및 보호: AI Gateway는 LLM 애플리케이션에 제어 및 보호 계층을 추가하여 속도 제한 및 캐싱을 적용하여 백엔드 인프라를 보호하고 예기치 않은 요금을 방지할 수 있습니다.

- 비용 효율적인 훈련: R2를 사용한 이그레스 없는 스토리지를 통해 LLM 훈련을 위한 멀티 클라우드 아키텍처를 저렴하게 만들 수 있습니다.

Cloudflare Workers AI는 누구를 위한 것인가요?

Cloudflare Workers AI는 다음과 같은 개발자 및 기업에 이상적입니다.

- 복잡한 인프라를 관리하지 않고 AI를 웹 애플리케이션에 통합하려는 경우

- 전 세계 사용자에게 빠르고 낮은 대기 시간의 AI 경험을 제공하려는 경우

- AI 애플리케이션을 효율적이고 비용 효율적으로 확장하려는 경우

고객 성공 사례:

SiteGPT.ai의 설립자인 Bhanu Teja Pachipulusu는 다음과 같이 말합니다.

"저희는 스토리지, 캐시, 큐, 그리고 가장 중요한 훈련 데이터와 엣지에 앱을 배포하는 데 필요한 모든 것을 Cloudflare를 사용하고 있기 때문에 제품의 안정성과 속도를 보장할 수 있습니다. 또한 가장 저렴한 옵션이기도 하며, 경쟁사는 Cloudflare의 한 달 비용보다 단 하루 요청에 더 많은 비용을 청구합니다."

"Cloudflare Workers AI"의 최고의 대체 도구

Baseten은 프로덕션 환경에서 AI 모델을 배포하고 확장하기 위한 플랫폼입니다. Baseten Inference Stack에서 제공하는 고성능 모델 런타임, 클라우드 간 고가용성 및 원활한 개발자 워크플로를 제공합니다.

Avian API는 오픈 소스 LLM에 가장 빠른 AI 추론을 제공하여 DeepSeek R1에서 351 TPS를 달성합니다. OpenAI 호환 API를 사용하여 HuggingFace LLM을 3~10배 빠른 속도로 배포하십시오. 엔터프라이즈급 성능 및 개인 정보 보호.

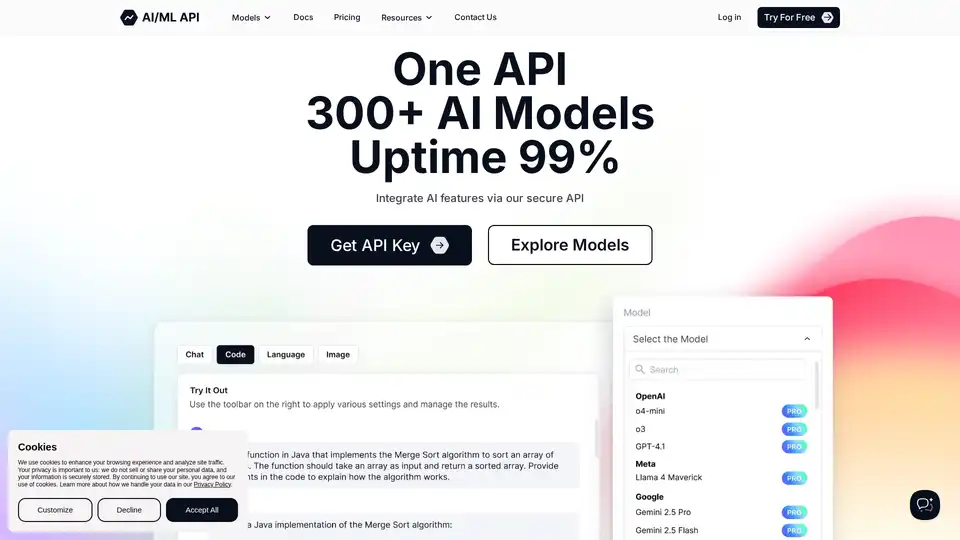

AIMLAPI는 단일, 낮은 대기 시간 API를 통해 300개 이상의 AI 모델에 대한 액세스를 제공합니다. 머신 러닝을 위한 빠르고 비용 효율적인 AI 솔루션으로 OpenAI에 비해 최대 80%를 절약하십시오.

Float16.cloud는 AI 개발을 위한 서버리스 GPU를 제공합니다. 사용량에 따른 요금제로 H100 GPU에 모델을 즉시 배포하십시오. LLM, 미세 조정 및 교육에 이상적입니다.

Runpod는 AI 모델 구축 및 배포를 단순화하는 AI 클라우드 플랫폼입니다. AI 개발자를 위해 온디맨드 GPU 리소스, 서버리스 확장 및 엔터프라이즈급 가동 시간을 제공합니다.

GPUX는 StableDiffusionXL, ESRGAN, AlpacaLLM과 같은 AI 모델을 위해 1초 콜드 스타트를 가능하게 하는 서버리스 GPU 추론 플랫폼으로, 최적화된 성능과 P2P 기능을 갖추고 있습니다.

개발자를 위한 번개처럼 빠른 AI 플랫폼. 간단한 API로 200개 이상의 최적화된 LLM과 멀티모달 모델 배포, 미세 조정 및 실행 - SiliconFlow.

Inferless는 ML 모델 배포를 위한 초고속 서버리스 GPU 추론을 제공합니다. 자동 확장, 동적 배치 처리, 기업 보안 등의 기능으로 확장 가능하고 수월한 맞춤형 머신러닝 모델 배포를 가능하게 합니다.

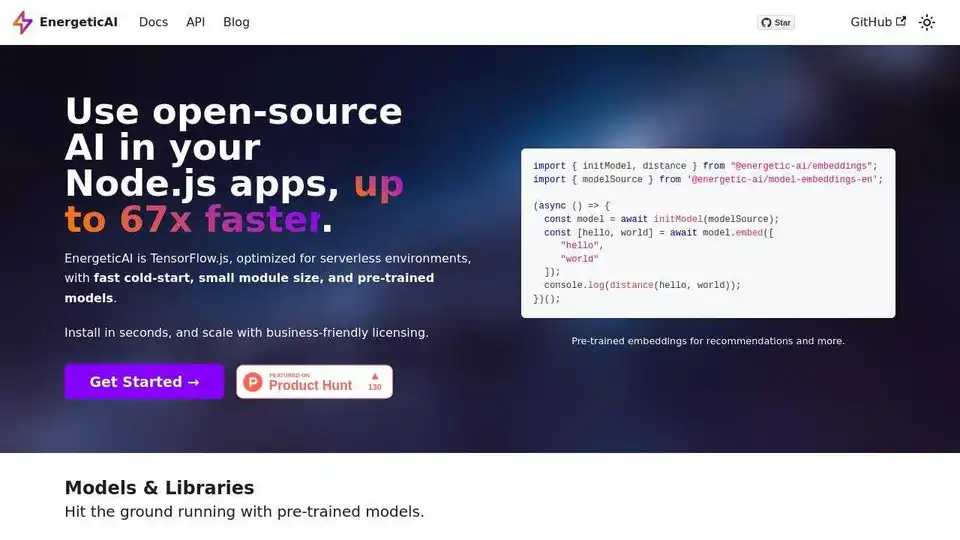

EnergeticAI는 서버리스 기능에 최적화된 TensorFlow.js로, 빠른 콜드 스타트, 작은 모듈 크기, 사전 훈련된 모델을 제공하여 Node.js 앱에서 AI 액세스 속도를 최대 67배까지 향상시킵니다.

Synexa를 사용하여 AI 배포를 간소화하세요. 단 한 줄의 코드로 강력한 AI 모델을 즉시 실행할 수 있습니다. 빠르고 안정적이며 개발자 친화적인 서버리스 AI API 플랫폼입니다.

fal.ai: Gen AI를 사용하는 가장 쉽고 비용 효율적인 방법입니다. 무료 API와 함께 생성 미디어 모델을 통합합니다. 600개 이상의 프로덕션 준비 모델입니다.

Modal: AI 및 데이터 팀을 위한 서버리스 플랫폼입니다. 자신의 코드를 사용하여 대규모로 CPU, GPU 및 데이터 집약적 컴퓨팅을 실행하십시오.

서버를 설정하지 않고도 HuggingFace에서 Llama 모델을 즉시 실행할 수 있습니다. 11,900개 이상의 모델을 사용할 수 있습니다. 무제한 액세스에 월 $10부터 시작합니다.

Julep AI: AI 에이전트 워크플로를 구축하기 위한 백엔드. 완전한 추적성과 제로 운영 오버헤드로 AI 에이전트를 설계, 배포 및 확장합니다.