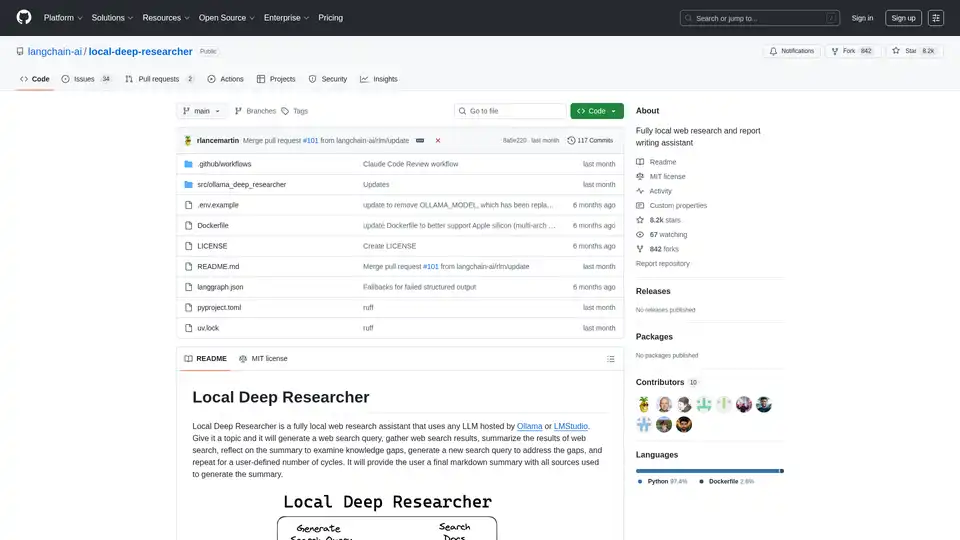

Local Deep Researcher 개요

Local Deep Researcher란 무엇인가요?

Local Deep Researcher는 사용자의 기기에서 완전히 로컬로 작동하도록 설계된 혁신적인 오픈소스 웹 연구 어시스턴트입니다. 이 강력한 도구는 Ollama 또는 LMStudio를 통해 대형 언어 모델(LLM)을 활용하여 포괄적인 웹 연구를 수행하고 적절한 출처 인용이 포함된 상세한 보고서를 생성합니다.

Local Deep Researcher의 작동 방식

시스템은 지능적인 반복 연구 프로세스를 따릅니다:

연구 사이클 프로세스:

- 쿼리 생성: 사용자 제공 주제에 따라 로컬 LLM이 최적화된 웹 검색 쿼리를 생성

- 소스 검색: 구성된 검색 도구(DuckDuckGo, SearXNG, Tavily 또는 Perplexity)를 사용하여 관련 온라인 소스를 찾음

- 내용 요약: LLM이 웹 검색 결과의 발견을 분석하고 요약

- 갭 분석: 시스템이 요약을 반성하여 지식 갭과 누락된 정보를 식별

- 반복적 개선: 식별된 갭을 해결하기 위한 새로운 검색 쿼리를 생성하고 프로세스를 반복

- 최종 보고서 생성: 여러 사이클(사용자에 의해 구성 가능) 후에 모든 소스가 적절히 인용된 포괄적인 마크다운 보고서를 생성

핵심 기능 및 능력

- 완전 로컬 작동: 모든 처리 로컬에서 발생하여 데이터 프라이버시와 보안을 보장

- 다중 LLM 지원: Ollama 또는 LMStudio를 통해 호스팅된 모든 LLM과 호환

- 유연한 검색 통합: DuckDuckGo(기본), SearXNG, Tavily 및 Perplexity 검색 API 지원

- 구성 가능한 연구 깊이: 사용자가 연구 사이클 수(기본: 3회 반복)를 설정 가능

- 구조화된 출력: 적절한 소스 인용이 포함된 잘 포맷된 마크다운 보고서 생성

- 시각적 워크플로우 모니터링: LangGraph Studio와 통합하여 실시간 프로세스 시각화

기술 요구사항 및 설정

지원 플랫폼:

- macOS(추천)

- Windows

- Docker를 통한 Linux

필요한 구성 요소:

- Python 3.11+

- 로컬 LLM 호스팅을 위한 Ollama 또는 LMStudio

- 프리미엄 검색 서비스를 위한 선택적 API 키

설치 및 구성

빠른 설정 프로세스:

- GitHub에서 저장소 클론

- .env 파일에서 환경 변수 구성

- 선호하는 LLM 제공자 선택(Ollama 또는 LMStudio)

- 검색 API 구성 선택

- LangGraph Studio를 통해 실행

Docker 배포: 프로젝트에는 컨테이너화 배포를 위한 Docker 지원이 포함되어 있지만, Ollama는 적절한 네트워크 구성으로 별도로 실행해야 합니다.

모델 호환성 고려사항

시스템은 구조화된 JSON 출력을 생성할 수 있는 LLM을 요구합니다. DeepSeek R1(7B 및 1.5B)과 같은 일부 모델은 JSON 모드에 제한이 있을 수 있지만, 어시스턴트에는 이러한 경우를 처리하기 위한 대체 메커니즘이 포함되어 있습니다.

누가 Local Deep Researcher를 사용해야 할까?

이상적인 사용자:

- 연구자 및 학자가 포괄적인 문헌 검토를 필요로 할 때

- 콘텐츠 크리에이터가 잘 연구된 배경 정보를 필요로 할 때

- 학생이 연구 논문 및 과제에 작업할 때

- 기자가 조사 연구를 수행할 때

- 비즈니스 전문가가 시장 연구 및 경쟁 분석을 필요로 할 때

- 프라이버시를 중시하는 사용자가 클라우드 기반 솔루션보다 로컬 처리를 선호할 때

실용적 응용 및 사용 사례

- 학술 연구: 문헌 검토 수행 및 논문을 위한 소스 수집

- 시장 분석: 경쟁자 및 산업 트렌드 연구

- 콘텐츠 연구: 블로그 포스트, 기사, 보고서를 위한 정보 수집

- 실사 조사: 적절한 소스 문서와 함께 주제를 철저히 조사

- 학습 및 교육: 자동화된 연구 지원으로 주제를 깊이 탐구

왜 Local Deep Researcher를 선택할까?

주요 이점:

- 완전한 프라이버시: 연구 주제와 데이터가 로컬 기기를 떠나지 않음

- 비용 효과적: 기본 검색 기능에 API 비용 없음

- 맞춤형: 특정 요구에 맞게 연구 깊이 및 소스 조정

- 투명성: 연구 프로세스와 사용된 소스에 대한 완전한 가시성

- 오픈소스: 커뮤니티 주도 개발 및 지속적 개선

최적의 결과를 얻기 위해

최적 성능을 위해:

- 가능할 때 더 크고 유능한 LLM 모델 사용

- 특정 요구에 적합한 검색 API 구성

- 주제 복잡성에 따라 연구 사이클 수 조정

- 중요한 연구를 위해 중요한 소스를 수동으로 검토 및 검증

Local Deep Researcher는 로컬 AI 기반 연구 도구의 중요한 발전을 나타내며, 대형 언어 모델의 힘과 실용적인 웹 연구 능력을 결합하여 완전한 데이터 프라이버시와 제어를 유지합니다.

"Local Deep Researcher"의 최고의 대체 도구

GPT Researcher는 심층 연구를 자동화하는 오픈 소스 AI 연구 도우미입니다. 신뢰할 수 있는 소스에서 정보를 수집하고 결과를 집계하여 포괄적인 보고서를 신속하게 생성합니다. 편견 없는 통찰력을 찾는 개인 및 팀에게 이상적입니다.

ScanRelief는 OpenAI를 사용하여 영수증 파일을 Excel로 변환하고 더 나은 구성을 위해 파일 이름을 변경하는 소프트웨어로, 비용 추적 및 회계 처리를 간소화합니다.

WhisperClip은 로컬 AI를 사용하여 음성을 텍스트로 변환하는 무료 macOS 앱입니다. 인터넷 연결이 필요 없고 완전한 개인 정보 보호를 제공하며, 변환된 텍스트를 모든 애플리케이션에 자동으로 붙여넣습니다.

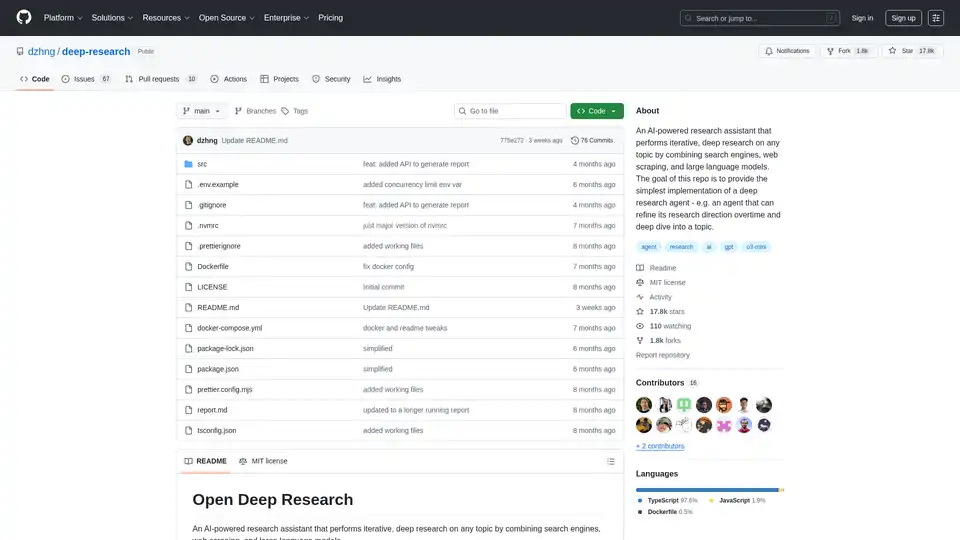

Deep Research는 검색 엔진, 웹 스크래핑 및 LLM을 결합하여 모든 주제에 대한 반복적이고 심층적인 연구를 수행하는 AI 기반 연구 도우미입니다. 지능형 쿼리 생성 및 포괄적인 보고서를 통해 심층 분석을 단순화합니다.

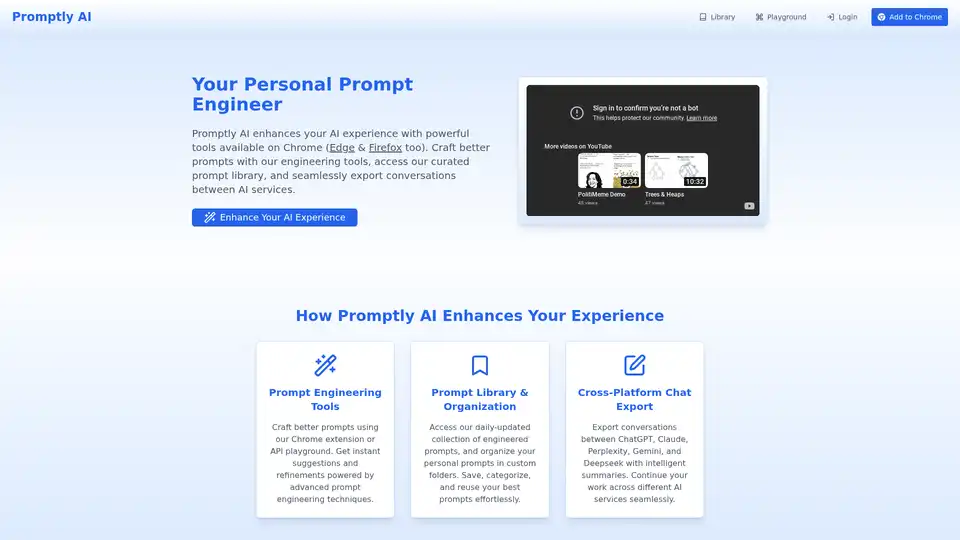

Promptly AI로 AI 상호작용을 혁신하세요. 더 나은 프롬프트를 만들고, 큐레이션된 라이브러리에 액세스하며, ChatGPT, Claude, Perplexity, Gemini, Deepseek 간 대화를 내보내세요.

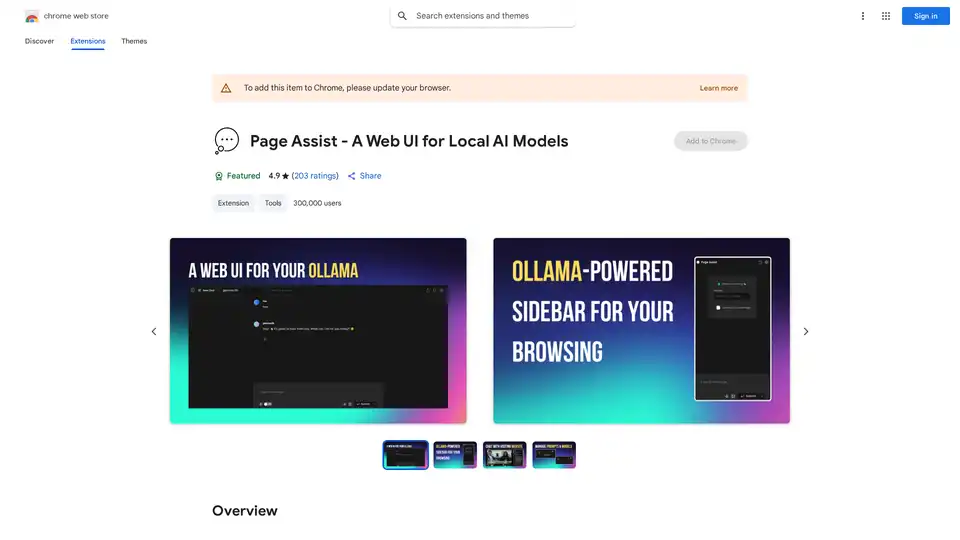

Page Assist는 Chrome 확장 프로그램으로, 웹 브라우징 중에 로컬에서 실행되는 AI 모델을 사용하기 위한 사이드바 인터페이스를 제공하며 Ollama, Chrome AI 및 OpenAI 호환 API를 지원합니다.

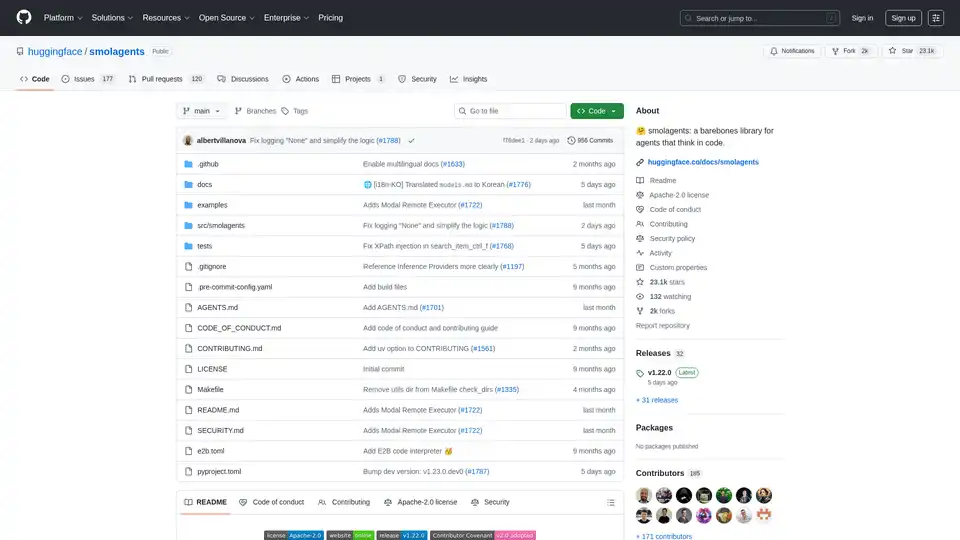

smolagents는 코드로 추론하고 행동하는 AI 에이전트를 생성하기 위한 미니멀리즘 Python 라이브러리입니다. LLM-agnostic 모델, 보안 샌드박스, Hugging Face Hub와의 원활한 통합을 지원하여 효율적인 코드 기반 에이전트 워크플로를 제공합니다.

Vagent는 n8n으로 구축된 사용자 지정 AI 에이전트를 위한 깨끗하고 음성 지원 인터페이스를 제공합니다. 단일 webhook를 통해 60개 이상의 언어로 자연스러운 음성 상호 작용을 통합하며, 로컬 데이터 저장으로 등록이 필요 없습니다.

Agent TARS는 브라우저 작업, 명령줄, 파일 시스템을 원활하게 통합하여 워크플로 자동화를 강화하는 오픈소스 멀티모달 AI 에이전트입니다. 고급 시각 해석과 정교한 추론으로 효율적인 작업 처리를 경험하세요.

CSV를 로드하고 시각적 단계별 인터페이스에서 분석하세요. 개인 AI 에이전트를 사용해 정리, 추출, 요약 또는 감정 분석을 수행하세요。

PDF Pals는 Mac용 네이티브 앱으로 AI를 사용해 어떤 PDF와도 즉시 채팅할 수 있습니다. 파일 크기 제한 없음. 빠른 OCR, 프라이버시를 위한 로컬 저장, OpenAI API 지원을 즐기세요. 문서 분석을 하는 연구원, 개발자, 전문가에게 완벽합니다.

Devika AI는 고급 명령을 이해하고, 이를 세분화하고, 관련 정보를 연구하고, Claude 3, GPT-4, GPT-3.5 및 로컬 LLM을 사용하여 코드를 생성할 수 있는 오픈 소스 AI 소프트웨어 엔지니어입니다.

Nightwatch는 정확한 순위 추적, 사이트 감사 및 보고 기능을 제공하는 AI 기반 SEO 모니터링 도구입니다. 키워드를 추적하고 검색 가시성을 모니터링하며 더 높은 순위를 위해 웹 사이트를 최적화하십시오.

MyReport는 보고서 및 에세이에 대한 데이터 수집, 작성 및 인용을 자동화하여 시간을 절약하고 완전하고 문서화된 문서를 신속하게 생성합니다.