Parea AI 개요

Parea AI: AI 팀을 위한 실험 및 어노테이션 플랫폼

Parea AI는 AI 팀이 프로덕션 환경에 바로 배포할 수 있는 대규모 언어 모델(LLM) 애플리케이션을 구축하고 자신 있게 배포할 수 있도록 설계된 포괄적인 플랫폼입니다. Parea AI는 실험 추적, 관찰 가능성, 휴먼 어노테이션, 프롬프트 배포를 위한 도구를 제공하여 개발 프로세스를 간소화하고 고품질의 안정적인 AI 솔루션을 보장합니다.

Parea AI란 무엇인가요?

Parea AI는 AI 팀이 LLM 애플리케이션을 테스트, 평가 및 개선할 수 있도록 지원하는 엔드 투 엔드 플랫폼입니다. 실험 관리, 성능 추적, 사용자 피드백 수집, 최적화된 프롬프트 배포를 위한 중앙 집중식 허브를 제공합니다. Parea AI는 OpenAI, Anthropic, LangChain 등을 포함한 주요 LLM 제공업체 및 프레임워크를 지원하므로 광범위한 AI 프로젝트를 위한 다용도 솔루션입니다.

Parea AI는 어떻게 작동하나요?

Parea AI는 간단한 Python 및 JavaScript SDK를 통해 기존 개발 워크플로와 원활하게 통합됩니다. 이러한 SDK를 통해 다음을 수행할 수 있습니다.

- LLM 호출 자동 추적: Parea AI는 LLM과의 모든 상호 작용을 자동으로 추적하고 기록하여 성능 및 동작에 대한 자세한 통찰력을 제공합니다.

- 성능 평가: 사용자 정의 평가 함수를 정의하고 실행하여 LLM 출력의 품질을 평가합니다.

- 사용자 피드백 수집: 최종 사용자, 주제 matter 전문가 및 제품 팀으로부터 피드백을 수집하여 모델 정확도와 관련성을 개선합니다.

- 프롬프트 실험: 샘플에서 여러 프롬프트를 수정하고, 대규모 데이터 세트에서 테스트하고, 가장 성능이 좋은 프롬프트를 프로덕션 환경에 배포합니다.

- 프로덕션 데이터 모니터링: 프로덕션 및 스테이징 데이터를 기록하여 문제를 디버깅하고, 온라인 평가를 실행하고, 사용자 피드백을 캡처합니다.

Parea AI의 주요 기능

- 자동 도메인별 평가 생성: 특정 도메인에 맞게 조정된 평가 함수를 자동으로 생성하여 정확하고 관련성 높은 성능 평가를 보장합니다.

- 실험 추적: 다양한 실험의 성능을 시간 경과에 따라 추적하고 비교하여 가장 효과적인 접근 방식을 식별할 수 있습니다.

- 사용자 검토: 사용자 피드백을 수집하고 관리하여 모델 정확도와 관련성을 개선합니다. Q&A 및 미세 조정을 위해 로그에 주석을 답니다.

- 프롬프트 Playground 및 배포: 다양한 프롬프트를 실험하고 가장 성능이 좋은 프롬프트를 프로덕션 환경에 배포합니다.

- 관찰 가능성: 프로덕션 및 스테이징 데이터를 기록하여 문제를 디버깅하고, 온라인 평가를 실행하고, 사용자 피드백을 캡처합니다. 비용, 대기 시간 및 품질을 한 곳에서 추적합니다.

- 데이터 세트: 스테이징 및 프로덕션 환경의 로그를 테스트 데이터 세트에 통합하고 이를 사용하여 모델을 미세 조정합니다.

Parea AI의 사용 사례

Parea AI는 다음과 같은 광범위한 사용 사례에 적합합니다.

- 프로덕션 환경에 바로 배포할 수 있는 LLM 애플리케이션 구축: Parea AI는 고품질 LLM 애플리케이션을 개발하고 배포하는 데 필요한 도구와 인프라를 제공합니다.

- RAG 파이프라인 최적화: 다양한 프롬프트와 평가 지표를 실험하여 검색 증강 생성(RAG) 파이프라인의 성능을 개선합니다.

- 빠른 프로토타입 제작 및 연구: 새로운 AI 모델과 기술을 신속하게 프로토타입 제작하고 테스트합니다.

- 도메인별 평가 구축: 특정 도메인에 맞게 조정된 사용자 정의 평가 함수를 만듭니다.

- AI 팀의 역량 강화: AI 팀에게 LLM으로 성공하는 데 필요한 도구와 교육을 제공합니다.

Parea AI는 누구를 위한 것인가요?

Parea AI는 다음 사용자를 위해 설계되었습니다.

- AI 엔지니어: LLM 애플리케이션의 개발 및 배포를 간소화합니다.

- 데이터 과학자: AI 모델의 성능을 분석하고 개선합니다.

- 제품 관리자: 사용자로부터 피드백을 수집하고 AI 애플리케이션이 사용자의 요구 사항을 충족하는지 확인합니다.

- AI 팀: AI 프로젝트에서 협업하고 모범 사례를 공유합니다.

가격 계획

Parea AI는 모든 규모의 팀에 적합한 다양한 가격 계획을 제공합니다.

- Free: 월 $0, 모든 플랫폼 기능, 최대 2명의 팀원, 3,000개의 로그/월, 10개의 배포된 프롬프트가 포함됩니다.

- Team: 월 $150, 3명의 멤버(추가 멤버당 +$50/월), 100,000개의 로그/월, 무제한 프로젝트, 100개의 배포된 프롬프트가 포함됩니다.

- Enterprise: 사용자 지정 가격, 온프레미스/자체 호스팅, 지원 SLA, 무제한 로그 및 배포된 프롬프트, SSO 적용, 추가 보안 및 규정 준수 기능이 포함됩니다.

Parea AI를 선택해야 하는 이유

Parea AI는 다른 AI 실험 및 어노테이션 플랫폼에 비해 몇 가지 주요 이점을 제공합니다.

- 포괄적인 기능 세트: Parea AI는 고품질 LLM 애플리케이션을 구축하고 배포하는 데 필요한 모든 도구를 제공합니다.

- 간편한 통합: Parea AI는 기존 개발 워크플로와 원활하게 통합됩니다.

- 확장 가능한 아키텍처: Parea AI는 모든 규모의 팀의 요구 사항을 충족하도록 확장할 수 있습니다.

- 전담 지원: Parea AI는 플랫폼을 최대한 활용할 수 있도록 전담 지원을 제공합니다.

Parea AI를 활용함으로써 AI 팀은 LLM 개발 프로세스의 효율성과 효과를 크게 개선하여 고품질 AI 솔루션과 더 빠른 시장 출시 시간을 달성할 수 있습니다.

Parea AI란 무엇인가요? LLM 애플리케이션을 평가하고 개선하는 플랫폼입니다. Parea AI는 어떻게 작동하나요? 코Integrationode와 통합되어 모델을 추적, 평가하고 피드백을 수집합니다. Parea AI를 사용하는 방법은 무엇인가요? Python 또는 JavaScript SDK를 사용하여 Parea AI를 워크플로에 통합합니다. Parea AI를 선택해야 하는 이유는 무엇인가요? 포괄적인 기능 세트와 간편한 통합을 제공합니다. Parea AI는 누구를 위한 것인가요? AI 엔지니어, 데이터 과학자 및 제품 관리자를 위해 설계되었습니다. LLM 애플리케이션을 최적화하는 가장 좋은 방법은 무엇인가요? Parea AI를 사용하여 데이터와 피드백을 기반으로 모델을 추적, 평가 및 개선합니다.

"Parea AI"의 최고의 대체 도구

Parea AI는 AI 팀을 위한 궁극의 실험 및 인간 주석 플랫폼으로, LLM 평가, 프롬프트 테스트, 그리고 안정적인 AI 애플리케이션 구축을 위한 프로덕션 배포를 원활하게 합니다.

Athina는 팀이 LLM 기반 기능을 10배 빠르게 구축, 테스트, 모니터링할 수 있도록 돕는 협업 AI 플랫폼입니다. 프롬프트 관리, 평가, 관찰성 도구를 제공하며 데이터 프라이버시를 보장하고 사용자 지정 모델을 지원합니다.

Maxim AI는 포괄적인 테스트, 모니터링 및 품질 보증 도구를 갖춘 end-to-end 평가 및 관찰 가능성 플랫폼으로, 팀이 AI 에이전트를 안정적으로 5배 더 빠르게 출시할 수 있도록 지원합니다.

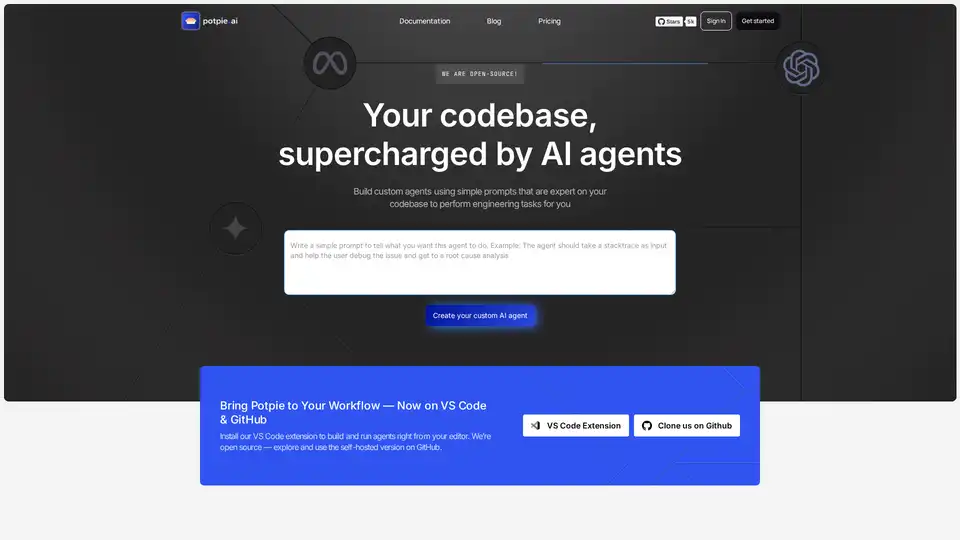

데이터의 지능과 컨텍스트로 구동되는 고정밀 엔지니어링 작업을 수행하는 코드베이스용 작업 지향 커스텀 에이전트를 구축하세요. 시스템 설계, 디버깅, 통합 테스트, 온보딩 등의 사용 사례를 위해 에이전트를 구축하세요.