Supermemory

Visão geral de Supermemory

Supermemória: A Camada de Memória para a Era da IA

O que é Supermemória? Supermemória é apresentada como um laboratório de pesquisa e produtos focado na construção da camada de memória para IA, com o objetivo de fornecer memória dinâmica, semelhante à humana, que possa ser dimensionada de forma eficiente. Ela fornece ferramentas para desenvolvedores e usuários finais para aproveitar a memória da IA em seus aplicativos e fluxos de trabalho.

Principais recursos:

- API e Roteador de Memória: Supermemória oferece uma API e Roteador de Memória rápidos e escaláveis, permitindo que os desenvolvedores adicionem recursos de memória de longo prazo aos seus aplicativos.

- Criação e Armazenamento Eficientes de Memória: O sistema promete criação, armazenamento e recursos de pesquisa de memória eficientes.

- Desempenho: Supermemória afirma ser 2 vezes mais rápido e barato do que as soluções de memória existentes.

- Memória Multi-Cliente: Os usuários podem acessar suas memórias em vários clientes de IA, incluindo ChatGPT, Claude e Cursor.

- Integração: Supermemória se integra com mais de 100 clientes de IA via MCP (Painel de Controle de Memória).

- Criação e Inferência Automáticas de Memória: O sistema suporta a criação e inferência automática de memória usando gráficos.

Como funciona a Supermemória?

Supermemória funciona fornecendo uma API e SDK (Supermemory SDK) que os desenvolvedores podem usar para integrar recursos de memória em seus aplicativos de IA. Ele permite o armazenamento e recuperação eficientes de informações, permitindo que os modelos de IA retenham e recordem interações e dados passados.

Como usar a Supermemória?

Para Desenvolvedores: Os desenvolvedores podem usar a API e o SDK da Supermemória para adicionar recursos de memória de longo prazo aos seus aplicativos. Isso envolve:

- Integrar a API em seu aplicativo de IA.

- Utilizar as funções de criação, armazenamento e pesquisa de memória.

- Aproveitar o roteador para gerenciamento eficiente de memória.

Para Usuários: Os usuários podem acessar suas memórias em diferentes clientes de IA usando o MCP, que se integra com mais de 100 clientes de IA. Isso permite que os usuários tenham uma experiência de memória consistente em várias plataformas.

Para quem é a Supermemória?

Supermemória tem como alvo dois grupos principais:

- Desenvolvedores de IA: Desenvolvedores que buscam adicionar recursos de memória aos seus aplicativos de IA podem usar a API e o SDK de Memória.

- Usuários de IA: Usuários que desejam uma experiência de memória unificada em várias plataformas de IA podem se beneficiar do MCP.

Por que a Supermemória é importante?

A memória é um componente crucial dos sistemas inteligentes. Ao fornecer uma camada de memória rápida, escalável e dinâmica, a Supermemória aprimora os recursos dos aplicativos de IA. Isso permite que eles:

- Reteham informações ao longo do tempo.

- Personalizem interações.

- Tomem decisões mais informadas com base em experiências passadas.

Casos de uso:

- Assistentes de IA Personalizados: Crie assistentes de IA que se lembram das preferências do usuário e das interações passadas.

- Chatbots Sensíveis ao Contexto: Desenvolva chatbots que podem manter o contexto e fornecer respostas mais relevantes.

- Agentes de IA Aprimorados: Construa agentes de IA que podem aprender com a experiência e se adaptar a ambientes em mudança.

Existe uma lista de espera para o aplicativo Supermemória?

Sim, existe uma lista de espera para o novo MCP (Painel de Controle de Memória).

Principais conclusões:

Supermemória oferece uma solução para integrar memória em aplicativos de IA. Ao oferecer uma camada de memória que imita a memória humana, ela visa melhorar o desempenho e a personalização das interações de IA. Supermemória é para aqueles que buscam aprimorar aplicativos de IA com recursos de memória de longo prazo, fornecendo um meio de armazenar, recordar e personalizar dados de forma eficiente.

Gestão de Tarefas e Projetos com IA Resumo de Documentos e Leitura com IA Pesquisa Inteligente com IA Análise de Dados com IA Fluxo de Trabalho Automatizado

Melhores ferramentas alternativas para "Supermemory"

Marvin é um framework Python poderoso para construir aplicações de IA com modelos de linguagem grandes (LLM). Simplifica o gerenciamento de estados, coordenação de agentes e saídas estruturadas para desenvolvedores que criam apps inteligentes.

Cerebrium é uma plataforma de infraestrutura de IA sem servidor que simplifica a implantação de aplicativos de IA em tempo real com baixa latência, zero DevOps e faturamento por segundo. Implante LLMs e modelos de visão globalmente.

AgentVoice é uma plataforma de voz de IA que automatiza tarefas como agendar compromissos, atualizar CRMs e enviar textos sem intervenção humana. Oferece conversas naturais, memória com reconhecimento de ferramentas e automação de fluxo de trabalho.

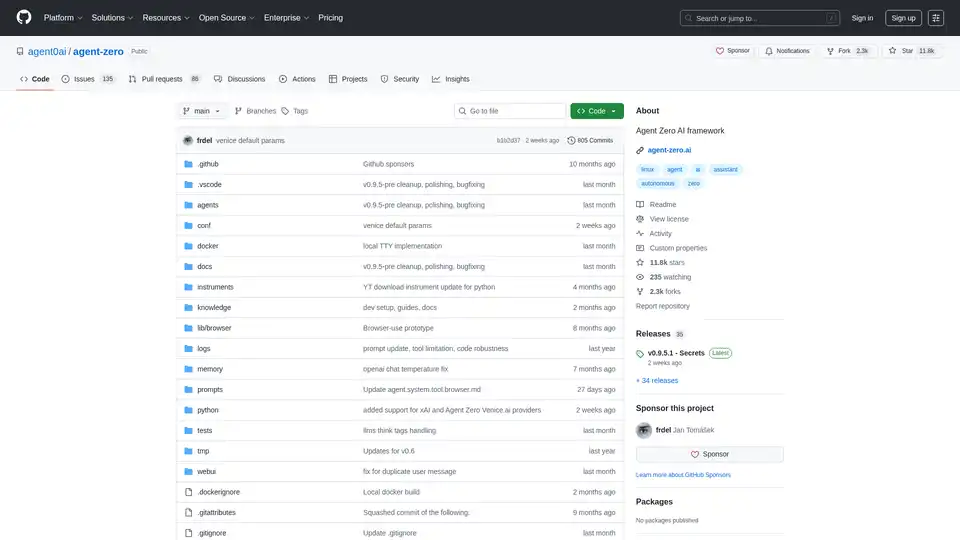

Agent Zero é um framework AI open source para construir agentes autónomos que aprendem e crescem organicamente. Possui cooperação multiagente, execução de código e ferramentas personalizáveis.