FILM Frame Interpolation

Visão geral de FILM Frame Interpolation

O que é Interpolação de Quadros FILM?

FILM, abreviação de Frame Interpolation for Large Motion, é uma rede neural de ponta desenvolvida pela Google Research para gerar quadros intermediários suaves em vídeos, particularmente aqueles envolvendo movimentos significativos de cena. Diferente de métodos tradicionais que dependem de redes pré-treinadas para fluxo óptico ou estimativa de profundidade, FILM usa uma abordagem unificada de rede única. Isso a torna eficiente e poderosa para criar interpolações de alta qualidade diretamente a partir de trios de quadros durante o treinamento. Lançada como uma implementação open-source do TensorFlow 2, é acessível para desenvolvedores e pesquisadores que buscam melhorar a fluidez de vídeos sem configurações complexas.

O modelo se destaca pela capacidade de lidar com grandes movimentos de cena—pense em objetos em movimento rápido ou panorâmicas dinâmicas de câmera—onde técnicas de interpolação convencionais frequentemente falham, produzindo artefatos ou borrões. Ao compartilhar pesos de convolução através de extratores de características multi-escala, FILM alcança pontuações de benchmark de ponta enquanto mantém a arquitetura leve e treinável a partir de entradas básicas.

Como o FILM Funciona?

Em seu núcleo, o FILM processa dois quadros de entrada (frame1 e frame2) para prever quadros intermediários em timestamps especificados. O processo começa com uma etapa de extração de características multi-escala, onde camadas convolucionais analisam as entradas em diferentes resoluções para capturar tanto detalhes finos quanto padrões de movimento mais amplos. Essas características são então fundidas e refinadas através de uma série de operações de sobreamostragem e mistura para gerar o quadro de saída ou sequência de vídeo.

Chave para sua inovação é a evasão de dependências externas. A interpolação de quadros tradicional pode calcular correspondências em nível de pixel usando fluxo óptico, mas o FILM as aprende implicitamente dentro de sua rede. Durante a inferência, você controla a profundidade de interpolação com o parâmetro 'times_to_interpolate': defina como 1 para um único quadro médio (em t=0.5), ou maior (até 8) para um vídeo completo com quadros exponencialmente mais (2^times_to_interpolate + 1 total, a 30 FPS). Essa invocação recursiva garante transições suaves, mesmo em cenários desafiadores como oclusões ou deformações rápidas.

O relatório técnico subjacente de 2022 detalha como o modelo foi treinado em conjuntos de dados de vídeo diversos, otimizando para qualidade perceptual sobre precisão pixel-perfeita. Isso resulta em saídas visualmente agradáveis que imitam a percepção humana, tornando-o ideal para aplicações além da síntese bruta.

Como Usar a Interpolação de Quadros FILM?

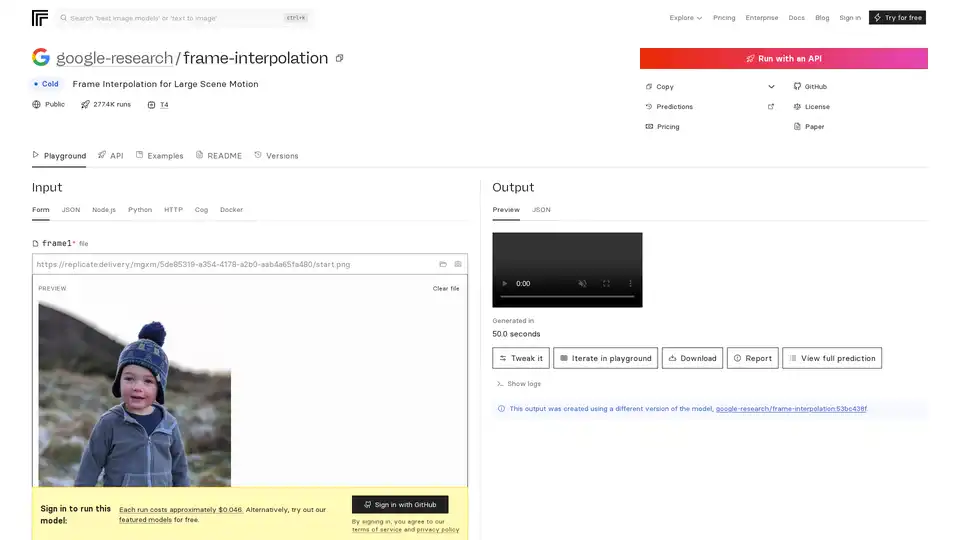

Começar com o FILM é direto, graças ao seu deploy em plataformas como Replicate para acesso API ou seu repositório GitHub para execuções locais.

Via API do Replicate: Faça upload de dois arquivos de imagem como frame1 e frame2. Ajuste 'times_to_interpolate' (padrão 1) para definir a complexidade de saída. As predições rodam em GPUs Nvidia T4, tipicamente completando em menos de 4 minutos, com custos em torno de $0.046 por execução (cerca de 21 execuções por dólar). As saídas incluem imagens de pré-visualização, vídeos baixáveis ou metadados JSON. Nenhum login necessário para testes gratuitos em modelos em destaque, mas login do GitHub desbloqueia acesso completo.

Configuração Local com Docker: Clone o repositório GitHub em https://github.com/google-research/frame-interpolation. Use Docker para isolamento de ambiente fácil—puxe a imagem e execute predições via linha de comando ou integre em scripts Python/Node.js. O framework Cog suporta entradas personalizadas, tornando-o extensível para processamento em lote.

Requisitos de Entrada: Os quadros devem ser imagens sequenciais (p. ex., JPEG/PNG). Para interpolação de vídeo, processe pares recursivamente. Captura via webcam é suportada para testes rápidos.

Exemplos no Replicate mostram usos do mundo real, como interpolar footage esportivo ou sequências animadas, demonstrando resultados sem artefatos.

Por que Escolher FILM para Seus Projetos?

O FILM se destaca onde outras ferramentas falham, oferecendo manuseio superior de grandes movimentos sem a sobrecarga computacional de pipelines multi-modelo. Pontuações de benchmark do paper ECCV 2022 destacam sua vantagem sobre concorrentes em métricas como PSNR e SSIM de interpolação. É open-source sob uma licença permissiva, fomentando contribuições da comunidade—forks e modelos relacionados como zsxkib/film-frame-interpolation-for-large-motion o adaptam para tarefas específicas de vídeo.

A custo-efetividade é outro atrativo: execuções locais gratuitas versus predições em nuvem acessíveis. Além disso, suas demos no YouTube e o paper fornecem validação transparente, construindo confiança para uso em produção. Se você lida com vídeos de baixa FPS irregulares de drones ou câmeras de ação, o FILM os transforma em experiências cinematográficas sem esforço.

Para Quem é a Interpolação de Quadros FILM?

Essa ferramenta visa entusiastas de AI, editores de vídeo e praticantes de machine learning focados em visão computacional.

Desenvolvedores e Pesquisadores: Ideal para experimentar com interpolação neural em papers ou protótipos, especialmente em áreas como compressão de vídeo ou animação.

Criadores de Conteúdo: Cineastas e YouTubers podem upscale taxas de quadros para playback mais suave, aprimorando vídeos móveis ou web sem hardware caro.

Profissionais da Indústria: Em gaming (p. ex., boosting de taxa de quadros para animações mais suaves) ou vigilância (interpolando footage esparso), a eficiência do FILM brilha. Não é adequado para aplicações em tempo real devido a tempos de predição, mas perfeito para aprimoramento offline.

Modelos relacionados no Replicate, como pollinations/rife-video-interpolation ou zsxkib/st-mfnet, complementam o FILM oferecendo workflows de vídeo-para-vídeo, mas o foco do FILM em grande movimento lhe dá uma vantagem nicho.

Valor Prático e Casos de Uso

O verdadeiro poder do FILM reside em sua versatilidade. Na educação, ajuda na criação de análises em slow-motion para demos de física. Para marketing, interpole fotos de produtos para mostrar rotações fluidas. Feedback de usuários no GitHub elogia sua facilidade em lidar com oclusões, comuns em footage real.

Considere um caso: Um videógrafo de vida selvagem com clipes de 15 FPS de uma câmera handheld instável. Usando FILM, eles geram saídas de 30 FPS, preservando detalhes em movimentos rápidos de animais—transformando footage bruto em reels profissionais.

Esquemas de precificação são transparentes: O modelo pay-per-run do Replicate escala com o uso, enquanto self-hosting elimina custos contínuos. Para FAQs, verifique o README para troubleshooting de entradas ou diferenças de versão (p. ex., o atual usa google-research/frame-interpolation:53bc438f).

Em resumo, o FILM representa o compromisso da Google com AI acessível para aprimoramento de mídia. Seja otimizando workflows ou empurrando limites de pesquisa, é uma escolha confiável para interpolação de quadros superior. Mergulhe no repositório GitHub ou playground do Replicate para vê-lo em ação—seus vídeos nunca mais serão os mesmos.

Melhores ferramentas alternativas para "FILM Frame Interpolation"

VideoProc Converter AI é uma solução completa de processamento de mídia com IA para aprimorar, converter, editar, comprimir, baixar e gravar vídeos, imagens e áudio com aceleração GPU. Suporta vídeos 4K/8K, DVDs e mídias online.

VIDIO simplifica a edição de vídeo com IA, reduzindo o tempo e tornando-a acessível para iniciantes. Os recursos incluem gráficos de movimento alimentados por IA, criação de realces, transformação de objetos e aprimoramento de vídeo. Compatível com armazenamento em nuvem e editores de desktop.

Melhore a qualidade de vídeo para 8K com HitPaw VikPea, o aprimorador de vídeo AI que desembaça, restaura e colore seus vídeos com um clique. Experimente aprimoramento de vídeo rápido, estável e em larga escala.

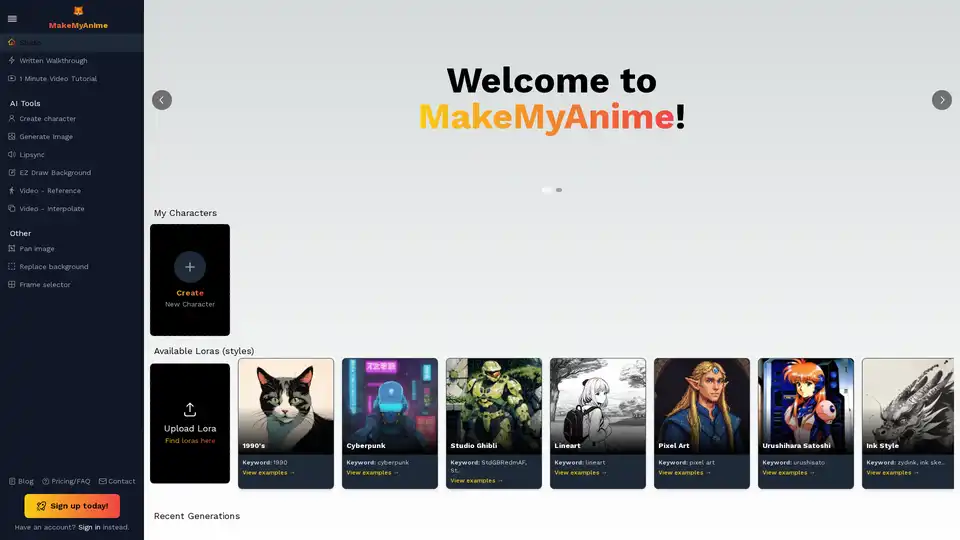

MakeMyAnime oferece ferramentas alimentadas por IA para criar animações facilmente. Os recursos incluem criação de personagens, geração de imagens, sincronização labial e desenho de fundo EZ. Inscreva-se gratuitamente e comece a animar hoje mesmo!

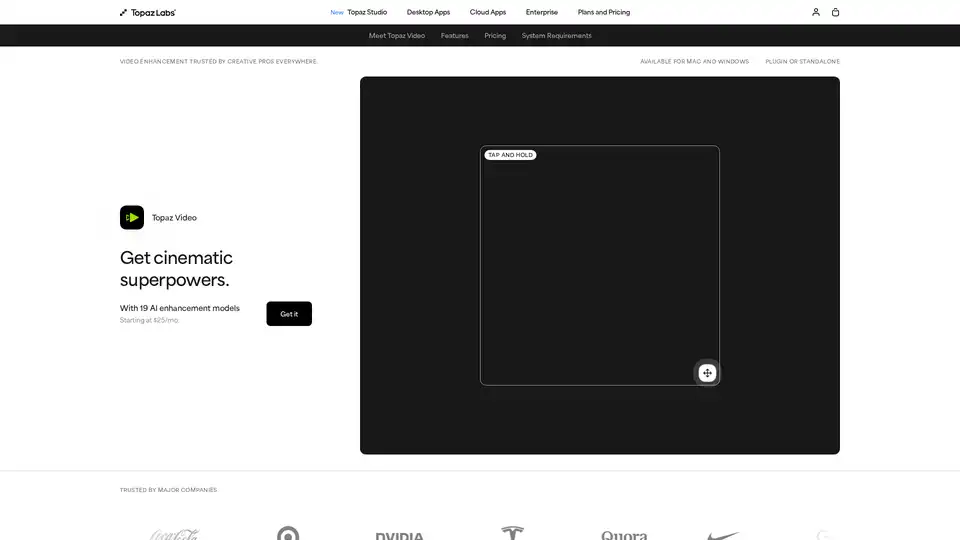

Melhore seus vídeos com o Topaz Video, um software com tecnologia de IA para upscaling, redução de ruído, estabilização e suavização de filmagens. Confiado por profissionais criativos para resultados de nível cinematográfico.

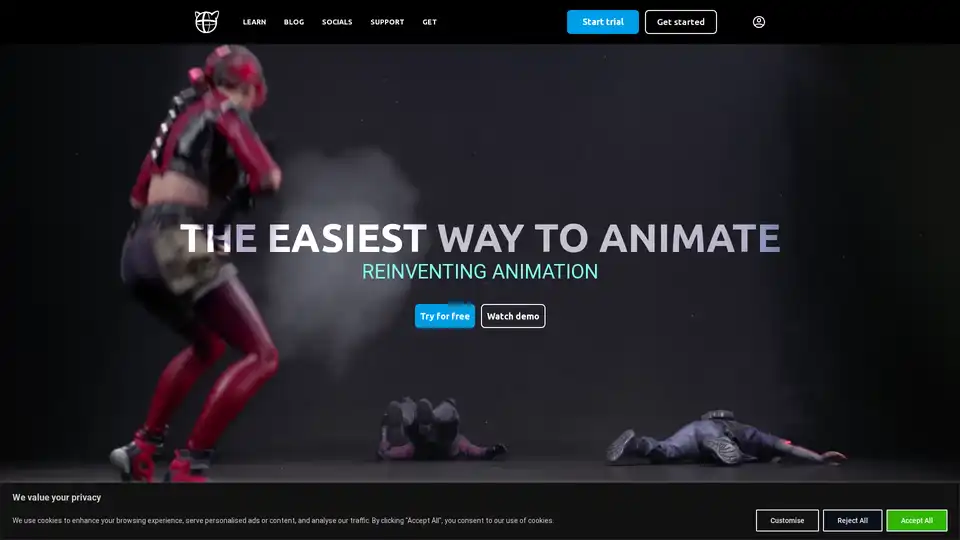

Cascadeur é um software de animação 3D independente que usa IA para auxiliar na animação de keyframes. Ele oferece recursos como AutoPosing, AutoPhysics e rigging de personagens fácil para acelerar o processo de animação e produzir resultados de alta qualidade.

Winxvideo AI é um kit de ferramentas de vídeo AI abrangente para aumentar a qualidade de vídeo/imagem para 4K, estabilizar vídeos tremidos, aumentar fps, converter, comprimir, editar vídeo e gravar tela com aceleração de GPU.

AVCLabs Video Enhancer AI utiliza tecnologia IA avançada para melhorar a qualidade do vídeo, aumentar a resolução de SD para 8K, restaurar filmagens antigas, colorir vídeos em preto e branco e estabilizar imagens tremulas com resultados profissionais.

Descubra bigmp4, uma ferramenta IA de ponta para ampliação de vídeo sem perda em 2K/4K/8K, colorização de preto e branco, interpolação IA para 60-240fps suaves e movimento lento sedoso. Suporta MP4, MOV e mais.

AnyEnhancer é um aprimorador de vídeo AI que transforma vídeos em alta qualidade, aumentando a escala para 4K, reduzindo o ruído, colorindo, suavizando e restaurando rostos. Melhore seu vídeo agora!

Crie seus próprios programas de TV e filmes com o software de criação de vídeo com tecnologia de IA do Focal. Gere a partir de um script, edite com bate-papo e use os modelos de IA mais recentes para extensão de vídeo, interpolação de quadros e muito mais.

Transforme fotos em desenhos animados cativantes com ToonCrafter AI, uma ferramenta de IA de código aberto para interpolação de desenhos animados e geração de vídeo perfeitas. Perfeito para entusiastas de animação e diretores criativos.

Anvsoft oferece ferramentas de vídeo e foto com tecnologia de IA, incluindo o AVCLabs Video Enhancer AI, projetado para aprimorar experiências multimídia.

Aiarty oferece software de aprimoramento e recorte de imagem/vídeo AI para aumentar a escala, aprimorar, restaurar imagens/vídeos, remover ou alterar fundos.