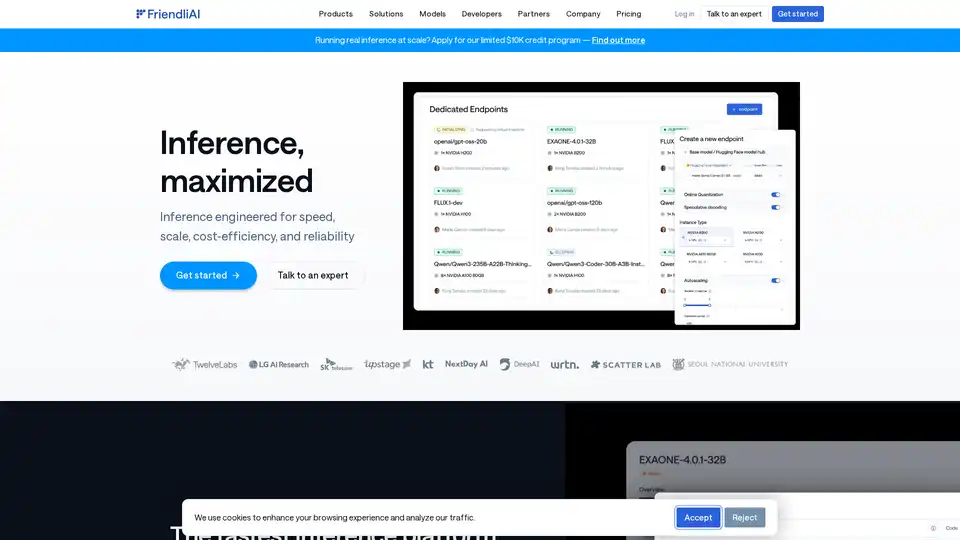

FriendliAI

Visão geral de FriendliAI

FriendliAI: A Empresa de Infraestrutura de IA Generativa

A FriendliAI é uma empresa especializada em infraestrutura de IA generativa, fornecendo uma plataforma projetada para velocidade, escala, custo-eficiência e confiabilidade na inferência de AI. Seu objetivo é maximizar o desempenho dos modelos de AI, oferecendo soluções para empresas que buscam implantar AI em escala.

O que é FriendliAI?

A FriendliAI é uma plataforma de inferência projetada para fornecer uma implantação de modelo de AI rápida e confiável. Ela se destaca por oferecer uma pilha construída especificamente que oferece inferência 2x+ mais rápida, combinando avanços de nível de modelo com otimizações de nível de infraestrutura.

Como funciona a FriendliAI?

A FriendliAI atinge alto desempenho através de vários recursos principais:

- Kernels de GPU personalizados: Otimiza a execução de modelos de AI em GPUs.

- Cache inteligente: Armazena e recupera eficientemente dados usados com frequência.

- Batching contínuo: Agrupa várias solicitações para melhorar a taxa de transferência.

- Decodificação especulativa: Acelera a geração de texto prevendo os próximos tokens.

- Inferência paralela: Distribui a carga de trabalho por várias GPUs.

- Cache avançado: Aprimora ainda mais os mecanismos de cache para acesso mais rápido aos dados.

- Escalabilidade multi-nuvem: Permite escalabilidade entre diferentes provedores de nuvem para flexibilidade e redundância.

Principais recursos e benefícios

- Alta velocidade: Reduz a latência para fornecer uma vantagem competitiva.

- Confiabilidade garantida: Oferece SLAs de tempo de atividade de 99,99% com infraestrutura geo-distribuída.

- Custo-eficiência: Alcança economias de custo significativas, otimizando o uso da GPU.

- Escalabilidade: Dimensiona perfeitamente entre abundantes recursos de GPU.

- Facilidade de uso: Suporta a implantação com um clique para mais de 459.400 modelos Hugging Face.

- Suporte a modelos personalizados: Permite que os usuários tragam seus próprios modelos ajustados ou proprietários.

Por que escolher FriendliAI?

- Taxa de transferência incomparável: Oferece alta taxa de transferência para processamento de grandes volumes de dados.

- Latência ultrabaixa: Garante tempos de resposta rápidos para aplicações em tempo real.

- Disponibilidade global: Fornece desempenho confiável em todas as regiões globais.

- Tolerância a falhas de nível empresarial: Garante que a AI permaneça online e responsiva durante picos de tráfego.

- Monitoramento e conformidade integrados: Oferece ferramentas de monitoramento e uma arquitetura pronta para conformidade.

Para quem é a FriendliAI?

A FriendliAI é adequada para:

- Empresas que escalam aplicações de AI.

- Desenvolvedores que implantam modelos de AI.

- Organizações que buscam inferência de AI econômica.

- Empresas que exigem desempenho de AI confiável.

Como usar a FriendliAI?

Para começar com a FriendliAI:

- Inscreva-se: Crie uma conta na plataforma FriendliAI.

- Implante um modelo: Escolha entre mais de 459.400 modelos Hugging Face ou traga o seu.

- Configure as configurações: Ajuste as configurações de escalabilidade e desempenho.

- Monitore o desempenho: Use ferramentas de monitoramento integradas para rastrear o tempo de atividade e a latência.

Valor prático e casos de uso

A FriendliAI suporta uma ampla variedade de modelos, desde linguagem até áudio e visão. Os modelos de exemplo listados incluem:

- Llama-3.2-11B-Vision (Meta)

- whisper-small-wolof (M9and2M)

- Qwen2.5-VL-7B-Instruct-Android-Control (OfficerChul)

- Muitos mais em diferentes modalidades

Esses modelos destacam a diversificada aplicabilidade da plataforma da FriendliAI no tratamento de vários tipos de tarefas de AI.

Confiabilidade sólida e economia de custos

Os usuários relatam benefícios significativos:

- APIs de modelo personalizado lançadas em cerca de um dia com monitoramento integrado.

- Processamento de token escalado para trilhões usando 50% menos GPUs.

- O tráfego flutuante é tratado sem preocupações devido ao autoescalonamento.

Conclusão

A FriendliAI oferece uma solução abrangente para inferência de AI, focando em velocidade, confiabilidade e custo-eficiência. Sua plataforma suporta uma ampla gama de modelos e fornece as ferramentas necessárias para implantar AI em escala, tornando-a um recurso valioso para empresas que buscam aproveitar as tecnologias de AI de forma eficaz.

Melhores ferramentas alternativas para "FriendliAI"

A Avian API oferece a inferência de IA mais rápida para LLMs de código aberto, atingindo 351 TPS no DeepSeek R1. Implante qualquer LLM HuggingFace com uma velocidade de 3 a 10 vezes maior com uma API compatível com OpenAI. Desempenho e privacidade de nível empresarial.

Nebius é uma plataforma de nuvem de IA projetada para democratizar a infraestrutura de IA, oferecendo arquitetura flexível, desempenho testado e valor de longo prazo com GPUs NVIDIA e clusters otimizados para treinamento e inferência.

Release.ai simplifica a implementação de modelos de IA com latência inferior a 100 ms, segurança de nível empresarial e escalabilidade contínua. Implante modelos de IA prontos para produção em minutos.

Runpod é uma plataforma de nuvem de IA que simplifica a construção e a implantação de modelos de IA. Oferecendo recursos de GPU sob demanda, escalonamento sem servidor e tempo de atividade de nível empresarial para desenvolvedores de IA.

Plataforma de IA ultrarrápida para desenvolvedores. Implante, ajuste e execute mais de 200 LLMs e modelos multimodais otimizados com APIs simples - SiliconFlow.

Inweave é uma plataforma alimentada por IA projetada para startups e scaleups para automatizar fluxos de trabalho de forma eficiente. Implante assistentes IA personalizáveis usando modelos líderes como GPT e Llama via chat ou API para ganhos de produtividade seamless.

Runpod é uma plataforma de nuvem de IA completa que simplifica a construção e a implantação de modelos de IA. Treine, ajuste e implemente IA sem esforço com computação poderosa e escalonamento automático.

Predibase é uma plataforma de desenvolvedores para ajustar e servir LLMs de código aberto. Alcance precisão e velocidade incomparáveis com a infraestrutura de treinamento e serviço de ponta a ponta, com ajuste fino de reforço.

Simplifique a implementação de IA com Synexa. Execute modelos de IA poderosos instantaneamente com apenas uma linha de código. Plataforma de API de IA sem servidor rápida, estável e amigável para desenvolvedores.

Modal: Plataforma sem servidor para equipes de IA e dados. Execute computação intensiva de CPU, GPU e dados em escala com seu próprio código.

Batteries Included é uma plataforma de IA auto-hospedada que simplifica a implantação de LLMs, bases de dados vetoriais e Jupyter notebooks. Crie aplicações de IA de classe mundial em sua infraestrutura.

Lightning AI é um espaço de trabalho em nuvem completo, projetado para construir, implantar e treinar agentes de IA, dados e aplicativos de IA. Obtenha APIs de modelos, treinamento de GPU e implantação multi-cloud em uma única assinatura.

Meteron AI é um conjunto de ferramentas de IA tudo-em-um que lida com medição, balanceamento de carga e armazenamento de LLM e IA generativa, libertando os desenvolvedores para se concentrarem na criação de produtos alimentados por IA.

Flyte orquestra fluxos de trabalho de IA/ML duráveis, flexíveis e nativos do Kubernetes. Com a confiança de mais de 3.000 equipes para a criação e implantação de pipelines escaláveis.