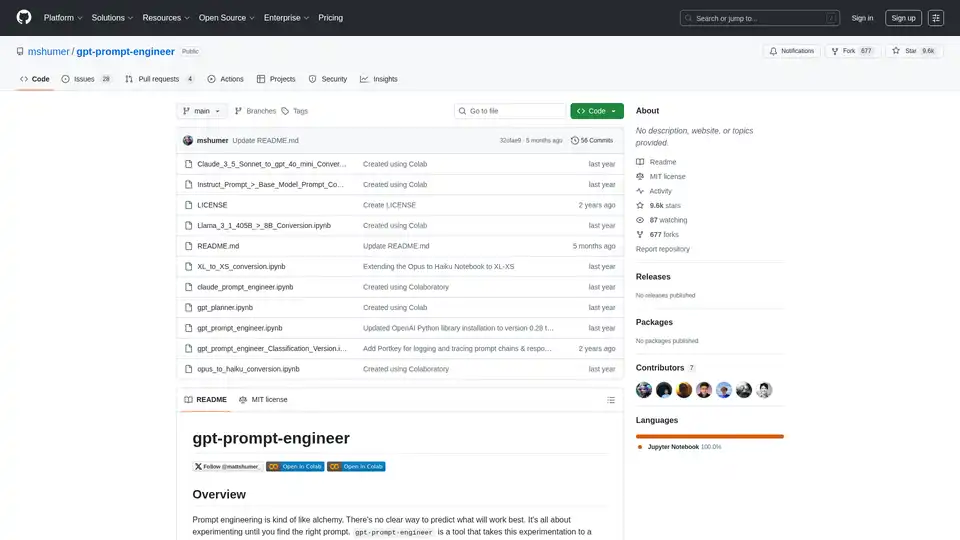

gpt-prompt-engineer

Visão geral de gpt-prompt-engineer

O que é gpt-prompt-engineer?

gpt-prompt-engineer é uma ferramenta de código aberto projetada para automatizar o processo de engenharia de prompts para modelos de linguagem grandes (LLMs) como GPT-4, GPT-3.5-Turbo e Claude 3. Ela ajuda os usuários a descobrir prompts ideais, gerando, testando e classificando vários prompts com base em casos de teste definidos pelo usuário.

Como funciona o gpt-prompt-engineer?

- Geração de Prompts: A ferramenta usa LLMs para gerar uma gama diversificada de prompts com base em uma descrição de caso de uso fornecida e em casos de teste associados.

- Teste de Prompts: Cada prompt gerado é testado em relação aos casos de teste fornecidos para avaliar seu desempenho.

- Sistema de Classificação ELO: Um sistema de classificação ELO é empregado para classificar os prompts com base em seu desempenho. Cada prompt começa com uma classificação ELO inicial, e as classificações são ajustadas com base no desempenho do prompt em relação aos casos de teste. Isso permite que os usuários identifiquem facilmente os prompts mais eficazes.

Principais Recursos do gpt-prompt-engineer

- Geração Automatizada de Prompts: Gera automaticamente uma infinidade de prompts potenciais com base em um caso de uso e casos de teste determinados.

- Teste e Classificação de Prompts: Testa sistematicamente cada prompt em relação aos casos de teste e os classifica usando um sistema de classificação ELO para identificar os mais eficazes.

- Suporte ao Claude 3 Opus: Uma versão especializada aproveita ao máximo o modelo Claude 3 Opus da Anthropic, permitindo a geração automatizada de casos de teste e múltiplas variáveis de entrada.

- Conversão Claude 3 Opus → Haiku: Este recurso permite que os usuários aproveitem o Claude 3 Opus para definir o espaço latente e o Claude 3 Haiku para geração de saída eficiente, reduzindo a latência e o custo.

- Versão de Classificação: Projetada para tarefas de classificação, esta versão avalia a correção de um caso de teste, comparando-o com a saída esperada ('true' ou 'false') e fornece uma tabela com pontuações para cada prompt.

- Registro de Pesos e Vieses: Registro opcional no Weights & Biases para rastrear configurações, prompts de sistema e usuário, casos de teste e classificações ELO finais.

- Integração com Portkey: Oferece integração opcional com o Portkey para registro e rastreamento de cadeias de prompts e suas respostas.

Como usar o gpt-prompt-engineer?

- Configuração: Abra o notebook desejado no Google Colab ou em um notebook Jupyter local. Escolha entre a versão padrão, a versão de classificação ou a versão Claude 3, dependendo do seu caso de uso.

- Configuração da Chave da API: Adicione sua chave da API OpenAI ou sua chave da API Anthropic à linha designada no notebook.

- Defina o Caso de Uso e os Casos de Teste: Para a versão GPT-4, defina seu caso de uso e seus casos de teste. O caso de uso é uma descrição do que você deseja que a IA faça, e os casos de teste são prompts específicos aos quais você gostaria que a IA respondesse.

- Configure as Variáveis de Entrada (para a versão Claude 3): Defina as variáveis de entrada, além da descrição do caso de uso, especificando o nome da variável e sua descrição.

- Gere Prompts Ideais: Chame a função

generate_optimal_promptcom a descrição do caso de uso, os casos de teste e o número desejado de prompts a serem gerados. - Avalie os Resultados: As classificações ELO finais serão impressas em uma tabela, classificadas em ordem decrescente. Quanto maior a classificação, melhor o prompt. Para a versão de classificação, as pontuações de cada prompt serão impressas em uma tabela.

Para quem é o gpt-prompt-engineer?

ogpt-prompt-engineer é ideal para:

- Desenvolvedores e pesquisadores de IA que buscam otimizar prompts para LLMs.

- Empresas que buscam melhorar o desempenho de aplicativos baseados em IA.

- Indivíduos interessados em explorar técnicas de engenharia de prompts.

- Qualquer pessoa que procure reduzir o custo e a latência de aplicativos baseados em LLM.

Casos de Uso:

- Automatizar a geração de manchetes de páginas de destino.

- Criar respostas de e-mail personalizadas.

- Otimizar prompts para geração de conteúdo.

- Construir sistemas de IA econômicos usando Claude 3 Opus e Haiku.

Por que escolher o gpt-prompt-engineer?

- Economia de Tempo: Automatiza o processo de engenharia de prompts, economizando tempo e esforço significativos.

- Desempenho Aprimorado: Ajuda a descobrir prompts ideais que levam a um desempenho aprimorado dos LLMs.

- Redução de Custos: Permite a criação de sistemas de IA econômicos, aproveitando modelos eficientes como o Claude 3 Haiku.

- Flexibilidade: Suporta vários LLMs e casos de uso, incluindo tarefas de classificação.

Licença

ogpt-prompt-engineer é licenciado sob a MIT.

Link do Projeto

Melhores ferramentas alternativas para "gpt-prompt-engineer"

Promptimize AI é uma extensão de navegador que aprimora os prompts de IA, facilitando para qualquer pessoa usar a IA de forma confiável para aumentar a produtividade. Ele oferece melhorias com um clique, variáveis personalizadas e integração em todas as plataformas de IA.

Mutatio.dev é uma ferramenta AI open-source para engenharia de prompts, permitindo mutação, validação e otimização sistemática de prompts com LLMs personalizados. Focada em privacidade, baseada em navegador, flexível.

Prompt Genie é uma ferramenta alimentada por IA que cria instantaneamente super prompts otimizados para LLMs como ChatGPT e Claude, eliminando os aborrecimentos da engenharia de prompts. Teste, salve e compartilhe via extensão do Chrome para resultados 10 vezes melhores.

GPT Prompt Lab é um gerador de prompts IA gratuito que ajuda criadores de conteúdo a criar prompts de alta qualidade para ChatGPT, Gemini e mais a partir de qualquer tópico. Gere, teste e otimize prompts para blogs, e-mails, código e conteúdo SEO em segundos.

Infrabase.ai é o diretório para descobrir ferramentas e serviços de infraestrutura de IA. Encontre bancos de dados vetoriais, ferramentas de engenharia de prompts, APIs de inferência e muito mais para construir produtos de IA de classe mundial.

Compare e compartilhe prompts lado a lado com Google's Gemini Pro vs OpenAI's ChatGPT para encontrar o melhor modelo AI para suas necessidades.

Langtail é uma plataforma de baixo código para testar e depurar aplicativos de IA com confiança. Teste prompts LLM com dados do mundo real, detecte bugs e garanta a segurança da IA. Experimente grátis!

What-A-Prompt é um otimizador de prompts amigável ao usuário para aprimorar entradas em modelos de IA como ChatGPT e Gemini. Selecione aprimoradores, insira seu prompt e gere resultados criativos e detalhados para impulsionar saídas LLM. Acesse uma vasta biblioteca de prompts otimizados.

Entregue software impulsionado por IA impactante em minutos, sem comprometer a qualidade. Envie, monitore, teste e itere sem perder o foco.

GeneratedBy simplifica a criação, teste e compartilhamento de prompts de IA. Aumente a produtividade com edição intuitiva, implementação flexível e integração de GPT-4 para aplicativos baseados em prompts.

Parea AI é a plataforma definitiva de experimentação e anotação humana para equipes de IA, permitindo avaliação fluida de LLM, testes de prompts e implantação em produção para construir aplicativos de IA confiáveis.

Query Vary é uma plataforma sem código que permite que as equipes treinem IA de forma colaborativa e construam automações baseadas em IA. Ele integra IA generativa para otimizar fluxos de trabalho e melhorar a produtividade sem programação.

Maxim AI é uma plataforma completa de avaliação e observabilidade que ajuda as equipes a implantar agentes de IA de forma confiável e 5 vezes mais rápido com ferramentas abrangentes de teste, monitoramento e garantia de qualidade.

PromptBuilder é uma plataforma de engenharia de prompts de IA projetada para ajudar os usuários a gerar, otimizar e organizar prompts de alta qualidade para vários modelos de IA, como ChatGPT, Claude e Gemini, garantindo resultados de IA consistentes e eficazes.