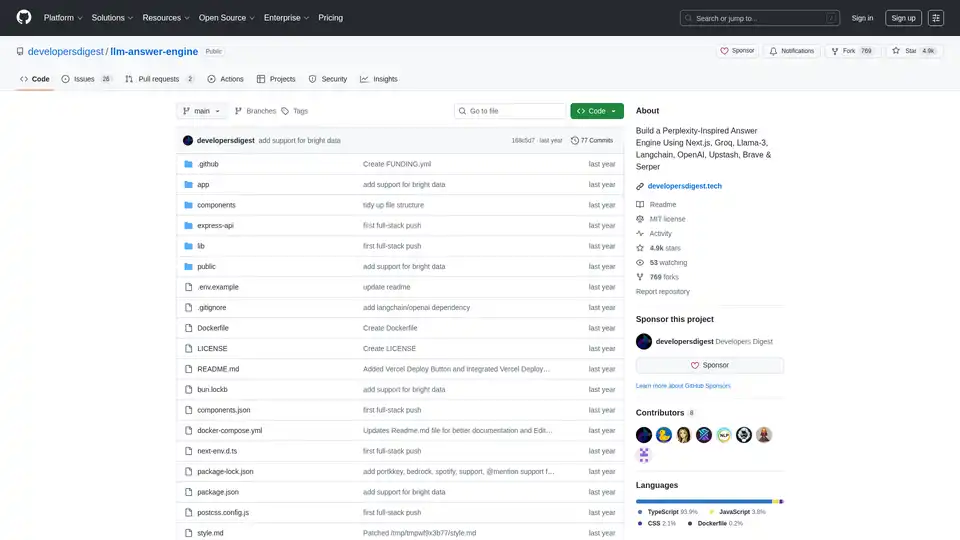

llm-answer-engine

Visão geral de llm-answer-engine

Motor de Respostas LLM: Construa Seu Próprio Sistema de Perguntas e Respostas Impulsionado por AI

Este projeto de código aberto, llm-answer-engine, fornece o código e as instruções para construir um sofisticado motor de respostas AI inspirado no Perplexity. Ele alavanca tecnologias de ponta como Groq, Mixtral da Mistral AI, Langchain.JS, Brave Search, Serper API e OpenAI para fornecer respostas abrangentes às consultas dos usuários, completas com fontes, imagens, vídeos e perguntas de acompanhamento.

O que é llm-answer-engine?

llm-answer-engine é um ponto de partida para desenvolvedores interessados em explorar o processamento de linguagem natural e tecnologias de busca. Ele permite que você crie um sistema que responda eficientemente às perguntas por:

- Recuperar informações relevantes de várias fontes.

- Gerar respostas concisas e informativas.

- Fornecer evidências de apoio e mídia relacionada.

- Sugerir perguntas de acompanhamento para orientar a exploração posterior.

Como funciona o llm-answer-engine?

O motor utiliza uma combinação de tecnologias para processar as consultas dos usuários e gerar respostas relevantes:

- Entendimento da Consulta: Tecnologias como Groq e Mixtral são usadas para processar e entender a pergunta do usuário.

- Recuperação de Informações:

- Brave Search: Um mecanismo de busca focado na privacidade é usado para encontrar conteúdo e imagens relevantes.

- Serper API: Usado para buscar resultados de vídeo e imagem relevantes com base na consulta do usuário.

- Cheerio: Utilizado para análise HTML, permitindo a extração de conteúdo de páginas web.

- Processamento de Texto:

- Langchain.JS: Uma biblioteca JavaScript focada em operações de texto, como divisão de texto e embeddings.

- OpenAI Embeddings: Usado para criar representações vetoriais de trechos de texto.

- Componentes Opcionais:

- Ollama: Usado para streaming de inferência e embeddings.

- Upstash Redis Rate Limiting: Usado para configurar a limitação de taxa para a aplicação.

- Upstash Semantic Cache: Usado para caching de dados para tempos de resposta mais rápidos.

Principais Características e Tecnologias:

- Next.js: Um framework React para construir aplicações web estáticas e renderizadas no lado do servidor, fornecendo uma base robusta para a interface do usuário.

- Tailwind CSS: Um framework CSS utility-first para construir rapidamente interfaces de usuário personalizadas, permitindo um estilo e personalização eficientes.

- Vercel AI SDK: Uma biblioteca para construir texto de streaming impulsionado por AI e UIs de chat, aprimorando a experiência do usuário com feedback em tempo real.

- Suporte para Chamada de Função (Beta): Estende a funcionalidade com integrações para Mapas e Localizações (Serper Locations API), Compras (Serper Shopping API), Dados de Ações da TradingView e Spotify.

- Suporte Ollama (Parcialmente suportado): Oferece compatibilidade com Ollama para streaming de respostas de texto e embeddings, permitindo a execução de modelos locais.

Como usar o llm-answer-engine?

Para começar com o llm-answer-engine, siga estes passos:

- Pré-requisitos:

- Obtenha as chaves API da OpenAI, Groq, Brave Search e Serper.

- Certifique-se de que Node.js e npm (ou bun) estejam instalados.

- (Opcional) Instale Docker e Docker Compose para implantação em contêineres.

- Instalação:

git clone https://github.com/developersdigest/llm-answer-engine.git

cd llm-answer-engine

3. **Configuração**: * **Docker**: Edite o arquivo `docker-compose.yml` e adicione suas chaves API. * **Não-Docker**: Crie um arquivo `.env` na raiz do seu projeto e adicione suas chaves API. 4. **Execute o servidor**: * **Docker**:bash

docker compose up -d

* **Não-Docker**:bash

npm install # or bun install

npm run dev # or bun run dev

```

O servidor estará ouvindo na porta especificada.

Por que escolher o llm-answer-engine?

- Inspirado no Perplexity: Fornece uma experiência de usuário semelhante a um motor de respostas AI líder.

- Alavanca tecnologias poderosas: Combina o melhor da raça em PNL, busca e desenvolvimento web.

- Código aberto e personalizável: Permite que você adapte o motor às suas necessidades específicas.

- Suporte para Chamada de Função: Estende a funcionalidade com integrações para Mapas e Localizações, Compras, Dados de Ações da TradingView e Spotify.

Para quem é o llm-answer-engine?

Este projeto é ideal para:

- Desenvolvedores interessados em processamento de linguagem natural e tecnologias de busca.

- Pesquisadores explorando sistemas de perguntas e respostas.

- Qualquer pessoa que queira construir sua própria base de conhecimento impulsionada por AI.

Roadmap:

O roadmap do projeto inclui recursos interessantes, como:

- Upload de documentos + RAG para busca/recuperação de documentos.

- Um componente de configurações para permitir que os usuários selecionem o modelo, o modelo de embeddings e outros parâmetros na UI.

- Adicionar suporte para perguntas de acompanhamento ao usar Ollama

Contribuições:

Contribuições são bem-vindas! Faça um fork do repositório, faça suas alterações e envie um pull request.

Este projeto é licenciado sob a Licença MIT.

Construa seu próprio motor de respostas impulsionado por AI e explore as possibilidades do processamento de linguagem natural com llm-answer-engine!

Melhores ferramentas alternativas para "llm-answer-engine"

Promethia orquestra agentes de IA especializados em equipes colaborativas, replicando fluxos de trabalho humanos para enfrentar desafios complexos. Melhore a estratégia empresarial, automatize a resposta a incidentes e acelere a pesquisa com IA.

LangSearch fornece uma API de pesquisa web e uma API de reclassificação semântica para conectar aplicativos LLM a um contexto limpo e preciso.

Helpjuice: Software de Base de Conhecimento confiável por mais de 130.000 usuários da Amazon, Hertz, Shipt. Simplifique o suporte, impulsione a produtividade com busca e criação de conteúdo alimentados por IA. Inicie teste gratuito de 14 dias.

AI Answer Generator ajuda você a gerar respostas instantâneas de IA para qualquer pergunta. Obtenha respostas rápidas e precisas com esta ferramenta gratuita de perguntas e respostas de IA online.

Juicebox (PeopleGPT) é um motor de busca alimentado por IA para aquisição de talentos. Pesquise mais de 800 milhões de perfis usando linguagem natural e sequências de e-mail alimentadas por IA.

Quattr é uma plataforma de SEO alimentada por IA projetada para unificar as estratégias de SEO, AEO e GEO. Ele automatiza a criação de conteúdo, o link interno e o rastreamento de classificação para melhorar a visibilidade online e o crescimento orgânico.

Albus AI é um espaço de trabalho na nuvem que constrói bases de conhecimento de IA, simplifica documentos e fornece um motor de IA sem alucinações para referências precisas e mapeamento semântico. Organize automaticamente seus arquivos, pesquise em vários formatos e obtenha respostas com referências.

Albus AI é um espaço de trabalho em nuvem que agiliza a indexação de documentos e fornece pesquisa semântica. Ele organiza automaticamente os arquivos, permitindo pesquisas em vários tipos de documentos e oferece respostas baseadas em IA com referências.

Resolvd usa IA para analisar logs, correlacionar eventos e detectar anomalias, reduzindo significativamente o tempo de resposta a incidentes e liberando os desenvolvedores. Ele se integra com Slack, Jira e PagerDuty.

Jina AI oferece embeddings, rerankers, leitor web, pesquisa profunda e modelos de linguagem pequenos de primeira classe. Uma solução de pesquisa de IA para dados multilingues e multimodais.

GenSearch revoluciona a pesquisa usando IA generativa, permitindo que os usuários criem mecanismos de pesquisa personalizados com tecnologia de IA, com experiências personalizadas e integrações perfeitas.

A plataforma de habilitação de IA da BA Insight fornece pesquisa empresarial baseada em IA, conectando os usuários ao conteúdo relevante de sistemas distintos, aprimorada com compreensão semântica e RAG para IA generativa.

INSIGHT DOCUMENT é uma plataforma com tecnologia de IA para análise de documentos e geração de relatórios. Extraia conhecimento, analise conteúdo e obtenha insights significativos de seus documentos com IA avançada.

Transforme sua estratégia de mídia social com Currents AI. Descubra tópicos de tendências, analise concorrentes e envolva-se com seu público nas principais plataformas.