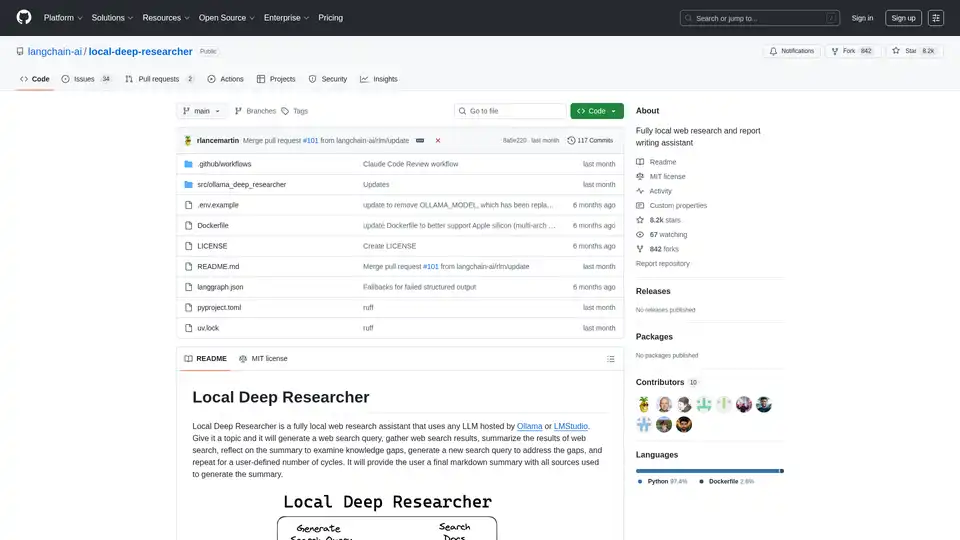

Local Deep Researcher

Visão geral de Local Deep Researcher

O que é Local Deep Researcher?

Local Deep Researcher é um inovador assistente de pesquisa web de código aberto projetado para operar totalmente localmente em sua máquina. Esta ferramenta poderosa aproveita grandes modelos de linguagem (LLMs) através do Ollama ou LMStudio para realizar pesquisas web abrangentes e gerar relatórios detalhados com citações de fontes adequadas.

Como o Local Deep Researcher funciona?

O sistema segue um processo de pesquisa iterativo inteligente:

Processo do ciclo de pesquisa:

- Geração de consultas: Dado um tema fornecido pelo usuário, o LLM local gera uma consulta de pesquisa web otimizada

- Recuperação de fontes: Usa ferramentas de pesquisa configuradas (DuckDuckGo, SearXNG, Tavily ou Perplexity) para encontrar fontes online relevantes

- Resumo de conteúdo: O LLM analisa e resume as descobertas dos resultados da pesquisa web

- Análise de lacunas: O sistema reflete sobre o resumo para identificar lacunas de conhecimento e informações faltantes

- Refinamento iterativo: Gera novas consultas de pesquisa para abordar lacunas identificadas e repete o processo

- Geração de relatório final: Após múltiplos ciclos (configuráveis pelo usuário), produz um relatório abrangente em markdown com todas as fontes devidamente citadas

Características e capacidades principais

- Operação totalmente local: Todo o processamento ocorre localmente, garantindo privacidade e segurança de dados

- Suporte múltiplo a LLMs: Compatível com qualquer LLM hospedado através do Ollama ou LMStudio

- Integração flexível de pesquisa: Suporta APIs de pesquisa DuckDuckGo (padrão), SearXNG, Tavily e Perplexity

- Profundidade de pesquisa configurável: Usuários podem definir o número de ciclos de pesquisa (padrão: 3 iterações)

- Saída estruturada: Gera relatórios em markdown bem formatados com citações de fontes adequadas

- Monitoramento visual do fluxo de trabalho: Integrado com LangGraph Studio para visualização em tempo real do processo

Requisitos técnicos e configuração

Plataformas suportadas:

- macOS (recomendado)

- Windows

- Linux via Docker

Componentes necessários:

- Python 3.11+

- Ollama ou LMStudio para hospedagem local de LLMs

- Chaves API opcionais para serviços de pesquisa premium

Instalação e configuração

Processo de configuração rápida:

- Clone o repositório do GitHub

- Configure as variáveis de ambiente no arquivo .env

- Selecione seu provedor de LLM preferido (Ollama ou LMStudio)

- Escolha a configuração da API de pesquisa

- Inicie através do LangGraph Studio

Implantaçãocom Docker: O projeto inclui suporte Docker para implantação em contêineres, embora o Ollama deva ser executado separadamente com configuração de rede adequada.

Considerações de compatibilidade de modelos

O sistema requer LLMs capazes de produzir saída JSON estruturada. Alguns modelos como DeepSeek R1 (7B e 1.5B) podem ter limitações com o modo JSON, mas o assistente inclui mecanismos de fallback para lidar com esses casos.

Quem deve usar o Local Deep Researcher?

Usuários ideais incluem:

- Pesquisadores e acadêmicos necessitando de revisões de literatura abrangentes

- Criadores de conteúdo requerendo informações de fundo bem pesquisadas

- Estudantes trabalhando em artigos de pesquisa e tarefas

- Jornalistas realizando pesquisas investigativas

- Profissionais de negócios necessitando de pesquisa de mercado e análise competitiva

- Usuários conscientes da privacidade que preferem processamento local a soluções baseadas em nuvem

Aplicações práticas e casos de uso

- Pesquisa acadêmica: Realizar revisões de literatura e coletar fontes para artigos

- Análise de mercado: Pesquisar concorrentes e tendências do setor

- Pesquisa de conteúdo: Coletar informações para posts de blog, artigos e relatórios

- Due diligence: Investigar tópicos minuciosamente com documentação adequada de fontes

- Aprendizado e educação: Explorar tópicos em profundidade com assistência de pesquisa automatizada

Por que escolher o Local Deep Researcher?

Vantagens principais:

- Privacidade completa: Seus tópicos de pesquisa e dados nunca saem de sua máquina local

- Custo-efetivo: Sem custos de API para funcionalidade básica de pesquisa

- Customizável: Ajuste a profundidade de pesquisa e fontes para atender suas necessidades específicas

- Transparente: Visibilidade completa do processo de pesquisa e fontes utilizadas

- Código aberto: Desenvolvimento conduzido pela comunidade e melhorias contínuas

Obtendo os melhores resultados

Para desempenho ideal:

- Use modelos LLM maiores e mais capazes quando possível

- Configure APIs de pesquisa apropriadas para suas necessidades específicas

- Ajuste o número de ciclos de pesquisa baseado na complexidade do tópico

- Revise e verifique manualmente fontes importantes para pesquisas críticas

Local Deep Researcher representa um avanço significativo em ferramentas de pesquisa locais alimentadas por IA, combinando o poder de grandes modelos de linguagem com capacidades práticas de pesquisa web enquanto mantém privacidade e controle completos de dados.

Melhores ferramentas alternativas para "Local Deep Researcher"

GPT for Work integra as principais IAs como ChatGPT, Gemini em Excel, Word, Sheets & Docs, automatizando tarefas como tradução, geração de conteúdo e análise de dados. Ideal para profissionais que buscam maior produtividade.

Alter é um assistente de IA para macOS que se integra com aplicativos e automatiza tarefas com voz e IA inteligente. Ele entende seu fluxo de trabalho e prioriza a privacidade com o processamento local de dados criptografados.

VisualGPT é uma plataforma com tecnologia de IA para geração, edição e aprimoramento de imagens. Ele combina modelos de IA com ferramentas de design fáceis de usar para visuais impressionantes, atendendo a profissionais de marketing, designers, empresas e amadores.

Transforme seu fluxo de trabalho com BrainSoup! Crie agentes de IA personalizados para gerenciar tarefas e automatizar processos por meio de linguagem natural. Melhore a IA com seus dados, priorizando privacidade e segurança.

Converse com IA usando suas chaves API. Pague apenas pelo que usar. Suporta GPT-4, Gemini, Claude e outros LLMs. A melhor interface de chat frontend LLM para todos os modelos de IA.

Learnitive Notepad é um app de anotações tudo-em-um impulsionado por IA para criar notas Markdown, códigos, fotos, páginas web e mais. Aumente sua produtividade com 50GB de armazenamento, assistência IA ilimitada e suporte multiplataforma.

Onnix AI atua como copiloto personalizado para banqueiros, acelerando a criação de slides, análise de dados baseada em Excel e consultas instantâneas de provedores de dados financeiros como FactSet e CapIQ para entregar insights rápidos e precisos.

Descubra Mindpool, a plataforma definitiva para consultar múltiplos modelos de IA líderes como ChatGPT e Gemini com um único prompt, compare saídas para insights precisos e impulsione sua pesquisa, criatividade e esforços de marketing de forma segura.

SummerEyes é uma extensão de navegador alimentada por IA que resume qualquer texto da internet em um clique, impulsionando a produtividade com 70% mais velocidade de leitura e 30 minutos economizados por dia usando modelos NLP avançados.

Carregue CSV e analise em uma interface visual passo a passo. Limpe, extraia, resuma ou faça análise de sentimentos com seu agente AI pessoal.

Text Assistant é um app alimentado por IA que permite criar e reutilizar prompts personalizados para gerar saídas de texto direcionadas, como pitches de vendas ou posts de blog. Conecte-se diretamente ao OpenAI para uso econômico, com recursos para compartilhamento fácil e integração com Safari.

SmythOS é um sistema operacional de código aberto para a era da IA, permitindo uma implantação rápida, confiável e auditável de fluxos de trabalho complexos de agentes de IA. Crie, depure e implemente agentes de IA com facilidade.

TypingMind é uma interface de usuário de chat AI que suporta GPT-4, Gemini, Claude e outros LLMs. Use suas chaves de API e pague apenas pelo que você usa. Melhor interface de usuário frontend LLM de chat para todos os modelos de IA.

Acuration IQ é um decodificador de mercado alimentado por IA que transforma dados complexos em insights acionáveis para sinergias B2B, pesquisa de mercado e tomada de decisões orientada por dados.