Sanctum

Visão geral de Sanctum

Sanctum: Seu Assistente de AI Local e Privado

O que é Sanctum?

Sanctum é um aplicativo de desktop que permite que você execute e interaja com Modelos de Linguagem Grande (LLMs) de código aberto e com todos os recursos, localmente em seu dispositivo. Ele prioriza a privacidade do usuário, garantindo que seus dados sejam criptografados, protegidos e nunca saiam do seu dispositivo. O Sanctum oferece um ambiente seguro para várias tarefas orientadas por AI, como análise de dados pessoais, criação de conteúdo, brainstorming e desenvolvimento de código.

Como o Sanctum funciona?

O Sanctum aproveita a criptografia e o processamento no dispositivo para manter seus dados privados. Ele se integra ao Hugging Face, fornecendo acesso a milhares de modelos GGUF. Essa integração permite que os usuários verifiquem facilmente a compatibilidade, baixem e usem modelos diretamente em seu PC ou Mac. Com o Sanctum, você pode conversar com PDFs de forma 100% privada, fazer perguntas e resumir arquivos em um ambiente seguro, sem precisar de uma conexão com a Internet após o download inicial.

Principais Características:

- Processamento de AI Local: Execute modelos de AI diretamente no seu dispositivo, sem depender de servidores em nuvem.

- Abordagem de Privacidade em Primeiro Lugar: Seus dados são criptografados e permanecem dentro do seu Sanctum.

- Integração com Hugging Face: Acesse uma ampla gama de modelos de código aberto e integre-os facilmente.

- Chat com PDF: Converse com PDFs com segurança e extraia informações.

- Configuração Fácil: Processo de download e instalação simples.

Casos de Uso:

- Analisando dados pessoais de saúde

- Criando conteúdo

- Brainstorming de ideias e soluções

- Conduzindo análises de dados

- Revisando notas de chamadas

- Analisando dados financeiros privados

- Colaborando no desenvolvimento de código

- Analisando feedback do usuário

- Melhorando scripts de vendas

- Acompanhando o progresso do bem-estar

Experiências Reais de Usuários:

- "Generative AI that lives on your laptop and keeps all of your data private! I've been playing around with it all morning and its very cool!" - @itscrazybro (Sanctum user on X)

- "Something we are very passionate about is giving control in AI back to users. Excited to see how this evolves." - Aaron McDonald (Founder @futureverse)

- "I didn’t realize how much I needed Sanctum until I started using it." - Noah Jessop (ProofGroup)

Como começar com o Sanctum:

- Baixe o Sanctum para o seu sistema operacional (Windows ou Mac).

- Instale o aplicativo.

- Explore e baixe modelos do Hugging Face através da interface do Sanctum.

- Comece a conversar com AI ou a analisar PDFs com segurança.

FAQ:

- Como funciona o aplicativo Sanctum? O Sanctum executa modelos de AI localmente em seu dispositivo, garantindo que seus dados permaneçam privados e seguros.

- Quais sistemas operacionais são suportados? O Sanctum está atualmente disponível para Windows e Mac.

- Quão seguro é o Sanctum? O Sanctum criptografa seus dados e os processa localmente, garantindo que eles nunca saiam do seu dispositivo.

Por que o Sanctum é importante?

O Sanctum é importante porque aborda a crescente necessidade de privacidade nas interações de AI. Ao executar modelos de AI localmente e criptografar dados, o Sanctum capacita os usuários a aproveitar os recursos de AI sem comprometer suas informações pessoais.

Em conclusão, o Sanctum fornece uma maneira privada e segura de interagir com AI. Seus recursos, facilidade de uso e compromisso com a privacidade o tornam uma ferramenta valiosa para quem procura aproveitar a AI sem sacrificar a segurança dos dados.

Melhores ferramentas alternativas para "Sanctum"

Private LLM é um chatbot de IA local para iOS e macOS que funciona offline, mantendo suas informações completamente no dispositivo, seguras e privadas. Desfrute de bate-papo sem censura no seu iPhone, iPad e Mac.

NativeMind é uma extensão open-source do Chrome que executa LLMs locais como Ollama para uma alternativa totalmente offline e privada ao ChatGPT. Recursos incluem chat contextual, modo agente, análise de PDF, ferramentas de escrita e tradução—tudo 100% no dispositivo sem nuvem.

Enclave AI é um assistente de IA com foco na privacidade para iOS e macOS que é executado completamente offline. Ele oferece processamento LLM local, conversas seguras, chat de voz e interação com documentos sem a necessidade de uma conexão com a Internet.

Privacy AI é um hub de chatbot de IA offline que garante a máxima privacidade de dados. Execute modelos de linguagem localmente no seu dispositivo sem Internet para conversas seguras.

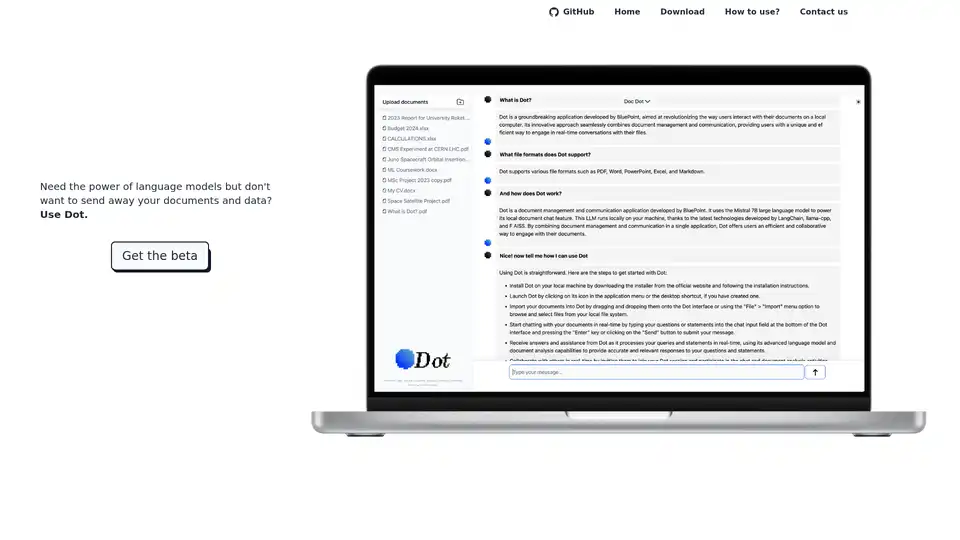

Dot é uma ferramenta de chat IA local e offline alimentada por Mistral 7B, permitindo que você converse com documentos sem enviar seus dados. Gratuito e com foco na privacidade.

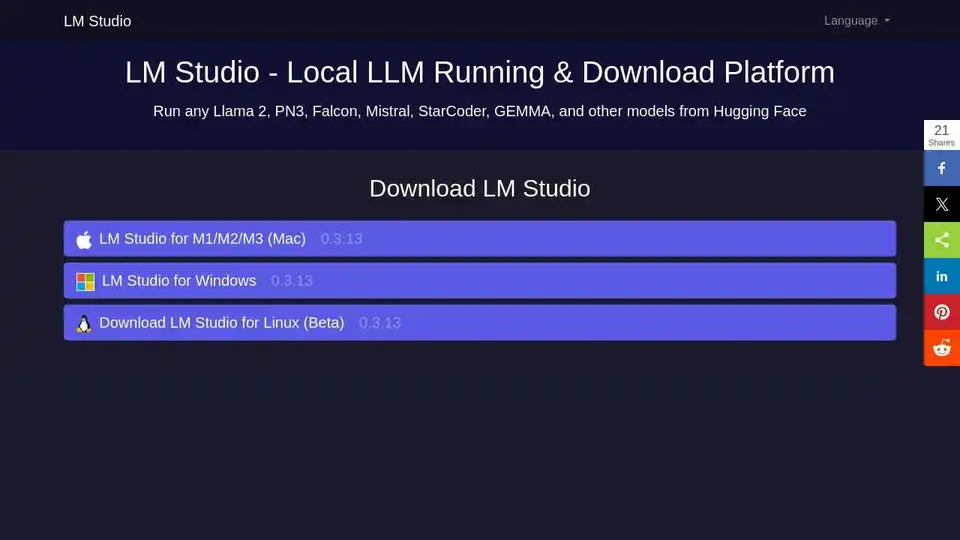

LM Studio é um aplicativo de desktop fácil de usar para executar e baixar modelos de linguagem grandes (LLMs) de código aberto como LLaMa e Gemma localmente no seu computador. Ele apresenta uma UI de chat no aplicativo e um servidor compatível com OpenAI para interação offline, tornando a IA acessível sem habilidades de programação.

RecurseChat: Um aplicativo de IA pessoal que permite conversar com IA local, offline e conversar com arquivos PDF e markdown.

Floneum é um editor de gráficos que permite construir visualmente fluxos de trabalho baseados em IA com modelos de linguagem grandes locais. Ele se estende com segurança com plug-ins WASM isolados e oferece suporte a vários idiomas.

Roo Code é um assistente de codificação open-source impulsionado por IA para VS Code, com agentes de IA para edição de múltiplos arquivos, depuração e arquitetura. Suporta vários modelos, garante privacidade e se personaliza para um fluxo de trabalho eficiente.

ProxyAI é um assistente de código com tecnologia de IA para IDEs JetBrains, oferecendo preenchimento de código, edição em linguagem natural e suporte offline com LLMs locais. Melhore sua codificação com IA.

AI Runner é um mecanismo de inferência de IA offline para arte, conversas de voz em tempo real, chatbots alimentados por LLM e fluxos de trabalho automatizados. Execute geração de imagens, chat de voz e muito mais localmente!

Text Generation Web UI é uma interface web Gradio poderosa e fácil de usar para modelos de linguagem grandes de IA local. Suporta múltiplos backends, extensões e oferece privacidade offline.

ProxyAI é um copiloto de IA para IDEs JetBrains que oferece recursos como conclusão de código, edição em linguagem natural e integração com LLMs líderes. Ele oferece suporte ao desenvolvimento offline e vários modelos por meio de chaves de API.

Jan é um cliente de IA de código aberto e com prioridade offline. Execute modelos de linguagem grandes (LLM) localmente com privacidade e sem cobranças de API. Conecte-se a vários modelos e serviços.