Stable Diffusion

Visão geral de Stable Diffusion

O que é Stable Diffusion AI?

Stable Diffusion é um sistema de IA open-source revolucionário que transforma descrições de texto em imagens impressionantes e realistas. Desenvolvido pelo grupo CompVis da Universidade Ludwig Maximilian de Munique, em colaboração com Runway ML e Stability AI, ele utiliza modelos de difusão para permitir a geração de imagens a partir de texto, edição de imagens e mais. Diferente de ferramentas proprietárias, o código, os modelos pré-treinados e a licença do Stable Diffusion são totalmente open-source, permitindo que os usuários o executem em uma única GPU diretamente em seus dispositivos. Essa acessibilidade democratizou a criatividade impulsionada por IA, tornando a geração de imagens de alta qualidade disponível para artistas, designers e entusiastas sem necessidade de recursos empresariais.

Em seu cerne, o Stable Diffusion se destaca na produção de visuais detalhados a partir de prompts simples, suportando resoluções de até 1024x1024 pixels. Ele é particularmente notável por sua versatilidade na geração de paisagens, retratos, arte abstrata e até designs conceituais. Para aqueles que se aventuram na arte de IA, o Stable Diffusion se destaca como um ponto de entrada confiável, oferecendo liberdade criativa enquanto é consciente do uso ético para evitar vieses de seus dados de treinamento.

Como o Stable Diffusion Funciona?

O Stable Diffusion opera em uma arquitetura de Modelo de Difusão Latente (LDM), que comprime e processa imagens de forma eficiente em um espaço latente em vez de no espaço completo de pixels, reduzindo as demandas computacionais. O sistema compreende três componentes principais:

- Variational Autoencoder (VAE): Isso comprime imagens de entrada em uma representação latente compacta, preservando detalhes semânticos essenciais enquanto descarta ruído.

- U-Net: O núcleo de desruído, construído sobre uma estrutura ResNet, remove iterativamente o ruído gaussiano adicionado durante o processo de difusão forward. Ele usa mecanismos de atenção cruzada para incorporar prompts de texto, guiando a geração para as saídas descritas pelo usuário.

- Text Encoder (Opcional): Converte descrições textuais em embeddings que influenciam os passos de desruído.

O processo começa adicionando ruído a uma imagem latente (ou começando de ruído puro para geração). A U-Net então reverte esse processo de difusão passo a passo, refinando a saída até que uma imagem coerente emerja. Uma vez desruído, o decodificador VAE reconstrói a imagem final baseada em pixels. Esse fluxo de trabalho elegante garante resultados de alta fidelidade, mesmo para prompts complexos envolvendo estilos, composições ou sujeitos.

Treinado no massivo conjunto de dados LAION-5B —compreendendo bilhões de pares imagem-texto de fontes web— permite que o Stable Diffusion aprenda conceitos visuais diversos. Os dados são filtrados por qualidade, resolução e estética, com técnicas como Classifier-Free Guidance melhorando a adesão aos prompts. No entanto, esses dados de origem web introduzem vieses culturais, principalmente para conteúdo em inglês e ocidental, que os usuários devem considerar ao gerar representações diversas.

Recursos e Capacidades Principais do Stable Diffusion

O Stable Diffusion não se resume à criação básica de imagens; ele oferece uma suíte de recursos avançados:

- Geração de Imagens a partir de Texto: Insira um prompt descritivo como "uma paisagem serena de montanha ao pôr do sol" e gere arte original em segundos.

- Ferramentas de Edição de Imagens: Use inpainting para preencher ou modificar partes de uma imagem (por exemplo, mudar fundos) e outpainting para expandir além das bordas originais.

- Tradução de Imagem para Imagem: Redesenhe fotos existentes com nova orientação textual, preservando a estrutura enquanto altera estilos ou elementos.

- Integração com ControlNet: Mantenha estruturas geométricas, poses ou bordas de imagens de referência enquanto aplica mudanças estilísticas.

- Suporte a Alta Resolução: A variante XL (Stable Diffusion XL 1.0) impulsiona as capacidades com um modelo duplo de 6 bilhões de parâmetros, permitindo saídas de 1024x1024, melhor renderização de texto em imagens e simplificação de prompts para resultados mais rápidos e realistas.

Melhorias como LoRAs (Adaptações de Baixo Rango) permitem ajuste fino para detalhes específicos —como rostos, roupas ou estilos anime— sem re-treinar todo o modelo. Embeddings capturam estilos visuais para saídas consistentes, enquanto prompts negativos excluem elementos indesejados como distorções ou membros extras, refinando a qualidade.

Como Usar o Stable Diffusion AI

Começar com o Stable Diffusion é direto, seja online ou offline.

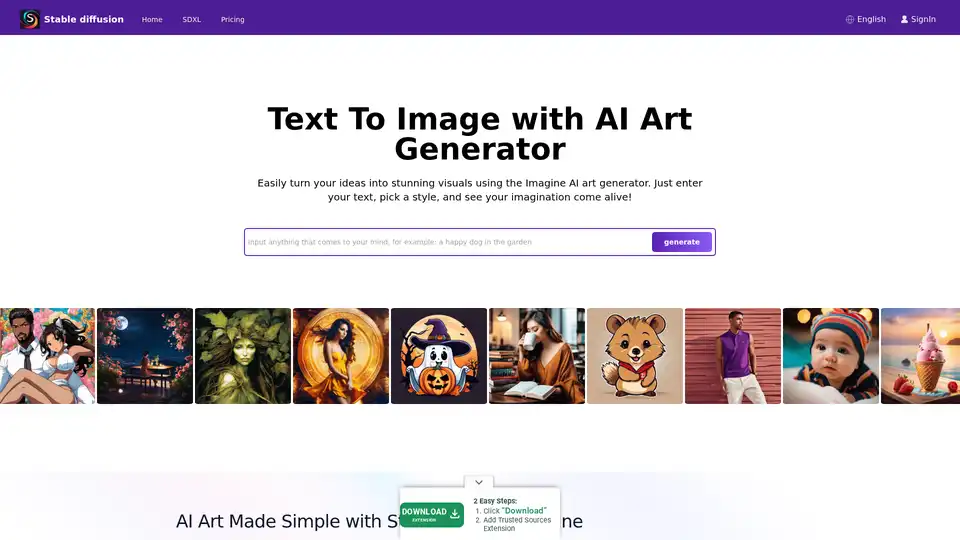

Acesso Online via Plataformas

Para iniciantes, plataformas como Stablediffusionai.ai fornecem uma interface web amigável ao usuário:

- Visite stablediffusionai.ai e faça login.

- Insira seu prompt de texto no campo de entrada.

- Selecione estilos, resoluções (por exemplo, SDXL para alta resolução) e ajuste parâmetros como passos de amostragem.

- Clique em "Generate" ou "Dream" para criar imagens.

- Refine com prompts negativos (por exemplo, "borrado, baixa qualidade") e baixe favoritos.

Essa opção sem instalação é ideal para experimentos rápidos, embora exija internet.

Instalação Local e Download

Para controle total e uso offline:

- Baixe do GitHub (github.com/CompVis/stable-diffusion) clicando em "Code" > "Download ZIP" (precisa de ~10GB de espaço).

- Instale pré-requisitos: Python 3.10+, Git e uma GPU com 4GB+ VRAM (NVIDIA recomendado).

- Extraia o ZIP, coloque checkpoints de modelo (por exemplo, do Hugging Face) na pasta models.

- Execute webui-user.bat (Windows) ou script equivalente para lançar a UI local.

- Insira prompts, ajuste configurações como passos de inferência (20-50 para equilíbrio) e gere.

Extensões como a web UI do Automatic1111 adicionam recursos como processamento em lote. Uma vez configurado, ele roda inteiramente offline, priorizando privacidade.

Treinar Seu Próprio Modelo de Stable Diffusion

Usuários avançados podem personalizar o Stable Diffusion:

- Reúna um conjunto de dados de pares imagem-texto (por exemplo, para estilos nicho).

- Prepare os dados limpando e legendando.

- Modifique configs para seu conjunto de dados e hiperparâmetros (tamanho de lote, taxa de aprendizado).

- Treine componentes separadamente (VAE, U-Net, codificador de texto) usando scripts —alugue GPUs na nuvem para tarefas pesadas.

- Avalie e ajuste finamente de forma iterativa.

Esse processo exige conhecimento técnico, mas desbloqueia modelos adaptados para domínios específicos como moda ou arquitetura.

Stable Diffusion XL: A Versão Aprimorada

Lançado em julho de 2023 pela Stability AI, o SDXL se baseia no original com uma contagem maior de parâmetros para detalhes superiores. Ele simplifica prompts (menos palavras necessárias), inclui estilos integrados e se destaca em texto legível dentro de imagens. Para profissionais, o SDXL Online via plataformas dedicadas entrega saídas de ultra-alta resolução para visuais de marketing, ativos de jogos ou impressões. É um passo adiante para aqueles buscando fotorealismo ou designs intricados sem comprometer a velocidade.

Usar LoRAs, Embeddings e Prompts Negativos

- LoRAs: Baixe arquivos especializados (por exemplo, para retratos) e ative-os via prompts como "lora:portrait_style:1.0". Eles aprimoram detalhes de forma eficiente.

- Embeddings: Treine em conjuntos de dados de estilos, então invoque com ":style_name:" em prompts para consistência temática.

- Prompts Negativos: Especifique evita como "deformed, ugly" para minimizar falhas, melhorando a precisão geral da saída.

Aplicações Práticas e Casos de Uso

O Stable Diffusion brilha em vários cenários:

- Artistas e Designers: Prototipe conceitos, gere referências ou experimente estilos para arte digital, ilustrações ou mockups de UI/UX.

- Marketing e Mídia: Crie visuais personalizados para anúncios, mídias sociais ou conteúdo sem fotos stock —ideal para renders de produtos de e-commerce.

- Educação e Entusiastas: Ensine conceitos de IA ou crie arte personalizada como hobby, como retratos familiares em cenários de fantasia.

- Desenvolvimento de Jogos: Criação de ativos para personagens, ambientes ou texturas, especialmente com ControlNet para controle de poses.

Sua capacidade offline se adequa a criadores remotos, enquanto o acesso API (via Dream Studio ou Hugging Face) se integra em fluxos de trabalho.

Para Quem é o Stable Diffusion?

Essa ferramenta visa profissionais criativos, de artistas digitais novatos a desenvolvedores experientes. Iniciantes apreciam as interfaces intuitivas, enquanto experts valorizam opções de personalização como ajuste fino. É perfeita para quem prioriza ética open-source e privacidade local sobre dependências em nuvem. No entanto, é menos adequada para tarefas não criativas ou usuários sem configuração técnica básica.

Limitações e Melhores Práticas

Apesar das forças, o Stable Diffusion tem obstáculos:

- Vieses: Saídas podem favorecer estéticas ocidentais; prompts diversos e ajuste fino ajudam a mitigar.

- Desafios Anatômicos: Mãos e rostos podem distorcer —use prompts negativos ou LoRAs.

- Necessidades de Recursos: Execuções locais requerem hardware decente; alternativas em nuvem como Stablediffusionai.ai preenchem lacunas.

Sempre revise por questões éticas, como direitos autorais em dados de treinamento. Comunidades no Civitai ou Reddit oferecem modelos e dicas para superar falhas.

Por Que Escolher o Stable Diffusion?

Em um panorama de IA lotado, a natureza open-source do Stable Diffusion fomenta inovação, com atualizações constantes da comunidade. Comparado a ferramentas fechadas como DALL-E, ele oferece gerações ilimitadas sem cotas e propriedade total das saídas. Para necessidades de alta resolução, o SDXL entrega qualidade profissional de forma acessível. Seja para激发 ideias ou finalizar projetos, ele capacita usuários a combinar engenhosidade humana com eficiência de IA.

Preços e Acesso

O núcleo do Stable Diffusion é gratuito para download e uso. Plataformas como Stablediffusionai.ai podem oferecer níveis gratuitos com upgrades pagos para gerações mais rápidas ou recursos avançados. Créditos API do Dream Studio começam baixos, escalando para uso intensivo. Configurações locais eliminam custos contínuos, tornando-o viável economicamente para criatividade sustentada.

Em essência, o Stable Diffusion redefine a geração de arte de IA colocando o poder nas mãos dos usuários. Mergulhe em seu ecossistema via GitHub ou demos online, e desbloqueie possibilidades infinitas para narrativa visual.

Tags Relacionadas a Stable Diffusion