AnimateDiff 概述

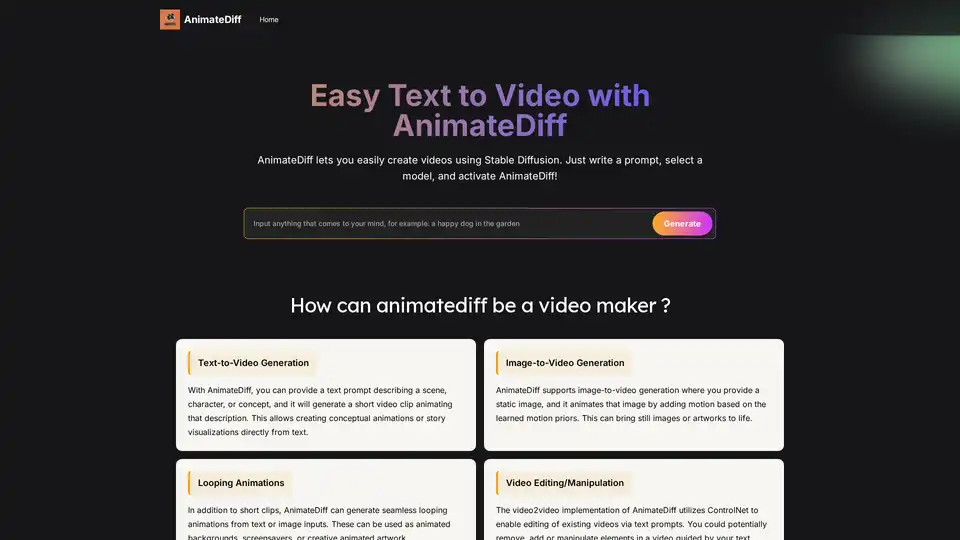

什么是AnimateDiff?

AnimateDiff是一款创新的AI工具,通过生成流畅的帧序列将静态图像或文本提示转换为动态动画视频。它基于Stable Diffusion构建,集成了专业运动模块来预测并应用逼真运动,是AI驱动视频创作领域的颠覆性工具。无论您是构思创意的艺术家还是制作视觉原型的开发者,AnimateDiff都能简化从概念到生动动画的转换过程,无需手动逐帧操作。这个开源框架可通过AUTOMATIC1111's WebUI等扩展使用,使用户能够利用扩散模型进行文本到视频和图像到视频生成,为艺术、游戏和教育等领域的高效内容创作开辟新途径。

AnimateDiff如何工作?

AnimateDiff的核心是将预训练的文本到图像或图像到图像扩散模型(如Stable Diffusion)与专用运动模块相结合。该模块通过多样化的真实视频片段训练,捕捉常见运动模式、动态和转场,确保动画呈现自然生动的效果。

文本到视频流程

- 输入提示:从描述性文本提示开始,概述场景、角色、动作或概念——例如“黄昏时分萤火虫在宁静森林中飞舞”。

- 基础模型生成:Stable Diffusion主干网络根据提示生成初始关键帧,聚焦视觉内容。

- 运动集成:运动模块分析提示和前序帧以预测动态,插入中间帧实现无缝过渡。

- 输出渲染:协同系统生成短视频片段或GIF,通常为16-24帧8-16FPS,展示运动中的动画元素。

图像到视频流程

对现有视觉内容进行动画化:

- 上传图像:提供静态照片、艺术作品或AI生成图像。

- 变体生成:使用Stable Diffusion的img2img功能创建细微的关键帧变体。

- 运动应用:运动模块添加推断动态,动画化物体或背景等元素。

- 最终视频:生成生动片段使原始图像焕发生机, ideal for为数字艺术或个人照片注入活力。

这种即插即用方法意味着无需大量重新训练——只需将运动模块集成到Stable Diffusion环境中。用户可通过高级选项(如用于摄像机效果的运动LoRA)或通过参考视频引导运动的ControlNet来微调输出,增强控制力和创造力。

AnimateDiff核心特性

- 即插即用集成:通过扩展与Stable Diffusion v1.5模型无缝协作,基础使用无需复杂设置

- 多模式生成:支持文本到视频、图像到视频、循环动画及文本引导的视频到视频编辑

- 个性化选项:结合DreamBooth或LoRA对自定义数据集训练的主体进行动画化

- 高级控制:调整FPS、帧数、上下文批处理大小以获得更流畅运动;启用闭合循环实现无缝周期或反转帧扩展流畅度

- 高效性:在性能硬件上快速生成短视频片段,比从头构建单体视频模型更高效

这些特性使AnimateDiff成为快速原型设计的灵活工具,显著缩短从创意到动画输出的时间。

如何使用AnimateDiff

入门非常简单,特别是使用animatediff.org的免费在线版本无需安装。

在线使用(无需设置)

- 访问animatediff.org

- 输入文本提示(如“猫咪跳过彩虹”)

- 选择可用模型和运动风格

- 点击生成——AI在服务器端处理并交付可下载GIF或视频

- 适合初学者或快速测试,完全在线无需本地资源

高级用户本地安装

释放全部潜力:

- 安装AUTOMATIC1111的Stable Diffusion WebUI

- 进入扩展>从URL安装,粘贴:https://github.com/continue-revolution/sd-webui-animatediff

- 下载运动模块(如mm_sd_v15_v2.ckpt)放入extensions/animatediff/model文件夹

- 重启WebUI;AnimateDiff出现在txt2img/img2img标签页

- 输入提示,启用AnimateDiff,设置帧数/FPS,生成

Google Colab用户可使用云端运行的notebook。除基础设置外无需编程专业知识——教程指导Python和Nvidia CUDA等依赖项。

系统要求

- GPU:Nvidia 8GB+显存(视频到视频需10GB+);推荐RTX 3060或更高

- 操作系统:主要支持Windows/Linux;macOS通过Docker

- 内存/存储:16GB内存,1TB存储空间用于模型和输出

- 兼容性:仅支持Stable Diffusion v1.5;关注GitHub更新

满足这些条件后,生成时间缩短至每分钟片段,随硬件性能扩展。

潜在应用场景

AnimateDiff在需要快速AI辅助动画的场景中表现突出,符合高效视觉叙事的搜索意图。

艺术与动画

艺术家可从文本快速原型化草图或故事板,节省手动绘制时间。例如即时可视化角色行走循环,在创意工作流中快速迭代。

游戏开发

快速生成原型资源动画——如敌人移动或UI过渡——加速预生产阶段无需完整动画团队。

教育与可视化

将抽象概念转化为引人入胜的视频,如动画化历史事件或科学过程,使学习交互性强且记忆深刻。

社交媒体与营销

创建吸睛帖子或广告:描述产品发布,即可获得适用于Instagram或TikTok的循环动画,以最小投入提升参与度。

动态图形与预可视化

为视频制作动态片头或在昂贵渲染/拍摄前预览复杂场景,适合电影制作人或AR/VR开发者。

在增强现实中,它以自然动作动画化角色;在广告中,从品牌图像制作个性化宣传片段。

为什么选择AnimateDiff?

与Adobe After Effects等传统工具相比,AnimateDiff自动化重负荷工作,使高质量动画无需专业技能即可实现。其依赖从真实视频学习的运动先验确保真实性,而通过提示的控制力解决了AI生成的常见痛点。免费开源特性对爱好者和专业人士都具成本效益,通过GitHub社区驱动更新。虽不适用于好莱坞级复杂度,但在创意构思和短格式内容方面无可匹敌,推动AI视频工具创新。

对于搜索“最佳文本到视频AI”或“用Stable Diffusion动画化图像”的用户,AnimateDiff凭借其扩散模型传承和运动专业知识交付可靠成果。

适用人群

- 创意专业人士:需要快速可视化的艺术家、动画师和设计师

- 开发者和游戏玩家:用于原型化交互元素

- 教育者/内容创作者:构建解释性或娱乐性媒体

- 营销人员/社交影响者:快速可定制的动画资源

- 爱好者:对AI动画好奇且无技术门槛的任何人

特别适合熟悉Stable Diffusion的用户,但在线演示降低了入门门槛。

限制与最佳实践提示

虽然功能强大,AnimateDiff存在限制:

- 运动范围:最适合简单、符合训练数据的运动;复杂动作可能需要调整

- 伪影问题:较高运动可能产生异常——从较低帧数开始尝试

- 长度/连贯性:擅长短片段(50帧以内);长视频可能不一致

- 模型限制:仅支持SD v1.5;关注v2兼容性

提示:使用含动作描述符的详细提示(如“缓慢旋转的摄像机”),尝试不同风格的LoRA,并在Premiere等工具中进行后处理优化。随着扩散技术发展,AnimateDiff社区持续改进,承诺更流畅输出。

总之,AnimateDiff通过融合Stable Diffusion的图像能力与智能运动预测,彻底改变动画创作方式。对于探索AI视频生成的任何人,这都是一个能轻松将想象转化为动作的必试工具。

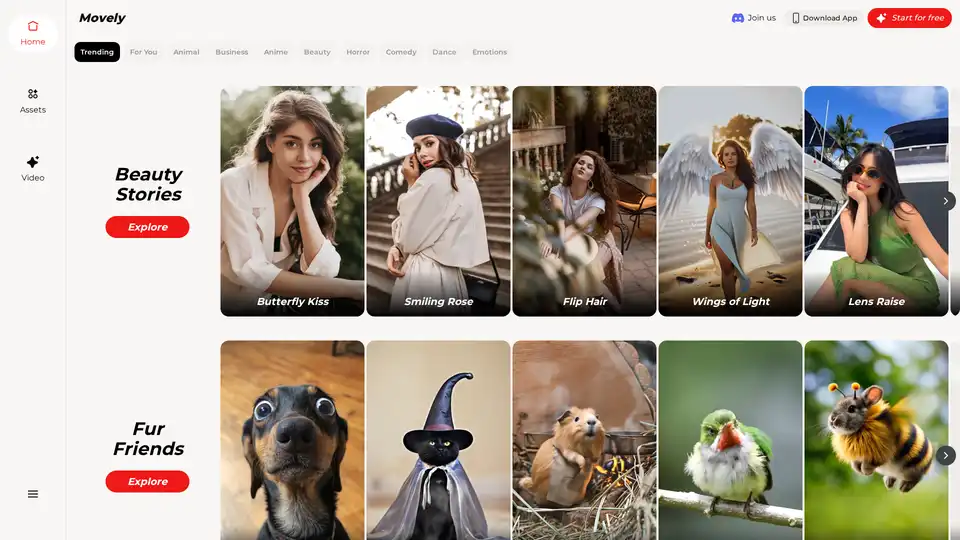

"AnimateDiff"的最佳替代工具

Yolly AI 是一款一体化 AI 视频和照片生成器,可将文本提示转换为电影级 4K 视频(带逼真声音)或在几秒钟内生成高分辨率图像,并提供对 Veo 3 和 DALL-E 等顶级 AI 模型的访问。

Morph Studio 是一个 AI 驱动的视频创作和编辑平台,提供文本转视频、图像转视频和视频风格转换功能,专为休闲和专业用途而设计。

AIVidly是一款iPhone全能AI视频制作App,可将文本转化为专业视频,配以AI语音、特效,并优化适用于TikTok和YouTube Shorts——无需编辑技能。

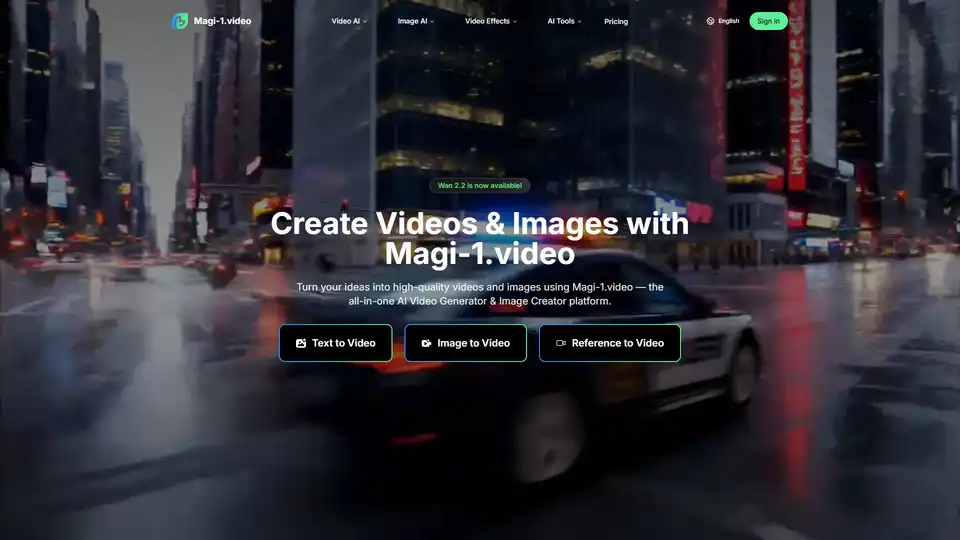

探索Wan 2.2 AI,这是一个前沿平台,支持文本转视频和图像转视频生成,具有电影级控制、专业运动和720p分辨率。适合寻求高质量AI视频工具的创作者、营销人员和制作者。

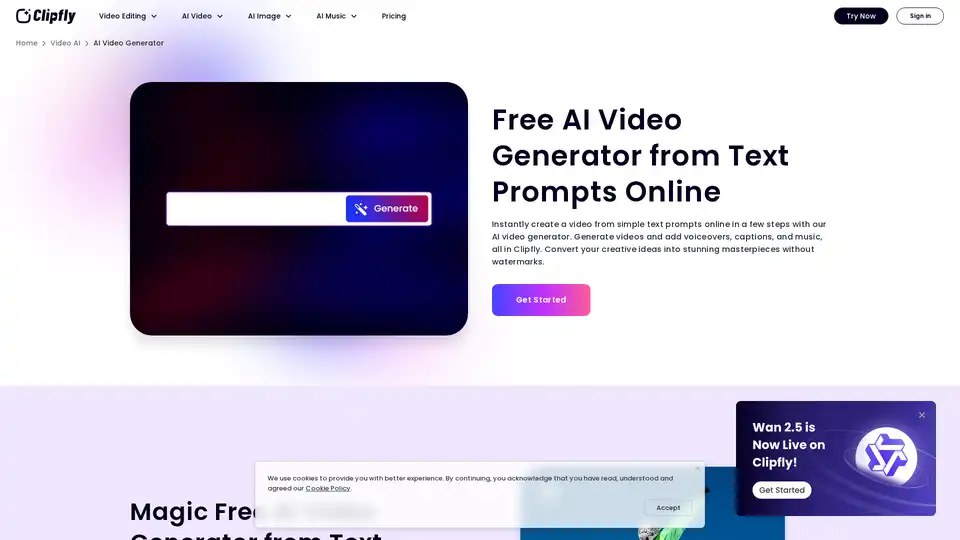

使用Clipfly的免费AI视频生成器,在线从文本和图像创建令人惊叹的AI视频。无需任何技能,几分钟内即可生成无水印的AI视觉效果。立即尝试!

Jimeng AI是一个AI视频生成平台,可以通过简单的文本或图像快速创建高质量的视频片段。 功能包括流畅的摄像机运动、精确的控制以及对中文提示的支持。

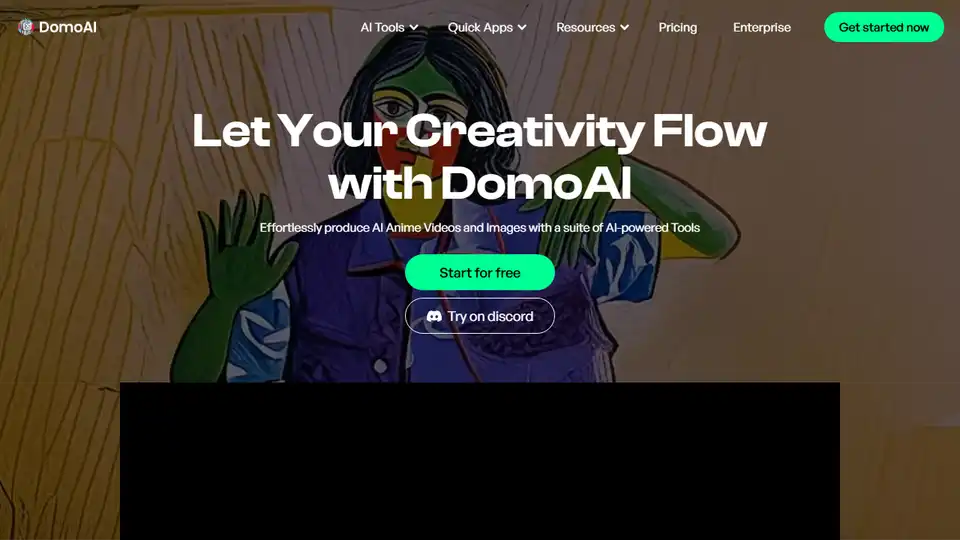

DomoAI是一个免费的AI创意工作室,可以将视频、文本和图像转换为高质量的动画。 使用DomoAI让任何角色动起来。 从文本生成AI视频,为图像制作动画,并将素材转换为创意内容。

使用 DeeVid AI 视频生成器轻松生成专业质量的视频。在一分钟内将文本、图像或视频提示转化为令人惊叹的视频。立即开始创作 AI 视频!

由 Luma Dream Machine AI 提供支持的免费图像转视频工具。将图像和文本转换为视频。创作惊艳的视频、图像和音乐。