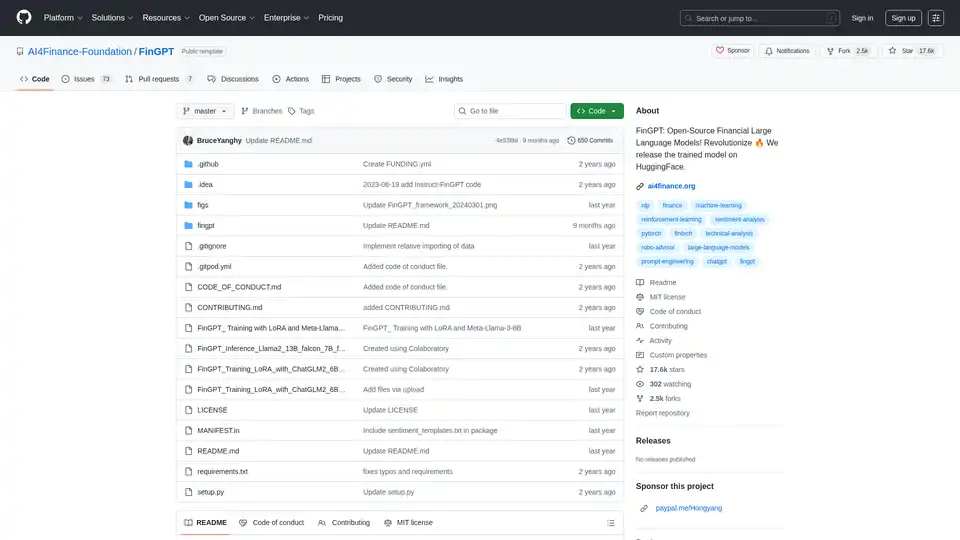

ChatLLaMA 概述

什么是 ChatLLaMA?

ChatLLaMA 是可访问 AI 技术的一个开创性步骤,设计为一个个人 AI 助手,由基于 LLaMA 模型的 LoRA(Low-Rank Adaptation)微调驱动。这个开源工具允许用户直接在自己的 GPU 上运行定制的对话 AI,消除对云服务的依赖,并增强隐私保护。专门使用 Anthropic 的高质量 HH 数据集进行训练,该数据集专注于有帮助且诚实的对话,ChatLLaMA 在模拟用户与 AI 助手之间无缝、自然的对话方面表现出色。无论您是开发者实验本地 AI 设置,还是爱好者寻求定制聊天机器人,ChatLLaMA 都能将先进的语言模型能力带到您的桌面。

目前提供 30B、13B 和 7B LLaMA 模型的版本,支持高达 2048 个 Token 的序列长度,使其适用于扩展交互。该工具包括用户友好的桌面 GUI,简化了非专家的设置和使用。以仅 3 美元的实惠价格,它已获得超过 2,011 次销售和来自 127 名用户的稳固 4.8 星评价,其中 92% 给出了五星。用户赞扬其创新方法,尽管有些人表示尚未完全测试它——这突显了对其潜力的兴奋。

ChatLLaMA 如何工作?

在核心上,ChatLLaMA 利用 LoRA,这是一种高效的微调方法,可以适应像 LLaMA 这样的预训练大型语言模型,而无需大量计算资源。LoRA 不是重新训练整个模型,而是向模型权重引入低秩矩阵,专注于关键参数的更新。这产生了一个轻量级适配器——LoRA 权重——可以加载到基础 LLaMA 模型上,以将其专用于对话任务。

训练过程使用 Anthropic 的 HH(Helpful and Harmless)数据集,这是一个强调道德和有用响应的对话示例集合。这确保 ChatLLaMA 生成的响应不仅引人入胜,而且安全且上下文合适。例如,它模拟真实的来回交流,使交互感觉更像人类,而非通用聊天机器人。

即将推出的 RLHF(Reinforcement Learning from Human Feedback)版本承诺更好地与用户偏好对齐,通过人类评级的细化潜在改善响应质量。要运行它,用户下载所选模型大小的 LoRA 权重,并将其集成到本地 LLaMA 推理设置中。桌面 GUI 简化了这一过程:启动界面,选择您的模型,加载权重,然后开始聊天——一切由您的 GPU 驱动,实现低延迟性能。

不提供基础模型权重,因为 ChatLLaMA 旨在用于研究,并假设用户可以访问基础 LLaMA 模型(这些模型公开可用)。这种模块化设计提供了灵活性;例如,您可以尝试不同的基础模型,甚至为未来的训练迭代贡献数据集。

如何使用 ChatLLaMA?

使用 ChatLLaMA 入门很简单,尤其是借助其桌面 GUI。以下是逐步指南:

获取基础模型:从官方来源如 Hugging Face 下载 LLaMA 7B、13B 或 30B 模型权重。确保您的系统具有兼容 GPU(推荐 NVIDIA,并有足够的 VRAM——7B 至少 8GB,更大模型需要更多)。

购买并下载 LoRA 权重:以 3 美元的价格获取针对您模型大小定制的 ChatLLaMA LoRA 权重。这些权重有标准版和 2048 序列版,用于处理更长的上下文。

安装桌面 GUI:开源 GUI 作为包的一部分提供。安装依赖项如 Python、PyTorch 和任何兼容 LLaMA 的库(例如 llama.cpp 用于高效推理)。运行 GUI 可执行文件以设置您的环境。

加载并启动:在 GUI 中指向您的基础模型和 LoRA 权重。配置设置,如温度用于响应创意或最大 Token 用于输出长度。启动聊天会话以测试对话流。

定制和实验:输入提示以模拟对话。对于高级用户,调整 LoRA 适配器或通过脚本集成以实现自动化。如果遇到设置问题,活跃的 Discord 社区提供实时支持。

GUI 处理了大部分繁重工作,即使您是 AI 部署新手,也很容易上手。在强大硬件上,响应时间很快,通常每轮不到一秒。

为什么选择 ChatLLaMA?

在由 ChatGPT 等云基 AI 主导的景观中,ChatLLaMA 以其对本地执行的强调脱颖而出。这意味着没有订阅费,没有数据发送到外部服务器,以及对 AI 交互的完全控制——适合注重隐私的用户或互联网有限的地区。其基于 LoRA 的方法资源高效,允许微调性能,而无需完整模型训练的开销,后者可能花费数千美元计算成本。

用户反馈突显了其价值:一位评论者称其概念“甜蜜”,而其他人欣赏自定义助手的潜力。随着高评价和强劲销售,很明显 ChatLLaMA 在 AI 社区中引起共鸣。此外,项目的开源精神邀请协作;鼓励开发者贡献代码,并通过 Discord 提供 GPU 资源作为交换。

与其他替代品相比,ChatLLaMA 专注于 HH 等对话数据集,在自然对话建模方面具有优势。它不仅仅是一个聊天机器人——它是构建专用助手的基石,从研究工具到个人生产力辅助。

ChatLLaMA 适合谁?

ChatLLaMA 针对多样化受众量身定制:

AI 研究者和开发者:完美用于实验 LoRA 微调、RLHF 集成或数据集贡献。如果您正在构建开源 AI 应用,此工具提供现成的对话骨干。

科技爱好者和业余爱好者:离线运行您自己的 AI 伴侣,并为其定制以供娱乐或学习。多亏 GUI,无需高级编码。

注重隐私的用户:对云 AI 谨慎的企业或个人可以部署安全的、本地实例,用于内部聊天或原型设计。

教育者和学生:使用它亲身探索大型语言模型,模拟道德 AI 对话,而无需基础设施障碍。

它特别适合拥有中端 GPU 的人,因为 7B 模型可在适中硬件上运行。不过,它是研究导向的,因此请预期自己处理基础模型——不是绝对初学者的即插即用。

最大化 ChatLLaMA 潜力的最佳方法

要充分利用 ChatLLaMA:

集成高质量数据集:与团队分享对话数据集,推动社区驱动改进。这可能导致专用版本,如行业特定助手。

与其他工具结合:将其与语音界面配对用于混合设置,或通过 API 嵌入应用以实现更广泛的应用。

监控性能:跟踪对话中的连贯性和相关性等指标。即将推出的 RLHF 更新很可能进一步提升这些。

加入社区:Discord 上充斥着提示,从优化调整到协作机会。开发者:联系 @devinschumacher 以获取 GPU 辅助项目。

总之,ChatLLaMA 通过使 LoRA 驱动的、本地对话模型可访问和可定制,从而使先进 AI 民主化。无论您是革新个人 AI 还是贡献开源创新,此工具在不断演进的大型语言模型世界中提供巨大的实际价值。深入探索,并保持 funky,同时发掘其能力。

"ChatLLaMA"的最佳替代工具

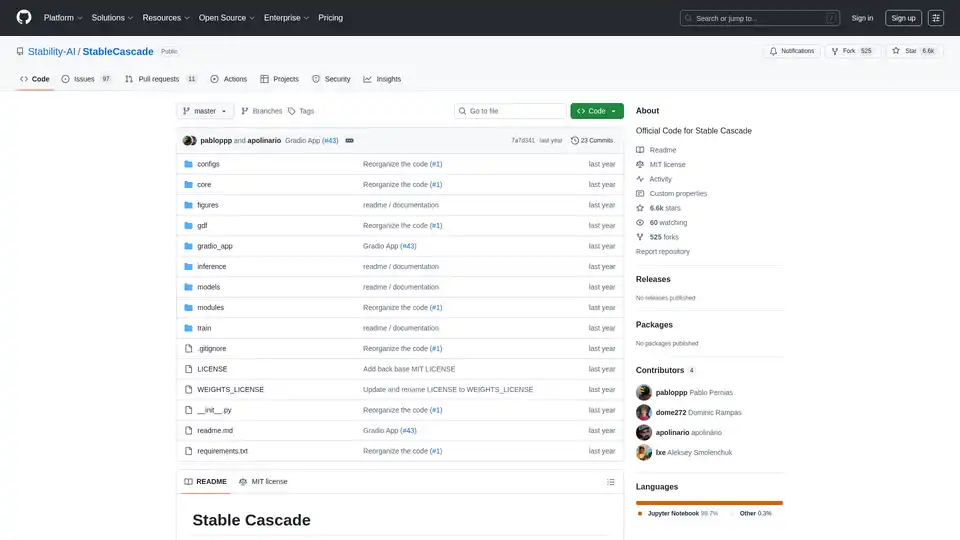

Stable Cascade 是一个基于 Würstchen 架构的高效文本到图像模型,提供快速推理和经济高效的训练。探索其图像生成等功能。

探索Pykaso AI,这是创建超现实AI图像、视频和自定义角色的终极平台。训练LoRa模型、增强皮肤,并轻松生成病毒式内容,实现社交媒体成功。

了解如何在 Google Colab 上使用 AUTOMATIC1111 的 Web UI 轻松运行 Stable Diffusion。安装模型、LoRA 和 ControlNet,实现快速 AI 图像生成,无需本地硬件。

CGDream AI图像生成器:免费AI图像生成,支持文本、照片或3D模型。使用Lora风格、图像修复、放大等功能,创作精美视觉效果。

在 Flux LoRA 模型库中浏览和比较最新的 Flux LoRA 模型。找到完美的 Flux LoRA 来增强您的 Flux 模型生成体验,用于 AI 图像创建。

Stable Diffusion API使您能够轻松生成和微调AI图像。无需昂贵的GPU即可访问文本到图像、图像到图像和图像修复API。

dreamlook.ai 提供闪电般的 Stable Diffusion 微调,使用户能够以 2.5 倍的速度训练模型并快速生成高质量图像。提取 LoRA 文件以减少下载大小。