local.ai 概述

Local AI Playground: 离线 AI 实验的入口

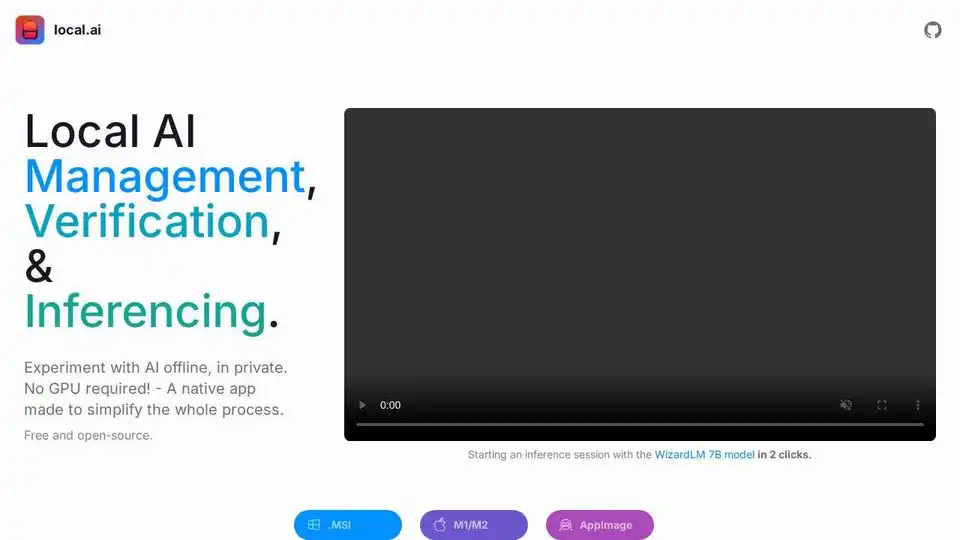

什么是 Local AI Playground?

Local AI Playground 由 local.ai 驱动,是一个免费且开源的原生应用程序,旨在简化本地 AI 模型实验的过程,即使没有 GPU 也能进行。 它允许您离线、私密地运行 AI 推理,为初学者和高级用户提供简化的体验。

local.ai 如何工作?

Local.ai 通过其用户友好的界面和高效的 Rust 后端简化了 AI 模型管理、验证和推理。以下是其主要功能和特性的细分:

主要功能:

- CPU 推理: 适应可用线程并支持 GGML 量化(q4、5.1、8、f16)以实现高效的基于 CPU 的 AI 推理。

- 模型管理: 用于跟踪 AI 模型的集中位置,具有诸如可恢复的并发下载器、基于使用情况的排序和与目录无关的设置等功能。

- 摘要验证: 通过 BLAKE3 和 SHA256 摘要计算、已知良好模型 API 以及许可/使用芯片来确保模型完整性。

- 推理服务器: 只需单击两次即可启动用于 AI 推理的本地流式服务器,从而提供快速推理 UI 并将输出写入 .mdx 文件。

可用功能:

- 流式服务器

- 快速推理 UI

- 写入 .mdx

- 推理参数

- 远程词汇表

- 摘要计算

- 已知良好模型 API

- 许可和使用芯片

- BLAKE3 快速检查

- 模型信息卡

即将推出的功能:

- GPU 推理

- 并行会话

- 嵌套目录

- 自定义排序和搜索

- 模型资源管理器

- 模型搜索

- 模型推荐

- 服务器管理器

- /audio

- /image

如何使用 local.ai:

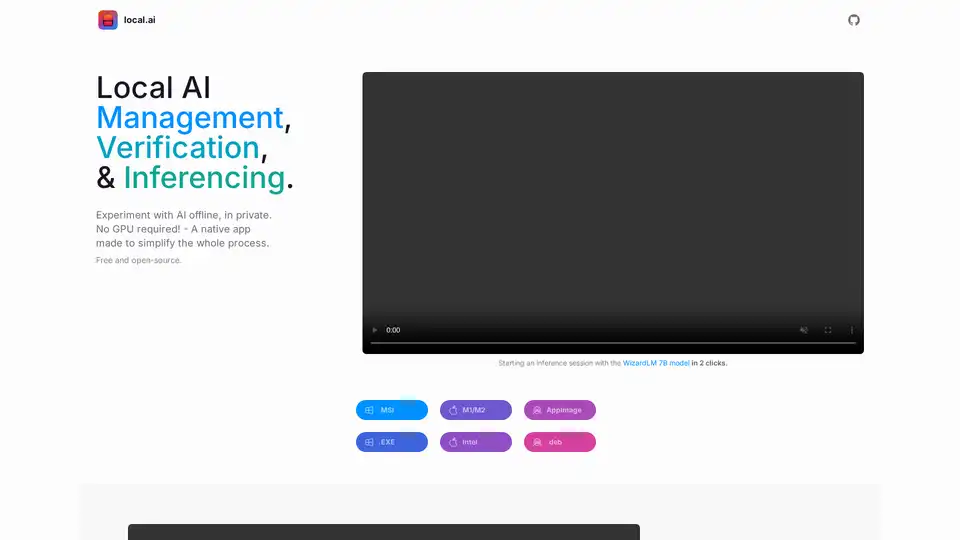

- 下载并安装: 下载适用于您操作系统的相应版本(.MSI、.EXE、M1/M2、Intel、AppImage、.deb)。

- 模型管理: 选择一个目录来跟踪您的 AI 模型。 该应用程序提供诸如可恢复的下载和基于使用情况的排序等功能。

- 推理服务器: 加载模型并只需单击两次即可启动服务器,以开始 AI 推理。

为什么 local.ai 很重要?

- 隐私: 离线且私密地运行 AI 模型。

- 可访问性: 不需要 GPU,从而使更多用户可以进行 AI 实验。

- 效率: Rust 后端确保内存效率和紧凑的占用空间。

- 开源: 免费且开源,鼓励社区贡献和透明度。

在哪里可以使用 local.ai?

Local.ai 可用于各种设置,包括:

- AI 开发: 用于测试和实验 AI 模型,而无需依赖云服务。

- 教育目的: 用于在实践性的离线环境中学习和理解 AI 概念。

- 隐私敏感型应用: 用于在敏感数据上运行 AI 模型,而无需将其传输到外部服务器。

开始使用 local.ai 的最佳方法是什么?

下载 local.ai,然后只需单击几下即可使用 WizardLM 7B 模型或任何其他开源模型进行实验。 local.ai 提供了简化的流程和强大的功能,可帮助您离线或在线管理所有 AI 模型。

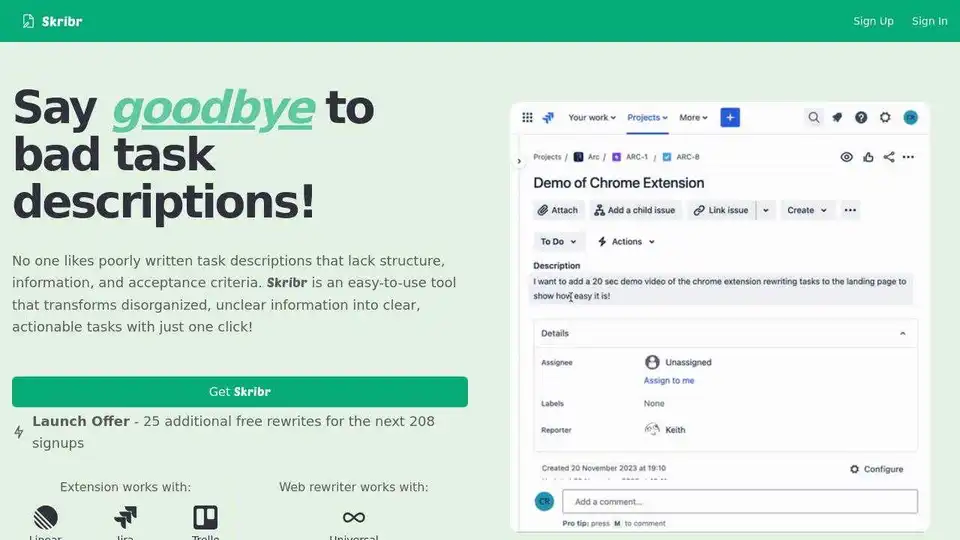

"local.ai"的最佳替代工具

AI Runner是一个离线AI推理引擎,用于艺术创作、实时语音对话、LLM驱动的聊天机器人和自动化工作流程。在本地运行图像生成、语音聊天等!

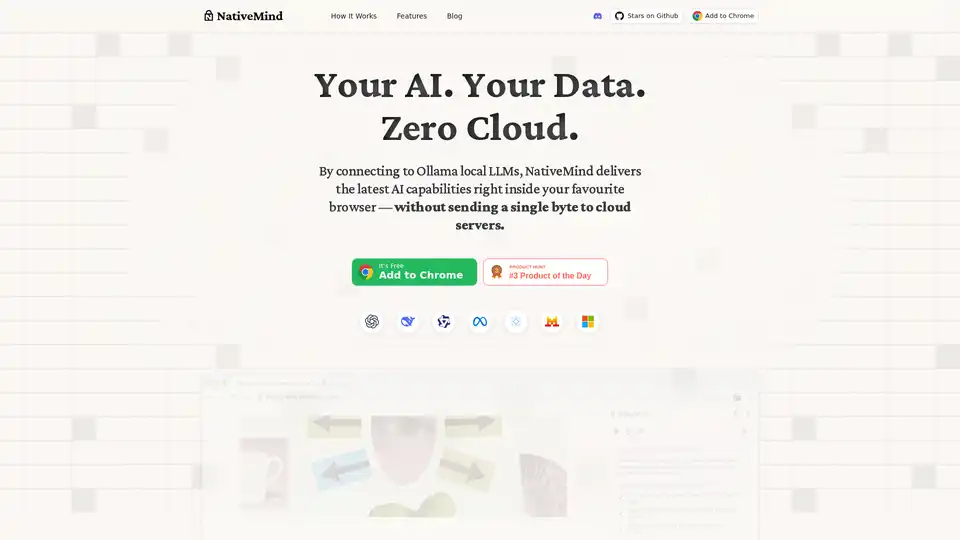

NativeMind是一个开源Chrome扩展,使用Ollama等本地LLM运行,提供完全离线、私密的ChatGPT替代品。功能包括上下文感知聊天、代理模式、PDF分析、写作工具和翻译——全部100%设备本地运行,无云依赖。

Agent Herbie 是一款离线 AI 代理,专为私有环境中的实时、关键任务型操作而设计。它利用 LLM、SLM 和 ML,提供卓越的灵活性和可靠性,且无需数据出口。

LM Studio 是一款用户友好的桌面应用,用于在您的电脑上本地运行和下载 LLaMa 和 Gemma 等开源大语言模型 (LLM)。它提供应用内聊天界面和兼容 OpenAI 的本地服务器,无需编程技能即可离线使用AI模型。

Synthesizer V Studio 2 Pro是一款AI驱动的人声合成软件,使用符合道德标准的AI人声模型生成专业人声。通过MIDI输入创建具有跨语言功能的富有表现力的人声。

Amuse是一款免费的AI艺术生成器,使用针对AMD硬件优化的Stable Diffusion模型,可在个人PC上无需互联网连接进行图像和视频生成。

DrawingPics是一款离线AI艺术生成器,可以将粗略的草图转化为精美的图像。它支持自定义模型和LoRA,并且100%本地运行。

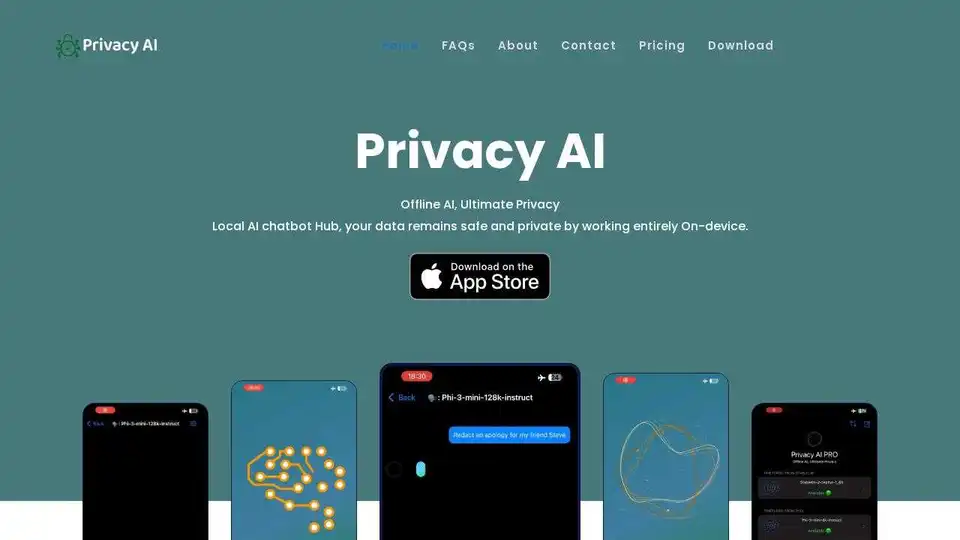

Privacy AI 是一款离线 AI 聊天机器人中心,确保终极数据隐私。在您的设备上本地运行语言模型,无需互联网即可进行安全对话。