Prompt Token Counter for OpenAI Models 概述

Prompt Token Counter: OpenAI 模型 Token 估算的简单工具

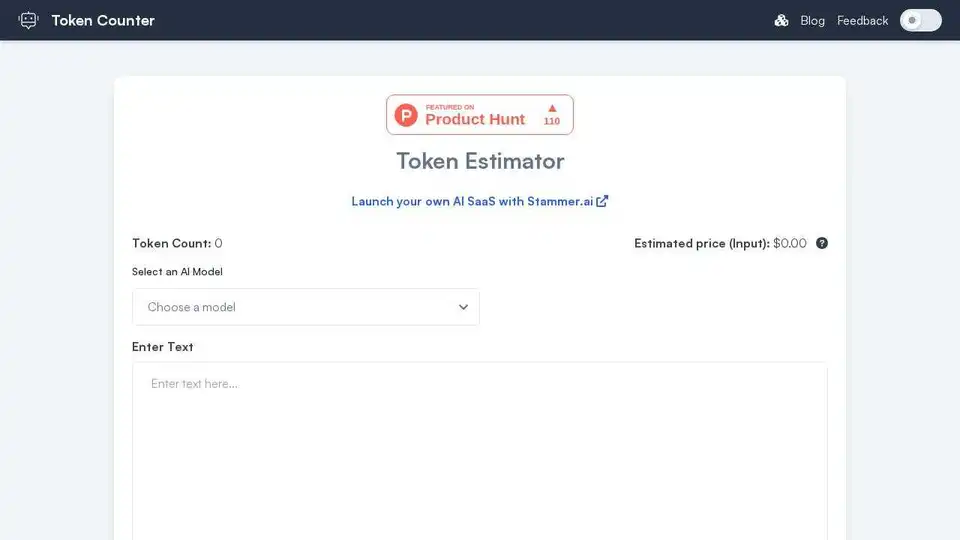

什么是 Prompt Token Counter?

Prompt Token Counter 是一款在线工具,旨在帮助用户在使用 GPT-3.5、GPT-4 等 OpenAI 模型时,估算其 Prompt 将消耗的 Token 数量。了解 Token 使用情况对于控制模型用量限制和有效管理成本至关重要。

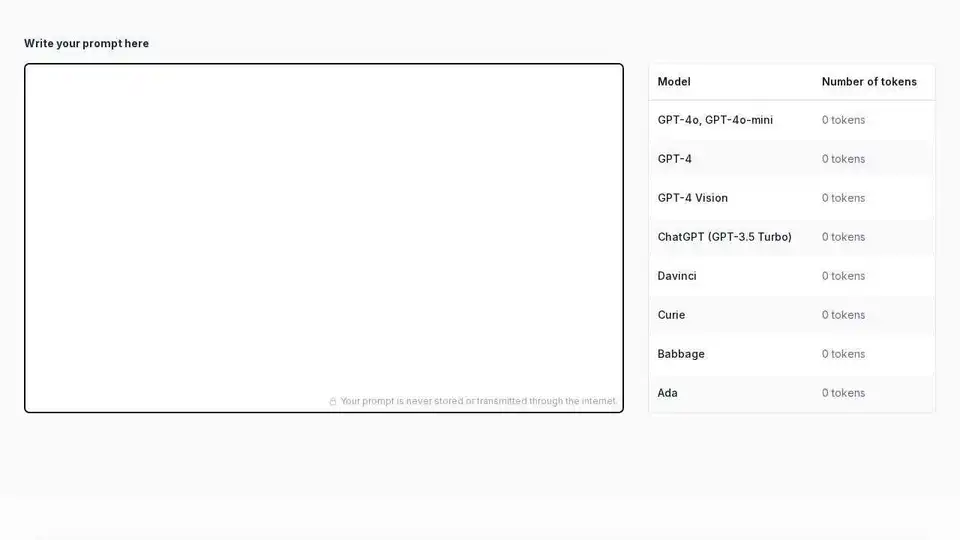

Prompt Token Counter 如何工作?

只需在提供的文本区域中键入或粘贴您的 Prompt。该工具会立即计算并显示各种 OpenAI 模型的 Token 数量,包括 GPT-4o、GPT-4、ChatGPT (GPT-3.5 Turbo)、Davinci、Curie、Babbage 和 Ada。该计数器会在您键入时实时更新,从而提供有关 Token 使用情况的即时反馈。

为什么 Prompt Token Counter 很重要?

- 控制模型用量限制: OpenAI 模型对单次交互中可以处理的 Token 数量有限制。超出这些限制可能会导致错误或截断的输出。

- 成本控制: OpenAI 根据 Token 使用量收费。估算 Token 数量有助于您管理成本并避免意外支出。

- 高效的 Prompt 工程: 了解 Token 数量使您能够制作简洁有效的 Prompt,从而在不超出限制的情况下最大限度地发挥模型的功能。

主要特点:

- 实时 Token 计数: Token 数量会在您键入时立即更新,从而提供即时反馈。

- 支持多种 OpenAI 模型: 该工具支持各种 OpenAI 模型,包括最新的 GPT-4o、GPT-4、ChatGPT 以及 Davinci 和 Ada 等较旧的模型。

- 注重隐私: 您的 Prompt 永远不会被存储或通过互联网传输,从而确保您的隐私。

如何使用 Prompt Token Counter:

- 访问 Prompt Token Counter 网站。

- 在文本区域中键入或粘贴您的 Prompt。

- 观察所需 OpenAI 模型的 Token 数量。

- 根据需要调整您的 Prompt 以控制在 Token 限制内。

了解 Token:

在自然语言处理中,Token 是模型处理的最小文本单位。Token 可以是单词、字符或子词,具体取决于使用的 Token 化方法。不同的模型可能会以略有不同的方式 Token 化相同的文本。

什么是 Prompt?

Prompt 是您提供给语言模型的输入,用于启动任务或生成响应。一个精心设计的 Prompt 清晰、简洁,并包含从模型获得所需输出的所有必要信息。它为模型后续的输出设置了上下文。例如,向模型提供“写一首关于海洋的短诗”就是一个 Prompt。您的 Prompt 的质量和特异性会极大地影响生成的结果。

控制在 Token 限制内:

控制在 Token 限制内对于以下几个原因至关重要:

- 防止错误: 超出 Token 限制可能会导致模型出现错误或不完整的响应。

- 管理成本: OpenAI 根据 Token 使用量收费,因此控制在限制内有助于控制费用。

- 优化性能: 与冗长、杂乱的 Prompt 相比,更短、更集中的 Prompt 有时可以产生更好的结果。

通过使用 Prompt Token Counter,您可以确保您的 Prompt 在使用 OpenAI 模型时针对成本和性能进行了优化。

"Prompt Token Counter for OpenAI Models"的最佳替代工具

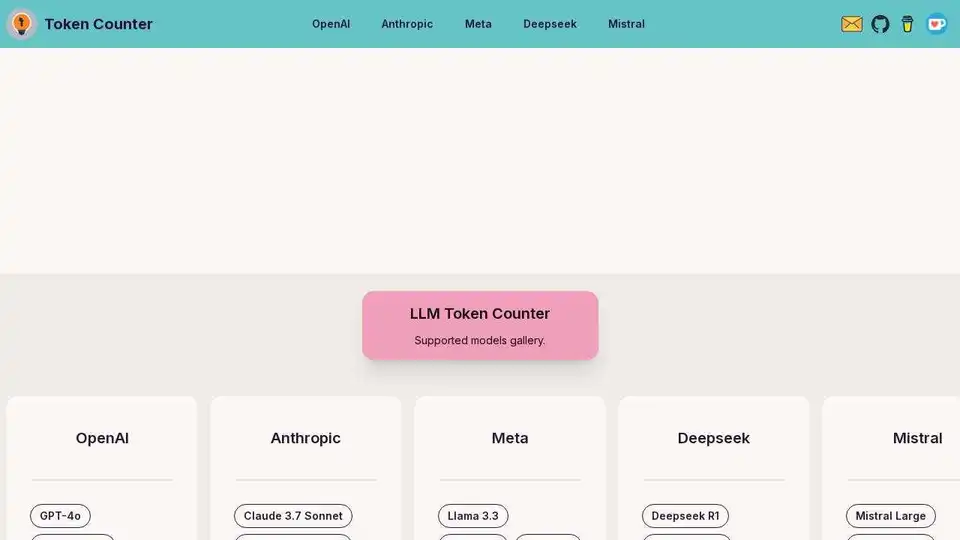

使用基于浏览器的 Tokenizer 计算所有流行 LLM(包括 GPT-4、Claude-3、Llama-3)的 prompt tokens。

16x Prompt 是一款 AI 编码工具,用于管理代码上下文、自定义提示,并通过 LLM API 集成更快地交付功能。非常适合寻求高效 AI 辅助编码的开发人员。

Token Counter 帮助估算 ChatGPT & GPT-3 等 AI 模型的成本。输入文本,获取 token 数量和成本,提高效率并防止浪费。

使用AI模型定价比较ChatGPT、Claude、Gemini及更多AI模型的价格。计算成本,找到最适合您需求的经济高效的AI解决方案。

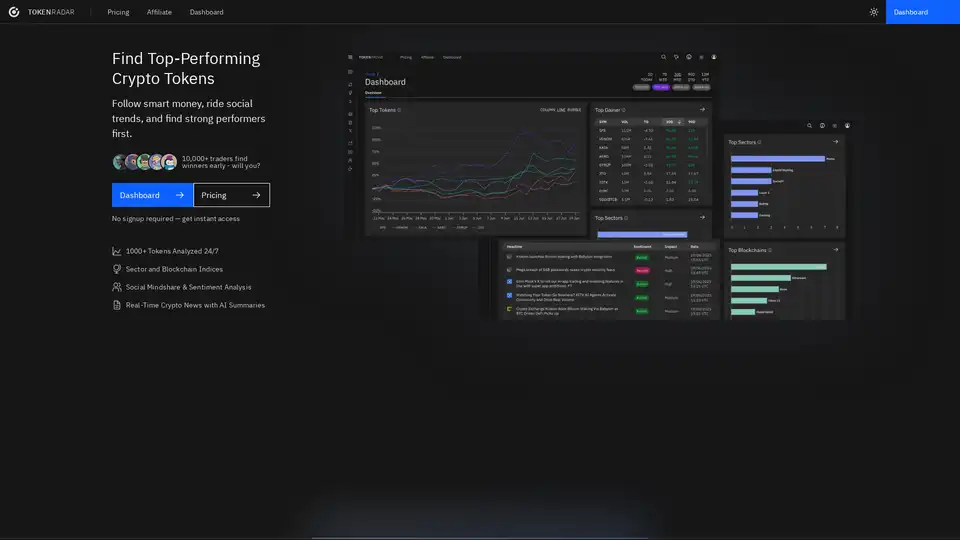

Token Radar 是一个 AI 驱动的平台,用于追踪顶级加密代币,分析行业和区块链,并提供实时情感和社会影响力洞察,帮助及早发现趋势。

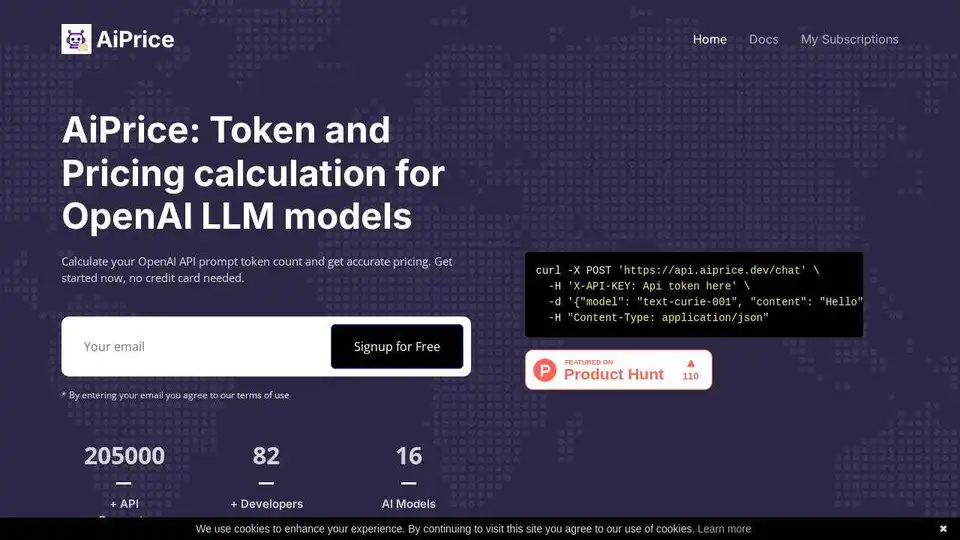

AiPrice提供了一个用于计算OpenAI token定价的API。准确预估各种LLM模型的prompt token数量。提供免费计划,无需信用卡。

Awan LLM提供无限token、无限制且经济高效的LLM推理API平台,非常适合开发者和高级用户。 无需担心token限制即可处理数据、完成代码并构建AI代理。

Awan LLM 提供无限、不受限制且经济高效的 LLM 推理 API 平台。它允许用户和开发人员访问强大的 LLM 模型,没有 token 限制,非常适合 AI 代理、角色扮演、数据处理和代码完成。

探索 Grok 4 Code,xAI 的 AI 编码助手,拥有 131k token 上下文窗口。为开发者提供高级代码生成、调试和无缝 IDE 集成等功能。