Stable Diffusion 概述

什么是 Stable Diffusion AI?

Stable Diffusion 是一款开创性的开源 AI 系统,它可以将文本描述转化为惊艳的、逼真的图像。由慕尼黑路德维希马克西米利安大学的 CompVis 团队开发,与 Runway ML 和 Stability AI 合作,它利用扩散模型实现文本到图像的生成、图像编辑等功能。与专有工具不同,Stable Diffusion 的代码、预训练模型和许可均为完全开源,允许用户在单一 GPU 上直接在其设备上运行。这项可及性使 AI 驱动的创造力民主化,让艺术家、设计师和爱好者无需企业级资源即可获得高质量图像生成。

在其核心,Stable Diffusion 擅长从简单提示生成详细视觉,支持高达 1024x1024 像素的分辨率。它特别以其在生成景观、肖像、抽象艺术甚至概念设计方面的多功能性而闻名。对于那些涉足 AI 艺术的人来说,Stable Diffusion 是一个可靠的切入点,提供创造自由,同时注意伦理使用,以避免训练数据中的偏见。

Stable Diffusion 如何工作?

Stable Diffusion 基于 Latent Diffusion Model (LDM) 架构运行,该架构在潜在空间中高效压缩和处理图像,而不是完整的像素空间,从而降低计算需求。该系统包括三个关键组件:

- Variational Autoencoder (VAE):这将输入图像压缩成紧凑的潜在表示,保留基本语义细节,同时丢弃噪声。

- U-Net:去噪主干,基于 ResNet 结构,在前向扩散过程中迭代去除添加的高斯噪声。它使用跨注意力机制来融入文本提示,引导生成朝着用户描述的输出方向发展。

- Text Encoder (Optional):将文本描述转换为影响去噪步骤的嵌入。

过程从向潜在图像添加噪声开始(或从纯噪声开始用于生成)。然后,U-Net 逐步逆转这一扩散过程,精炼输出直到出现连贯的图像。一旦去噪,VAE 解码器重建最终的基于像素的图像。这一优雅的工作流程确保即使对于涉及风格、构图或主题的复杂提示,也能获得高保真结果。

在庞大的 LAION-5B 数据集上训练——包含数十亿来自网络来源的图像-文本对——使 Stable Diffusion 能够学习多样化的视觉概念。数据根据质量、分辨率和美学进行过滤,使用如 Classifier-Free Guidance 等技术来提升提示遵守度。然而,这种网络来源数据引入了文化偏见,主要偏向英语和西方内容,用户在生成多样化表示时应加以考虑。

Stable Diffusion 的核心功能和能力

Stable Diffusion 不仅仅是基本的图像创建;它提供了一系列高级功能:

- 文本到图像生成:输入描述性提示,如“日落时分的宁静山景”,并在几秒钟内生成原创艺术作品。

- 图像编辑工具:使用 inpainting 来填充或修改图像的部分(例如,改变背景),并使用 outpainting 来扩展超出原始边界。

- 图像到图像转换:使用新的文本指导重新绘制现有照片,保留结构同时更改风格或元素。

- ControlNet 集成:从参考图像中保留几何结构、姿势或边缘,同时应用风格变化。

- 高分辨率支持:XL 变体(Stable Diffusion XL 1.0)通过 60 亿参数的双模型提升能力,支持 1024x1024 输出、在图像中更好的文本渲染,以及简化提示以获得更快、更真实的 results。

增强功能如 LoRAs (Low-Rank Adaptations) 允许针对特定细节(如面部、服装或动漫风格)进行微调,而无需重新训练整个模型。嵌入捕捉视觉风格以实现一致输出,而负面提示排除如扭曲或额外肢体等不需要元素,精炼质量。

如何使用 Stable Diffusion AI

开始使用 Stable Diffusion 非常简单,无论是线上还是线下。

通过平台在线访问

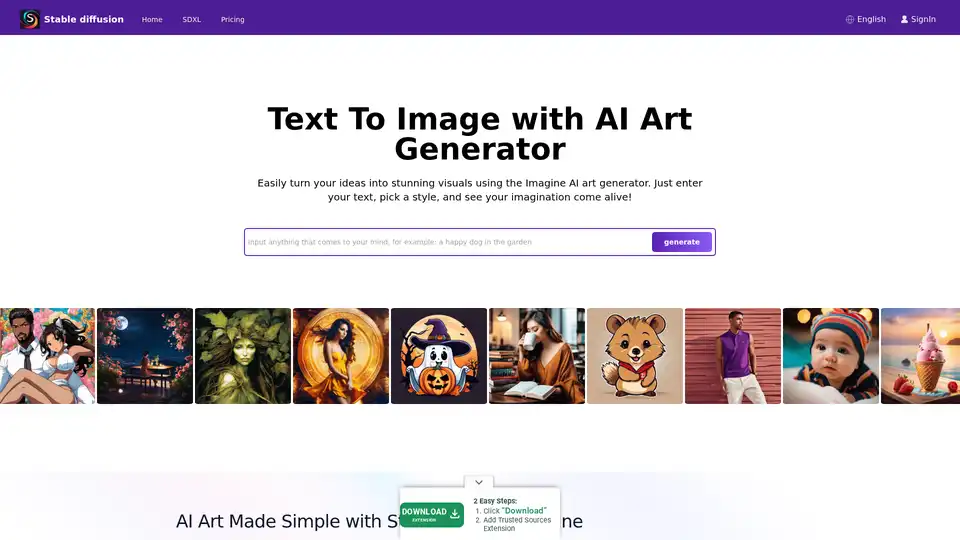

对于初学者,像 Stablediffusionai.ai 这样的平台提供用户友好的 web 接口:

- 访问 stablediffusionai.ai 并登录。

- 在输入字段中输入您的文本提示。

- 选择风格、分辨率(例如,SDXL 用于高分辨率),并调整如采样步骤等参数。

- 点击“Generate”或“Dream”来创建图像。

- 使用负面提示(如“blurry, low quality”)精炼并下载喜欢的图像。

这种无需安装的选项适合快速实验,但需要互联网。

本地安装和下载

对于完全控制和离线使用:

- 从 GitHub (github.com/CompVis/stable-diffusion) 下载,点击“Code” > “Download ZIP”(需要约 10GB 空间)。

- 安装先决条件:Python 3.10+、Git 和具有 4GB+ VRAM 的 GPU(推荐 NVIDIA)。

- 解压 ZIP,将模型检查点(例如,从 Hugging Face)放入 models 文件夹。

- 运行 webui-user.bat (Windows) 或等效脚本启动本地 UI。

- 输入提示,调整如推理步骤(20-50 以实现平衡)等设置,并生成。

像 Automatic1111 的 web UI 这样的扩展添加了批量处理等功能。一旦设置好,它完全离线运行,优先考虑隐私。

训练您自己的 Stable Diffusion 模型

高级用户可以自定义 Stable Diffusion:

- 收集图像-文本对数据集(例如,用于特定风格)。

- 通过清理和标注准备数据。

- 为您的数据集和超参数(批次大小、学习率)修改配置。

- 使用脚本单独训练组件(VAE、U-Net、文本编码器)——租用云 GPU 处理重负载。

- 迭代评估和微调。

这一过程需要技术知识,但能解锁针对特定领域如时尚或建筑的定制模型。

Stable Diffusion XL:升级版

2023 年 7 月由 Stability AI 发布,SDXL 在原有基础上构建,使用更大的参数数量实现更优细节。它简化提示(需要更少的词),包括内置风格,并在图像中擅长可读文本。对于专业人士,通过专用平台提供的 SDXL Online 可交付超高分辨率输出,用于营销视觉、游戏资产或印刷。它是寻求照片级真实或复杂设计而不牺牲速度的人的升级一步。

使用 LoRAs、嵌入和负面提示

- LoRAs:下载专属文件(例如,用于肖像),并通过如 "lora:portrait_style:1.0" 的提示激活。它们高效提升细节。

- 嵌入:在风格数据集上训练,然后在提示中使用 ":style_name:" 调用,以实现主题一致性。

- 负面提示:指定如 “deformed, ugly” 的避免项,以最小化缺陷,提高整体输出精度。

实际应用和用例

Stable Diffusion 在各种场景中大放异彩:

- 艺术家和设计师:原型概念、生成参考,或实验数字艺术、插图或 UI/UX 模拟的风格。

- 营销和媒体:为广告、社交媒体或内容创建自定义视觉,而无需库存照片——适合电商产品渲染。

- 教育和爱好者:教授 AI 概念或手工制作个性化艺术,如幻想设定中的家庭肖像。

- 游戏开发:创建角色、环境或纹理资产,特别是使用 ControlNet 进行姿势控制。

其离线能力适合远程创作者,而 API 访问(通过 Dream Studio 或 Hugging Face)可集成到工作流程中。

Stable Diffusion 适合谁?

这款工具针对创意专业人士,从新手数字艺术家到资深开发者。初学者欣赏其直观界面,而专家重视如微调这样的自定义选项。它完美适合那些优先考虑开源伦理和本地隐私而非云依赖的人。然而,它不太适合非创意任务或缺乏基本技术设置的用户。

局限性和最佳实践

尽管有优势,Stable Diffusion 仍有障碍:

- 偏见:输出可能偏向西方美学;多样化提示和微调有助于缓解。

- 解剖学挑战:手和脸可能扭曲——使用负面提示或 LoRAs。

- 资源需求:本地运行需要体面硬件;像 Stablediffusionai.ai 这样的云替代品可填补空白。

始终审查伦理问题,如训练数据中的版权。Civitai 或 Reddit 上的社区提供模型和提示来克服缺陷。

为什么选择 Stable Diffusion?

在拥挤的 AI 领域,Stable Diffusion 的开源性质促进创新,并有持续的社区更新。与如 DALL-E 这样的封闭工具相比,它提供无限生成而无配额,并完全拥有输出。对于高分辨率需求,SDXL 以实惠价格提供专业级质量。无论激发想法还是最终化项目,它都能赋能用户将人类独创性与 AI 效率相结合。

定价和访问

核心 Stable Diffusion 免费下载和使用。像 Stablediffusionai.ai 这样的平台可能提供免费层级,并有付费升级用于更快生成或高级功能。Dream Studio API 积分从低价起步,按重度使用扩展。本地设置消除持续成本,使其在持续创造力方面经济可行。

本质上,Stable Diffusion 通过将权力置于用户手中,重新定义了 AI 艺术生成。深入其生态系统,通过 GitHub 或在线演示,并解锁视觉叙事的无限可能性。

与Stable Diffusion相关的标签