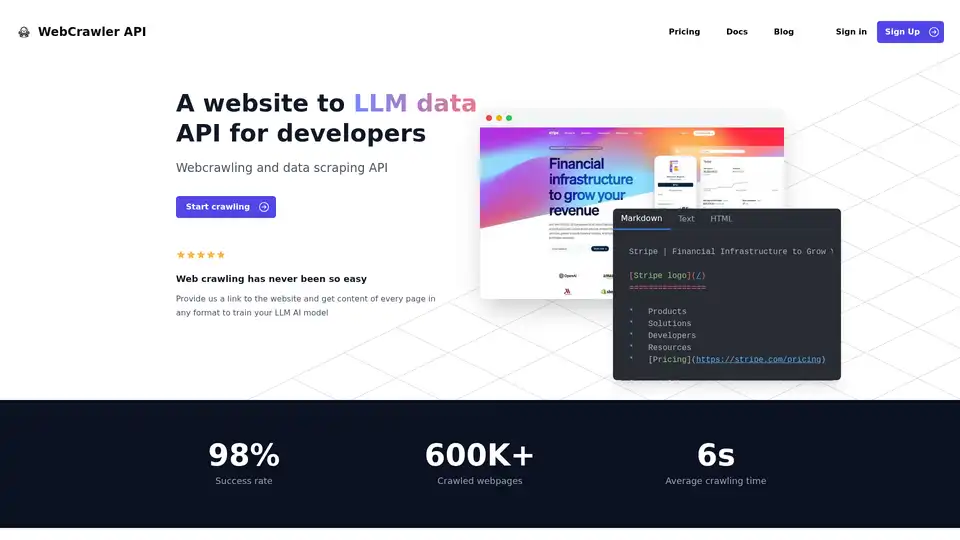

WebCrawler API 概述

WebCrawler API:轻松进行网络爬取和数据提取,助力 AI 发展

什么是 WebCrawler API?它是一款强大的工具,旨在简化从网站提取数据的过程,特别是为了训练大型语言模型 (LLM) 和其他 AI 应用程序。它能处理网络爬取的复杂性,让您专注于利用数据。

主要特性:

- 易于集成: 只需几行代码,即可使用 NodeJS、Python、PHP 或 .NET 集成 WebCrawlerAPI。

- 多样的输出格式: 以 Markdown、文本或 HTML 格式接收内容,根据您的需求量身定制。

- 高成功率: WebCrawlerAPI 拥有 98% 的成功率,可克服常见的爬取挑战,如反爬虫阻止、验证码和 IP 阻止。

- 全面的链接处理: 管理内部链接,删除重复项并清理 URL。

- JS 渲染: 以稳定的方式使用 Puppeteer 和 Playwright 来处理 JavaScript 繁重的网站。

- 可扩展的基础设施: 可靠地管理和存储数百万个已爬取的页面。

- 自动数据清理: 使用复杂的解析规则将 HTML 转换为纯文本或 Markdown。

- 代理管理: 包括无限代理使用,因此您无需担心 IP 限制。

WebCrawler API 的工作原理是什么?

WebCrawler API 抽象化了网络爬取的困难,例如:

- 链接处理: 管理内部链接,删除重复项并清理 URL。

- JS 渲染: 渲染 JavaScript 繁重的网站以提取动态内容。

- 反爬虫阻止: 绕过验证码、IP 阻止和速率限制。

- 存储: 管理和存储大量爬取的数据。

- 扩展: 在不同的服务器上处理多个爬虫。

- 数据清理: 将 HTML 转换为纯文本或 Markdown。

通过处理这些底层复杂性,WebCrawlerAPI 让您可以专注于真正重要的事情 – 利用提取的数据来开发您的 AI 项目。

如何使用 WebCrawler API?

- 注册 一个帐户并获取您的 API 访问密钥。

- 选择您首选的编程语言: NodeJS、Python、PHP 或 .NET。

- 将 WebCrawlerAPI 客户端 集成到您的代码中。

- 指定目标 URL 和所需的输出格式(Markdown、文本或 HTML)。

- 启动爬取 并检索提取的内容。

使用 NodeJS 的示例:

// npm i webcrawlerapi-js

import webcrawlerapi from "webcrawlerapi-js";

async function main() {

const client = new webcrawlerapi.WebcrawlerClient(

"YOUR API ACCESS KEY HERE",

)

const syncJob = await client.crawl({

"items_limit": 10,

"url": "https://stripe.com/",

"scrape_type": "markdown"

}

)

console.log(syncJob);

}

main().catch(console.error);

为什么选择 WebCrawler API?

- 专注于您的核心业务: 避免花费时间和资源来管理复杂的网络爬取基础设施。

- 访问干净且结构化的数据: 以您喜欢的格式接收数据,为 AI 训练做好准备。

- 扩展您的数据提取工作: 处理数百万个页面,而无需担心基础设施限制。

- 经济高效的定价: 只为成功的请求付费,没有订阅费。

WebCrawler API 适合哪些人?

WebCrawler API 非常适合:

- AI 和机器学习工程师: 他们需要大型数据集来训练他们的模型。

- 数据科学家: 他们需要从网站提取数据以进行分析和研究。

- 企业: 他们需要监控竞争对手、跟踪市场趋势或收集客户洞察。

定价

WebCrawlerAPI 提供简单的、基于使用量的定价,没有订阅费。您只需为成功的请求付费。可以使用成本计算器根据您计划爬取的页面数量来估算您的每月费用。

常见问题解答

- 什么是 WebcrawlerAPI? WebcrawlerAPI 是一个 API,可让您以高成功率从网站提取内容,处理代理、重试和无头浏览器。

- 我可以只爬取特定页面还是整个网站? 您可以指定在发出请求时是希望爬取特定页面还是整个网站。

- 我可以在 RAG 中使用爬取的数据或训练我自己的 AI 模型吗? 是的,爬取的数据可以在检索增强生成 (RAG) 系统中使用,也可以用来训练您自己的 AI 模型。

- 我需要支付订阅费用才能使用 WebcrawlerAPI 吗? 不,没有订阅费。您只需为成功的请求付费。

- 我可以在购买前试用 WebcrawlerAPI 吗? 请与他们联系以咨询试用选项。

- 如果我需要集成方面的帮助怎么办? 提供电子邮件支持。

使用 WebCrawlerAPI 提取网站数据以进行 AI 训练的最佳方式

WebCrawlerAPI 提供了一种简化的解决方案来提取网站数据,简化了网络爬取的复杂性,使您能够专注于 AI 模型训练和数据分析。凭借其高成功率、多功能的输出格式和高效的数据清理能力,它使 AI 工程师、数据科学家和企业能够有效地从网络收集有价值的见解。

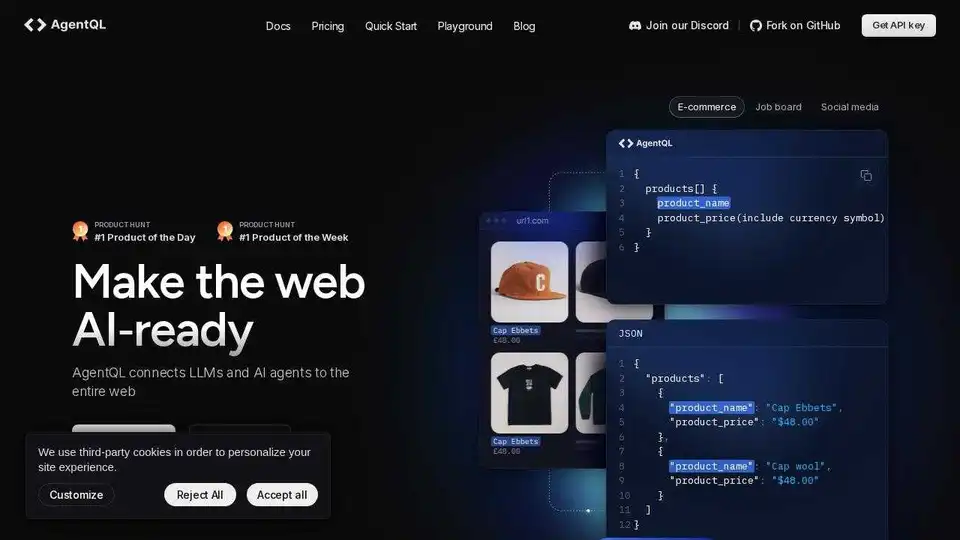

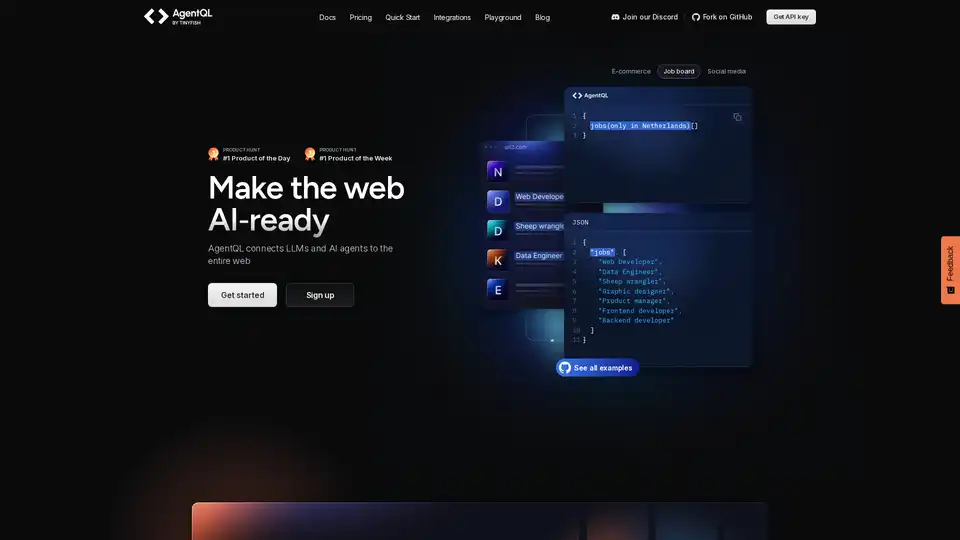

"WebCrawler API"的最佳替代工具

Scrapingdog 提供网页抓取 API 以及用于提取搜索、社交和电子商务数据的专用 API。它管理复杂性,通过真实浏览器渲染和旋转代理提供无阻塞数据。

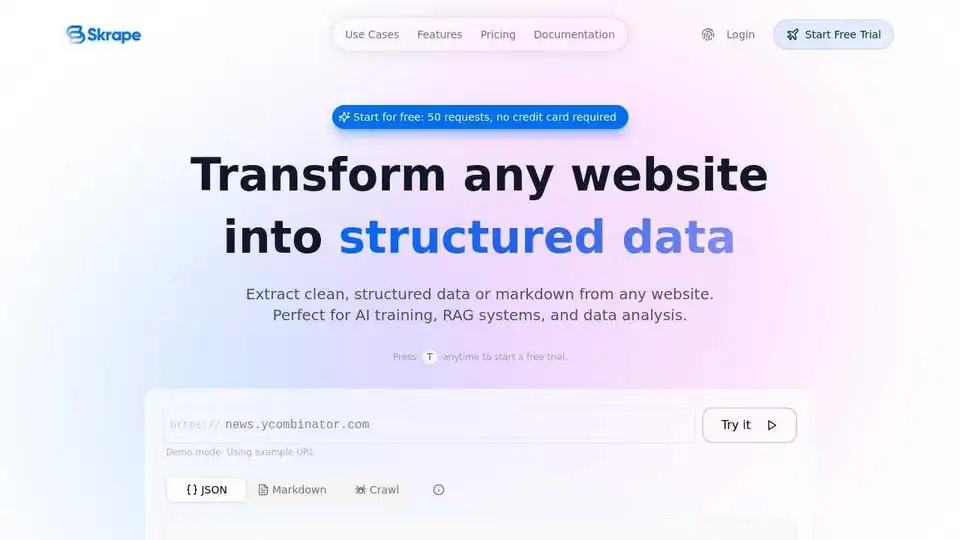

Firecrawl 是专为 AI 应用设计的领先网页爬取、抓取和搜索 API。它将网站转化为干净、结构化的 LLM 就绪数据,支持大规模 AI 代理使用可靠的网页提取,无需代理或复杂问题。

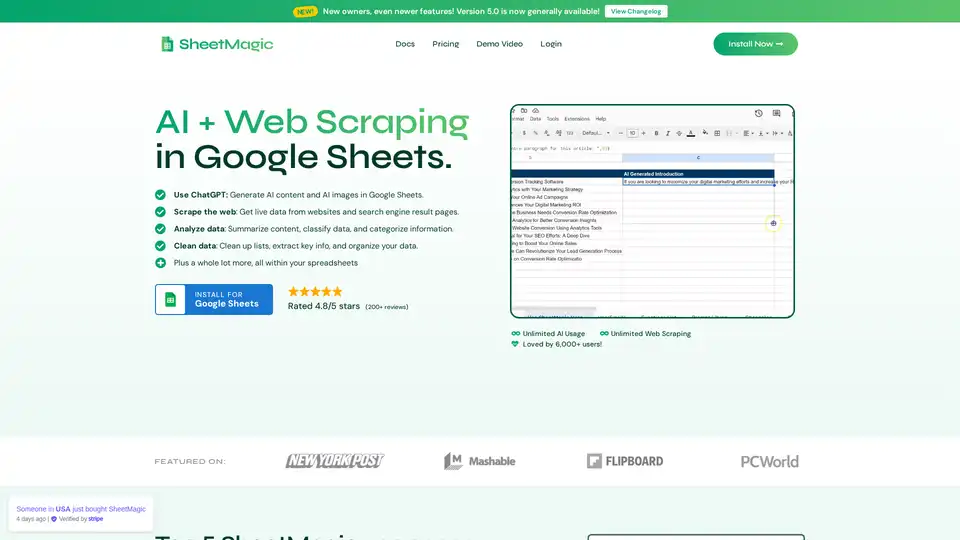

SheetMagic 将无限的 AI 能力和网页抓取直接引入 Google Sheets。通过 ChatGPT 集成和一系列抓取功能,轻松生成内容、抓取数据和自动化任务。

Simplescraper 简化了网页抓取,将网站转换为 API。使用免费 Chrome 扩展程序或云平台提取数据。轻松自动化数据提取和集成。

Simplescraper 是一款简化数据提取的网页抓取工具。它提供 Chrome 扩展程序和云平台,可将网站转换为结构化数据和 LLM 就绪的内容,可通过无代码仪表板或 API 访问。

BrowserAct是一款AI驱动的网页抓取和自动化工具,无需编码即可从任何网站提取数据。自动化工作流程并与n8n和Make等工具集成。

Olostep 是一款面向 AI 和研究代理的 Web 数据 API。 它允许您实时从任何网站提取结构化 Web 数据,并自动执行 Web 研究工作流程。 用例包括 AI 数据、电子表格扩充、潜在客户生成等。

Agent TARS 是一个开源多模态 AI 代理,无缝集成浏览器操作、命令行和文件系统,实现增强的工作流自动化。体验先进的视觉解释和复杂的推理,以高效处理任务。

Deep Research是一款AI驱动的研究助手,它结合了搜索引擎、网络抓取和LLM,可以对任何主题进行迭代和深入的研究。通过智能查询生成和综合报告简化深度研究。