FramePack

Übersicht von FramePack

FramePack: Revolutionierung der Videogenerierung auf Consumer-GPUs

Was ist FramePack? FramePack ist eine bahnbrechende Open-Source-Video-Diffusionstechnologie, die entwickelt wurde, um die Erzeugung hochwertiger Videos auf Consumer-Grafikkarten zu ermöglichen, wobei nur 6 GB VRAM benötigt werden. Es verwendet einen innovativen Frame-Context-Packing-Ansatz, der die AI-Videoerstellung zugänglicher macht als je zuvor.

Hauptmerkmale und Vorteile:

- Niedrige VRAM-Anforderungen: Generieren Sie hochwertige Videos auf Laptops und Systemen der Mittelklasse mit nur 6 GB VRAM.

- Anti-Drift-Technologie: Behalten Sie eine konsistente Qualität über lange Videosequenzen hinweg mit dem bidirektionalen Sampling-Ansatz von FramePack.

- Lokale Ausführung: Generieren Sie Videos direkt auf Ihrer Hardware, ohne dass Cloud-Verarbeitung oder teure GPU-Mieten erforderlich sind.

Wie FramePack funktioniert

FramePack bietet einen intuitiven Workflow für die Generierung hochwertiger Videoinhalte:

- Installation und Einrichtung: Installieren Sie FramePack über GitHub und richten Sie Ihre Umgebung ein.

- Definieren Sie Ihr erstes Frame: Beginnen Sie mit einem Bild oder generieren Sie eines aus einer Textvorgabe, um Ihre Videosequenz zu starten.

- Erstellen Sie Bewegungsvorgaben: Beschreiben Sie die gewünschte Bewegung und Aktion in natürlicher Sprache, um die Videogenerierung zu steuern.

- Generieren und Überprüfen: Sehen Sie zu, wie FramePack Ihr Video Frame für Frame mit beeindruckender zeitlicher Konsistenz generiert.

Erläuterung der Kerntechnologien

- Frame-Context-Packing: Komprimieren und nutzen Sie Frame-Context-Informationen effizient, um die Verarbeitung auf Consumer-Hardware zu ermöglichen. Dies ist der Schlüssel für den geringen VRAM-Bedarf von FramePack.

- Lokale Videogenerierung: Generieren Sie Videos direkt auf Ihrem Gerät, ohne Daten an externe Server zu senden, um Datenschutz und Kontrolle zu gewährleisten.

- Bidirektionales Sampling: Behalten Sie die Konsistenz über lange Videosequenzen mit Anti-Drift-Technologie bei. Dies verhindert, dass sich die Videoqualität im Laufe der Zeit verschlechtert.

- Optimierte Leistung: Generieren Sie Frames mit etwa 1,5 Sekunden pro Frame auf High-End-GPUs mit Teacache-Optimierung. Selbst auf Low-End-Hardware ist die Leistung für Prototyping nutzbar.

- Open-Source-Zugang: Profitieren Sie von einer vollständig Open-Source-Implementierung, die Anpassungen und Community-Beiträge ermöglicht. Dies fördert Innovation und gewährleistet langfristige Unterstützung.

- Multimodaler Input: Verwenden Sie sowohl Textvorgaben als auch Bildeingaben, um Ihre Videogenerierung zu steuern und Flexibilität und Kontrolle über den kreativen Prozess zu gewährleisten.

Warum ist FramePack wichtig?

FramePack demokratisiert die AI-Videogenerierung, indem es sie für Benutzer mit begrenzten Hardware-Ressourcen zugänglich macht. Die Möglichkeit, die Videogenerierung lokal auszuführen, ist ein erheblicher Vorteil für datenschutzbewusste Benutzer und solche mit begrenzter Internetbandbreite. Der Open-Source-Charakter von FramePack fördert die Zusammenarbeit der Community und die kontinuierliche Verbesserung.

Anwenderberichte

- Emily Johnson, unabhängige Animatorin: "FramePack hat die Art und Weise, wie ich Animationen erstelle, verändert. Die Möglichkeit, hochwertige Videos auf meinem Laptop zu generieren, bedeutet, dass ich von überall aus arbeiten kann, und die Ergebnisse sind beeindruckend genug für Kundenpräsentationen."

- Michael Rodriguez, VFX-Spezialist: "Als jemand, der mit mehreren Kreativteams zusammenarbeitet, ist FramePack ein Game-Changer. Es bietet eine schnelle und effiziente Möglichkeit, Videokonzepte zu prototypisieren, ohne auf Renderfarmen warten zu müssen, was uns unzählige Stunden in der Produktion spart."

- Sarah Chen, AI-Forscherin: "Dieses Tool hat die Art und Weise verändert, wie wir an die Videogenerierungsforschung herangehen. FramePacks innovatives Frame-Context-Packing ermöglicht es uns, mit längeren Sequenzen auf Standard-Laborausrüstung zu experimentieren und so unseren Forschungszyklus erheblich zu beschleunigen."

FAQ

- Was genau ist FramePack und wie funktioniert es? FramePack ist eine Open-Source-Video-Diffusionstechnologie, die die Next-Frame-Vorhersage auf Consumer-GPUs ermöglicht. Es funktioniert, indem es Frame-Context-Informationen effizient packt und ein Eingabeformat mit konstanter Länge verwendet, wodurch es hochwertige Videos Frame für Frame auch auf Hardware mit begrenztem VRAM generieren kann.

- Was sind die Systemanforderungen für FramePack? FramePack benötigt eine NVIDIA-GPU mit mindestens 6 GB VRAM (wie RTX 3060), CUDA-Unterstützung, PyTorch 2.6+ und läuft unter Windows oder Linux. Für eine optimale Leistung wird eine GPU der RTX 30- oder 40-Serie mit 8 GB+ VRAM empfohlen.

- Wie schnell kann FramePack Videos generieren? Auf High-End-GPUs wie der RTX 4090 kann FramePack Frames mit etwa 1,5 Sekunden pro Frame mit Teacache-Optimierung generieren. Auf Laptops mit 6 GB VRAM ist die Generierung 4-8x langsamer, aber dennoch für Prototyping nutzbar.

- Ist FramePack kostenlos nutzbar? FramePack bietet eine kostenlose Open-Source-Version mit vollem Funktionsumfang. Premium-Stufen bieten möglicherweise zusätzliche Funktionen, Prioritätssupport und erweiterte Funktionen für professionelle Benutzer und Teams.

- Was ist 'Frame-Context-Packing' in FramePack? Frame-Context-Packing ist die Kerninnovation von FramePack, die Informationen aus vorherigen Frames effizient in ein Format mit konstanter Länge komprimiert. Dadurch kann das Modell die zeitliche Konsistenz aufrechterhalten, ohne dass der Speicher mit zunehmender Videolänge zunimmt.

- Wie schneidet FramePack im Vergleich zu anderen Videogenerierungs-Tools ab? Im Gegensatz zu Cloud-basierten Lösungen läuft FramePack vollständig lokal auf Ihrer Hardware. Während einige Cloud-Dienste möglicherweise eine schnellere Generierung bieten, bietet FramePack überlegenen Datenschutz, keine Nutzungslimits und die Möglichkeit, längere Sequenzen mit gleichbleibender Qualität zu generieren.

Fazit

FramePack stellt einen bedeutenden Schritt nach vorn in der AI-Videogenerierung dar. Seine geringen VRAM-Anforderungen, sein Open-Source-Charakter und seine innovative Frame-Context-Packing-Technologie machen es zu einem wertvollen Werkzeug für Hobbyisten und Profis gleichermaßen. Egal, ob Sie Animationen erstellen, Videokonzepte prototypisieren oder Forschung betreiben, FramePack bietet eine schnelle, effiziente und zugängliche Lösung für die Generierung hochwertiger Videos auf Consumer-GPUs. Was ist der beste Weg, um Videos auf Ihrem lokalen Rechner zu generieren? FramePack ist definitiv ein Top-Anwärter.

Beste Alternativwerkzeuge zu "FramePack"

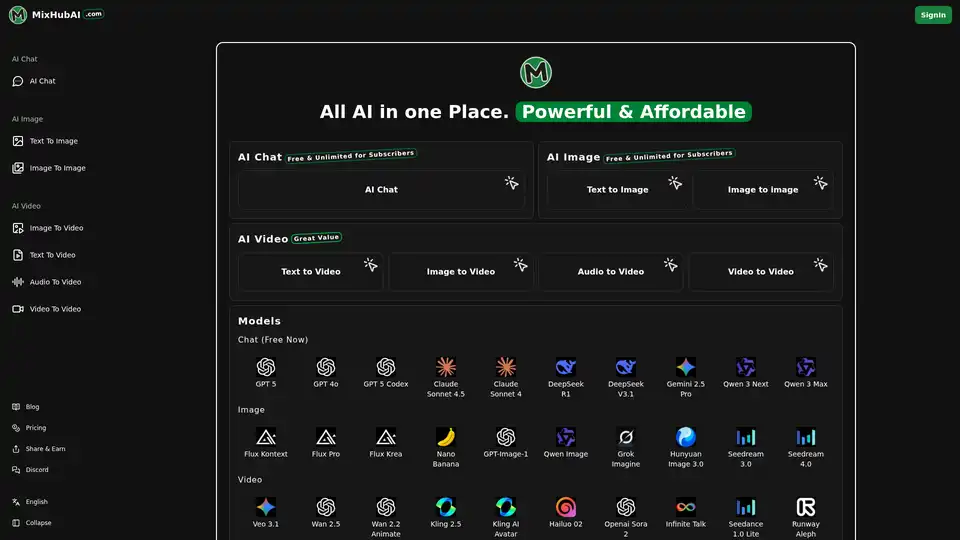

MixHub AI ist eine All-in-One-Plattform mit GPT-5, Flux, Claude, Qwen Image, Kling, Hailuo und mehr für KI-Chat, Bild- und Videogenerierung. Immer die neuesten KI-Modelle, regelmäßig aktualisiert.

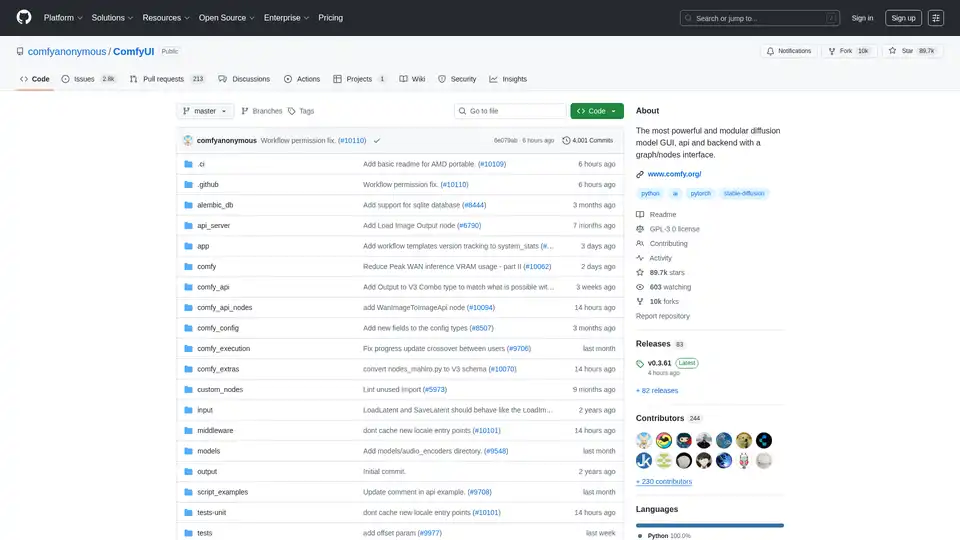

ComfyUI ist eine leistungsstarke, modulare, visuelle KI-Engine zum Entwerfen und Ausführen fortschrittlicher Stable-Diffusion-Pipelines mithilfe einer Graph-/Knotenoberfläche. Verfügbar für Windows, Linux und macOS.

Lumiere von Google Research ist ein Raum-Zeit-Diffusionsmodell für die Videogenerierung. Es unterstützt Text-zu-Video, Bild-zu-Video, Videostilisierung, Cinemagraphen und Inpainting und erzeugt realistische und kohärente Bewegungen.

DimensionX erstellt 3D- und 4D-Szenen aus einem einzigen Bild mithilfe steuerbarer Videodiffusion und ermöglicht so die Erstellung neuartiger Ansichtsvideos und die räumlich-zeitliche Fusionssteuerung.

Stable Video Diffusion ist ein kostenloses KI-Tool von Stability AI, das Bilder in Videos umwandelt. Perfekt für kreative und pädagogische Zwecke. Testen Sie jetzt die KI-Videogenerierung!

MotionAgent ist ein Open-Source-KI-Tool, das Ideen in Bewegungsfilme umwandelt, indem es Skripte, Filmstills, hochauflösende Videos und benutzerdefinierte Hintergrundmusik mit Modellen wie Qwen-7B-Chat und SDXL generiert.

Generieren Sie kurze Videos aus Bildern oder Text mit Stable Video Diffusion, einem generativen KI-Videomodell. Verwandeln Sie Ihre Konzepte in fesselnde Filme. Unterstützt mehrere Seitenverhältnisse.

Generieren Sie mit Stable Video 3D (SV3D) 3D-Modelle mit mehreren Ansichten aus einzelnen Bildern. Nutzen Sie Stable Video Diffusion für hochwertige, konsistente 3D-Visualisierungen.

Verwandeln Sie Fotos mit ToonCrafter AI in fesselnde Cartoons, einem Open-Source-KI-Tool für nahtlose Cartoon-Interpolation und Videogenerierung. Perfekt für Animationsbegeisterte und Kreativdirektoren.

Wan 2.2 ist das führende KI-Videogenerierungsmodell von Alibaba, jetzt Open Source. Es bietet filmische Visionskontrolle, unterstützt die Generierung von Text-zu-Video und Bild-zu-Video und bietet effizientes High-Definition-Hybrid-TI2V.

BasedLabs: Kostenloser KI-Bild- und Video-Generator mit über 20 Modellen wie Stable Diffusion & SDXL. Erstellen Sie KI-Influencer, -Videos und -Bilder ohne Anmeldung.

Unbody: KI-nativer Stack mit Headless-Architektur für den Aufbau von KI-Websites und -Apps, der Datenbanken, APIs, ETL, RAG, Chatbots, CDNs abdeckt.

Verwandeln Sie Bilder mit Stable Video Diffusion AI in atemberaubende Videos. Kostenloses Online-Tool, um in Sekundenschnelle hochwertige Videos aus Bildern zu erstellen.

AI-Flow ist eine No-Code-Plattform, um auf einfache Weise mehrere KI-Modelle für die Inhaltserstellung, Bildgenerierung und Workflow-Automatisierung zu verbinden. Integrieren Sie Modelle von OpenAI, StabilityAI und mehr.