Fireworks AI

Übersicht von Fireworks AI

Fireworks AI: Die schnellste Inference Engine für generative KI

Was ist Fireworks AI? Fireworks AI ist eine Plattform, die entwickelt wurde, um die schnellsten Inference-Geschwindigkeiten für generative KI-Modelle bereitzustellen. Sie ermöglicht es Benutzern, KI-Anwendungen einfach zu erstellen, zu optimieren und zu skalieren, indem sie Open-Source-Modelle nutzen, die für verschiedene Anwendungsfälle optimiert sind.

Wie funktioniert Fireworks AI? Fireworks AI erzielt eine hohe Leistung durch seine Inference Engine, die für niedrige Latenz, hohen Durchsatz und hohe Parallelität optimiert ist. Die Plattform unterstützt beliebte Modelle wie DeepSeek, Llama, Qwen und Mistral, sodass Entwickler mit den Fireworks SDKs schnell experimentieren und iterieren können.

Hauptmerkmale und Vorteile

- Blitzschnelle Inference: Bietet Echtzeit-Performance mit minimaler Latenz, geeignet für unternehmenskritische Anwendungen.

- Erweiterte Optimierung: Bietet Tools zur Maximierung der Modellqualität durch Techniken wie Reinforcement Learning und quantisierungsbewusste Optimierung.

- Nahtlose Skalierung: Stellt automatisch die neuesten GPUs in mehreren Clouds und Regionen bereit und gewährleistet so hohe Verfügbarkeit und konsistente Leistung.

- Open-Source-Modelle: Unterstützt eine breite Palette von Open-Source-Modellen und bietet Flexibilität und Anpassungsoptionen.

- Enterprise-Ready: Enthält Funktionen für sichere Teamzusammenarbeit, Überwachung und Compliance (SOC2 Typ II, GDPR, HIPAA).

Anwendungsfälle

Fireworks AI eignet sich für eine Vielzahl von Anwendungen, darunter:

- Sprachagenten: Ermöglicht Echtzeit-Sprachinteraktionen mit geringer Latenz.

- Code-Assistenten: Verbessert die Codegenerierung und -vervollständigung mit schnellen Inference-Geschwindigkeiten.

- KI-Entwicklungstools: Ermöglicht Feinabstimmung, KI-gestützte Codesuche und tiefen Codekontext für verbesserte Entwicklungsabläufe.

Warum ist Fireworks AI wichtig?

Fireworks AI adressiert den Bedarf an Geschwindigkeit und Skalierbarkeit in generativen KI-Anwendungen. Durch die Optimierung der Inference und die Bereitstellung nahtloser Skalierung ermöglicht es Unternehmen, KI-Funktionen in großem Umfang bereitzustellen, ohne Leistung oder Kosteneffizienz zu opfern.

Für wen ist Fireworks AI geeignet?

Fireworks AI ist ideal für:

- Unternehmen: Die KI-Lösungen mit Sicherheit und Compliance auf Enterprise-Niveau bereitstellen möchten.

- Entwickler: Die eine schnelle und flexible Plattform zum Experimentieren mit Open-Source-Modellen suchen.

- KI-Forscher: Die eine robuste Infrastruktur zum Trainieren und Bereitstellen von KI-Modellen benötigen.

Kundenreferenzen

Mehrere Unternehmen haben mit Fireworks AI Erfolge erzielt:

- Cursor: Sualeh Asif, CPO, lobte Fireworks für seine Leistung und die minimale Verschlechterung der Qualität quantisierter Modelle.

- Quora: Spencer Chan, Product Lead, hob Fireworks als die beste Plattform für die Bereitstellung von Open-Source-LLMs und die Skalierung von LoRA-Adaptern hervor.

- Sourcegraph: Beyang Liu, CTO, bemerkte die schnelle und zuverlässige Modell-Inference von Fireworks für die Entwicklung von KI-Entwicklungstools wie Cody.

- Notion: Sarah Sachs, AI Lead, berichtete von einer deutlichen Reduzierung der Latenz durch die Partnerschaft mit Fireworks zur Feinabstimmung von Modellen.

Preisgestaltung

Fireworks AI bietet flexible Preisoptionen für unterschiedliche Anforderungen. Details finden Sie auf der Seite Pricing.

Erste Schritte

Um mit der Entwicklung mit Fireworks AI zu beginnen, besuchen Sie die Website und erkunden Sie die verfügbaren Modelle und die Dokumentation. Sie können sich auch an das Vertriebsteam wenden, um Enterprise-Lösungen zu erhalten.

Wie kann man Fireworks AI am besten nutzen? Um die Vorteile von Fireworks AI optimal zu nutzen, beginnen Sie mit der Identifizierung Ihres spezifischen Anwendungsfalls und der Auswahl des geeigneten Open-Source-Modells. Verwenden Sie die Fireworks SDKs, um das Modell feinabzustimmen und für Ihre Anwendung zu optimieren. Nutzen Sie die Skalierungsfunktionen der Plattform, um Ihre KI-Funktionen weltweit bereitzustellen, ohne die Infrastruktur verwalten zu müssen.

Durch die Bereitstellung einer robusten und skalierbaren Inference Engine ermöglicht Fireworks AI Entwicklern und Unternehmen, die Leistungsfähigkeit generativer KI mit beispielloser Geschwindigkeit und Effizienz zu nutzen.

Beste Alternativwerkzeuge zu "Fireworks AI"

Blitzschnelle KI-Plattform für Entwickler. Bereitstellen, Feinabstimmen und Ausführen von über 200 optimierten LLMs und multimodalen Modellen mit einfachen APIs - SiliconFlow.

Friendli Inference ist die schnellste LLM-Inferenz-Engine, optimiert für Geschwindigkeit und Kosteneffizienz, die GPU-Kosten um 50-90 % senkt und gleichzeitig einen hohen Durchsatz und eine geringe Latenz bietet.

AI Runner ist eine Offline-KI-Inferenz-Engine für Kunst, Echtzeit-Sprachkonversationen, LLM-gestützte Chatbots und automatisierte Arbeitsabläufe. Führen Sie Bilderzeugung, Voice-Chat und mehr lokal aus!

vLLM ist eine Inferenz- und Serving-Engine mit hohem Durchsatz und Speichereffizienz für LLMs, die PagedAttention und kontinuierliche Batchverarbeitung für optimierte Leistung bietet.

Spice.ai ist eine Open-Source-Daten- und KI-Inferenz-Engine zum Erstellen von KI-Apps mit SQL-Query-Federation, Beschleunigung, Suche und Abruf auf der Grundlage von Unternehmensdaten.

Cortex ist eine Open-Source-Blockchain-Plattform, die KI-Modelle in einem dezentralen Netzwerk unterstützt und die KI-Integration in Smart Contracts und DApps ermöglicht.

fima AI ist eine KI-gestützte Kollaborationssuite, die darauf abzielt, effiziente Arbeitssysteme neben dem menschlichen Wohlbefinden aufzubauen. Bietet Data-Ground für Datenanalysen und ein Open-Source-KI-Agent-Framework.

Wavify ist die ultimative Plattform für On-Device-Sprach-KI, die eine nahtlose Integration von Spracherkennung, Wake-Word-Erkennung und Sprachbefehlen mit erstklassiger Leistung und Datenschutz ermöglicht.

dstack ist eine Open-Source-KI-Container-Orchestrierungs-Engine, die ML-Teams eine einheitliche Steuerungsebene für die GPU-Bereitstellung und -Orchestrierung über Cloud, Kubernetes und On-Premises bietet. Optimiert Entwicklung, Training und Inferenz.

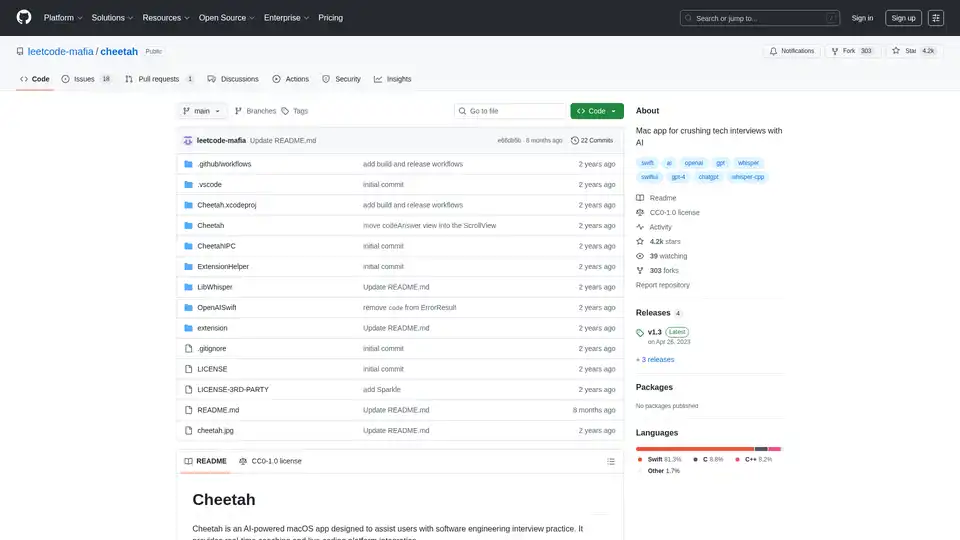

Cheetah ist eine Open-Source-macOS-App mit KI, die Whisper für Echtzeit-Transkription und GPT-4 für Interview-Hinweise nutzt und Benutzer mit Live-Coaching bei Tech-Interviews unterstützt.

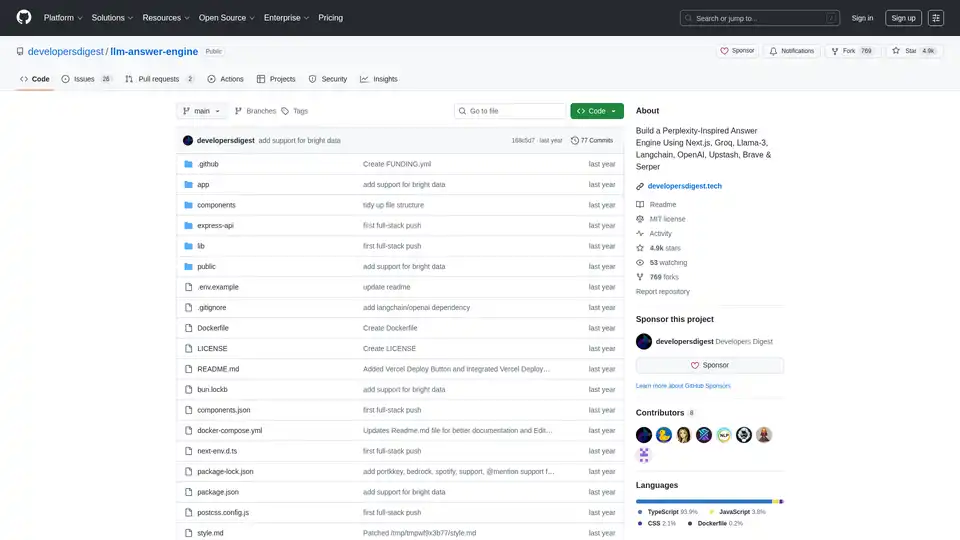

Erstellen Sie eine von Perplexity inspirierte KI-Antwort-Engine mit Next.js, Groq, Llama-3 und Langchain. Erhalten Sie effizient Quellen, Antworten, Bilder und Folgefragen.

Inweave ist eine KI-gestützte Plattform für Startups und Scaleups, die Workflows effizient automatisiert. Bereitstellen anpassbarer KI-Assistenten mit Top-Modellen wie GPT und Llama über Chat oder API für nahtlose Produktivitätsgewinne.

Entdecken Sie Fast3D, die KI-gestützte Lösung zur Generierung hochwertiger 3D-Modelle aus Text und Bildern in Sekunden. Erkunden Sie Funktionen, Anwendungen in Spielen und zukünftige Trends.

Vespa.ai ist eine KI-Suchplattform für die Entwicklung und den Betrieb von Anwendungen im großen Maßstab. Sie kombiniert Big Data, Vektorsuche, maschinell erlerntes Ranking und Echtzeit-Inferenz und ermöglicht so Echtzeit-KI-Anwendungen.