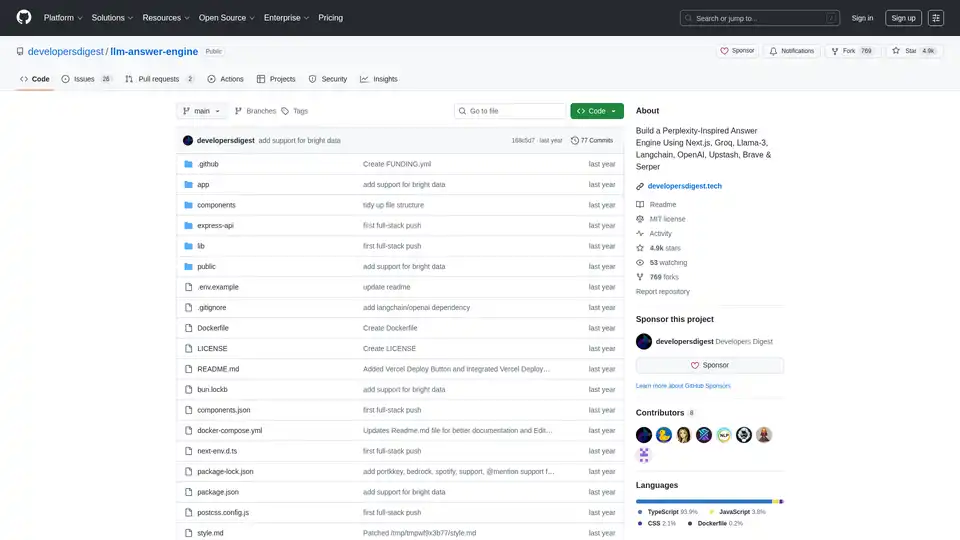

llm-answer-engine

Übersicht von llm-answer-engine

LLM Antwort-Engine: Bauen Sie Ihr eigenes KI-gestütztes Frage-Antwort-System

Dieses Open-Source-Projekt, llm-answer-engine, stellt den Code und die Anweisungen bereit, um eine hochentwickelte KI-Antwort-Engine zu bauen, die von Perplexity inspiriert ist. Es nutzt modernste Technologien wie Groq, Mistral AI's Mixtral, Langchain.JS, Brave Search, Serper API und OpenAI, um umfassende Antworten auf Benutzeranfragen zu liefern, komplett mit Quellen, Bildern, Videos und Folgefragen.

Was ist llm-answer-engine?

llm-answer-engine ist ein Ausgangspunkt für Entwickler, die sich für Natural Language Processing und Suchtechnologien interessieren. Es ermöglicht Ihnen, ein System zu erstellen, das Fragen effizient beantwortet durch:

- Abrufen relevanter Informationen aus verschiedenen Quellen.

- Generieren prägnanter und informativer Antworten.

- Bereitstellen von unterstützenden Beweisen und zugehörigen Medien.

- Vorschlagen von Folgefragen, um die weitere Erkundung zu leiten.

Wie funktioniert llm-answer-engine?

Die Engine verwendet eine Kombination von Technologien, um Benutzeranfragen zu verarbeiten und relevante Antworten zu generieren:

- Abfrageverständnis: Technologien wie Groq und Mixtral werden verwendet, um die Frage des Benutzers zu verarbeiten und zu verstehen.

- Informationsbeschaffung:

- Brave Search: Eine datenschutzorientierte Suchmaschine wird verwendet, um relevante Inhalte und Bilder zu finden.

- Serper API: Wird verwendet, um relevante Video- und Bildergebnisse basierend auf der Benutzerabfrage abzurufen.

- Cheerio: Wird für das HTML-Parsing verwendet, wodurch das Extrahieren von Inhalten von Webseiten ermöglicht wird.

- Textverarbeitung:

- Langchain.JS: Eine JavaScript-Bibliothek, die sich auf Textoperationen wie Textaufteilung und Embeddings konzentriert.

- OpenAI Embeddings: Werden verwendet, um Vektordarstellungen von Textblöcken zu erstellen.

- Optionale Komponenten:

- Ollama: Wird für Streaming-Inferenz und Embeddings verwendet.

- Upstash Redis Rate Limiting: Wird verwendet, um die Ratenbegrenzung für die Anwendung einzurichten.

- Upstash Semantic Cache: Wird verwendet, um Daten für schnellere Antwortzeiten zu cachen.

Hauptmerkmale und Technologien:

- Next.js: Ein React-Framework zum Erstellen von serverseitig gerenderten und statischen Webanwendungen, das eine robuste Grundlage für die Benutzeroberfläche bietet.

- Tailwind CSS: Ein Utility-First-CSS-Framework zum schnellen Erstellen benutzerdefinierter Benutzeroberflächen, das eine effiziente Gestaltung und Anpassung ermöglicht.

- Vercel AI SDK: Eine Bibliothek zum Erstellen von KI-gestützten Streaming-Text- und Chat-UIs, die die Benutzererfahrung mit Echtzeit-Feedback verbessert.

- Function Calling Support (Beta): Erweitert die Funktionalität mit Integrationen für Karten & Standorte (Serper Locations API), Shopping (Serper Shopping API), TradingView-Aktiendaten und Spotify.

- Ollama Support (teilweise unterstützt): Bietet Kompatibilität mit Ollama für das Streamen von Textantworten und Embeddings, was die lokale Modellausführung ermöglicht.

Wie verwende ich llm-answer-engine?

Um mit llm-answer-engine zu beginnen, folgen Sie diesen Schritten:

- Voraussetzungen:

- API-Schlüssel von OpenAI, Groq, Brave Search und Serper beziehen.

- Stellen Sie sicher, dass Node.js und npm (oder bun) installiert sind.

- (Optional) Installieren Sie Docker und Docker Compose für die containerisierte Bereitstellung.

- Installation:

git clone https://github.com/developersdigest/llm-answer-engine.git cd llm-answer-engine - Konfiguration:

- Docker: Bearbeiten Sie die Datei

docker-compose.ymlund fügen Sie Ihre API-Schlüssel hinzu. - Non-Docker: Erstellen Sie eine

.env-Datei im Stammverzeichnis Ihres Projekts und fügen Sie Ihre API-Schlüssel hinzu.

- Docker: Bearbeiten Sie die Datei

- Server starten:

- Docker:

docker compose up -d - Non-Docker:

npm install # or bun install npm run dev # or bun run dev

- Docker:

Der Server wird am angegebenen PortListening sein.

Warum llm-answer-engine wählen?

- Inspiriert von Perplexity: Bietet eine ähnliche Benutzererfahrung wie eine führende KI-Antwort-Engine.

- Nutzt leistungsstarke Technologien: Kombiniert das Beste aus NLP, Suche und Webentwicklung.

- Open-Source und anpassbar: Ermöglicht es Ihnen, die Engine an Ihre spezifischen Bedürfnisse anzupassen.

- Function Calling Support: Erweitert die Funktionalität mit Integrationen für Karten & Standorte, Shopping, TradingView-Aktiendaten und Spotify.

Für wen ist llm-answer-engine?

Dieses Projekt ist ideal für:

- Entwickler, die sich für Natural Language Processing und Suchtechnologien interessieren.

- Forscher, die Frage-Antwort-Systeme untersuchen.

- Jeder, der seine eigene KI-gestützte Wissensdatenbank aufbauen möchte.

Roadmap:

Die Projekt-Roadmap umfasst spannende Funktionen wie:

- Dokumenten-Upload + RAG für die Dokumentensuche/-abruf.

- Eine Einstellungs-Komponente, mit der Benutzer das Modell, das Embeddings-Modell und andere Parameter über die Benutzeroberfläche auswählen können.

- Hinzufügen von Unterstützung für Folgefragen bei Verwendung von Ollama

Mitwirken:

Beiträge sind willkommen! Forken Sie das Repository, nehmen Sie Ihre Änderungen vor und senden Sie einen Pull Request.

Dieses Projekt ist unter der MIT-Lizenz lizenziert.

Bauen Sie Ihre eigene KI-gestützte Antwort-Engine und erkunden Sie die Möglichkeiten der natürlichen Sprachverarbeitung mit llm-answer-engine!

Beste Alternativwerkzeuge zu "llm-answer-engine"

Jina AI bietet erstklassige Einbettungen, Reranker, Webreader, Deep Search und kleine Sprachmodelle. Eine Such-KI-Lösung für mehrsprachige und multimodale Daten.

Quattr ist eine KI-gestützte SEO-Plattform, die entwickelt wurde, um SEO-, AEO- und GEO-Strategien zu vereinheitlichen. Sie automatisiert die Erstellung von Inhalten, die interne Verlinkung und das Ranking-Tracking, um die Online-Sichtbarkeit und das organische Wachstum zu verbessern.

Lettria ist eine KI-Plattform, die unstrukturierte Daten mithilfe von GraphRAG in strukturiertes Wissen umwandelt und so die Entscheidungsfindung in regulierten Branchen wie Finanzen, Gesundheitswesen und Recht verbessert.

GradeLab bietet KI-gestützte automatisierte Benotung, KI-gesteuerte Bewertungen, Fragengenerierung und Einblicke in die Schülerleistung, die für moderne Pädagogen entwickelt wurden. Vereinfachen Sie die Benotung und verbessern Sie die Lernergebnisse.

FishAI ist ein KI-nativer persönlicher Informationsassistent, der durch KI- und Informationsabonnementtechnologie personalisierte Informationsdienste bereitstellt.

Beschleunigen Sie Ihren Linkaufbau mit den KI-Tools von Pitchbox: Personalisierung, Vorlagenassistent und KI-Antwort. Optimieren Sie Ihre Reichweite und steigern Sie jetzt Ihre SEO-Bemühungen!

Cheetah ist eine Open-Source-macOS-App mit KI, die Whisper für Echtzeit-Transkription und GPT-4 für Interview-Hinweise nutzt und Benutzer mit Live-Coaching bei Tech-Interviews unterstützt.

Erhalten Sie mit AISwers sofortige, genaue Antworten auf Ihre Fragen, unterstützt durch fortschrittliche KI-Technologie. Finden Sie Lösungen zu verschiedenen Themen und Kategorien.

iAsk.Ai ist eine kostenlose KI-Suchmaschine, die sofortige, genaue Antworten auf Ihre Fragen liefert. Erhalten Sie KI-gestützte Hilfe bei Hausaufgaben, Recherchen und mehr. Als die Nummer 1 der KI eingestuft.

FlyRank fördert organisches Wachstum mit innovativen SEO-, GEO- und AEO-Strategien und stellt sicher, dass Ihre Marke in Suchmaschinen und KI-Chatbots einen hohen Rang einnimmt.

Homeworkify ist ein kostenloser, KI-gestützter Hausaufgabenhelfer, der sofortige Fragen und Antworten mit schrittweisen Erklärungen bietet. Erhalten Sie Hausaufgabenhilfe in mehreren Fächern ohne Anmeldung.

Finden Sie heraus, ob Ihre Marke von KIs wie ChatGPT und Gemini zitiert wird. LLMO Metrics hilft, die KI-Suchsichtbarkeit durch Answer Engine Optimization (AEO) zu verbessern.

Erhalten Sie immer die richtige Antwort mit automatischer AI-Modellauswahl. ChatBetter gibt Ihnen Zugang zu allen großen AI-Anbietern in einer einfachen Oberfläche.

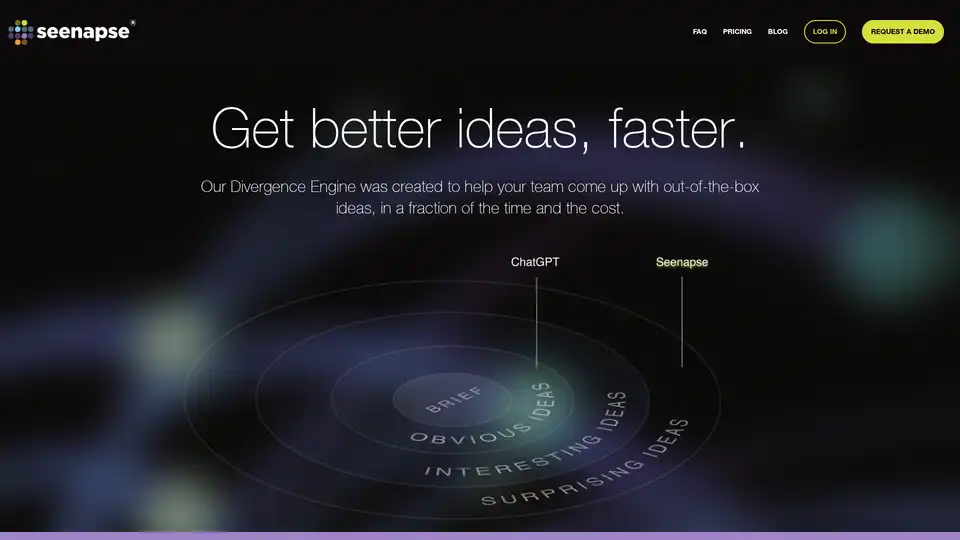

Seenapse ist ein webbasiertes KI-Tool, das originale, unkonventionelle Ideen schneller und kreativer als ChatGPT generiert. Ideal für kreative Teams in Werbung und Marketing.